医疗争端、化学合成、罪犯识别、自动驾驶等应用领域,AI的威力日趋扩大。目前哪些是AI做不到的,未来哪些事又是AI可能做到的?美国商用系统芯片互连IP供应商ArterisIP的CTO Ty Garibay发表了一篇博客,解释了AI及AI芯片的前世今生。

经历了第一次泡沫、寒冬时期、研究重启的AI技术,目前的突破点在基础层AI芯片的更新中。AI到底能不能超越现在顺利达到深度学习的高标准,还是有待商榷和验证的。

简史

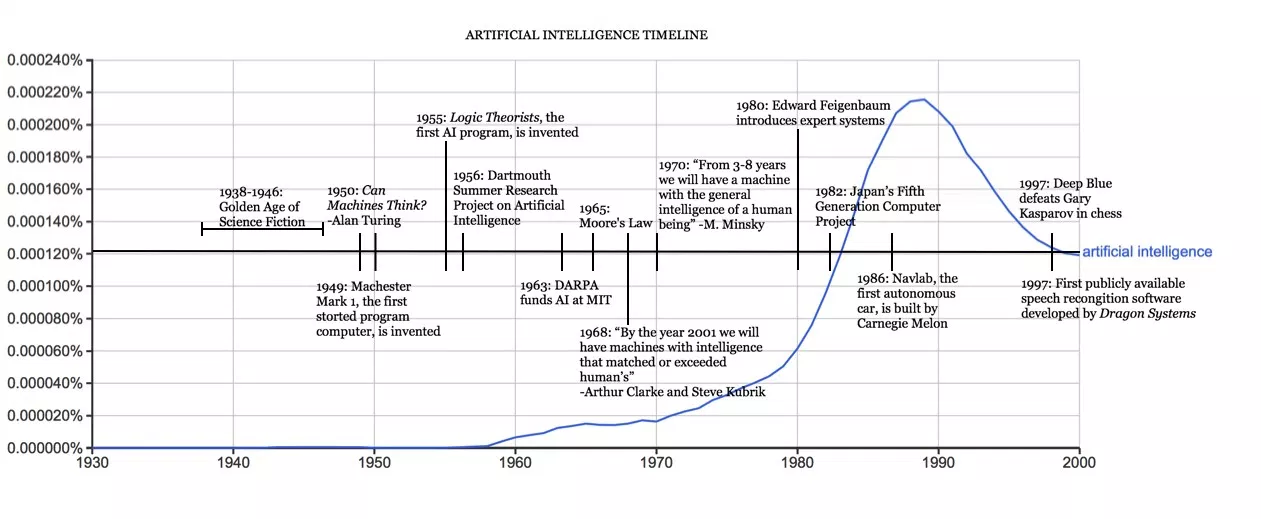

“人工智能”的术语1956年便诞生,由三位科学家John McCarthy、Claude Shannon and Marvin Minsky在英国达特茅斯会议上提出。当时那个年代末期,Arthur Samuel创造了“机器学习”的概念,指能够从错误中学习的程序,这个程序甚至能够在跳棋等游戏中表现胜过编程的人。

计算机技术的飞速进步使研究者相信,AI可很快解决。科学家们在研究基于人类大脑功能计算是否能解决实际生活中的问题过程中,创造了“神经网络”的理念。

1970年,科学家Marvin Minsky在《生活周刊》采访中表示,3至8年内,将有望出现一台与人类平均智力相当的机器。

上世纪80年代,AI走出了实验室并走向商业化,还掀起了AI投资狂潮。当AI相关的科技股泡沫破灭后,AI又重新回到实验室。“AI寒冬”到来。业内人士认为,当时发展AI技术过于超前,甚至此技术永远都无法普及。

1986年,神经网络之父Geoffrey Hinton和其他研究人员发表了一篇里程碑式的报告,报告探讨了在“反向传播”算法如何使深层神经网络反应更出色。

1989年,深度学习三巨头之一的美国计算机科学家杨立昆(Yann LeCun)与当时他在贝尔实验室的同事通过培养能够识别手写ZIP码的神经系统而验证了一个AI理论在真实生活中的可行性。

2009年,斯坦福大学的Rajat Raina、Anand Madhavan和Andrew Ng发表了论文,论证了现代GPU的深度学习能力远远超过CPU。AI大军似乎卷土重来了。

现在

为什么现在投资界都在聊AI,说到底驱动因素是计算机技术成熟,海量数据容易获得,一旦研究者有了这些资源,算法与解决方案也就不是天方夜谭。

但AI芯片的最大挑战是,如何在系统级的芯片中,将以上资源协调在一起,而且系统级的芯片是以硬件加速器为载体的。

所以AI芯片的设计要求很高,尤其是在汽车行业,对安全和可靠性的标准一点都不能降低。

谷歌和特斯拉这样的公司对集成电路设计也许还并不成熟,而AI Movie、Horizon Robotics等AI初创企业虽然对机器学习有很深造诣,但要完成高水准的系统级芯片研发也很困难。

以汽车前置摄像头中的深度学习AI芯片加速器为例,此芯片主要用途是为了分析和检测道路上的车辆、物体。每个AI芯片都带有记忆文件以确保最大的带宽。

芯片内互联机制必须在检测到物体时保证较宽的带宽,并且在没有遇到物体,优化能源耗损时分配较窄的带宽。而优化的手段就是更新更高级的算法。这样的AI算法每天都要更新或升级一次。

如果把现在的深度算法芯片比作香蕉,那么没人愿意保留烂了的香蕉。其实AI芯片中旧算法就好比烂香蕉。所以对AI芯片来说,问世时间比其他类别的半导体更加敏感。

未来

除了深度学习和神经网络大幅推动了AI技术的进程,仍有很多研究者认为,如果AI要达到更好的要求,还需要更多的方法去支持AI芯片。

大多数AI芯片的设计目前只是基于杨立昆和Hinton等学者的理论而研发出的不同版本,但如果一直沿着这一条轨道前进,AI技术无法有更大的实质突破,更不用说用AI完全替代人类思维。

目前AI技术还是要建立在“标签化”数据的基础上的,它无法完成一个与历史经验毫无关联的任务。神经网络也并没有将已有知识与陌生规则(例如,“向上”的对立面是“向下”、孩子由父母生育等事实)。

AI技术现在还不能根据没有标签的数据解决问题,好比一个人即使没被烫过,也不会主动去碰点燃的火炉,AI却还做不到。即使通过“标签化”的数据学习,数据样本也要足够大。

AI芯片似乎没能表现得比人类更智能,但它们的学习能力很强,未来可以变得更聪明。算法和芯片系统的设计都可以进步,这需要AI芯片具备更高级的记忆系统和连接机制,以及承载深度学习数据流的硬件加速器。