AI是当下的新闻热点。如今,AI已经用于医学诊断、合成新的化学物质、识别藏匿在人群中的罪犯的面孔、驾驶汽车,甚至进行艺术创作。有时,我们似乎感觉AI无所不能,人类很快就会失业,默默看着AI为我们完成一切。

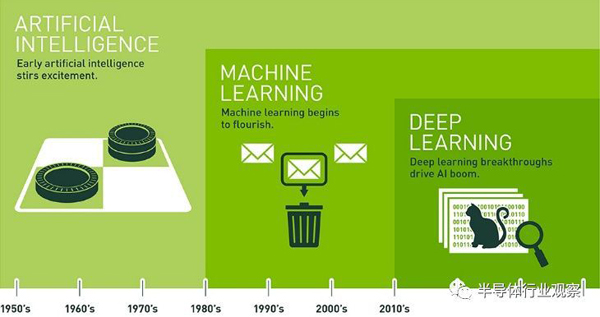

为了解AI技术的起源,本文记录了AI的发展历程,通过高级驾驶员辅助系统(ADAS)和自动驾驶汽车的案例,分析了AI芯片目前的发展状态,以及如何让AI芯片真正改变我们的日常生活。让我们从AI的历史开始讲起,随着AI的发展,更专业化的技术出现了,即所谓的机器学习,它依靠经验学习而不是编程来做决策。反过来,机器学习也为后来的深度学习奠定了基础。深度学习涉及到分层算法,目的是为了更好地理解数据。

图1:AI导致了机器学习的出现,后来又演变成深度学习 (来源:英伟达)

AI技术本源

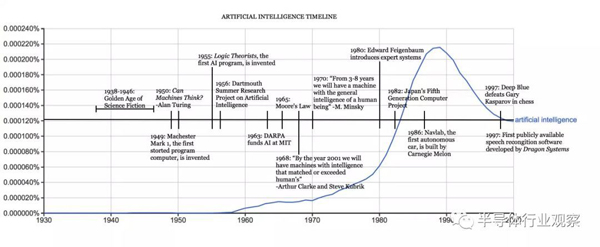

1956年达特茅斯会议上,科学家约翰·麦卡锡,克劳德·香农和马文·明斯基提出了“人工智能”一词。50年代末,阿瑟·萨缪尔(Arthur Samuel)提出了“机器学习”这个术语,他开发了一个西洋跳棋程序,可以从错误中吸取教训,经过学习后,甚至比编写程序的人棋力更强。

在这个计算机技术飞速发展的时代,乐观的环境让研究人员相信AI技术将在短时间内“攻克”。科学家们研究了基于人脑功能的计算是否能够解决现实生活中的问题,创造了“神经网络”的概念。1970年,马文·明斯基在《生活》杂志中讲到,“未来3~8年内,我们将拥有相当于普通人智力水平的机器。”

到了20世纪80年代,AI走出实验室,进入商业化,掀起了一股投资热潮。80年代末,AI技术泡沫最终破裂,AI又回到了研究领域,科学家们继续开发AI的潜能。行业观察者称AI是一种超前于时代的技术,也有人说是未来科技。经历了相当长一段时间的所谓“AI寒冬”之后,商业开发再次启动。

图2:AI时间表

1986年,杰弗里·希尔顿(Geoffrey Hinton)和他的同事发表了一篇里程碑式的论文,描述了一种称为“反向传播(back-propagation)”的算法,该算法可以显著提高多层或“深度”神经网络的性能。 1989年,严恩·乐库(Yann LeCun)和贝尔实验室的其他研究人员创建了一个可以训练识别手写的邮政编码的神经网络,展示了这项新技术在现实世界中的重要应用。他们训练深度学习卷积神经网络(CNN)只花了3天时间。时光飞逝到2009年,斯坦福大学的Rajat Raina、Anand Madhavan和Andrew Ng发表了一篇论文,阐述了现代GPU在深度学习领域拥有远远超过多核CPU的计算能力。AI已经准备好重新起航。

探索真正的AI芯片

为什么当今我们总是听到不可胜数的关于AI的消息?关键因素的融合为AI技术的巨大进步奠定了基础,许多人认为这能够解决越来越重要的现实问题。利用当今互联网提供的基础设施,全球研究人员可以获得创建新算法和解决方案所需要的计算能力、大规模数据和高速通信。例如,汽车行业已经表示,愿意为AI技术投入研发资金,因为机器学习有能力处理自动驾驶等高度复杂的任务。

AI芯片设计的主要挑战之一就是将一切整合到一起。我们在这里讨论的是超大型的定制SoC,它使用多种类型的硬件加速器实现深度学习。设计AI芯片可能是非常困难的事情,尤其是考虑到汽车行业对安全性和可靠性的严格要求,但AI芯片仍然只是芯片而已,或许在加工工艺、存储器、I/O和互连技术方面会有一些新的解决方案。

像谷歌和特斯拉这样的IC设计新手公司,以及AIMotive和Horizon Robotics这样的AI芯片创业公司,都对深度学习的计算复杂性有深入的了解,但在开发这些最先进的SoC时,它们可能会面临严峻的挑战。可配置的互连IP在确保业内所有这些新参与者能够尽快获得功能性芯片方面可以发挥关键作用。

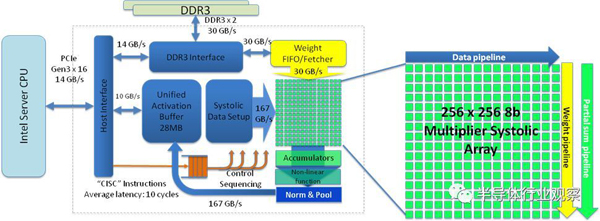

图3:AI芯片剖析图,以谷歌TPU为例。

例如,对于汽车前置摄像头,可以采用具有深度学习加速器的AI芯片,它们可以对路边的目标进行检测和分类。每颗AI芯片都有唯一的内存访问配置文件,以确保最大带宽。片内互连的数据流必须进行优化,以确保在满足性能目标时有更宽的带宽路径,但在可能的情况下分配窄路径以优化面积、成本和功耗。

每个连接也必须进行优化,以适应更高级别的AI算法。为了让它更有趣,人们每天都在开发新的AI算法。从某种程度上讲,今天的深度学习芯片就像香蕉,没有人想在自己的AI芯片中使用烂香蕉或老算法。对于这些前沿产品而言,上市时间甚至比其他很多半导体产品更为重要。

AI的未来

虽然深度学习和神经网络正在迅速推动AI技术的发展,但仍有许多研究人员认为,如果要实现AI最不可思议的目标,仍然需要从根本上采用完全不同的新方法。大多数AI芯片的设计都是为了实现LeCun和Hinton以及其他人在十多年前发表的相同想法的不断改进的版本,但是我们没有理由期望,沿着这条道路取得指数级别的进展就能让AI变得可以像人类一样思考。正如我们今天所知道的那样,我们无法将付出巨大努力完成了一项任务的深度学习应用到一项不同的新任务中。

此外,神经网络没有很好的方法来整合先前的知识,也没有“向上vs向下”(up vs down)以及“孩子有父母”(children have parents)这样的规则。最后,基于神经网络的AI需要大量的例子来学习,而人类只要有一次难忘的经历就能学会不去碰火炉。目前尚不清楚如何将现有的AI技术应用于那些没有海量标记数据集的问题。

虽然AI芯片目前还不是特别智能,但它们绝对很聪明,而且很有可能在不久的将来变得更加智能。这些芯片将继续利用半导体加工、计算机架构和SoC设计方面的先进技术,以提高处理能力,支持下一代AI算法。与此同时,新的AI芯片将继续需要先进的存储系统和片上互连架构,以便为新的专有硬件加速器提供深度学习所需的源源不断的数据流。

原文链接:https://semiengineering.com/artificial-intelligence-chips-past-present-and-future/