无人驾驶再次撞人致死,Uber 全面停止测试

美国当地时间19日上午,UBER自动驾驶车在美国亚利桑那州进行测试时,撞到路边一名女子并导致其不治身亡。

美国CNBC网站3月20日报道,美国国家运输安全委员会NTSB发言人,正在调查这起事故。亚利桑那州州长办公室也表示,他们正与执法部门进行沟通。此外,美国国家公路交通安全管理局也在调查这一事件。

UBER在这起事故发生后推特上宣布,暂停全国各地城市的自动驾驶汽车测试,同时向死者家属致哀及提供协助,并全力配合当局调查这起事件。

坦佩警方表示,这辆UBER自动驾驶车在碰撞发生时,处于自动驾驶模式,当时在车上有一名操作人员。值得一提的是,当地警方还表示:事故现场未发现明显的减速痕迹!

但随后美国亚利桑那州当地警方称,Uber“很可能”在自动驾驶死亡事件中无过错。警察局局长西尔维娅·莫伊尔表示,“很明显,在任何一种驾驶模式(无人驾驶或人为驱动)中,都很难避免这种碰撞,如果行人直接从黑暗中走出来到马路上。”

事件发生后,在国外引起了轩然大波。媒体、社交网站纷纷报道、讨论。因为这是全球首起自动驾驶致死事故,人们对自动驾驶(甚至人工智能)技术的信任程度可能会产生更大的波动。

自动驾驶事故频发

在近几年国外无人车上路测试的过程中,还发生过或大或小的事故,甚至惨剧。

2017年3月,一辆UBER无人车在坦佩市测试期间,被一辆私家车撞到,车上两名人员没有受伤,UBER随即一度暂停测试计划。之后警方判定,Uber 的自动驾驶汽车没有任何故障,责任在与其相撞的车辆。不过,Uber的测试车也并未做出有效的“补救措施”,最终导致自己翻车。

2016年5月7日,40岁的乔舒亚·布朗正使用自动驾驶系统,驾驶特斯拉Model S电动汽车。在一个没有安装红绿灯的十字路口,一辆大型牵挂型卡车突然左转,特斯拉没来得及刹车,车身直接钻到卡车底部,车顶完全被掀起。特斯拉车主布朗当场毙命,卡车司机并没有受伤。随后特斯拉公告中明示,当时系统未发现前方的危险,未采取刹车,径直撞向了前方的卡车!

2016年1月,一位23岁男青年驾驶着自己的特斯拉轿车在京港澳高速河北邯郸段公路行驶,未能及时躲避前方的道路清扫车而发生追尾,事故导致该名车主身亡。时隔近两年,在各方面证据面前,特斯拉方面终于承认了该事故“自动驾驶”负有责任。

而18日的这起悲剧事件凸显了自无人驾驶汽车诞生以来一直存在的担忧。

自动驾驶真的安全吗?

从表面上看,除了整体系统出现故障外,很难理解为何会发生这样的致死事故。因为自动驾驶汽车在设计时就是为了防止这样的事故发生。

意外进入行驶路径的人或物几乎是自动驾驶汽车工程师首先考虑的突发事件。这种情况有很多,例如突然停下来的汽车、一只鹿、过路的行人。

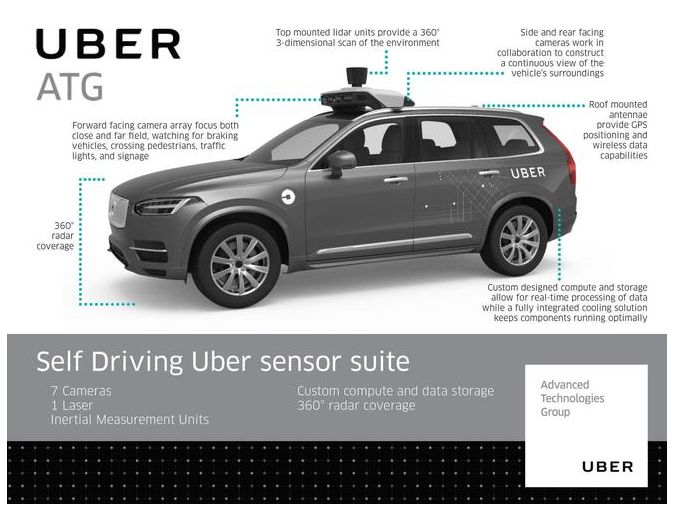

Uber自动驾驶汽车配备了一整套传感器:

1、顶部激光雷达

它能够以每秒多次的速度生成汽车周围的3D成像。激光雷达使用了红外激光脉冲,遇到物体后会反弹,返回到传感器,从而在白天或晚上相当细致地侦测静止和移动的物体。

如果顶部激光雷达单元运行正常,在没有被完全遮挡的情况下,它应该能够分辨出受害者。同时,汽车距离行人还有100多英尺远(30多米),可以把行人成像传送给“大脑”进行核对。

2、前端雷达

和激光雷达一样,雷达发出信号,等待它弹回,但使用的是无线电波,可以穿透雪和雾,具有更强的抗干扰能力。

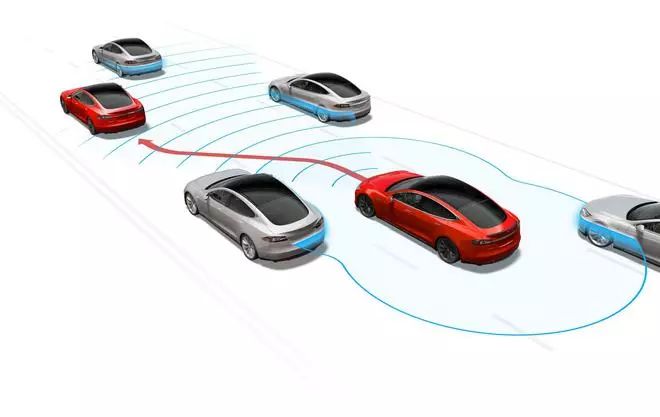

特斯拉自动驾驶系统Autopilot主要依赖雷达

3、短焦和长焦光学相机

激光雷达和雷达易于确定物体的形状,但并不擅长读取标记,理解物体颜色等。这个任务就交给了可见光相机,它内置了精密的计算机视觉算法,能够对成像进行实时分析。侦测行人是工程师们试图解决的最常见问题之一,这种算法已经非常成熟。

光学相机拍摄的图像

相机夜间工作很困难,但激光雷达和雷达能够在夜间工作,即便是在伸手不见五指的环境下,穿着全黑衣服的人也能够被激光雷达和雷达识别。

4、安全司机

人类很擅长发现障碍物,虽然人类的反应时间不是最好的,但是汽车不会作出反应或者作出错误反应,经过训练的安全司机会作出正确反应。

中国的自动驾驶

自动驾驶汽车虽然前景光明,但还有很长一段路要走,目前所达到的水平可能并没有我们想象的那么乐观。

但要说到监管,可能没有哪个国家做得比中国用心。

就在去年年底,北京率先发布《北京市关于加快推动自动驾驶车辆道路测试有关工作的指导意见(试行)》和《北京市自动驾驶车辆道路测试管理实施细则(试行)》,对测试主体、测试车辆、测试人员、事故处理等方面做了明确的要求。

虽然目前美国已经出台了三部与自动驾驶有关的政策,但是随着自动驾驶技术的发展加快,美国也慢慢放宽了一些限制,而且每个州的情况有所不同。

相比之下,中国的管理办法虽然比较笼统,但是一切都要以安全为前提。

百度无人车

在事故责任鉴定方面,北京的规定则明确指出,车辆的测试驾驶员应当为事故或交通违法行为承担责任。

而上海则指出,发生重伤或者死亡事故、车辆或者道路设施毁损等严重交通事故,由国家认可的交通事故司法鉴定机构对测试车辆进行技术鉴定,鉴定费用由测试主体承担。公安机关交通管理部门依据鉴定结果进行责任认定,对测试驾驶人和测试主体进行处理。

我国虽然自动驾驶起步比美国晚,但是坚持“稳定发育”。

以北京为首的城市,如上海、广州也都开始发放自动驾驶测试的牌照,并且积极建设与真实驾驶环境接近的测试场地。

无人驾驶的前途

毫无疑问,无人驾驶未来市场空间广阔。

根据相关数据,无人驾驶汽车到2025年可以催生出一个2000亿至1.9万亿美元的巨大市场。至2035年全球无人驾驶汽车销量将达到1180万辆,2025-2035年间年复合增长率为48.35%,届时中国将占据全球市场24%的份额。

目前,国内的百度、长安等企业以及国防科技大学、军事交通学院等军事院校的无人驾驶汽车也走在国内研发的前列。

例如长安汽车实现了无人驾驶汽车从重庆出发一路北上到达北京的国内无人驾驶汽车长途驾驶记录。百度汽车同样在北京成功进行了初次无人驾驶车道路测试,并取得了成功。

在这次两会上,百度董事长李彦宏在接受采访时表示:“三到五年内就会出现替代司机的无人驾驶汽车。而在明年,百度和合作伙伴推出的L3级别自动驾驶量产车就可以开上高速,今后在高速公路上也可以“吃着火锅唱着歌了。”

不过,中国道路的复杂性大家也是有目共睹的,要放心交给汽车去自动驾驶,任重而道远!

无人驾驶汽车出车祸,到底谁该负责?

《机器人也是人》(Robots Are People, Too)一书的作者、律师约翰-弗兰克-韦弗(John Frank Weaver)称,如果我们希望让机器人为我们做更多的事情,例如当我们的全职司机或给我们运送货物,那么我们可能就需要赋予他们法律主体资格。

“如果我们对待机器人就像对待真人一样,那么法律就应该认可我们与机器人之间的互动等同于我们与真人之间的互动。”韦弗写道,“有时候,这要求我们承认:机器人是可接受保险的实体,就像真人或企业一样;而且,机器人的责任是独立的。”

关键的问题是:如果我们不将机器人定义为负有某种法律责任和义务的实体,那么我们将很难有效地驱使它们。

现在,像谷歌这样打造无人驾驶汽车的公司,面临的处境就非常耐人寻味。假设谷歌卖了一俩无人驾驶汽车给你,然后它出了车祸。那么,谁该为此事故造成的损失负责呢?是你?还是谷歌?驱动汽车的算法、感应器以及所有控制系统,均是谷歌设计和研制的。就连谷歌内部员工也认为,损失赔偿责任不应由车主承担,而应由谷歌负责。

但在现实生活中,无人驾驶汽车可能需要进行特殊的保养和维护,或者在指定的区域内运营。在这种情况下,车主,而不是车载软件,就应该对此负责。

韦弗曾提到一种棘手的现实情境,他说无人驾驶汽车可能是为了避让一只鹿,突然转弯才撞上另一辆车的。如果这辆无人驾驶汽车做了好心的人类司机们都会做的事情,那么谷歌(或者任何无人驾驶汽车制造商)还应该对此情境中的交通事故负责吗?

韦弗认为,答案是否定的。在上述情境中,机器人本身不该被定责。按照他的法律理想,“无人驾驶汽车应该成为独立的可保险的实体,这样一旦发生交通事故,那么我们就能够更快地给受害人提供保险赔付,同时保护车主免受官司之扰。”

如果这听起来似乎很荒唐,你可以想象另一种情形。如果谷歌售出了 10 万辆无人驾驶汽车,那么他们真的应该对所有这些车辆发生的事故或遭到的罚单负法律责任吗?哪家公司会承担这种程度的法律责任呢?

但是,设计顾问布莱恩-舍伍德-琼斯(Brian Sherwood Jones)并不认同韦弗的观点。他说,“有人认为‘事故是机器人的错’,这种想法是毫无道理的。”他争论说,如果我们不“让人来承担责任”,那么这就是在“严重逃避责任”。

有趣的是,现在路上行驶的无人驾驶汽车的责任已被定到了非人主体的身上——企业。

韦弗声称,让机器人成为独立的法律主体,也许有助于我们澄清它们在我们的生活中所充当的角色。因此,无人驾驶汽车——作为法律主体——应该拥有自己的保险,以应付它在运行过程中可能会发生的交通事故。这就是说,交通事故中的损失应该由法律主体——汽车——来支付。

另一种选择是像谷歌这样的公司开发出一种新的业务模式,以减少和承担相应的风险。例如,谷歌不向任何人销售它的无人驾驶汽车,而是自己组建一个超级安全的无人驾驶汽车车队。谷歌汽车的设计——小巧、轻便和限速——表明谷歌已在努力确保不发生严重的交通事故。

也许有人会说,机器人主体资格的例子表明,我们现有的法律系统未能跟上现代社会、企业或机器人发展的步伐。也许,我们不是需要赋予机器人主体资格,而是应该改革现有的法律主体资格的概念。

但是,正如温迪-柯米纳(Wendy Kaminer)所警告的那样,将法律主体资格赋予的对象仅限定为“自然人”,可能会产生意想不到的严重后果。这就是说,最合理的做法是将法律主体资格的概念延伸到机器人身上。

对此事,你怎么看?