经过多年的应用实践和技术发展,传统RAID越来越体现出局限性的一面,如热点效应。为了方便管理,假设我们把整个RAID组格式化产生的逻辑盘都映射给某个系统,不同系统使用不同RAID组,若某个应用系统的业务特别繁忙,就会造成对应RAID组的物理盘读写压力大,形成热点。

这时,聪明的童鞋提出,我们可以把RAID组的逻辑盘打散了用啊!!于是,每个系统使用的逻辑盘来自不用的RAID组,这样就把繁忙系统的读写压力分散到更多的物理硬盘上了,棒棒哒!!但是,管理起来好麻烦,有没有?另一方面,每个系统的业务特征是动态变化的,忙的不会一直忙,不忙的也不一定一直让人省心,有可能某个时刻所有的应用系统都在往同一个RAID组上做读写,其它RAID组的硬盘在喝茶磕瓜子,你说那个RAID组内硬盘的心里有多苦?这时,管理员童鞋就要做性能调优了,分散热点数据,累不?

这时,又有聪明的童鞋提出了池化的概念,即先把所有的逻辑盘放到一个大池子里,再从池子里往外分配存储空间。假设RAID组格式化后的逻辑盘大小是100GB,池子里有100个逻辑盘,A系统要使用200GB空间,那么系统会从池子里的每个逻辑盘上抠出2GB空间,100*2GB,组成一个200GB的虚拟盘分配给A系统,而不是把2个100GB的逻辑盘组成一个200GB的虚拟盘分配出去。这样A系统的读写压力会分散到100个逻辑盘上,而不是2个,而这100个逻辑盘可能对应着更多的物理盘,大大分散了压力。

这个问题解决了,管理员童鞋开开心心地过了几年,渐渐地心里有点慌乱。物理硬盘的容量越来越大,从原来的73GB增长到现在的4TB,坏盘之后数据重构时间从原来的1个小时增长到10个小时!!这么长的时间里,如果再坏一块盘,那我RAID5的磁盘组不就全挂了?即使用了RAID6可以容忍坏两块盘,但老话还说祸不单行呢?

又有聪明的童鞋站了起来,我们可以把盘切片再做RAID,看这个图先!

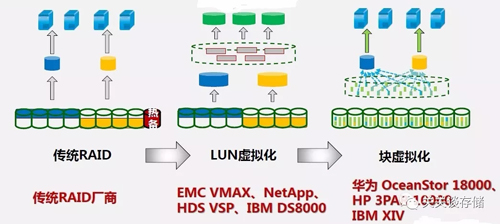

上图中LUN虚拟化技术就是前面说的池化技术,仍然基于传统的RAID实现,只是多了一层虚拟盘的概念,原来是直接把逻辑盘分配出去,现在改成把虚拟盘分配出去,虚拟盘上的数据均匀分布在逻辑盘上。

块虚拟化就是本文重点介绍的RAID2.0技术,它先把物理硬盘切成若干片,然后片与片之间再做RAID,然后一层层封装成虚拟卷映射出去,方法与池化技术类似。有童鞋要问了,不就是切个片嘛,没看出来哪好!!

物理硬盘切片之后,所有的片可以自由组合做RAID,不再局限于物理硬盘,原则就是一个RAID组内的片必须来自不同的物理硬盘。

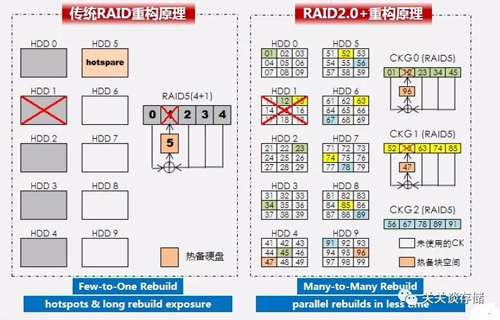

让我们仔细对比一下上图左右两部分:

- 左图HDD1与HDD-0/2/3/4组成一个RAID组;右图HDD1切出来的片分别与HDD-0/2/3/4和HDD-5/6/7/8切出来的片组成了两个RAID组;

- 左图HDD1发生故障后,HDD5作为后备军勇敢顶上,但HDD-0/2/3/4校验恢复出来的数据要写到HDD5一块硬盘上;右图HDD1发生故障后,2个RAID组受到影响,HDD-4和HDD-9切出来的片顶上,RAID组校验恢复出来的数据写到HDD-4和HDD-9两块盘上,而且数据量超小哟,只是两个片的数据,HDD1上其它空白片不用管了!!

- 推而广之,RAID2.0技术不再有热备盘的概念,换成了热备空间,这里我们姑且称之为热备片。一块物理硬盘故障后,来自多块物理硬盘的热备片顶上,数据重构不再是传统RAID的N对1,而是N对N。据某靠谱国产大厂统计,RAID2.0重构速度是传统RAID的20倍,可将10小时的重构时间缩短至30分钟!!

结语

通过上文的分析可以看出,RAID2.0能够显著减少重构时间,避免数据重构时对一块硬盘的高强度读写,降低硬盘故障率。但它与池化技术存在同样的隐患,即由于虚拟盘做了宽条带的数据分布,多块物理硬盘损坏导致RAID组失效之后,整个存储池的数据会读写异常,影响范围大于传统RAID方式。因此,存储阵列若使用池化技术,***采用RAID6。