随着深度学习对人工智能的巨大推动,深度学习所构建的多层神经网络模型的参数空间已从***上升到百亿级,这对计算能力提出了新的挑战。相比CPU,GPU更适合深度学习的神经网络模型,可进行高度统一、相互无依赖的大规模并行计算。

阿里云发布的***一代异构计算通用GPU实例GN5规格族就是一款用于搭建深度学习加速平台的云端利器。

“品学兼优”的GN5采用了NVIDIA Pascal架构旗舰级P100 GPU,可在云端按需构建敏捷弹性、高性能和高性价比的深度学习平台,让用户以最简便地方式享用阿里云遍布全球的高效、稳定的云基础设施资源。

与上一代相比,GN5的单实例性能拓展了5倍,单实例最多可提供8个 NVIDIA P100 GPU,提供2万多个并行处理核心,***75TFLOPS FP32单精度浮点、150 TFLOPS FP16半精度浮点和38 TFLOPS FP64双精度浮点运算能力。

自建GPU物理服务器经常会遇上扩容难、适配难的难题,GN5规格族提供了灵活弹性的系列化配置,可以根据深度学习计算力的要求,按需选择合适的规格,分钟级即可完成实例的创建,并可根据运算力需求进行GPU实例的“Scale-out”水平扩容或“Scale-up”垂直变配。

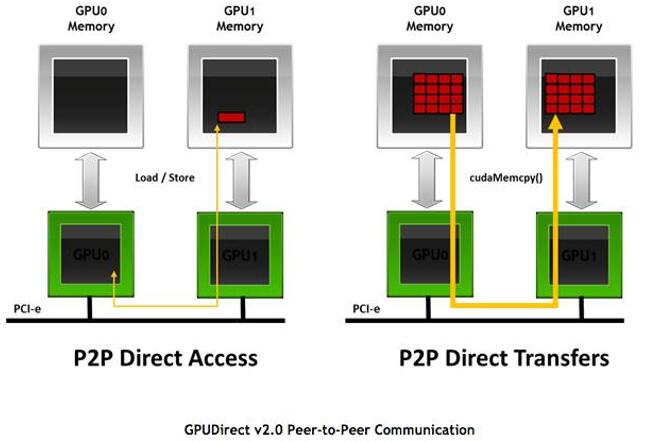

为了更好地发挥GN5多GPU卡并行计算效率,GN5支持GPUDirect,通过GPU卡之间点对点通信,可让GPU之间在无需CPU干预下,直接通过PCIe的总线进行高带宽低时延的互联通信,极大地提升了深度学习训练中模型参数交换效率。

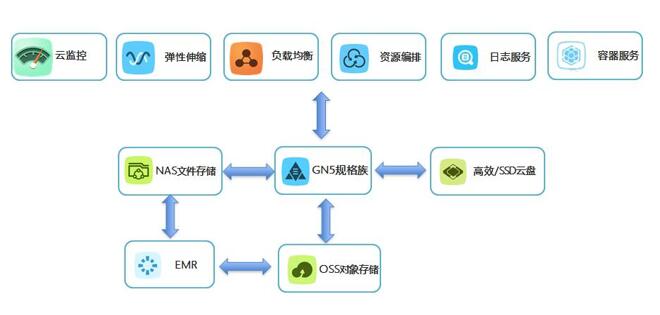

除了GPU外,深度学习还需要有海量的数据存储能力、业务服务能力、监控能力等,这在传统模式下复杂度高、工作量大、费时费力。而GN5实现了与ECS弹性计算生态的***结合,可与OSS对象存储、NAS文件存储等打通,满足深度学习海量训练数据的低成本存储和访问要求;通过EMR服务进行预处理;通过云监控服务进行GPU资源的监控与告警;通过负载均衡、弹性伸缩、资源编排等快速在云端搭建完整弹性GPU服务;并可搭配容器服务使用,简化部署和运维的复杂度,提供资源调度服务等。

GN5实例支持灵活的使用支付方式,用户可以按年支付以获得***的使用折扣;也支持按月周期付费,以降低用户的计算资源使用一次性投入成本,并且具有相对较低的单位小时使用价格;同样支持按小时的付费方式使用户以***的单次使用成本来应对临时性的短期使用需求。