威廉·吉布森(William Gibson)写于 2010 年的小说《零历史(Zero History)》中有这样一个场景:一个角色穿着迄今为止「最丑陋的 T-shirt」展开了危险的突袭,T-shirt 可使其对闭路电视(CCTV)隐身。在尼尔·斯蒂芬森(Neal Stephenson)的小说《雪崩(Snow Crash)》中,一个位图图像被用来传递可扰乱黑客大脑频率的病毒,借助计算机增强的视觉神经以腐蚀目标者的心智。诸如此类的故事形成了一种循环往复的科幻比喻:一张普通的图像具有摧毁计算机的能力。

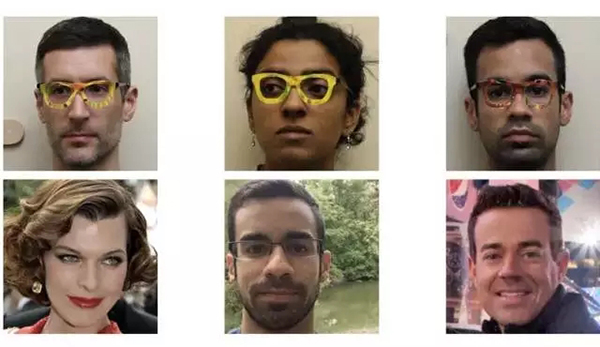

不管怎样,这个概念并非完全虚构。去年,研究者仅仅带上花式眼镜(patterned glasses),一个商用面部识别系统就做出了错误识别。花式眼镜就是在镜框上贴上迷幻色彩的贴纸,花式的扭曲和曲线在人看来是随机的,但计算机却要在带有花式眼镜的人脸上分辨出五官,而且这些人脸的轮廓很相似。花式眼镜不会像吉布森「最丑陋的 T-shirt」那般将其从闭环电视中抹去,但是它可使人工智能错认为你是教皇,或者其他人。

带有花式眼镜的研究者以及人脸识别系统的对应识别结果。

这些类型的袭击包含在被称为「对抗机器学习(adversarial machine learning)」(之所以如此称呼是由于对手之类的存在,在该情况中,对手是黑客)大量网络安全类别中。在这一领域,「最丑陋的 T-shirt」以及腐蚀大脑的位图的科幻比喻表现为「对抗性图像」或者「愚弄式图像」,但是对抗性袭击具有形式,如音频甚至是文本。2010 年早期,大量的团队各自独立发现了这一现象的存在,他们通常把可对数据进行分类的机器学习系统「分类器」作为目标,比如谷歌图片中的算法可为你的照片打上食物、假期和宠物等标签。

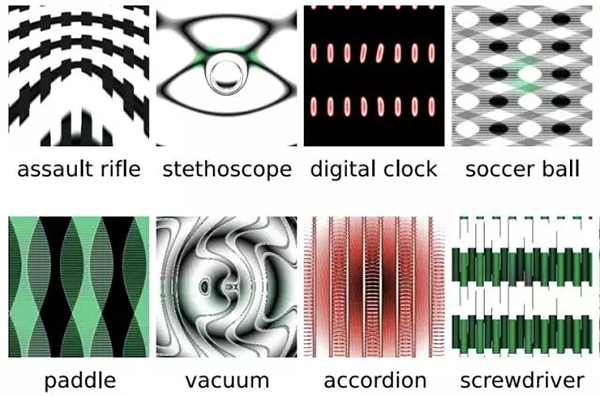

对于人而言,愚弄式图像就像是一个随机的扎染图案或者突发的电视噪点;但是对图像分类器而言,它却可以自信的说出:「看,那是一只长臂猿」或者「一个如此亮眼的红色摩托车」。就像花边眼镜使人脸识别系统发生了错误识别,分类器处理了混乱到人类永远无法识别的图像视觉特征。

这些图案可以各种方式绕过人工智能系统,并对未来的安全系统、工业机器人和自动驾驶汽车等需要人工智能识别物体的领域有重大意义。2015 年有关愚弄式图像论文的联合作者 Jeff Clune 告诉 The Verge:「想象一下你身处军队,正在使用一个自动锁定目标的武器系统,你绝不希望敌人把一张对抗性图像放在了医院的楼顶,系统锁定并攻击了医院;或者你正在使用同一个系统追踪敌人,你也绝不喜欢被愚弄式图像骗了,[并] 开始用你的无人机紧盯着错误的目标车辆。」

愚弄式图像以及人工智能识别的对应结果。

这些情节是假设的,但却非常具有可行性,如果继续沿着当前的人工智能路径发展。Clune 说:「没错,这是一个研究社区需要共同面对的大问题。」防御对抗性攻击的挑战有两方面:我们不仅不确定如何有效地反击现有攻击,而且更多高效的攻击变体在持续增长。Clune 及其联合作者 Jason Yosinski 和 Anh Nguyen 描述的愚弄式图像容易被人类发现,它们就像是视觉幻觉或者早期的网络艺术,满是斑驳的色彩与图案重叠,但是有更为微妙的方法运用它们。

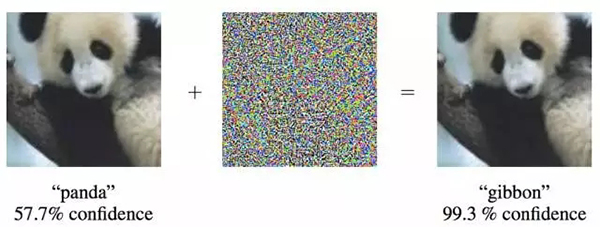

摄动可像 Instagram 滤镜一般被用于图像

有一类被研究者称为「摄动(perturbation)」的对抗性图像几乎对人眼不可见,它作为照片表面上的像素涟漪(ripple of pixels)而存在,并可像 Instagram 滤镜一般被用于图像。这些摄动发现于 2013 年,在 2014 年一篇名为「解释和利用对抗性实例(Explaining and Harnessing Adversarial Examples)(链接:https://arxiv.org/abs/1412.6572)」的论文中,研究者演示了摄动的灵活性。摄动有能力愚弄一整套不同的分类器,即使没有被训练来攻击的分类器。一项名为「通用对抗性摄动(Universal Adversarial Perturbations)(链接:https://arxiv.org/pdf/1610.08401v1.pdf)」改进研究通过成功地在大量不同的神经网络上测试摄动,使得这一特征明确起来,上个月引起了众多研究者们的关注。

左边是原始图像,中间是摄动,右边被摄动的图像。

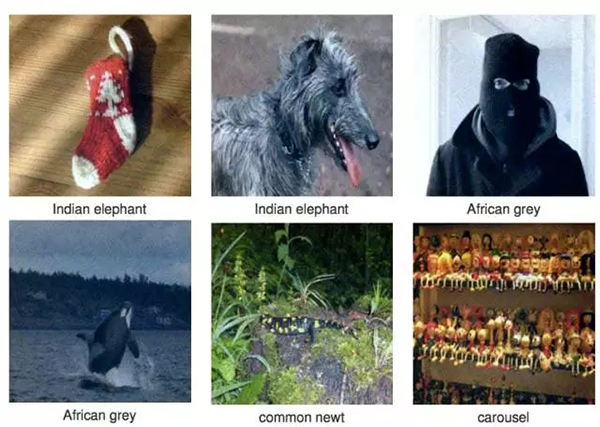

使用愚弄式图像黑进人工智能系统有其局限性:第一,需要花费更多时间制作加扰的图像,使得人工智能系统认为其看到的是一张特殊的图像而不是产生了随机错误。第二,为了在起初生成摄动,你经常——但不总是——需要获取你要操控的系统的内部代码。第三,攻击并不是一贯高效。就像论文「通用对抗性摄动」所述,在一个网络中成功率为 90% 的摄动也许在另外一个网络之中只有 50-60% 的成功率。(也就是说,如果一个存在问题的分类器正在指引一辆自动驾驶半式卡车,甚至 50% 的错误率都是灾难性的。)

为了更好地防御愚弄式图像,工程师开始了「对抗性训练」。这需要为分类器输入对抗性图像,从而让分类器可以学习识别并忽略它们,就像保镖通过脸面照片识别酒吧禁止入内之人。不幸的是,正如宾夕法尼亚州立大学毕业生 Nicolas Papernot(关于对抗性攻击他写了大量论文)所解释的,在「计算密集型策略」面前,即使这种训练也很脆弱(即,向系统输入足够的图像,它最终仍会出错)。

被摄动的图像,以及对应的人工智能识别的结果。

更困难的是,这类攻击奏效或失败的原因并不清晰。一种解释是对抗性图像利用一种被称为「决策边界」的特征,其在很多人工智能系统中都存在。这些边界是不可见的规则,它们调控了系统如何判别,如,狮子和豹子之间的不同。一个很简单的只区分这两类动物的人工智能项目将最终创造出一个意境地图。想像在一个 X-Y 平面内:右上角分布着所有该人工智能系统见过的豹子,而左下角分布着狮子。将这两个部分分开的直线——狮子变成豹子,豹子变成狮子的边界——称作决策边界。

Clune 说道,对于分类来说,决策边界方法的难题是它太绝对,太武断。「你对神经网络所做的所有事情仅仅是训练它们在各类数据间画线,而不是对它们建模以识别出它们代表了豹子还是狮子。」像这样的系统可以通过一个确定的、用各种方式操作。为了愚弄狮子-豹子分析器,你可以拍一张狮子的照片并把它的特征推到奇特的极端,但仍然让它变现为正常的狮子:给它如同挖掘装备的,和校车一般大小的爪子,以及如同燃烧的太阳一般的长鬃毛。对人类来说,这是无法识别的,但对一个检查决策边界的人工智能系统来说,这只是一只极端的狮子罢了。

据我们所知,对抗性图像从未在真实世界形成过危害。但谷歌大脑的研究科学家,联合著述了《解释和利用对抗性实例》的 Ian Goodfellow 认为这种潜在的威胁从未被忽视。「研究社区,尤其是谷歌,正在严肃地对待这个问题,」Goodfellow 说道。「并且我们正努力致力于发展更好的防御措施。」大量组织,如伊隆·马斯克创立的 OpenAI,目前正在进行或发起关于对抗性攻击的研究。目前的结论是暂时没有新技术,但关于这些攻击在真实世界中能造成多大威胁,研究者们并未达成共识。例如,已存在大量攻击自动驾驶汽车的方法,它们并不依赖于计算复杂的摄动。

Papernot 认为,广泛存在于人工智能系统中的不足并不令人惊讶——分类器被训练成「拥有好的平均表现,而并不总是针对最坏情况的表现——这是典型的从安全角度出发的观点。」也就是说,比起它的平均表现,研究者较少担心系统发生灾难性的错误。「一种处理棘手的决策边界的方法,」Clune 说道,「是使得影像分类器知晓它们无法分类什么目标,而不是试图将数据拟合进某一类。」

与此同时,对抗性攻击也激发了更深层与概念化的思考。相同的愚弄式图像可以扰乱谷歌、Mobileye 或 Facebook 独立开发的人工智能系统的「心智」,整体上揭示了当代人工智能特有的不足。

「仿佛所有这些不同的网络围坐一起,互相诉说为什么这些愚蠢的人类认识不到这个噪点图里实际上是一个海星,」Clune 说道。「那相当有趣且神秘;所有这些网络都同意这些疯狂和非自然的影像实际上属于同类。那种程度的收敛真让人惊讶。」

对 Clune 的同事 Jason Yosinski 来说,在愚弄式图像上的研究表明人工智能和自然界创造的智能之间存在令人惊讶的共同点。他注意到人工智能及它们的决策边界所犯的同类错误也存在于动物世界中,在这里动物们被「超常刺激」所愚弄。

这些刺激是自然界现象的人工版,怂恿动物违背它们的天性。这一行为首先于二十世纪五十年代被发现,当时研究者们用它使得鸟类忽视它们自己的蛋而更偏爱颜色更鲜艳的赝品,或者使得红肚棘鱼将垃圾当作竞争对手而进行争斗。只要有大的红肚绘在垃圾上面,鱼就将与其争斗。一些人曾认为人类成瘾行为,如快餐和色情文学,也是超常刺激的例子。鉴于此,人们可以认为人工智能犯的错误是自然而然的。但遗憾的是,我们需要人工智能有能力避免这些错误,表现得更好。

原文:http://www.theverge.com/2017/4/12/15271874/ai-adversarial-images-fooling-attacks-artificial-intelligence

【本文是51CTO专栏机构机器之心的原创译文,微信公众号“机器之心( id: almosthuman2014)”】