前言

关于DCI技术的探索,最近很是热门,尤其是在SDN-WAN被大家重视起来后,关于DCI技术的介绍文章层出不穷。本文着重对DCI网络中传输网络部分的技术和现有一些情况进行介绍,希望能给大家带来一定的帮助,请轻喷。

一、DCI网络的由来

数据中心最开始,还比较简陋,一个随意的房间里面放几个机柜+几台高P的空调,然后是单路普通市电+几台UPS,就成了一个数据中心。但是这种数据中心规模较小,可靠性也低,从90年代末开始疯狂发展的互联网,对数据中心的需求也是暴增,所以这类数据中心存在的不可解决的问题来了:空间位置不足,电力供应不足,无冗余,无SLA保障,使得用户开始找另外的数据中心,进行业务部署。这时候,新数据中心与老数据中心开始有了网络互联需求,产生了最初的DCI网络,即Data Center Inter-connect,这里囊括了物理网络层面和逻辑网络层面的技术。

最初的DCI网络,是通过internet直接互联的,后来开始考虑到安全性,使用加密手段,考虑到的服务质量,使用了专线,考虑到带宽,使用了光纤直连。

二、 DCI网络的发展

DCI网络从Internet互联,再到几M专线,发展到现在数10T的波分互联,其实经历时间不长,客观上是对互联网发展的一个反应。最初,用户使用公网VPN隧道的方式,将其业务直接通过公网进行传输,这种方式由于受到公网各环境(全球网络带宽拥塞,劣等路由,线路抖动,链接重置,防火墙等等)和成本情况的影响,所以适合小流量,带宽质量要求低,非实时,同时安全要求低的业务使用;后来,数据中心中的业务越发受到关注,业务开始逐渐增加部署,服务器数量成线性进行增长。大量业务部署后,这些通过网络传送的业务对公司、行业的影响越来越大,所以对网络的要求也越来越高,首先就体现在带宽和链路稳定性上,因此数据中心用户开始租用运营商电路专线,在SDH网络上承载的MSTP专线由于其稳定性高,带宽更大,运营商复用程度高等特点,开始大卖。

后来,业务持续的爆发式发展,数据中心间的数据开始了对时延和冗余的要求,特别是金融类客户,对时延要求特别高,于是对专线的要求也更为提升了;再者,用户开始要求大颗粒,比如2.5G,10G的单链路带宽,还要求双路由保护,保证LSA达到4个9~5个9。

即便如此,互联网发展的力量是惊人的,日志传输,数据库同步等业务大势增长。在出于成本,交付时长,服务质量等各方面的需求考虑,拔尖的公司(特别是像Google,FB这样拥有大数据的互联网公司)开始撇开运营商,通过租用裸光纤来自己建DCI网络。在使用裸光纤的最初时,最先也是通过单个光纤跑单个信号的方式,比如一对光纤用一个万兆ZR的模块,可以传输80公里远,这距离对一般的同城数据中心之间传输已经足够了。但是这种方式的不足是,一方面光纤使用量随带宽线性增长、成本增高,另一方面单光纤的带宽利用率太低(当然,对于运维来说还有裸光纤的资源和路由管理也是一个老大难问题),而且此时单光纤10G带宽也不能满足业务增长的需求,于是DCI网络开始了波分WDM时代。

WDM时代有两种方式出现在了DCI网络中,也就是粗波分CWDM和密集波分DWDM。最初的一些用户基于成本的考虑,使用万兆粗波分彩光光模块,利用CWDM技术,进行DCI互联,但是这种系统最多支持16波10G,且EDFA不能对粗波分所在波长进行信号放大,其无源中继距离也相当受限。因此,随着大规模数据传输的需求不断上涨,用户不得不开始使用容量和性能更高的DWDM系统。

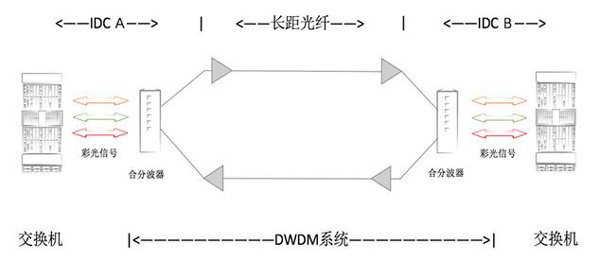

纯DWDM系统的DCI网络结构:

DWDM系统是目前通信网中最主要的大带宽传输系统,各公司出于业务量,成本,运维各方面考虑的情况下,早期使用交换机插万兆彩光模块,出来的彩光以太网信号直接上无源DWDM设备。这种系统运维简单,在成本可控的情况下,一般可以做到40波*10GE信号,总系统带宽可以到400G,且无过高的网络运维成本,普通IP网络工程师进行低成本学习就可以进行运维,曾经被一些有需求的公司广泛使用。但是互联网的发展是蓬勃的,10GE单波的信号很快就不能满足需求了,这时候需要更高的单波信号系统,如单波40GE&100GE。不过此时能放在交换机上的40GE&100GE的以太网彩光光模块,市场上还没出现有,并且在出现后的成本也是长时间居高不下,但是业务等不了,因此只能另辟蹊径,于是OTN这个在电信网络中叱刹风云的东西出现在了Google,FB这样互联网公司的DCI网络中。

互联网开始接触OTN,基本上都是从10GE开始的,那时10G彩光+DWDM盒子已经不能满足业务增长需求,并且这种方式由于没有基于光层面的管理方式,所以也满足不了批量网络,特别是长距网络的运营要求;加之在100G的OTN面市后,经过几年发展,尤其是经过运营商的几次集采以后,成本大幅下降。综上这些原因,10GE彩光+DWDM盒子的方式开始慢慢被OTN系统替换了。由于技术发展和成本降低,在互联网行业的DCI网络中基本就没有用过40G的OTN系统,直接从10G系统升级到100G系统,中间也考虑过如果使用100G系统时,故障后影响范围面广等问题,但是业务增长需求依旧是首要的,所以线路侧(面向传输光纤一侧的信号)从10G直接到了100G,保证了线路侧的波分系统能满足长期带宽发展的需求。而客户侧(面向交换机对接一侧的信号),考虑到现有10G客户系统还挺多,为了保护已有投资,需要兼容现有10G颗粒业务,并在未来可以升级为客户侧100G系统,所以为了让10G和100G系统在DCI网络升级可以进行过渡,就出现了基于10个ODU2–>1个ODU4的客户侧10*10G,线路侧1*100G的业务卡,并且这个板卡得到广泛应用。

OTN网络以其丰富的管理开销,高可靠和多样化的保护方式,集中专业化NMS管理平台,以及大带宽,的确为互联网的发展起到了及其重要的作用,让网络运营更加专业和细分,当然最重要的是满足的互联网业务快速增长的需求。

使用OTN进行点到点DCI网络的典型拓扑:

此时OTN网络,已经不再是电信网络专有技术了,互联网的崛起,让这样一个传统的电信网络技术进入了DCI网络行业。

三、 DCI网络现在的运营路数

DCI网络在引入了OTN技术后,运营方面相当于新添加了一整块以前没有的工作。传统的数据中心网络为IP网络,属于逻辑网络技术。而DCI中的OTN是种物理层的技术,和IP层怎么能一起友好方便的工作,是运营要走的一条很长的路。

目前在基于OTN的情况下的运营工作目的与数据中心各子系统的运营目的是一样的,都是为了使基础设施高成本投入的资源发挥最大功效,对上游业务提供最好的支撑。提高基础系统的稳定性,方便运维工作高效开展,协助资源合理分配投入,把已投入资源发挥更大作用,而把未投入的资源合理分配。

OTN的运营工作主要涉及几块:运营数据管理,资产管理,配置管理,告警管理,性能管理,DCN管理。

3.1 运营数据

对故障数据进行统计,区分人为故障,硬件故障,软件故障,第三方故障,并对故障较高的类型进行统计分析,制定针对性的处理方案,未来标准化后,为自动化处理故障进行铺垫。根据故障数据分析,为以后从架构设计,设备选型等工作对系统进行优化,以降低后期运维工作的开销。针对OTN从光放,板卡,模块,合分波器,跨设备跳纤,干路光纤,DCN网络等进行故障统计,参入厂商维度,第三方维度等,多维度进行数据分析,以便数据更能准确反映网络现状。

对变更数据进行统计,区分变更复杂度、影响面,对人员进行分配,按照需求分析、变更方案、设定窗口、通告用户、操作执行、总结复盘的流程进行变更,最终可以把不同的变更分窗口,甚至安排在白天执行,对变更人员分配更加合理,降低工作生活压力,提升操作工程师的幸福感。并能把最终统计的数据整合,用作对人员工作效率和工作能力进行参考,同时也让常态的变更向标准化、自动化方向发展,减少各方面开销。

对OTN业务分布进行数据统计,帮助自身在业务量增加后,随时掌握网络使用情况,进行全网网络分布和业务分布的把控。做粗了可以知道单个通道是由哪个网络业务进行使用的,比如外网,内网,HPC网络,云服务网络等,做细了可以结合全流量系统,对具体业务流量使用情况进行分析,将不同的带宽成本分摊到不同的业务部门身上,帮助其进行业务流量优化工作,随时对低使用率的工作通道进行回收和调整,对高使用率的业务通道进行扩容。

统计稳定性数据,该数据是SLA的主要参考数据,也是每个运维人员头上的达摩克利斯之剑。OTN的稳定性数据统计,由于本身具备保护所以要进行区分,比如单路由中断,IP层面总带宽不受影响是否计入SLA;如果IP带宽减半,但对业务不影响,是否计入SLA;单个通道故障,是否计入SLA;保护路径时延增加,虽然对网络带宽无影响,但是造成了业务有影响,是否计入SLA,等等。一般的做法是建设前就告知业务方存在的抖动、时延变化等风险,后期SLA,以故障通道数*单个故障通道带宽为计算基础,除以总通道数*对应通道带宽的总和,再乘以影响时间,得到的值作为SLA的计算标准。

3.2 资产管理

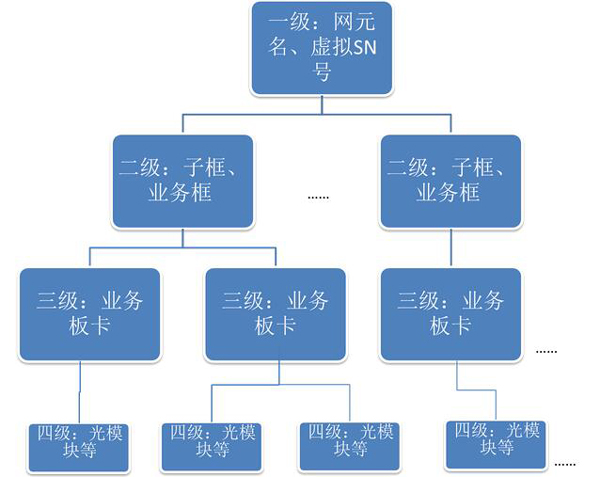

OTN设备的资产也要有生命周期管理(到货、上下线、报废、故障处理),但是不同于服务器,网络交换机等设备,OTN设备结构更复杂。OTN设备涉及到的功能性板卡数量众多,所以在进行管理时需要设计一个模式,以便进行全量的资产管理。数据中心内的主要IP资产管理平台是基于服务器、交换机,会设置主从设备级别。OTN在此基础上,主从级别会涉及层级管理,但是层级更多。管理级别主要以网元->子架->板卡->模块进行:

- 网元是个虚拟设备,无实物,是OTN网络中用作管理使用、第一逻辑点,属于OTN网络管理中的一级单位。一个物理机房可能有一个网元,也有可能有多个网元。一个网元包含多个子架,如光层的子架,电层子架,外置的合分波器也算是一个子架,每个子架可以串联,属于单个网元站点以内的子架,进行编号。另外,网元没有一个资产的SN号,所以在这方面要与管理平台对齐,尤其要和采购清单、后期运维管理平台的信息对齐,避免资产排查不对应,毕竟网元是一个虚拟的资产。

- OTN的设备最大的具体物理单位就是机框,也就是子架,属于一级网元的次一级,既是二级单位,一个网元至少有一个子架设备。这些子架分不同厂商的不同型号,功能各不相同,有电子框、光子框、通用子架等等。子架具有具体的SN号,但是不能通过网管平台自动获取到其SN号,只能现场查看。子架上线后再移动变更情况极少。子架内会涉及多种板卡安插。

- OTN的二级子架内部,是有安插具体的业务槽位的,槽位具有数字编号,用作插放各种光网络的业务板卡。这些板卡是支撑OTN网络业务的基础,每块板卡都可通过网管查询到其SN号。而这些板卡就是OTN资产管理中的第三级单位。各种业务板卡大小不一,占用槽位数不同,功能也各不相同,因此当板卡需要归属到二级单位子架的时候,资产平台要允许单个板卡可以使用多个或者半个槽位,以便对应子架上的槽位编号。

- 光模块资产管理,模块是依赖在业务板卡上使用的,所有业务板卡要允许进行光模块归属,但不是所有OTN设备的板卡都要插光模块,所以也要允许板卡上面没有模块的存在。每个光模块都有SN号码,插在板卡上的模块要与板卡的端口编号进行对其,以便位置查找。

所有这些信息可以通过网管平台的北向接口进行数据采集,通过线上采集与线下核查匹配进行资产信息的准确性管理。另外,OTN设备上还会涉及光衰器,短跳纤等,这些消耗性器件就可以直接按照耗材进行管理。

3.3 配置管理

波道配置时,需要进行业务配置,光层逻辑链路配置,链路虚拟拓扑图的配置,如果单个波道可能配置了保护路径,这个时候的波道配置就更加复杂,随之而来的配置管理也将更复杂,单是管理波道走向就需要一个专用的业务表,还要在表格中区分业务方向,使用实线虚线。当OTN通道和IP链路进行对应关系管理时,特别是在OTN保护的情况下,需要一个IP链路对应多个OTN通道,这时管理量增加,且管理复杂,又增加了管理excel表的需求,要完整管理一条业务的所有元素,多达15个。当工程师要对某一个链路进行管理时,他需要把这个excel表格找出来,然后去厂商的NMS上面去寻找对应,然后进行操作管理。这就更需要两边信息的同步性,由于OTN的NMS平台和工程师自己做的excel都是两个人为的数据,很容易出现信息不同步的情况,任何一个错误都将导致业务信息与实际关系不对应,都可能导致在变更调整的时候影响业务。所以,将厂商的设备数据通过北向接口,采集到一个管理平台,再在这个平台上,将IP链路的信息进行匹配,使得信息能自动化的根据现网业务变化进行调整,确保信息的集中管理和单一准确来源,保证配置管理信息的准确性。

在进行OTN业务开通配置时,做好每个接口的信息描述,然后通过OTN的NMS提供的北向接口进行OTN信息收集,相关描述与IP设备通过北向接口采集到的端口信息进行配对,就能使得OTN通道与IP链路在平台化上的管理,免去人工进行信息更新工作。

对于DCI传输网络的使用中,尽量避免使用电交叉的业务配置,这种方式在管理起来逻辑极为复杂,并且本身也不适用DCI网络的模型,可以从一开始的DCI设计时就进行规避。

3.4 告警管理

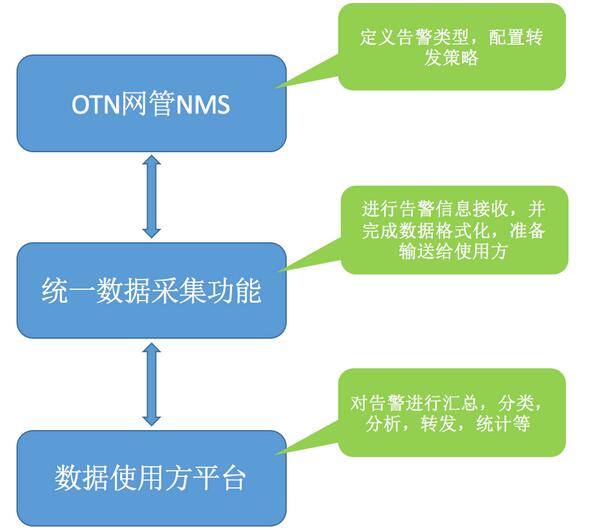

OTN由于其复杂的管理开销,长距传输时的信号监控,不同业务颗粒的复用嵌套等原因,出现一个故障可能会报几十上百条告警信息。虽然厂商已经做了四个等级的告警分类,每个告警取名不同,从工程师运维角度来看,依旧极为复杂,需要经验丰富的人员才能第一时间判断出故障原因。而传统的OTN设备的故障外发功能主要是使用短信猫或者邮件推送,但是两个功能对于集成与互联网公司基础系统现有的网络告警管理平台来说比较特殊,单独开发成本高,所以需要更标准的北向接口进行报警信息收集,在保留公司已有的相关平台情况下,进行功能扩展,然后再将报警推送给运维工程师。

因此,对于运维人员来说,需要的是先让平台对OTN故障产生的告警信息进行自动收敛,然后再接收这些信息。因此,先在OTN的NMS上面进行告警分类设置,然后在上次的告警信息管理平台上进行发送筛选工作。一般OTN告警的做法是NMS会设置推送所有第一二类的告警到告警信息管理平台,然后平台再进行按时间、按汇总的信息、接收人范围等维度,把单个业务中断的报警信息、主光路中断报警信息、(若有)保护倒换报警信息推送给运维工程师,有以上三个信息大概就能进行故障判断和处理了。在设置接收时,可以对合波信号故障这种断光纤才会产生的重大告警,进行例如电话通知设置,例如以下几种:

NMS的北向接口,如华为中兴阿朗现在都支持的XML接口进行告警信息推送,也是目前常用的。

3.5 性能管理

OTN系统的稳定性,高依赖与其系统各方面的性能数据,比如干路光纤光功率管理,合波信号中的各通道光功率管理,系统OSNR余量管理等。公司网络系统的监控项目中应该加入这些内容,以便随时了解系统性能,并及时进行性能优化,便于网络稳定性的保证。另外,长期的光纤性能质量监控,还可以用来发现光纤路由的变动情况,防止出现一些光纤供应商在未进行通知时,将光纤路由进行更改的情况发生,导致运维盲区,出现光纤同路由风险。当然,这需要大量数据进行模型训练,以便对路由变动的情况发现更为准确。

3.6 DCN管理

这里的DCN是指OTN设备的管理通信网络,负责对OTN各个网元进行管理的组网结构,OTN的组网也会影响到DCN网络的规模和复杂度。一般DCN网络的做法有两种:

- 在OTN全网中确认主备网关网元,其它非网关网元都为普通网元,所有普通网元的管理信号通过OTN中跨OTS层的OSC通道,到达主备网关网元,再接入到NMS所在的IP网络中。这种方式可以减少网元在NMS所在IP网络的部署量,而使用OTN本身系统解决网管问题,但是干路光纤中断,对应远端的网元也会受影响而脱管了。

- 将OTN全网的网元全部配置成网关网元,每个网关网元都单独与NMS所在的IP网络进行通信,不走OSC通道。这样保证了网元的管理通信,不受主干光纤中断的影响,网元依旧可以远程管理,都上IP网络,对于传统IP网工的运维成本也会降低。

DCN网络在建设之初要进行好网元规划和IP地址分配,特别是网管服务器部署时尽量与其它网络隔离,否则后期网络中mesh链路过多,维护中网络抖动平凡,普通网元连不上网关网元等问题就会出现,也会容易出现生产网地址与DCN网络的地址重复使用的问题,导致生产网受影响。

四、 DCI网络发展的方向

数据中心所有者的在建设跨数据中心网络互联时,其考虑的问题主要是大带宽,低延迟,高密度,快部署,易运维,高可靠性几个问题。目前主流的大带宽OTN技术主要是几家大型电信设备制造厂商所把控(芯片另说),比如华为,中兴,阿朗。他们面对的主要客户是传统电信运营商,所以OTN这个产品特点就主要面对这些运营商的业务特点进行设计,也正因为如此,目前OTN其在互联网行业的DCI网络应用中出现越来越多的不和谐的问题。

OTN设备的特点是,也同样是DCI所遇到的问题,丰富的业务开销,网络具备强大的OAM能力,不同颗粒带宽的调度复用能力,长距离情况下的线路容错能力,采用低压直流,设备功耗利用率低等特点。

- 丰富的业务开销能力,要求运维人员更专业化能力,更依赖厂商技术支持,技术更加封闭。

- 强大的OAM能力,标准不统一,与跨网络的对接更加困难更加独立,无用的功能也对DCI网络带来了更多的传输运营成本。

- 不同的颗粒的调度能力,使得业务封装帧结构更为复杂,嵌套字节更多。

- 长距离的线路容错能力,使得FEC的算法复杂,消耗的开销更大和处理时间更长

- OTN设备48V-DC的供电模式,和大部分数据中心所使用的标准19英寸220V-AD(或者240V-DC)机柜不同,安装复杂且需要机房电力改造

- 传统OTN设备机框大,不适合标准机柜安装,且容量密度不高,后期扩展麻烦且要机柜腾挪或改造新加。

目前,我们的DCI网络主要是是为跨数据中心的数据提供管道,业务模型特点主要是:带宽颗粒度要求统一且单一,带宽大,跨数据中心的业务(尤其多活IDC,大数据类业务)延时要求低,对网络的稳定性要求较高;同时由于互联网行业缺少相关的专业技术人员,DCI网络的运维工作需要“简单”“简单”“简单”—重要事情说三遍(哪种网络不是呢?);互联网的爆发式发展,使得建设和扩容周期要求更短(运营商的OTN扩容周期一般是半年~1年,而互联网自己的DCI扩容要求是1~3个月),因此要压缩各方面的时间。

因此OTN为DCI提供了一种可用的解决方案,但是OTN绝不是DCI最合适的方案,在DCI网络蓬勃发展的现在,越来越需要一些合适的解决方案出现,以解决从成本到建设运维上遇到的各种问题。而这些问题,无外乎就是围绕这DCI网络的六个要求来的(大带宽,低延迟,高密度,快部署,易运维,高可靠性):

- 大带宽,DCI传输网络不像运营商会有丰富的类型颗粒,DCI传输网络的带宽颗粒更简单,目前常用的10G或者100G,未来200G/400G等,所以有了大带宽就不需要再做其它颗粒度的带宽。DCI传输网络由于其距离范围一般不会过长的特点,使用基于200G的PM-16QAM双载波调制的400G系统,无电中继传输距离大概能传输500公里(PM-64QAM的大概是200公里),使得DCI这种城域骨干传输不会受限于距离。

- 低延迟,DCI的业务要求,特别云计算做池化资源,多活数据中心时,延迟是按照微秒级别计算,让数据传输时间越短越好,恨不得超光速。去掉不必要的数据处理工作,降低信号传输路径两个方面努力。比如,去掉100G OTN所使用的SD-FEC功能,单个背靠背可以节省200微秒时间,去掉跨阶的OTN封装可以节省几十微秒时间,对重点业务合理使用hubspoke拓扑,保证路径最短。当然也可以再次配合IP层面的MPLS,QOS等,尽量保证数据转发层面的时延也更优。

- 高密度,单个U,或者2U,能做到上T的带宽,DWDM光层与电信号层面解耦,提升设备的密度接口,缩小光模块的尺寸。比如,使用QSFP28的光模块,可以保证单设备的100G接入能力大大提升,线路侧使用CFP2的采光模块,可以保证整体设备传输带宽能力提升,1U可以1.6T,3.2T。目前国际上已经有很多相关产品在出现,比如ADVA,coriant,ciena这类的公司,当然国内的华为也推出了相关的902产品,不过截止文章完成,好像还没有完成工信部的入网测试。高密度会产生高功耗的散热问题,于是要摒弃原有OTN的左右进出风、上下进出风的散热方式,高密度设备需要采用与数据中心服务器交换机一样的前后进风散热的方式,以满足设备散热需求。

- 快部署,使用目前标准化IDC的19英寸机架,类同于主流服务器的形态,使用AC-220V直接供电,免掉电力和机柜改造,实现货到机房马上上架,插上电源就能配业务,并做好标准化验收工作,实现快部署。

- 易运维,DCI的业务模型要求,跨数据中心的距离不会很远,而复杂的管理开销,OAM等功能在这种场景中没有了太大发挥作用的必要,并且复杂处理还降低了数据传输效率,提升了数据处理时间,还对技术的要求更高,更封闭。直接以太网的方式对接信号,免去OTN的复杂开销,那么传统IP网络工程师就能对DCI系统运维。在结合如YANG model,REST API,netconf等新型北向接口后,对DCI传输设备管理与IP网络设备管理用同一种接口进行开发,从而更好的进行统一的平台化网络集中管理。

- 高可靠性,多物理路由和对上层无感知的保护技术将继续在DCI传输网络中发挥作用,底层链路层面的故障除非在完全中断的情况下,其它原因都不应该对业务产生任何感知或影响,不管是保护倒换,链路抖动,时延增加等。

根据这些特点,目前常规的DCI解决方案大概有两种:

- 使用纯DWDM设备,交换机上使用彩光光模块+DWDM的合分波器,在单波道10G的情况下,这种成本极低,且产品可选度丰富,10G彩光模块在国内早已生产,成本已经很低(其实10G的DWDM系统,在早几年前就开始火了,但一些更大带宽需求的到来,不得不将其淘汰掉,而那时100G的彩光模块还未出现。)100G目前国内刚开始有相关的彩光模块出现,成本还不是足够低,但是其总会在DCI网络中写上浓墨重彩的一笔。

- 使用高密度的传输OTN设备,它们220V交流电,19英寸设备,1~2U高,部署更加方便。关闭SD-FEC功能,降低时延,配合光层面的路由保护,提升稳定性,并且行的可控制型的北向接口也提升了设备扩展功能开发能力。但是仍旧有OTN技术的保留,管理还是会相对复杂。

除此之外,现在第一梯队的DCI网络建设者正在做的事情主要是对DCI传输网络进行解耦,包括0层的光与1层的电的解耦,以及传统厂商的NMS与硬件设备的解耦。传统的做法是某厂商的电处理层面设备必须配合同样该厂商的光层面设备,且硬件设备必须配合厂商专有的NMS软件进行管理,这种传统方式有几大弊端:

- 技术封闭,理论上光电层面是可以互相解耦的,而传统厂商故意做成不解耦,以便控制技术的权威性。

- DCI传输网络的成本主要集中在电信号处理层,系统初期建设成本低,但是扩容时候厂商会以技术唯一性为要挟进行提价,扩容成本大大增高

- DCI传输网络的光层面投入后,受限只能同一厂商的电层设备使用,设备资源利用率低,不符合网络资源池化发展方向就,更不利于统一的光层资源调度。解耦后的光层面,在建设初期单独投资,不受未来多厂商同用一套光层系统的限制,并且结合光层的北向接口,配合SDN技术,进行光层面的波道资源进行方向调度,提升业务灵活性。

- 网络设备直接通过例如YANGmodel的数据结构,与互联网公司自有的网管平台进行无缝对接,节省了管理平台的开发投入,同时免去了厂商提供的NMS软件,提升了数据采集效率和网络管理效率。

所以,光电解耦是DCI传输网络发展的新方向,可以预见的未来DCI传输网络光层可以是配合ROADM+南北向接口构成的SDN技术,对波道进行任意开通、调度和回收,系统里面多家厂商的电层器件混合使用,甚至以太网接口和OTN接口混合在同一套光系统上使用的情况,都将成为可能,届时系统的扩容、变更等方面的工作效率将大大提升,光电层面也将更方便进行区分,网络逻辑管理更清晰,成本将大大降低。

对于SDN来说,核心前提是网络资源的集中化管理分配。所以,梳理下在当前的DCI传输网络上可以进行管理的DWDM传输网络资源有哪些呢?

波道、路径、带宽(频率)就这三样。因此,光+IP的协作中的光其实就是围绕着这三个点来的管理和分配来进行的。

IP和DWDM的波道是解耦的关系,所以如果一个IP逻辑链路与一个DWDM的波道对应关系是前期配置完成的,而后期要调整这个波道与IP的对应关系,可以通过OXC的方式,来进行毫秒级的快速波道切换,能使得IP层面无感知。通过对OXC的管理,可以实现各个站点上的传输波道的资源集中化管理,以至于配合业务SDN化。

单个波道的与IP的解耦调整,仅仅是一个小的部分,如果考虑在调整了波道的同时,还能进行带宽的调整,就可以解决不同业务在不同时间段的带宽需求调整问题,大大提升已建设带宽的使用率。所以,在配合了OXC进行波道调整的同时,结合灵活栅格技术的合分波器,可以让单个波道不再有固定的中心波长,而是让其覆盖可以伸缩的频率范围,从而达到带宽大小的灵活调整。并且,在对于一个网络拓扑内,使用多个业务的情况下,可以进一步提升DWDM系统的频率使用率,将已有资源进行饱和使用。

在有了前两者的动态管理能力后,传输网络的路径管理可以帮助整个网络拓扑具有更高的稳定性。根据传输网络的特点,每个路径都具备有独立的传输波道资源,因此将每一段传输路径上的波道进行统一管理分配的意义非凡,这将为多路径的业务提供最优的路径选择,并最大限度的将所有路径上的波道资源进行使用。就如同ASON中,对不同业务进行金银铜区分,以保证最高等级业务的稳定性。

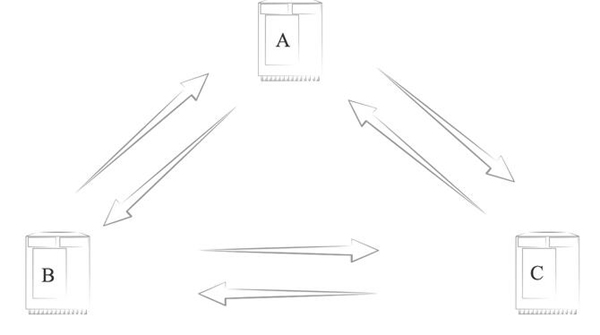

例如,有A,B,C三个数据中心组成的一个环网。有业务S1(如内网大数据业务),从A到B到C,占用了这个环网的1~5波,每一波100G带宽,频率间隔为50GHz;有业务S2(外网业务),从A到B到C,占用了这个环网的6~9波,每一波100G带宽,频率间隔为50GHz。

就平时而言,这种带宽和波道使用情况是满足需求的,但是当有些时候,例如新增一个数据中心,业务需要短时间进行数据库的迁移,那么内网带宽在这个时间段的需求就翻了几倍,原来500G带宽(5个100G),现在需要2T的带宽。那么传输层面的波道可以进行重新计算,在波分层部署5个400G通道,每个400G的波道的频率间隔由原来的50GHz变成75GHz,配合灵活光栅的ROADM和合分波器,打通整个传输层面的路径,于是这5个波道占用了375GHz的频谱资源。在传输层面的资源准备就绪后,再通过集中管理平台,对OXC进行调整,在毫秒级别的时延下,将原来1~5波100G业务信号所使用的传输通道,调整到新准备的5个400G业务通道上去,这样就完成了带宽和波道根据DCI的业务需求进行灵活调整的功能,这样是可以实时进行的。当然,这里面的IP设备的网络连接器需要支持100G/400G的速率可调和光信号频率(波长)调整的功能,这将不是问题。

关于DCI的网络技术中,传输能完成的工作是非常底层的,要做到更智能的DCI网络,还需要配合IP一起实现。例如配合在DCI的IP内网使用MP-BGP EVPN+VXLAN,快速部署跨DC的二层网络,这能对已有的网络设备进行较高的兼容,并满足租户虚机跨DC灵活漂移等需求;在DCI的IP外网使用segment routing,进行基于源业务区分的流量路径调度,满足跨DC出口的流量可视化,快速路由恢复,带宽高利用率等需求;底层传输网络配合多维度的OXC系统,可以实现比目前常规ROADM跟细颗粒度的业务路径调度功能;使用无电的传输波长转换技术,更能使得波道频谱资源碎片化的问题迎刃而解。上层和下层的资源融合一起进行业务管理部署,灵活调配,提高资源利用率将是未来必然的方向。目前国内一些大公司在关注这块,一些初创的专业化公司已经在进行相关技术产品的研发。希望在今年能看到相关的整体解决方案面市。或许不久的将来,OTN将在电信级网络中也将消失,只剩DWDM。

作者简介:李言,曾负责互联网行业的传输网络建设运营工作多年,对DCI传输网络有较为透彻的理解,目前在主要负责数据中心基础网络(L1~L4)的运营工作。