前向传播之-***化

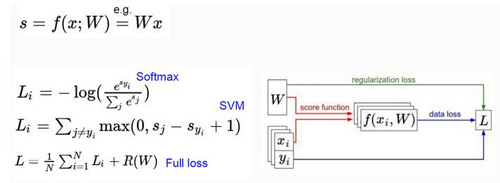

通过对之前课程的学习,我们已经能够对于一个输入数据得出它的最终的一个LOSS值,那么下面就该咱们如何去找到一个***的参数矩阵,使得最终的LOSS值达到一个最小的范围。这就引入了咱们的***化问题。下面咱们通过几种解决方案来详细讨论如何处理这个***化的问题

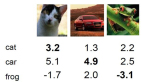

首先咱们就算不经过大脑思考也能得出一种方法,我把它叫做一个简单粗暴的想法就是咱们随机的去找一组组的权重参数矩阵W,每一次咱们都通过整个计算流程得出这组权重计算出它的一个LOSS值,就像上面的代码的流程一样,***对比找到一组还算凑合的权重参数。这个方法咋样呢?很蠢是吧,但是也是一种办法。下面咱们就该进入思考就行改进了!

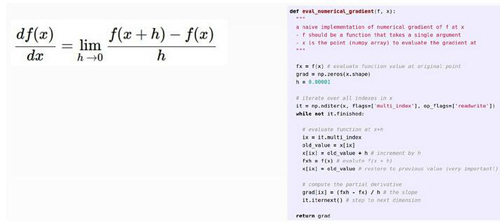

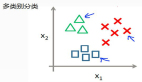

我在这里先给大家做一个比较形象的比喻,为了寻找***的W参数矩阵,咱们就像蒙着眼镜在一个山坡上寻找山坡的***点一样,这个山坡咱们可以把它当成LOSS值的山峰,咱们的目的就是能够找到一个山峰的***点也就是LOSS值最小的那个点。那么咱们该怎么走才能使得咱们朝着一个LOSS值下降的方向呢?我们可以想象一下,咱们要找到山坡的***点需要一个方向,也就是说咱们首先需要得出一个明确的方向,这个方向能够使得咱们朝着山坡下面走去寻找***点。那么咱们该如何得出这个方向呢?

这就是咱们这节课的核心也就是***化问题的解法,跟随梯度去寻找山坡的***点。梯度也就是山坡的一个最陡峭的方向,我们沿着这个最陡峭的方向可以最快的走到山坡的***点,这里就引入了咱们这个梯度下降的问题,什么叫梯度下降呢?它的意思简单的说就是咱们不是已经找到最陡峭的方向了嘛,那么咱们就沿着梯度的反方向去走,这就是梯度下降的直观表达。之所以要反向就是由于咱们的梯度方向是使得LOSS值增加幅度***的方向,所以咱们为了LOSS能减少就要朝着梯度下降的方向去寻找最小点。

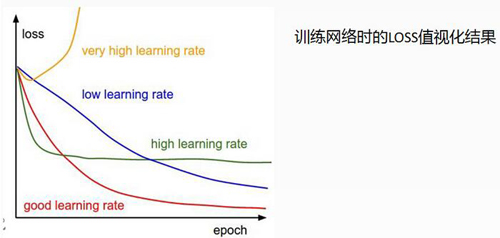

咱们接下来要讲的就是这个学习率了,咱们现在已经找到了一个要往下走的方向了,就差一个走的距离了。学习率就是咱们一次沿着这个梯度下降的方向走多远,这个学习率可以说对于咱们整个***化问题起着决定性的作用,因为如果学习率太大我们有可能有跳过***点而学习率太小又会使得咱们整个网络收敛的太慢。所以设置学习率还是很有学问的,这里咱们这是引入这个知识点,在之后的神经网络中咱们会再详细讨论学习率这个问题的!

【本文是51CTO专栏作者唐宇迪的原创稿件,转载请注明出处】