【51CTO.com原创稿件】在这个快速消费的时代,互联网已经和人们的日常生活紧密相关,随着人们的需求和产品功能的细分,消费被重新定义,如何"留住用户",成为牵系企业于互联网立足生存的首要课题。本文将从两个方面:分析和思路、技术实现,讲述如何把您的用户留下来。

【讲师简介】

郭炜: 毕业于北京大学,加入易观智库之前,曾任联想研究院大数据总监,万达电商数据部总经理、并曾在中金、IBM、Teradata公司担任大数据方向重要岗位。在大数据采集、存储、处理、挖掘、应用研发等方面具有丰富的理论和实践经验,对大数据前沿领域研究,包括视频、智能Wi-Fi, Beacon等大数据软硬数据处理一体技术有独特的见解与实践。在电商、移动互联网、商业地产、百货、移动通信、零售、院线等多个业务领域大数据方面具有搭建团队、系统以及分领域的分析与算法经验。

生命周期管理

想要留住用户,首先要回答三个问题:一,这个用户是从哪里来的。二,流失的用户去哪儿了。三,针对这些流失的用户如何争取回来。回归到如何做数据分析,主要有四个步骤:生命周期管理、运营转化分析、用户分析、应用评级。如下图所示:

“7天法则”分析不同事件下的用户留存

使用“7天法则”,首先是,分析每一次活动之后,七天之内用户留存的趋势怎么样,这个用户在七天之内是不是又再次激活了App,还是没有再使用。分析这些用户单次的使用时长,包括日、周、月启动次数的分布,进而分析出来到底哪些人是羊毛党,哪些人是忠实用户,哪些人会留下来成为App用户,而哪些人是不值得挽留的。不管是自己做还是使用第三方工具,都会分析这些趋势。

第二,什么时候该换产品思路了。很多产品,特别是在初期,可能在七日内的留存不到10%,等于这个产品的有效价值并没有体现出来,这个时候要么需要调整产品思路,要么调整运营思路,证明产品价值并没有吸引最终用户留下来,这个时候可能要对产品价格做比较大的调整,认为这个方向没有问题,进行切口的调整和切换,继续再向这个方向走。

运营转化分析

运营转化分析看似一个简单的漏斗分析,每个层次都有它的故事,都有它所关注的重点。

营销渠道:哪些是你的用户?

浏览运营位:哪些用户看了就走?你的老用户是怎样做的?

提交订单(购物车):哪些用户冲动消费了?

支付订单:没支付的这些用户到哪里去了?

分享:哪些内容具有传递性?

通过支付转化率和渠道来源用户分析不同营销渠道的质量,辅助决策在有限的资源下优选哪些渠道推广。分析页面不同位置的转化质量,辅助决策产品、运营改进,获得更好更好的效果。

用户分析

用户分析其实就是分析你的用户长什么样?从哪里来,到哪里去?通过10亿终端的覆盖,通过算法模型计算出你的应用用户特征,性别、年龄…

应用评级

认清大局,才认清自己,你的评级是多少?你的用户价值是多少?

看行业趋势:确定是否逐渐远离风口。看行业均值、TOP10:市场是否已被领头羊蚕食?长尾几无生存空间?看行业排行:自己是否还有机会?寻求新的切口?

如何实现大数据平台

郭炜以易观为例,详细讲解了大数据平台实现的方法。

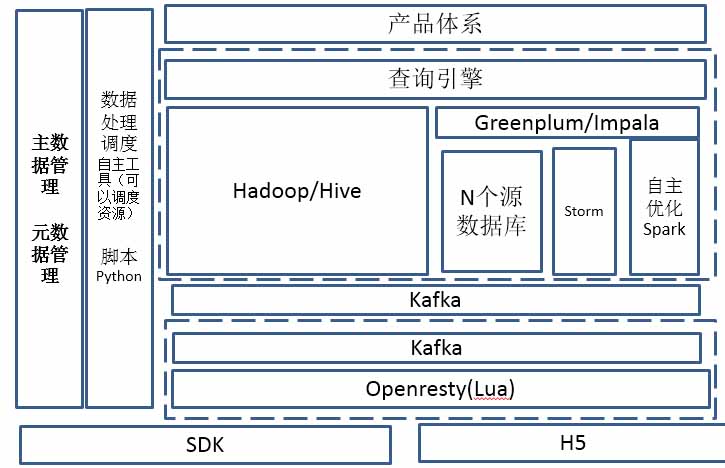

首先,底层在读取数据的时候,SDK嵌入到每一个开发的App里,包括H5。数据读取完成以后,肯定还需要把数据收回来,每个开发者和创业者建立自己的平台一定也有一个接收端。易观目前这个量级用的是Openresty(Lua),中间用Lua做了一些在SDK到上层相互交流的粗加工,目前是每天100亿条的数据在往上传,有时峰值可能还会更多。哪些能把有效的数据迅速采集过来,哪些数据能够迅速对客户端做出一些反馈,要通过Openresty、Lua做一个高效的返回机制放过来。直接进Kafka,图中使用了几个虚括号,因为现在使用的是混合云,主要混合了三个地方:一,通过公有云采集收数,因为在接收端的带宽是两倍,从这里做收数,通过一些光纤打通的方式打到线下,但是由于像光纤的方式如果万一出现问题,形成单点故障,还有一条互联网链路做保障。在收数端的Kafka收完后,还会在私有云有一个Kafka,两个做对接,在对接中间做了一个开源小工具,Kafka中间有一个Url的工具能够去对跑,但实际上这个工具是不靠谱的,特别是在数据量级比较大的时候,对跑会出现各种各样的企业问题,后来易观自己制作了一个小程序,为了保证中间传输上的稳定,做了一些压缩,可以实时传输过来,目前延时大约在5-10秒的范围,同时能够从线下收数到整个线下集群。

Kafka往上,易观和大多数大数据企业是类似的,一个是使用Hadoop/Hive,因为数量比较大,像MR把数量变小,变成ODS,其实是变成底层的基础数据,会在PDS做汇总层数据。再往上就是IDS,为了做产品体系查询。另一种是做Storm,Spark易观目前还没有完全做到自主优化,因为数据的量级非常大,每天大约100亿,数据在查询的时候,上面还有一个大数据查询,经过三个汇总以后,到这一层动辄也是千亿条的数据。举个例子,对于产品来讲,尤其是云端分析师,想看到上个月晚上9点到10点之间,标签是游戏玩家,淘宝资深购物人员,经常打开App的排行榜是什么,这个查询还是很容易的业务,但真正落成千亿条的数据查询却非常难,并且还希望做成一个比较好的查询,希望至少在分钟之内的范围,这个要求就非常难。这个查询如果在Hub里,一般是以小时来计,怎么能够放到产品里,把分钟级别的查询反馈过来?目前,在中间做了一个简单的查询引擎(目前是查询目录),根据企业的数据量级分到不同的查询引擎里解决相关问题,例如现在的GP,其实要求的是一个贵族开源的软件,好处是在千亿条大数据查询的时候非常稳定,兼容性也很好,但是对硬件的要求很高,不是每一个初创企业能有钱去做GP集群。Impala相对更加简单一些,要求硬件没有那么复杂,但时效性不如GP好。对一个企业内部,看上去整个集群大小有千亿条,但真正对于某一个App或对于某一个开发者来说,开发者要分层,发现有了这些大的头部应用,至少百亿。而小的开发者完全不用,目前很多还有日活不到1万的开发者,把它直接放到这查询就可以了。

数据调度资源也很重要,易观自己用的EMP,对资源做一些调度,能保证每天有内部分析师查询,在EMP里和Hadoop做了一些底层的接口对接,保证任务按时优先处理完。除此之外,内容数据量越来越多,数据越来越复杂,中间必须要有主数据管理、源数据管理,像数据地图等等一些相关工具。这些都包含在整个产品体系里。

几个技术难点

关于SDK,首先是不能丢数据。用户网络情况不太好的时候,在本地可能需要一个Cache,但是不能做无限大的Cache,用户就会把App卸掉,因为存了太多的无用数据,哪些数据要留存下来,哪些要做循环处理,都是需要注意的。

第二是如何不变成DDOS。把数据放在Cache,而且越来越多,服务接收能力还不强,会形成非常大的DDOS。这个时候就需要去控制。在SDK上传的时候要做防火墙,真正数据在传到云端时,如果App上传的频次过高本地要做屏蔽,如果一旦形成DDOS,就没有办法很快把App更新,基本上服务器这套机制全部就死掉了,在这个地方要有一个防火墙。上传数据不是单向,而是双向,把数据传上去的同时要有交互,要拿到云端的配置,特别是在中心云,能看到很多双向机器,当出现一些问题时,在云端是可控地把数据屏蔽掉,这样才能保证自己的数据安全,如果只是一个小开发者可能量比较大,但日活如果到千万以后,需要在这个地方做一个很好的交互,让云端的一些配置能够很快反馈到SDK,把数据上传和拐点机制能够做更新,保证不会形成DDOS,比如作为开发者来讲或其他部门把点埋错了,或者出现一些问题时,能控制好相关的数据。

此外,如何做到最小,如何将H5与APP互相调起,也是SDK需要注意的问题。

在接收端,需要注意的问题有:如何高并发接收数据,如何可以跨互联网传送高频大数据,如何可以做到极致实时。而关于用户画像,如何基于小数据算大量用户画像,如何计算用户标签,如何知道你用户的用户画像,是需要注意的问题。

关于实时大数据查询,如果面对的是上千亿条的数据,可以考虑模糊计算,先抽样,郭炜的建议是做分层抽样。第二是做预先计算,在不同的场景里,用到一些工具,把数据变成打横的,而不是打纵的据,这样能做到很多。郭炜在这里举的例子是转化漏斗。每一个用户的交易和点击是一张纵向的流水表,用户IP、事件、时间分点等,当量级变成千亿条,如何保证每次都能很快过滤出来,这是非常难的,对于这种情况,易观会在这种纵调做完以后打横,通过每一个事件(过去都是事件流水),从ID到时间,做完打横以后会变成用户ID、时间周期,每个事件会变成0和1。打横以后会把原来的查询变成并和交的查询,去关联化,最后再去做整个数据查询,速度会快很多,这也是大数据查询经常用的一种方法。

每一个不同的用户,数据来源和大小不太一样,当自建一个大平台时,每个业务部门的分析也是不一样的,究竟哪些业务部门真的需要用到这么复杂的GP和Impala,哪些是真的实时性要求高,但数量非常小?郭炜的建议是在每一个大数据,特别是真的数据做得很多以后,每个地方至少做一个数据扩容,最终才能够根据查询的情况选择适合自己的大数据工具做查询,有的东西用GP合适,哪怕简单写一些日常规则或者基于后期统计,把查询做起来,都非常有助于整个大数据查询平台的整体效率,从而实现高性价比的大平台策略。

易观简介

易观是中国互联网市场领先的大数据分析公司。自2000年成立以来,易观打造了以海量数字用户数据及专业大数据算法模型为核心的大数据与分析师服务生态体系,并致力于帮助所有拥有互联网产品及服务的企业,洞察自身的产品和用户,对标竞争和市场,并通过对数字用户资产的持续运营,实现增收,节支,提效和避险。

本文由郭炜于2016年8月,在WOT2016移动互联网技术峰会数据分析专场《如何巧用数据在移动创业的红海中突围》主题演讲整理而成。WOT2016大数据峰会将于2016年11月25-26日在北京粤财JW万豪酒店召开,届时,数十位大数据领域一线专家、数据技术先行者将齐聚现场,在围绕机器学习、实时计算、系统架构、NoSQL技术实践等前沿技术话题展开深度交流和沟通探讨的同时,分享大数据领域最新实践和最热门的行业应用。了解WOT2016大数据技术峰会更多信息,请登陆大会官网:http://wot.51cto.com/2016bigdata/

【51CTO原创稿件,合作站点转载请注明原文作者和出处为51CTO.com】