很多人都知道, iPhone3是iPhone撬动中国市场的核心。彼时的iPhone市场占有率还不足1%,而今天,中国手机市场似乎再没有谁能撼动苹果的地位。来自两个群体的强大力量推动了这种格局的形成,一是我们熟知的“年轻果粉”,另外一个更加重要的群体被称为“技术红颜”,iPhone的演进潮流与这个群体有极其密切的关系。

技术红颜引发的iPhone旋风

“技术红颜”是谁?从2009年开始,北京大学新媒体研究院副院长刘德寰与他的同事们开始了一项主题为“手机人”的研究。在定性研究的过程中,他们发现了一个极为特殊的小群体,这个群体小到往往不被注意。她们只占全部人口数量的0.67%,由年龄在35岁到45岁的职业女性组成。她们普遍学历高、收入高、职位高,喜欢追逐时尚潮流,怕落伍,买技术最全面最先进的手机,但却只使用其中10%的功能。这个群体被刘德寰等人称为“技术红颜”。

“技术红颜”带动了潮流的变化,引发苹果旋风,其影响力远远超过“年轻果粉”。因为她们将偏中年、偏成熟的女性引入时尚大潮当中,并形成了更大的族群,一种全新的经济模式被带动——“熟女经济”。无论是微博整移动化的发展,移动内容的付费、网购, 都不乏技术红颜的“兴风作浪”。

大数据时代已经到来,每个企业都开始忙着数据挖掘,忙着数据分析,忙着构建各种算法模型。但为什么你无法引发技术红颜式的蝴蝶效应?为什么你眼中对用户的“精准推荐”,成了Ta备感厌烦的“精准骚扰”?

日前在友盟主办的“全域大数据峰会”上,刘德寰院长一语中的:

“你没盯着我的人,老盯着我兜里的钱。我兜里又没多少钱还紧着盯,我不烦你烦谁。”

我们的用户推荐到底在哪儿出现了问题?

推荐算法困境

- 标签推荐的困境

目前最常见的推荐机制为“相似邻居推荐”,这是一种基于纯行为的标签推荐:当进行海量数据的收集和分析后,如果发现行为A、行为B总体共现次数多,系统就会向有行为A的人推荐B。比如在网购时,如果你的朋友喜欢,那么系统就会认为你也喜欢,就会把朋友买过的衣服推荐给你。

但其实,我们在日常生活中最讨厌的事情之一就是——撞衫!!

- 关系推荐的困境

再以微博推荐机制为例,其逻辑基本如下:

我与A非好友,但我的好友中有不少人与A是好友,即我和A有不少共同的好友,好么系统便会A也推荐给我(共同好友);我关注的人中有不少关注了B,那么系统推测我也可能会喜欢B,从而变会把B也推荐给我(间接关注人)。

但大多数时候,我们可能会这样觉得,“这位和我有毛关系?”

- 行为赋值的困境

再说说音乐分类分类,大家常常会进行这样的行为赋值:

“单曲循环=5,分享=4,收藏=3,主动播放=2,听完=1,跳过=-2,拉黑=-5”

这些分值分别代表什么意思?对行为量化到什么程度?你又真的清楚这些行为的原因吗?如果简单的认为将某个行为变成数值后就可以着手分析的话,面临的真正难题不是计算,而是如何明确地判断这些行为,并进行用户匹配。行为的背后到底是什么,需要精细的考量。

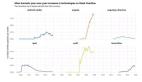

我们都知道这些机制有问题,那最好的解决办法是什么?——从用户真正关注的内容入手。应该通过增加对用户内容的搜索,寻找到用户与用户之间共同的兴趣、偏好和价值。比如分析用户在微博中发表、转发的内容,找到不同用户共同的关注点、兴趣点、价值观、生活方式,这才是真正有价值的实现路径。

看到这里,一定不乏愤世小青年发出咆哮:

“你的系统能实时全盘扫描海量用户的海量微博内容?知道这得多少台机器吗?千万台!

”U can U up.No can No BB!“

所以,我们只能退而求其次,选择这些看起来逻辑很清楚,实际上效率要弱得多的算法机制。但这背后的问题是,我们现在利用的数据绝大部分是稀疏的,算法经常停止于局部最优,结果极其不稳定,并存在大量的过度拟合,经常把噪音当成信号。最重要的是算法的构建绝对不是基于人性,而是基于商业。

真的没办法了吗?其实,无论是大数据还是小数据,运算的原则都是一致的。让我们来看看那些真正有效的运算原则。

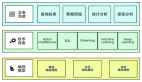

有效运算的七大原则

稳定性原则。运算精准的前提是稳定。面对不稳定的用户、不稳定的行为,不稳定的情感等干扰,必须要找到行之有效的办法去解决。

人性原则:人与物品的区别是人是有情感的,人有态度、人情绪、有对情境的考量、有动机……人的所有行为随着环境的变化瞬息万变。人性的不稳定,怎么能在大数据的运算当中呈现出来,这是一个问题。

数据全面性原则:数据全面是有效分析的基础,数据缺失多错误率一定高。现在数据分析当中面临最常见的问题是低价值数据稠密,高价值数据稀疏。我们的对象是人,定要基于人的逻辑考虑,产生人可以认识的分析结果。数据的维度应该基于人能力所及的范围,而非机器。

分类原则:做过调查的人都知道,做抽样的时候永远应该先分层。在分析用户之前,我们也一定要先分群。个体永远是复杂的,复杂性对复杂现象只能添乱。所以不要把人回归到个体的维度,而是放在群体里讨论。这是一个降维的过程,也降低了问题的复杂性。

变量多元指向原则:不要以为变量都只有一种展现方式,所以不要拿比例表做所谓用户画像。一个变量就是一个含义。以“代沟”为例,它的形成可能关乎年龄、学历、家庭生命周期、社会现象等等,一个变量是可以对应N个维度的。

变量复杂性原则:变量的呈现并不是简单的、分离的现象,而是混后、叠加、再分类后的行为组合。这非常类似于深度学习的层级。

效率原则:效率一定是和人的行为匹配的。如果在没有进行准确匹配的前提下进行推送,人们只会将大量的推送服务视为骚扰。

理论有了,实现路径在哪里?刘德寰提出两个假说。

有效大数据运算的两大路径假说

- 假说一:基于人,寻找“常人”和“常模”

数据运算的本质是找寻常人”稳定的人“,分析的本质是建构”常模“,常模建立之后才能对象于个人。

任何一个人的行为都没有规律,但是人的生活行为方式是都极其规律的。因此在进行数据运算时,对生活方式的探究价值要远远大于对行为打标签。生活方式对应的就是“常人”。

人的态度、行为、情绪、场景都是不同的,似乎找不到规律可言。但人是生活在群体当中的,群的行为是用户特征的综合,代表的是一种稳定的生活方式与态度,是可以感知和评判的,其变化是也有规律可循的。正确的做法是对某一个群体的行为分析来建立常模,要注意的是,这不同于数据挖掘算法中的”分类‘。这种分析这不是行为的叠加,是一种生活方式的展现, 一个人可以从属N个群。文章开头提到的“技术红颜”就是典型的例子。

- 假说二:基于物,寻找N维空间与人的认识能力

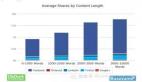

这个假说的前提是每个非人的事物都有一个确定的N维空间,而且N可以从人的认识能力角度定义。每一个不同的物品,N维空间不一定一样,但都是相似的,体现的只是数量的变化。

TESCO的运算逻辑是抽样实验+分析+大数据推送,随时实验,购物篮组合,它把每一个产品都用20个维度打标签,收集了海量的顾客数据,通过对每位顾客海量数据的分析,对每位顾客的使用程度和相关风险都有一个极为准确的评估。推荐这件事情就变得简单多了。

其实,运算当中可以融入社科的所有思想,现有很多程序员只关注自己的领域,对其它的行业一点不了解,您说说,做出的分析能靠谱吗?

大数据运算的逻辑本身是要反推人性。因此数据科学要将社会学、经济学、法学、政治学、传播学等所有学科已有的知识,稳定到计算当中。相信那种运算规则不仅效率高,而且简单。