| 本文转自51CTO博客博主通信,我的***,如有任何问题,请进入博主页面互动讨论。 |

朋友所在的单位中标了,一人前去目标地点实施,因为他对虚拟化、存储这一块不是很熟悉,所以让我跟他一起实施(做些远程支持)。

实施前准备:

由于朋友去的匆忙,并没有说清楚目标地点的环境,因此我让他准备一下:

1.确定一下是原有的数据中心云平台系统升级还是新装

2.确定一下设备以及相关配套设施是否就位

3.确定一下设备及关键配套设备的具体型号,是否已经上架

4.确定一下机房内网络电源等是否完备,如果完备的话提前联系好相关负责人,如果网络没有规划设计,则需要规划和设计网络

5.(可选)货物清单,项目合同等

经朋友询问,只知道服务器是6台Dell PowerEdge R720,1套Dell未知型号的15T存储和使用VMware vSphere虚拟化环境,设备以及配套设备基本就位了,还差一些存储的连接线,其他的只有到了现场才知道。虽然个人还是喜欢使用自己熟悉的Cisco UCS和EMC存储,但Dell的服务器设计也是可以的,服务器R720价格便宜,内存、IO等功能也比较完备,适合做企业级虚拟化。但不知道究竟是什么存储心里还是有些不踏实,存储这些东西真是做一次学习一次。因为此次实施是在外地,时间短,需要在短时间内就要完成,如果知道是什么型号才好下手,查手册查指南等,免得到时候手忙脚乱。

部分实施计划:

Day1.跑路去客户现场,电话预知项目大概情况,晚上去客户机房了解实际情况,做好相关记录

Day2.服务器、存储上架,上线上电,安装VMware vSphere ESXi,初始化配置存储

Day3.继续配置VMware vSphere环境,配置网络,配置HA,配置虚拟机

Day4.确认实施结果,跟客户说明实施情况和注意事项,跑路回来,跟公司报告实施情况,等待或提前做好下一步安排

部分实施细节:

经查,前面提到的未知型号存储是Dell PowerVault MD3800f(e04j)和Dell PowerVault MD1200(e03j)。经过查询Dell文档和VMware文档,这些服务器和软件之间都是兼容的,这样就令人放心,最起码在方案选型时,售前并没有吃干饭。

MD3800f是一个高速光纤通道存储,支持16 Gb FC和12 Gb SAS连接,支持12 Gb/s SAS技术,支持MD Storage Manager软件对存储进行配置管理和PowerVault VMware vCenter插件程序5.0,使用VMwarevCenter对存储进行配置管理。R720可以通过安装FCoE HBA卡与MD3800f进行直连(DAS),此处估计刻意减去了SAN FC交换机的成本。理想的情况是R720服务器安装两个HBA卡,分别连接到两台FC交换机,两台FC交换机再连接到存储的两个IO模块,但受限于没有 FC交换机,那只能将两块HBA卡直连到存储的两个IO模块,如果只有一块HBA卡,那只能连接存储上的一个IO模块了,具体使用哪种根据实际需要和实际情况使用。个人认为FC SAN的性能是优于IP SAN的,因为通常通过FC访问高性能数据库和生产服务器,通过存储局域网络NAS访问桌面存储等。

MD1200可以扩展MD3800f,通过SAS连接线将MD1200与MD3800f连接起来,扩充存储容量,最多支持192块硬盘,支持6 Gb/s SAS技术。

PowerVault 存储阵列可与PowerEdge服务器相配合还是不错的,PowerVault MD系列使用与PowerEdge服务器相同的磁盘驱动器,因此只需要购买一种备用驱动器、风扇或电源就行了。对于用户来说还是很人性化的,做虚拟化时可以把服务器上的硬盘尽可能的加到存储上,毕竟因为HA可靠性等原因,本地存储在VMware vSphere中一般不会使用。

搞定了存储的型号和解决方案的设计,就可以进行下一步了。由于Dell产品在保内是有原厂支持的,因此存储的配置交给Dell工程师就行了,这一块是朋友那边做的,我没有看到。最终的结果就是划分出两个LUN1和LUN2,供服务器使用。

6 台服务器做2个集群,每1个集群3台服务器,其中2台互为主备,1台standby。因为朋友单位购买的是VMware vSphere 5 Enterprise版本,此版本还是有很多限制的,比如vSphere Distributed Switch,令人不爽的是Cisco Nexcus 1000v也是不支持的,Cisco Nexcus 1000v要求必须有vSphere Enterprise Plus license,因此只能使用vSphere标准交换机。

每一台服务器是有4个网卡的,从0-3,0和1划分到vSwitch0,用于管理网络(Management Network)和VMkernel使用,用于管理和连接存储,其上行链路接交换机的Vlan access端口,2和3绑定到vSwitch1,作为虚拟机网络,其上行链路接交换机的Trunk access端口,这样虚拟机可以使用不同的VLAN来隔离网络。

将存储划分给vSphere Cluster(集群),LUN1给Cluster1,LUN2给Cluster2,之所以这么做,是因为朋友那边说主机上只有一个HBA卡,所以一个HBA卡只能连接一个存储IO接口,我也是没办法。

接下来的工作就由朋友一人独立完成了,我的工作也到此结束。

补充知识:

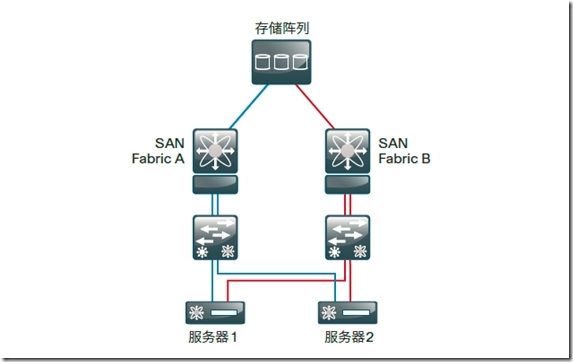

借助FC,服务器能通过光纤网络、数据中心甚或广域网与存储相连。多台服务器能够共享一个存储阵列。在SAN中,阵列(fabric)由与FC交换机相连的服务器和存储组成,如下图所示。SAN中的标准做法是,创建两个完全独立的物理阵列,提供两条与存储相连的不同路径。每个阵列上的FC阵列服务都独立运行,以便当服务器需要永续连接到一个存储阵列时,它与两个独立阵列相连。这种设计能够防止一个阵列中的故障或误配置影响另一个阵列。

补充知识来自以下参考:

Cisco IBA智能业务平台--数据中心设计概览.pdf http://www.cisco.com/web/CN/solutions/industry/segment_sol/enterprise/programs_for_large_enterprise/pdf/dc/Cisco_SBA_DC_DataCenterDesignOverview-Aug2012_CHN.pdf

Cisco IBA智能业务平台上的文档还是非常详细的,大家如果以后做类似项目时可以多参考一下,从数据中心到统一通信应有尽有。

Tag:云平台项目实施,VMware虚拟化实践,Cisco IBA智能业务平台,磁盘阵列,高速光纤通道存储