LinkedIn有个三人小组出来创业了—正是当时开发出Apache Kafka实时信息列队技术的团队成员,基于这项技术Jay Kreps带头创立了新公司Confluent,致力于为各行各业的公司提供实时数处理服务解决方案,其他两位成员是Neha Narkhede和Jun Rao。该公司已获Benchmark、LinkedIn、Data Collective 690万美金融资。

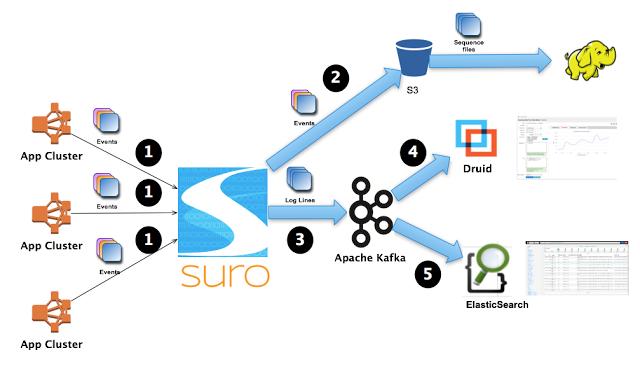

Kreps将Kafka描述为LinkedIn的“中枢神经系统”,管理从各个应用程序汇聚到此的信息流,这些数据经过处理后再被分发到各处。

不同于传统的企业信息列队系统,Kafka是以近乎实时的方式处理流经一个公司的所有数据,目前已经为LinkedIn, Netflix, Uber和Verizon建立了实时信息处理平台。Confluent的愿景便是让其他公司也能用上这种平台。Confluent已经向Kafka用户了解了他们的使用模型。现在还没有产品出来,但这些实践足以启示Confluent应当打造何种产品。

Kreps承认,他最初也怀疑那些非网络公司是否会对Kafka这样的技术感兴趣,但当他看到金融服务和电信行业对这项技术的广泛采用后,Kreps改变了自己的看法。今年三月,去拜访了一家叫做Synapse Wireless的公司,这家公司使用Kafka来支持一套传感器网络系统,用于追踪医院工作人员的卫生习惯。

因此他认为需求是绝对存在的,Confluent的优势就在于近乎实时性。Kreps认为,基于Kafka信息处理技术建立一家公司,总比基于像Apache Storm这样的开源流处理技术建立一家公司要靠谱,因为信息列队是先进数据处理架构的更基本的组成部分。

他还记得刚加入LinkedIn那会儿,网站只有批处理系统,后来有了流处理系统后每个人都别提多开心了。再后来,他们意识到LinkedIn并没有支持这一系统的架构。

“当今大多数公司之所以与佼佼者存在差距,是因为他们几乎不能实时任何获取数据。”一旦公司找到最对路的技术堆栈,它们就有望建立物联网或者其它基于传感器的应用程序,再或者是从许多渠道抓取大量数据进入后端系统的其他业务。

“这实际上是开辟了全新的应用场景,”Kreps说道,“而且是不这么办就没法真正打开的场景。”