业界对“大数据”这一概念的质疑声从来就没有停止过,很多人认为它只是一个过度炒作的营销泡沫。确实,单就数据的体量而言,大多数企业并没有Google, Facebook那样的PB级数据。 那么, 大数据究竟有没有意义呢? 数据分析专家Tom Anderson最近给出了一个概念叫“中数据”,根据他的划分, 数据集数据量在10万以下的称为“小数据”, 数据集在1000万以上的称为“大数据”,而在二者之间的称为“中”数据。 Tom Anderson认为, 企业进行数据分析的投资收益率在“中”数据范围内是最高的。 以下是IT经理网编译Tom Anderson的博文:

在我参加了这个星期的美国营销协会的第一届大数据的研讨会后,我更加坚信了我这几年与许多财富1000强企业的营销人员沟通后的一个看法。 那就是:

很少有公司能够分析到所谓“大”数据的量级,而事实上它们也并不需要。 其实, 大部分公司应该开始考虑如何从“中”数据开始。

大数据,大数据, 大数据, 人们到处在谈它, 其实我发现, 真正处理“大”数据的研究者其实很少。 我认为我们应该把“大数据”的概念范围缩小。 引入一个新的更有意义的名词:“中”数据来描述我们目前的大数据热潮。

要了解什么是“中”数据,进而理解大数据, 我们得先知道什么是“小”数据。

“小数据”

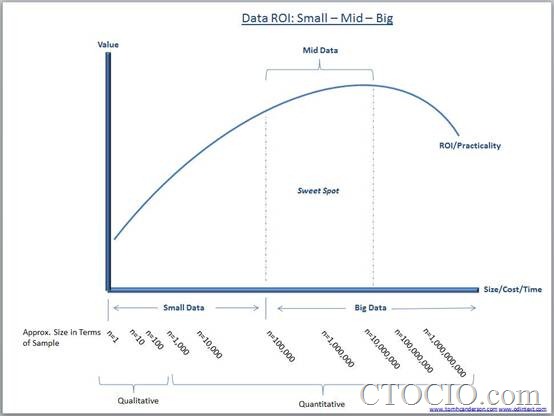

上面的图简单地按照数据记录的规模或者说样本的规模对数据的“大”“中”“小”进行了划分

小数据可以包括从定性研究的某个访谈到几千个调查问卷的结果。在这个规模上, 定性分析和定量分析可以从技术上结合起来。 而这两者都不能称之为现在定义的“大数据”。 目前对大数据的定义随着企业对数据的处理水平的不同而不同。通常的的大数据定义指的是用现有普通软件很难分析的数据量。

而这个定义是从IT或者软件提供商的角度来说的。 它描述了企业无法利用现有能力, 必须进行大量硬件软件升级进行有价值的数据分析的情况。

中数据

那么,什么是中数据呢? 进入大数据时代, 有些我们认为是小数据的数据集可能会迅速成长为大数据。 比如 3万到5万条用户满意度调查记录可以用类似IBM的SPSS软件分析。 可是, 如果把这些数据集中加入了用户的评论这样的文本数据, 同样的分析可能就会变得缓慢了。 这同样的数据集现在需要更长的时间来分析,甚至可能导致分析软件崩溃。

如果我们把同样的文本数据用文本挖掘的方式处理的话,新加入数据集的数据将会极大地增加数据量。 这常常就会被认为是大数据, 需要更加强大的软件来处理它。 不过, 我认为, 一个更准确的描述应该是“中”数据, 它其实只是真正大数据的起步阶段(这与IT经理网之前的文章“大数据需大处着眼,小处着手”中的观点不谋而合)。而且对于这个规模的数据量, 其实还是有很多简单的处理手段的。

大数据

好了,我们把大数据的一部分切出来叫做“中”数据。 现在, 我们可以重新定义“大”数据了。

为了理解“大”数据与“中”数据的区别, 我们需要考虑一些不同的维度。 Gartner的分析师Doug Laney曾经对大数据有一个著名的描述, 把大数据分为3个维度:规模(Volume), 种类(Variety)和 速度(Velocity), 通常叫做3V模型。

在理解“中”数据与“大”数据的区别时, 我们只需要考虑两个因素, 成本与价值。

成本(以时间计量或者按照金钱计量)与期望价值构成了所谓的投资收益率(ROI)。 这也可以应用于大数据项目的可行性研究。

我们知道, 有些数据天然的比其他数据具有更高的价值。 (100个客户投诉邮件可能比1000个微博上提到你的产品比起来, 对你的运营分析更有价值。) 当然, 有一点是肯定的: 没有经过分析的数据是没有价值的。

相对于“中”数据来说, “大”数据或者说“真正的大”数据量的分界点在于, 对于分析进行的投入, 相对成本(包括可能从中发现不了什么的风险)来说,并不具有吸引力。 比“中”数据更大的数据量来说, 大数据分析要么并不现实, 要么对企业来说ROI太低。

而“中”数据则是正好在数据分析的最佳范围内, 可以在相对可控的预算前提下进行有价值的分析。

对于很多市场研究人员来说, “中”数据才是一个真正能够提供有价值, 有足够ROI的分析目标。 而真正“大”数据分析, 则会呈现递减的ROI。

在最近我去德国的一次出差中, 我有幸遇到了一位在欧洲核子研究中心从事大型对撞机项目的科学家。 相对于大型核子对撞机来说, 普通的商业企业不需要像那样的软件和硬件来进行那个规模的大数据分析。 对撞机的1亿5千万个传感器每秒钟产生4000万条数据。 而实际上, 即使是欧洲核子研究中心的科学家们, 也不会去分析如此打规模的数据量。 他们在分析前过滤掉来99.999%的粒子对撞数据!

对我们普通企业来说, 对消费者的分析相对简单得多。 对于数据或者文本挖掘, 我们不需要EB或者PB级别的处理能力或者在数以千计的服务器上跑大型并发软件, 目前其实有一些很好的软件能够处理我们一般企业的“中”数据需求。 一提到大数据, 媒体常常提到的是亚马逊, 谷歌或者Facebook。 就算是这些案例中(很多 听上去更像是IT销售鼓吹的科幻小说), 也并没有提到这些公司在数据分析中实际使用的样本的量。

就像欧洲核子研究中心的科学家发现的那样, 相对一股脑处理全部数据的做法, 更重要的是能够正确的分析对研究相关的那部分重要数据。

那么, 读者可能会问“既然‘中’数据比‘大’数据更加具有吸引力, 为什么我们分析‘小’数据不是更好吗?”

这里的关键是, 随着数据量的增加, 我们不但可以对分析结果更加具有信心, 而且可能会发现一些传统的“小”数据所不能发现的现象。 对市场分析来说, 这可能意味着发现了一个新的细分产品市场或者竞争对手的新动向, 对药物研究来说, 可能意味着发现一些小的人群细分与某些癌症的高风险关联 (参考本站文章: 大数据“显影”:Ayasdi用拓扑数据分析癌症 )从而拯救生命。

“中”数据应该被更加明确的定义, 而且也需要更多的最佳实践。 不幸的是, 经常有一些企业的CEO或者CIO会要求IT人员“采集所有的数据, 全面分析数据”。 这样的过程, 他们其实在制造真正的“大”数据, 这种数据量常常是超过需要的。 这就产生了我一直在提的ROI的问题。 追求真正的“大”数据常常不能给你带来任何优势。 经验丰富的“小”数据或者“中”数据的分析人员知道, 对于“大”数据的分析常常是没有满意结果的。 而相对投入的成本来说, 从ROI的角度是不值得的。

因此, 对于“大”数据分析而言, “中”数据才应该是我们真正需要瞄准的目标。

原文链接:http://www.ctocio.com/hotnews/11715.html

【编辑推荐】