尽管距离Facebook公开其数据中心设计蓝图已经过去了一年半,但Google公布的数据中心设计还是值得研究。不可否认,Google和亚马逊依然是地球上拥有***进的数据中心的两个公司,包括Facebook服务器实验室系统工程经理Amir Michael、Prineville数据中心总经理Ken Patchett在内的许多工程师都来自Google。上个月,我们***次了解到Google数据中心内部的景象,不过这些照片并不是Google***进的数据中心,其中所包含的信息量也相当有限。同样的,Google公布的自己数据中心的文档更像是一次炫耀,大篇幅的展示了极低的PUE,而对设计细节忽略不提。尽管如此,我们还可以从其中发现有价值的信息。好,让我们开始。

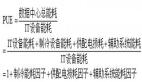

图:Goole芬兰哈米纳港数据中心量化和提升能源的使用

当面临互联网应用服务器爆炸式增长的局面,我们将精力放在如何减少能源使用上。大多数数据中心就像给服务器供电一样,给非计算用设备无限制的供电(即日常管理、制冷等)。在Google,我们将传统数据中心的制冷用电比例降低到13%。这样,大部分的电能用于服务器,这些服务器将为搜索及其它产品提供支持。我们对用电量进行测量,不断的朝目标行进——提供更多服务,减少电量浪费。

如何降低PUE——Google的5点建议

不管你运营的是小型数据中心还是大型的数据中心,你都可以采用一些简单的设计来提升效率,降低成本并减少对环境的影响。

1、测量PUE

没有测量就没有管理,采用更综合的方法测量PUE。

我们的计算基于Google在全球所有的数据中心的性能,不仅仅是我们***的或***的数据中心。同时,统计数据贯穿全年,并不仅统计凉爽的季节。

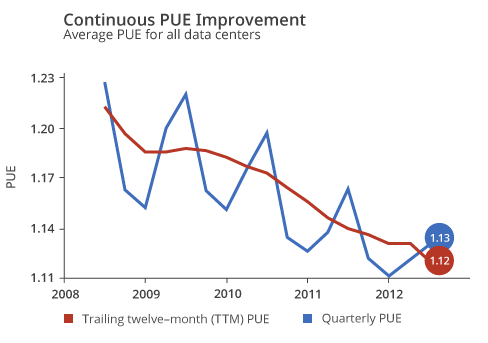

不仅如此,我们还将所有的日常产生的耗能全部进算在其中。当然,只要采用更宽松的Green Grid v2标准(Green Grid's PUE measurement standards。Green Grid是一个非盈利的企业团队,成员包括 AMD、APC、Cisco、Dell、Emerson、Fujitsu、Fujitsu Siemens、HP、IBM、Intel、微软和Sun等供应商以及ADP、Allstate、BT、Enterprise、Facebook和Fed Ex Services等用户。),就可以得出更低PUE值。事实上,如果使用业界通常的解释,我们效率***的数据中心可以不夸张的达到PUE 1.06。然而,我们坚持使用更高的标准,因为我们相信这可以有助于更好的统计和优化我们的用电。总之,我们公布的综合PUE为1.13,覆盖全球所有的数据中心,并贯穿全年,以及所有的日常用电。

图:Google数据中心PUE统计边界。平均PUE为1.13,如果忽略变电站、电源转换以及发电设备,PUE将降低到1.06。

Google数据中心PUE统计

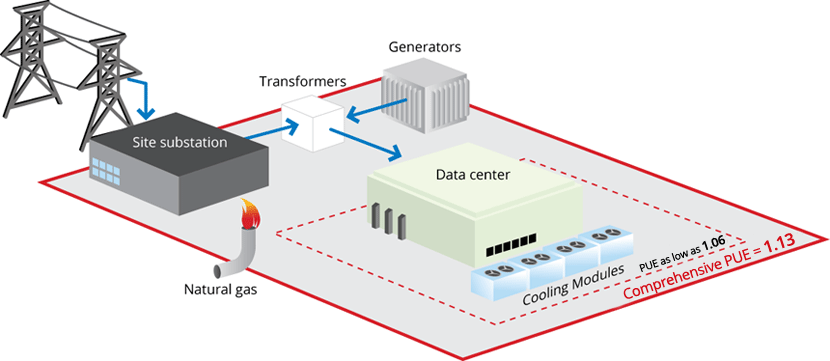

自从2008年开始公开PUE后,每年我们都不断的降低PUE。截至到2012年第二季度,过去12个月的加权平均值(TTM)PUE达到了1.13,这是全球效率***的数据中心。

图:Google自2008年以来的PUE统计

图:Google数据中心PUE计算取值含义

这里是从2008年到现在的Google数据中心PUE统计,如果想了解Google数据中心PUE的计算公式,可以在这里找到。 #p#

2、管理气流

气流管理对数据中心运营十分重要。通过恰当的设计尽量减少热空气和冷空气混合。然后,确保热空气被密封。我们发现一些很小的分析工具能带来巨大的回报。比如,通过电脑流体力学(CFD)建立气流模型可以帮助你快速的描绘和优化气流,这样你就不用对电脑房大规模重组。

控制设备的温度

为了在持续节能的前提下保持设备***状态,温度管理、气流管理以及设备管理尽量保持简单,提高成本效益比。

将恒温器设定提高到80华氏度(约等于26.7摄氏度)

让数据中心节能最简单的办法就是提高温度,根据专家的建议以及设备制造商的说明,数据中心可以在80华氏度以上安全的运行。

建立热力模型

我们使用热力模型来定位“热点”,并能更好的理解气流的运行。在数据中心设计阶段,通过物理组合的方式让设备温度更加平均。在这之后,我可以移动计算机机房空调来减少热点,并降低其周边的温度,最终减少空调必须运行的时间。

我们找到低成本的方式管理气流

为了减少制冷成本,我们要防止机架后端排到热管的热空气与机架前端环境的冷空气混合。在我们那些巨大的数据中心里,我们使用了适当的导管和附属设备。此外,在较小的数据中心中,我们采用适当简单的散热方式。请看实例:

使用空的面板(或者平坦材料)封闭机架上空闲的机位,防止热空气渗入冷空气。

悬挂塑料窗帘(与在冰箱中使用的材质相似)防止冷空气跑掉。

将高温的部件或区域(如供电单元)用塑料窗帘密封起来 #p#

3、调整恒温器

让数据中心保持在70华氏度(约等于21.1摄氏度)简直是生活在童话中。事实上,所有的设备制造商都允许你将通道温度提升到80华氏度或更高。如果让你的数据中心效率更高(我们强烈推荐),让它运行在更高的温度就能在更多天里实现“免费制冷”(通过室外的自然空气进行制冷)并节约更多的电能。

4、使用免费的制冷

通常冷水机组都会用在数据中心的制冷设备中,你可以发现这就是节省电能的巨大机会。利用“免费制冷”消除高温就能避免使用冷水机组。这包括使用周边低温的空气、蒸发器以及巨大的热容设备。当然,有许多方法让你使用“免费制冷”,水和空气都被证明可以使用的资源。

用水替代冷水机组

电力在数据中心中最终会转换成热量。大部分数据中心使用冷水机组或空调进行降温,这将占到日常用电中的30-70%。在Google数据中心,我们经常使用水这种高能效的方式来代替。

使用水来围堵热空气以及对设备降温

我们为机架设计并定制了制冷系统,我们叫它“热屋”(Hot Huts),因为它用作容纳从服务器排出的热空气的临时房间,房间与数据中心其余地板是隔离的。每个热屋的顶部都装有风扇,将服务器排出的热空气吸入水冷器。冷却后的空气离开热屋回到数据中心的环境中,服务器可以将这些冷空气抽入帮助降温,空气完成了一个循环。

利用蒸发器制冷

蒸发是非常强大的工具。在我们人体上,当外界温度高过身体的温度时,蒸发可以帮助我们保持体温。我们的冷却塔和人体出汗的工作原理如出一辙。热水从数据中心输送到冷却塔,水从上到下流过快速蒸发器,一部分水转变成水蒸气。风扇将这些水蒸气向上推动,这一过程将带走剩余的热量,然后将变冷的水输送回数据中心。

利用海水进行自然冷却

蒸发水并不是唯一的免费冷却方式。我们在芬兰哈米纳港的数据中心使用海水降温,没有使用冷却装置。数据中心地处芬兰湾,气候寒冷。冷却系统将寒冷的海水输送到数据中心,热量通过交换器传送给海水,海水最终流回海湾。通过这种方法,可以给我们提供全年的冷却,而根本不需要任何冷却装置。

节约并循环用水

为了更节约用水,我们在两个数据中心实现了100%循环用水,并在1/3的数据中心中通过收集雨水进行制冷。这个方法很简单,替代用于冷却的饮用水,而使用不能饮用的水源,通过清洁就可以用于冷却了。

我们通过各种方式使用循环水。在道格拉斯数据中心我们利用城市废水,在比利时数据中使用工业废水,通过盛有干净沙子的巨大的水槽过滤水中的微小粒子,水会变得干净(尽管并不适合饮用)。不过,循环用水的方式并不总是很划算,我们对找到合适的方法来支撑大部分循环用水还是持乐观态度。 #p#

5、优化电源布局

你可以通过减少电流转换的次数来减少分布式电源带来的电能损耗。你必须进行电流转换,但要确保使用特定的转换设备和分布式电源单元(PDU)。数据中心中分布式电源***的能量损失之一来自不间断电源(UPS),所以选择高效率的UPS十分重要。***,尽量让高电压接近电源,这可以减少能量损失。

定制高效的服务器

Google的服务器始终保持着高效率,它是我们数据中心的核心,并且经过了极端节能设计,通过最小化电能损失以及移除不必要的组件来实现。

优化电源路径

一个典型的服务器最多将浪费1/3的电能,只有电能用于服务器的计算才能发挥真正的价值。服务器浪费的大部分电能是在电源部分,电源需要将标准的交流电转换成低电压的直流电。这一过程将损失大量电能,同时芯片也将完成进一步电源转换工作。这种设计可以降低初始成本,但最终将在电力转换的过程中花费大量的成本。

Google的服务器则不同。从2001年开始,我们一直在改进设计不断提高效率。多年之后,我们的供电效率已经超过了“气候保护计算倡议组织”的“金牌”标准(Climate Saver Computing Initiative,简称CSCI),事实上,我们与“气候保护计算倡议组织”、Intel以及世界自然基金会(WWF)共同努力提升工业电源效率。同时,我们使用了更高效率的调压模块,确保更多的电能输送到各个组件。我们在机架后放置电池直接向服务器供电,这样就可以省去两次交流/直流变换过程。我们估算,一台服务器一年时间就可以节省500kWh,相当于典型的服务器能耗的25%。

定制自己的服务器 只保留必须的组件

对于硬件,我们只保留那些对我们的应用有帮助的部分。我们去掉那些外围的部件和显卡。我们还优化服务器和机架以适应最小功率的风扇,在保持服务器冷却的前提下,尽量降低风扇的转速。

我们鼓励所有的供应商去除那些闲置的组件,这里是2007年发布的“能源比例”文档。

关于Google数据中心的相关信息

图:数据中心传统的冷却方式是通过高出地面的计算机机房空调(CRAC)制造冷空气

图:Google上个月公布的数据中心的照片,在风道内有输送冷水的水管,这是自2006年以来的第5次升级。

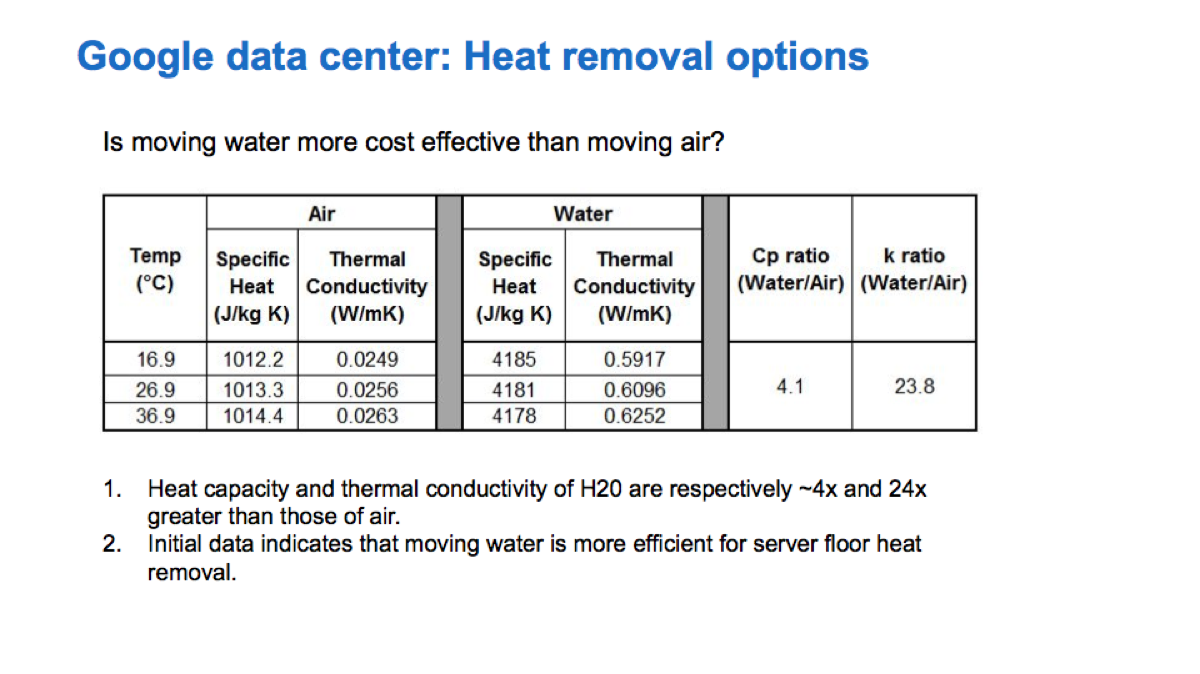

图:Google对风冷和水冷方式进行了评估,水冷的热容积和热传导性分别是风冷的4.1倍和23.8倍。

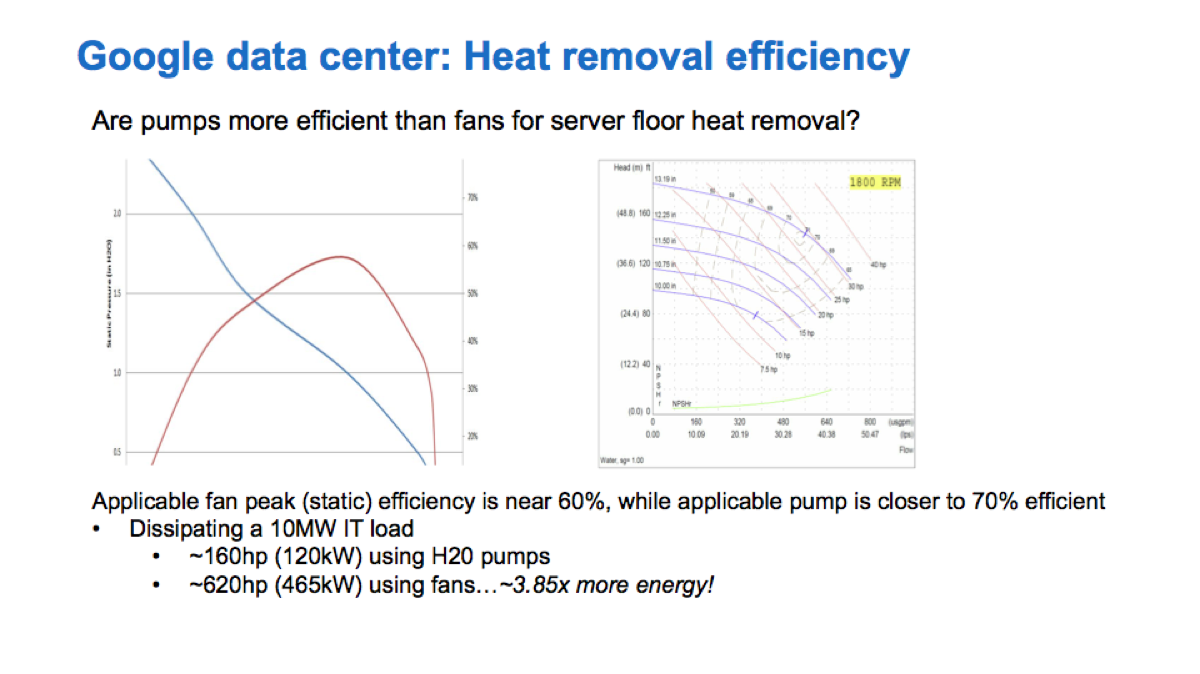

图:Google模拟了100MW的IT负载,风冷所消耗的电能是水冷的4.875倍。

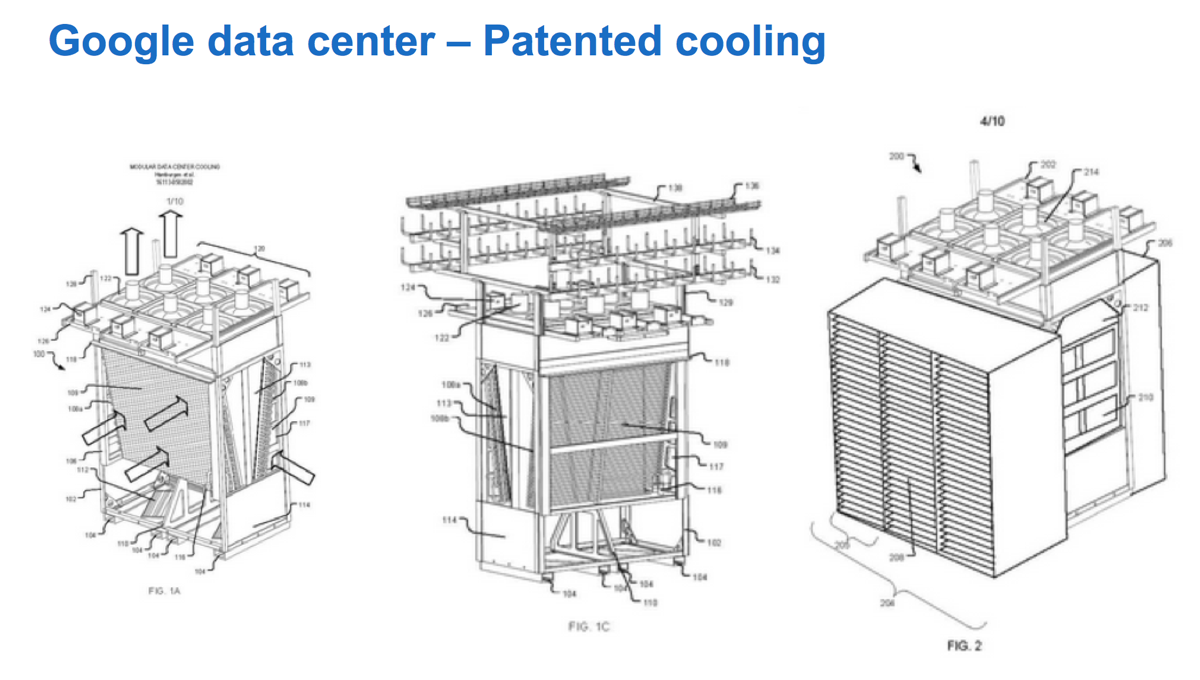

图:Google展示了制冷设计专利

写在***

“每一个Google员工都需要签署一份保密协议,而这在Facebook根本不需要。”这是Facebook Prineville数据中心总经理Ken Patchett在接受Wired记者采访是透露的。即便现在,Google对数据中心的保密等级并没有因为公开一些无足轻重的照片而降低。除了图片、描述笼统的文字和YouTube上有限的介绍影片,Google数据中心更多的秘密还需要时间来揭晓。