虚拟化技术由于其在提高基础设施可靠性和提升资源利用效率等方面的巨大优势,应用越来越广泛。同时,虚拟化技术本身也在快速发展,虚拟网络接入领域,802.1Qbg、802.1Qbh等标准相继推出,虚拟服务器高可用方面,HA、FT、DRS、DPS、vMotion等技术也在不断演进。相应的虚拟化管理技术必须同步发展,才能解决虚拟化带来的需求。

一、虚拟化的技术和管理需求

1.主流的服务器虚拟化技术简介

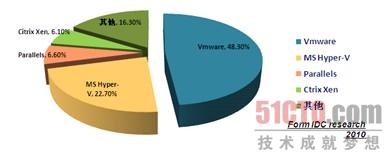

在数据中心服务器领域,虚拟化技术目前仍处于快速发展的阶段,IDC统计数据表明,VMware和Hyper-V处于领导者地位。KVM阵营由于Redhat的加入,将成为第三支最有力量的参与者(如图1所示)。

图1 虚拟化产品市场份额

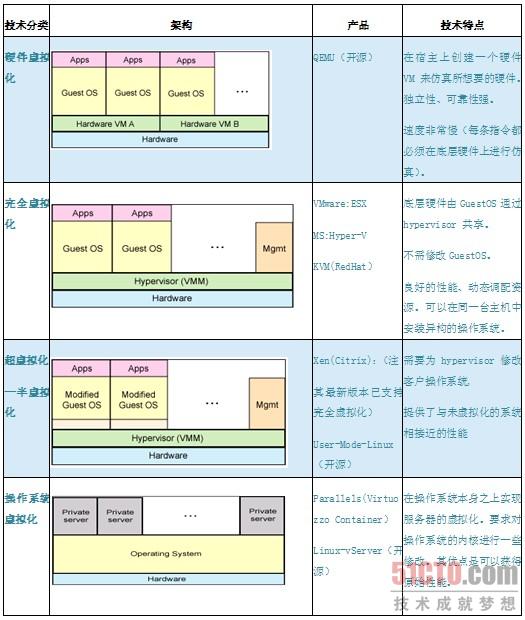

从技术发展方向来看,服务器虚拟化的有四种分类(如表1所示),其中完全虚拟化技术是目前使用最为普遍的技术,VMware、Hyper-V、KVM、XEN等产品均已支持该技术。

表1 虚拟化技术分类

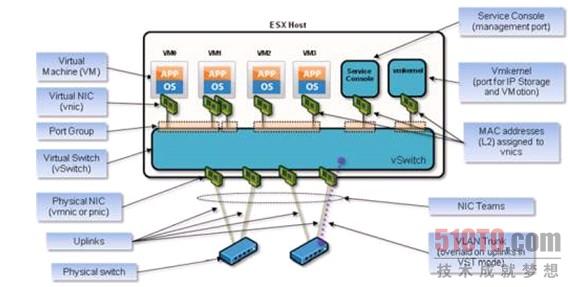

2.虚拟化对管理的影响因素之一:vSwitch

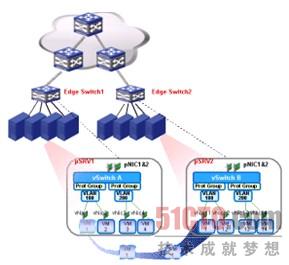

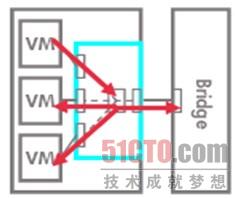

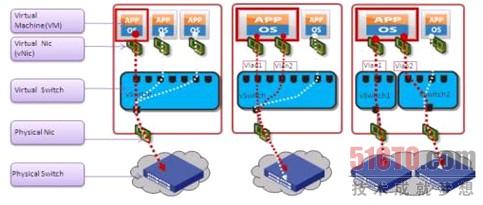

服务器虚拟化引入了虚拟网络交换机(vSwitch)的概念,如图2所示,使用虚拟化软件技术仿真出来的二层交换机,位于物理服务器中。vSwitch创建虚拟的网络接口(vNIC)链接VM,并使用物理网卡连接外部的物理交换机。

图2 vSwtich结构

vSwitch的出现,对传统的网络管理方式产生了巨大的影响,主要体现在以下几点。

1)从网络管理的范围来看,不仅要覆盖物理网络设备(交换机、路由器、防火墙等),还要延伸到服务器内的网络交换功能,因此需要有不同于SNMP/CLI等传统的管理手段来管理实现对vSwitch的管理。

2)从网络的可视性来看,由于虚拟服务器和物理网络之间多了一层vSwitch,使得传统的基于网络设备的网络可视化管理手段失效(比如流量无法全部感知影响流量分析管理、终端接入无法感知影响网络拓扑分析)

3)从网络的可控性来看,由于一个物理网络接口下面将连接一个复杂的网络结构,接入层的管控能力从原来针对一个终端扩展成针对一个网络(包含多个VM终端),需要有手段区分每个VM终端来达到接入层的控制(而不仅仅是区分接入接口,因为接入接口下移到服务器内部的vSwitch上了)。

3.虚拟化对管理的影响因素之二:迁移

为提供VM系统的可靠性,服务器虚拟化技术提供了VM迁移、高可用性(HA)、热备容错、资源池调度等特性,这些特性都会影响VM的物理部署位置,不仅使虚拟服务器在数据中心网络中的物理位置的可视性变得困难,并且使得服务器接入物理网络设备需要一定的网络资源配置,其接入位置的动态性就要求物理网络配置能提供随需而动的管理能力。

以下以VMware举例,介绍这几种特性及对网络管理的影响和需求。

1)VM迁移-vMotion

vMotion有几种实现,目前对VM服务中断影响最小、迁移性能最佳的实现方式是在线迁移(Live Migration),如图3所示。一般物理机之间要采用SAN或NAS之类的集中式共享外存设备,同时考虑操作系统内存执行状态的迁移[注:主流的内存迁移技术是预拷贝技术,通过多个轮次的增量拷贝,直至内存不再更新。不在此详述],停机时间非常短暂。

图3 vMtoion示意图

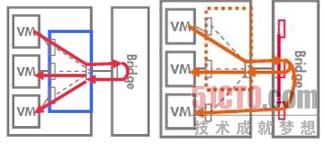

2)高可用性HA

有两种HA模式:1)物理服务器故障,可在具有备用容量的其他生产服务器中自动重新启动受影响的所有虚拟机(如图4左所示);2)VM操作系统出现故障,HA 会在同一台物理服务器重启启动受影响的虚拟机(如图4右所示)。

图4 HA场景示意图

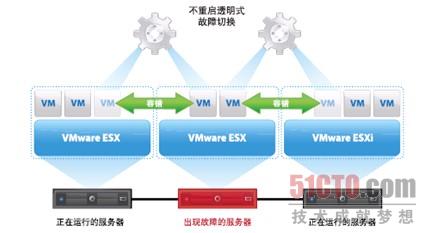

3)热备容错(Fault Tolerance):

如图5所示,原始实例创建一个在另一台物理服务器上运行的实时影子,VM故障时可不重启完成切换,防止由硬件故障导致的应用程序中断,相当于热备份。

图5 FT场景示意图

4)动态资源调度:

基于预先设定的规则,跨资源池动态平衡计算、分配资源。如图6所示,管理员可以将Exchange server和Apache Server移动到其他物理服务器,使SAP系统得到更多的空闲资源。

图6 动态资源调度示意图

4.迁移对网络管理的影响和需求分析

在上述场景中,VM位置都发生了改变,VM能否正常运行,不仅需要在服务器上的资源合理调度,网络连接的合理调度也是必须的。

图7 VM、网络迁移示意图

如图7所示,如果把虚拟机VM1从物理服务器pSrv1迁移到物理服务器pSrv2上,其网络连接从原来的由pSRV1上虚拟交换机vSwitchA的某个VSI(属于VLAN100的端口组)接入到边缘物理交换机Edge Switch1,变成由pSRV2上vSwitchB的某个VSI接入到Edge SwitchB。若迁移后对应的Edge Switch的网络配置不合适,则VM1迁移后就可能不能正常使用。比如原先对VM1的访问设置了ACL,以屏蔽非法访问;或设置了QoS,以保障VM1上业务运行带宽等服务质量。都需要在发生VM创建或vMotion时同步调整相关的网络连接配置。并且,为了保证VM的业务连续性,除了虚拟化软件能保证VM在服务器上的快速迁移,相应的网络连接配置迁移也需要实时完成,即网络需要具有"随需而动"的自动化能力,这也就需要利用虚拟化软件提供管理API。目前主要的API技术有如下几种。

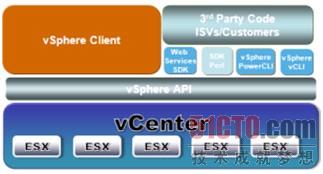

1)VMware ESX/ESXi的管理API

VMware对外提供的管理接口主要是vShpere API(如图8所示),管理系统可通过调用API接口对VMware进行管理。

图8 VMware管理接口

2)Hyper-V的管理API

微软的Hyper-V提供了类似VMware vCenter的集中管理产品SCVMM(System Center Virtual Machine Manager),并可以提供WMI和powerShell形式的API接口管理能力。

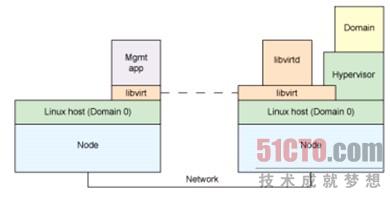

3)通用的虚拟化API

为解决虚拟化产品管理的兼容性问题,业界出现了针对虚拟化的通用API技术,典型的是Libvert技术(如图9所示)。注:Libvert目前支持KVM、Xen、VMware等主流虚拟化产品。

图9 Libvert技术架构#p#

二、虚拟化趋势下的可视性管理

服务器虚拟化后,虚拟服务器规模剧增,以及虚拟化软件的迁移特性使虚拟服务器在数据中心网络中的物理位置的可视性变得困难。当业务系统异常时,需要从服务器、网络各方面进行分析诊断,对网络管理员来讲,需要清楚虚拟服务器VM位于哪个物理服务器、通过哪个物理网络交换机接口接入网络,甚至需要了解vSwitch上的网络配置(比如VLAN),特别是服务器和网络的边界链接的可视性。如果对这些信息无法可视化管理,就无法有效的分析和定位故障。

因此需要使用服务器虚拟化管理技术将虚拟化网络相关信息纳入到统一的资源可视化管理中。

1.虚拟资源视图

通过虚拟资源视图,可以查看物理服务器、虚拟交换机、VM的资源从属关系信息。同时在虚拟交换机管理视图中,其提供了服务器中虚拟网络的配置能力(端口数量、端口组、VLAN、和物理网卡的绑定关系等)。在虚拟机的管理视图中,可以提供分配的计算资源、GuestOS信息的可视性等功能。

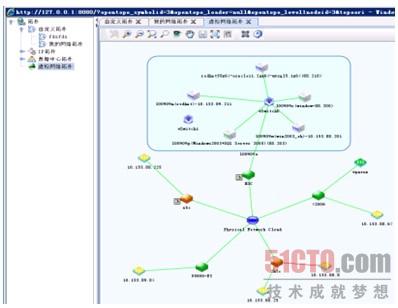

2.虚拟网络拓扑

拓扑是最为直观的管理方式,通常的网络拓扑由于没有计算虚拟化相关数据,无法得到各个虚拟服务器VM和物理服务器、vSwitch的从属和链接关系,各个VM是零落到整个拓扑、不同网段中的独立节点,而且VM的数量远远大于物理服务器的数量,最终出现的是一个大量、杂乱、无关的拓扑。

通过虚拟网络拓扑可以解决这个问题,管理系统在拓扑计算中使用虚拟网络的拓扑数据,提供清晰简洁的物理拓扑,所有虚拟节点都聚合到物理服务器节点上;同时又能体现物理服务器内部的虚拟世界。如图10所示,可以看到展示物理服务器(ESX)、虚拟交换机(vSwitch)、虚拟机(VM)之间的从属或连接关系。同时,通过ESX和物理交换机之间的连接关系,可展示ESX所在的物理位置。

图10 虚拟网络拓扑实例

三、虚拟化趋势下的流量可视性管理

数据中心中不仅仅存在着外部对数据中心应用的访问流量,在数据中心内部应用之间反而存在着更为大量的数据交换,掌握这部分流量的分布以及对网络的需求,对保障其业务的正常运行有更大的意义。而当业务大量部署在虚拟服务器上时,如何感知虚拟服务器之间的流量就变得非常重要。

1.从网络侧分析虚拟化流量的可视性

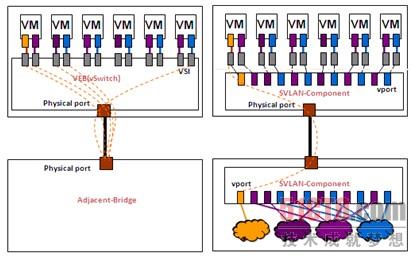

对于传统虚拟化技术中的VEB vSwitch模式,虚拟机VM之间的相互流量直接在vSwitch上交换,网络是无法感知的(如图11所示)。因此通过传统的网流分析手段分析流量比较困难。

图11 VEB模式流量模型

目前正在形成标准的VEPA(802.1Qbg)方案中,VM间的流量必须通过外部网桥进行交换(如图12所示),网络具有完全的流量可视性,只要网流分析管理软件能够将触角延伸到VEPA外部网桥上即可。该模式要求对应网桥支持NetStream、NetFlow、SFlow能力。

图12 VEPA、Multi-Channel模式流量模型

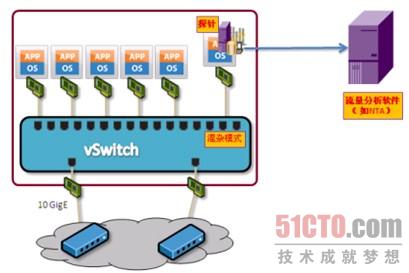

2.从服务器内部分析虚拟化流量的可视性

除了从网络侧进行流量的可视性感知,还可以以一定的手段从虚拟机内部进行进行流量分析。比如,利用vSwitch端口的混杂模式特性,当vSwitch的相应端口配置为混杂模式时,与该端口连接的探测服务器就能镜像观测到该vSwitch上的所有流量。当然,探测服务器就必须作为一个VM才能连接到vSwitch上。

如图13所示,流量采集器(探针)可以作为一个VM部署到需要监控的物理服务器上,并将采集的流量数据输出到外部的流量分析软件进行分析。该方式要求探针部署到服务器内部,而不是重要网络节点附近。相当于降低了探针的部署位置,部署的数量可能会比较多。

图13 基于vSwitch端口混杂模式的流量采集

四、虚拟趋势下的自动化配置迁移

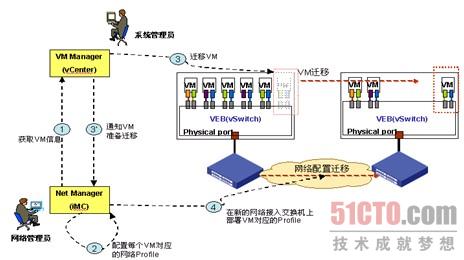

1.基于VMware vCenter的配置迁移方案

图14 基于VMware的虚拟网络配置迁移原理

如图14所示,该方案的关键在于网管系统的虚拟化环境的拓扑可视化能力,定位出VM连接到的物理网络交换机的接入位置以下发VM对应的网络配置。如图17所示,一个VM可能有一个或多个vNic,通过一个或多过vSwitch连接到外部物理交换机。如果要准确定位VM连接的物理网络交换机的接入位置,vSwitch和pSwitch都需要支持必要的二层拓扑协议,比如LLDP协议。以VMware产品为例,其最新版本(vSphere5.0)已经开始支持LLDP协议,但仅在vDS(虚拟网络分布式交换机)上支持LLDP,普通的vSwitch并不支持,虚拟服务器接入位置定位的准确性很难保证。

图15 VM的物理网络接入位置定位

除此之外,本方案还存在一个控制精细度问题。在VEB vSwtich模式下,多个VM可以通过一个物理接口连接到邻接物理交换机,即VM和物理接口是N:1的关系。如图16所示。

图16 VEB、Multi-Channel物理端口映射对比

在此模式下,对物理交换机的配置控制粒度只能到物理接口级,针对数据中心"随需而动"的配置自动化迁移,通常情况下会出现多个VM的配置都重复下发到一个物理接口上,很难做到针对每一个VM的精细化网络配置管理。

2.基于802.1Qbg的配置迁移方案

拟定义的802.1Qbg标准(目前是draft1.6版本)在解决这些问题上提出了新的思路。

802.1Qbg标准首先解决了精细化控制最优的解决方法,即在邻接物理交换机出现了vPort的概念。这类逻辑虚接口可以实现和VM对应的vNic/VSI的1:1对应关系。VM迁移时,只需在对应的邻接物理交换机上动态创建一个vPort,并将VM对应的网络配置Profile绑定到vPort上。不会对其他vPort产生影响。同时迁移前对应的邻接物理交换机只需要简单的将对应的vPort逻辑接口删除即可,不存在反向去部署的复杂性问题。

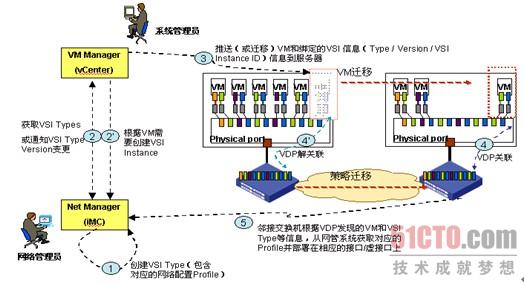

其次,802.1Qbg的VDP特性解决了VM接入定位准确性的问题,即通过VDP通告,邻接物理交换机学习到连接接入的VM信息和对应的网络连接配置信息,并主动向网管系统请求对应的网络连接配置profile,减少了网管系统进行VM接入位置定位的步骤。

该方案过程如图17所示。

图17 支持VDP的虚拟网络配置迁移

整体来看,引入802.1Qbg VDP后,不依赖网管系统对VM接入物理网络的定位能力,提高了网络配置迁移的准确性和实时性。同时,服务器系统管理员和网络管理员职责划分也将更加明确。对系统管理员来讲,只需要关注网络提供的虚拟服务器到邻接交换机的链接;而对网络管理员而言,则只需要关注针对不同的应用系统(或VSI类型)应提供什么样的网络接入配置。这样在IaaS中,网络和服务器之间就产生了一种服务概念的抽象――链接即服务(CaaS,Connection as a service)。

虚拟化服务器、网络的融合管理已经成为当前企业IT、数据中心建设IaaS能力的必要元素,各厂商都在相关领域进行尝试,也出现了不同的虚拟化软件厂商和网络厂商的联盟,不同的实现方案。另一方面,标准化工作和管理技术的研究也在快速进行,在虚拟化管理领域我们仍需紧跟虚拟化技术的发展,才能更好地提供可视、可控的虚拟网络管理能力。