本节和大家继续学习Hadoop,Hadoop是一个分布式系统基础架构,由Apache基金会开发。它有什么奥秘呢,就让我们一起来继续关注Hadoop吧。

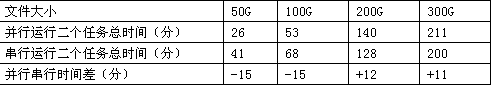

条款6:多个大输入的Job建议使用串行执行,多个小输入的Job建议使用并行执行。

Hadoop的任务处理分为map阶段以及reduce阶段,当集群的taskslots足够支持多个任务同时执行时,建议使用多任务并行执行,反之,建议使用串行执行,且当一个Job开始执行reducetask

时,可以开始执行下一个Job的maptask。

以下是我们在50台退役机器上分别并行和串行运行2个100G,200G,300G的任务的测试结果:

条款7:reducer的个数应该略小于集群中全部reduceslot的个数。

maptask的个数由输入文件大小决定,所以选择合适的reducer的个数对充分利用Hadoop集群的性能有重要的意义。

Hadoop中每个task均对应于tasktracker中的一个slot,系统中mapperslots总数与reducerslots总数的计算公式如下:

mapperslots总数=集群节点数×mapred.tasktracker.map.tasks.maximum

reducerslots总数=集群节点数×mapred.tasktracker.reduce.tasks.maximum

设置reducer的个数比集群中全部的reducerslot略少可以使得全部的reducetask可以同时进行,而且可以容忍一些reducetask失败。

条款8:多个简单串行的Job优于一个复杂的Job。将复杂的任务分割成多个简单的任务,这是典型的分治的思想。这样不仅可以使得程序变得更简单,职责更单一,而且多个串行的任务还可以

在上一个任务的正在执行reduce任务的时候,利用空闲的map资源来执行下一个任务。

4.Key-Value权衡

Map-Reduce算法的核心过程如下:

map(k1,v1)-->list(k2,v2)

reduce(k2,list(v2))-->list(v2)

即通过用户定义的map函数将输入转换为一组<Key,Value>对,而后通过用户定义的reduce函数将<Key,List<Value>>计算出***的结果。

如何选择合适的map和reduce函数才能充分利用Hadoop平台的计算能力呢?换句话说,如何选择上式中合适的K2和V2呢?

条款9:maptask或reducetask的大小应该适中,以一个task运行2-3分钟为宜,且task不能超出计算节点的运算能力。

虽然Hadoop平台帮助我们将数据分割成为小任务来执行,但我们也应当意识到,每个task都是在一个计算节点运行的,若一个task对机器资源(CPU、内存、磁盘空间等)的需求超出了计算

节点的能力的话,任务将会失败。而如果task过小的话,虽然计算节点能够快速的完成task的执行,但过多的task的管理开销,以及中间结果频繁的网络传输将占据任务执行的绝大部分时间,

这样同样会严重影响性能。建议的task大小***是以能够运行2-3分钟为宜。

条款10:map产生的中间结果不宜过大。

输入数据经过用户定义的map函数后生成的<Key,Value>对是Map-Reduce模型的中间计算结果。

Maptask将计算的中间结果保存在本地磁盘,而后通过Reducetask拉去所有当前任务所需的中间结果,并将中间结果按Key排序。显然若map产生的中间结果过大,网络传输时间以及中间结

果排序将占据大部分的Job执行时间。本节关于Hadoop的介绍到此结束。

【编辑推荐】