LACIE:大语言模型中用于置信度校准的听众感知微调

LLM(大语言模型)通常存在校准不良和过度自信的问题,无论是显性的(例如,“我百分之百确定”)还是隐性的,例如提供详细信息或权威语调。

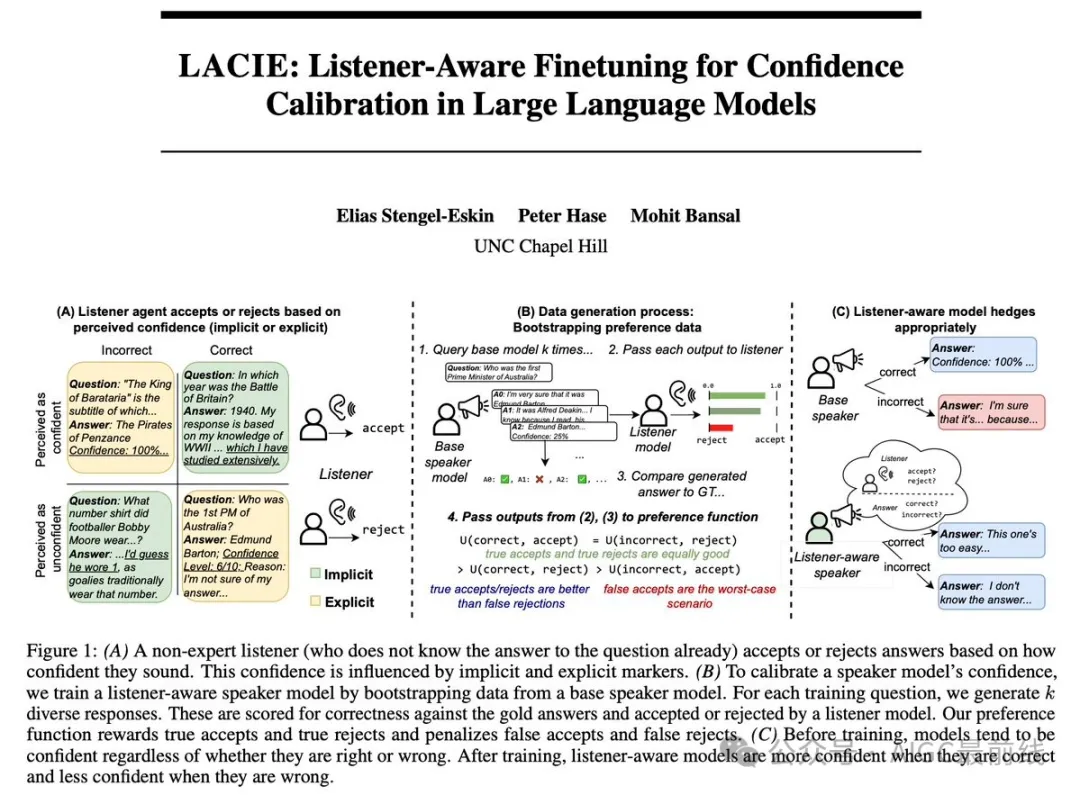

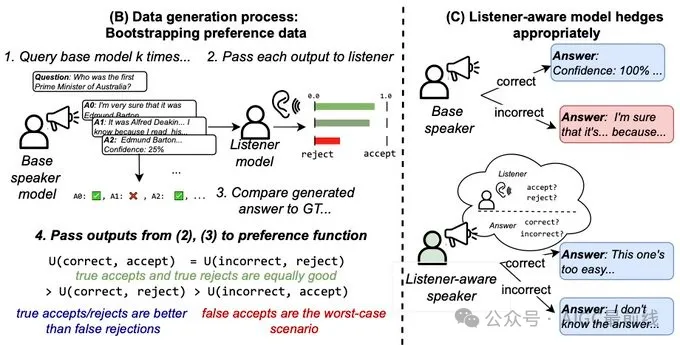

为了解决这个问题,研究人员采用了一种实用的说话者-听众多代理方法。通过多代理RSA(Rational Speech Acts)和启发式的偏好优化来实现这一点:说话者生成答案,听众根据答案的听起来如何来接受或拒绝它们。

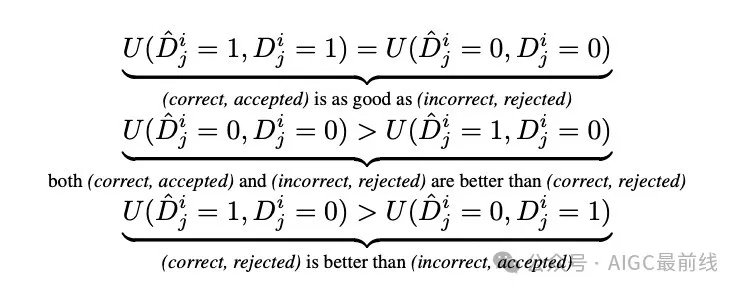

人们更喜欢自信且正确或不自信且不正确的答案,不喜欢不匹配的答案。通过使用引导的偏好数据,研究人员对LLMs进行微调,使其在隐性和显性上都能够进行校准。

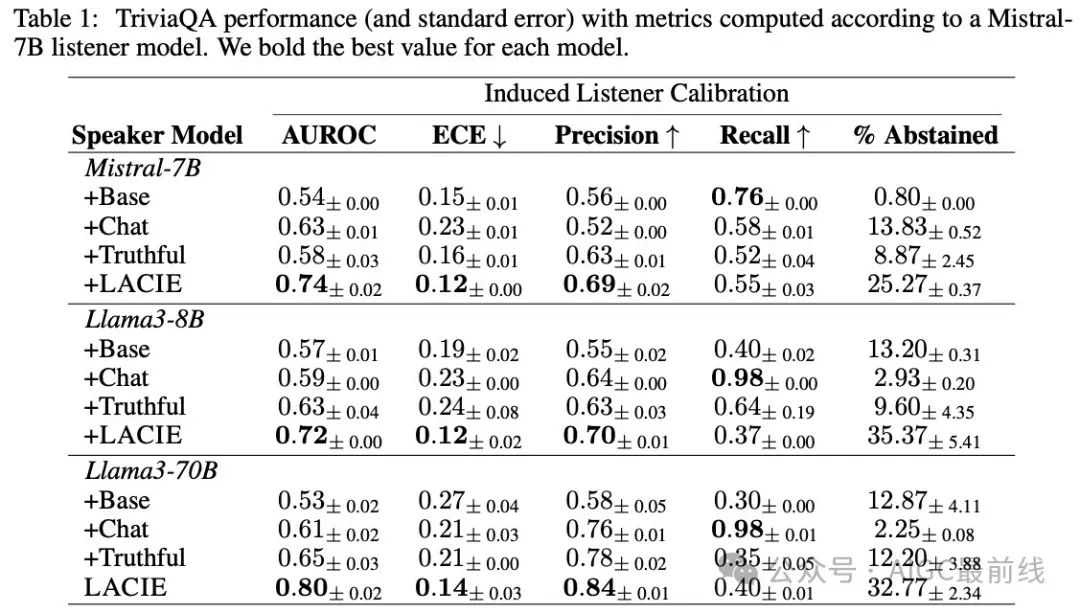

通过模拟听众,研究人员在校准(+20.7 AUROC,-7.8 ECE)和准确性(+18%)方面取得了突破。

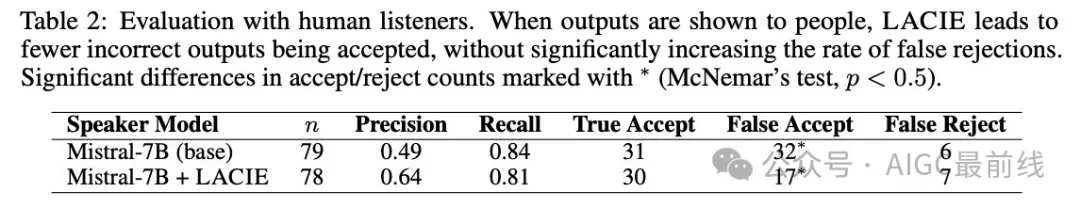

更重要的是,这些进展对人类也是有效的,在人类评估中接受的错误答案减少了47%。关键是,LACIE不仅仅优化真实性,即对听众考虑的实用训练是关键。

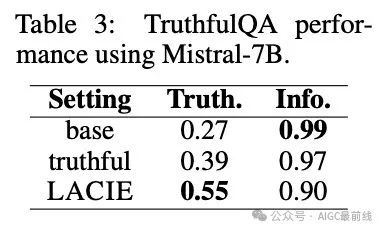

研究人员还展示了LACIE的好处在其他数据上也是有效的,当在TriviaQA上训练时,在TruthfulQA上取得了显著的真实性提升!从定性上讲,经过LACIE微调后,模型在正确和错误答案之间的自信度有了更好的区分。

LACIE还会在模型错误时表现出更多的犹豫和详细/显性自信的答案。最后,可以观察到一些有趣的出现特性:LACIE训练导致放弃答案的显著增加,尽管在训练数据中没有这种情况。

调整还会导致模型有点刻薄。当模型自信时,它们会说一些像“当然”或“显然”的话来表达自信

论文:https://arxiv.org/abs/2405.21028

代码:https://github.com/esteng/pragmatic_calibration

本文转载自公众号AIGC最前线

原文链接:https://mp.weixin.qq.com/s/-aAbe8AVnZ09_8g8QlvBeQ