10倍速度突破质量瓶颈,效果超越Gen-2和Pika!T2V-Turbo:新一代视频生成模型 精华

论文链接: https://arxiv.org/pdf/2405.18750

项目链接:https://t2v-turbo.github.io/

基于扩散的文本到视频(T2V)模型取得了显著的成功,但仍然受到迭代采样过程速度缓慢的影响。为了解决这一挑战,一些一致性模型被提出来促进快速推理,尽管以牺牲样本质量为代价。在这项工作中,旨在突破视频一致性模型(VCM)的质量瓶颈,实现快速且高质量的视频生成。本文引入了T2V-Turbo,将来自不同可微分奖励模型混合的反馈集成到预训练T2V模型的一致性蒸馏(CD)过程中。值得注意的是,本文直接优化与单步生成相关的奖励,这些奖励自然产生于计算CD损失,有效地绕过了通过迭代采样过程反向传播梯度所施加的内存限制。值得注意的是,本文的T2V-Turbo产生的4步生成在VBench上取得了最高的总分,甚至超过了Gen-2和Pika。

本文进一步进行了人类评估来证实结果,验证了本文的T2V-Turbo产生的4步生成优于它们的教师模型产生的50步DDIM样本,这表示视频生成质量的提升了十倍以上,同时加速了视频生成的过程。

介绍

扩散模型(DM)已经成为神经图像和视频合成的强大框架,加速了文本到视频(T2V)模型的前沿发展,例如Sora,Gen-2和Pika。尽管这些基于扩散的模型的迭代采样过程确保了高质量的生成,但它显著减慢了推理速度,阻碍了它们的实时应用。另一方面,现有的开源T2V模型,包括VideoCrafter和ModelScopeT2V,是在网络规模的视频数据集上训练的,例如WebVid-10M,视频质量各不相同。因此,生成的视频通常在视觉上看起来不吸引人,并且无法准确与文本提示对齐,偏离了人类的偏好。

为了解决上述列出的问题,已经进行了一些努力。为了加速推理过程,Wang等人应用了一致性蒸馏(CD)理论,从教师T2V模型中蒸馏出一个视频一致性模型(VCM),使得在只需4-8个推理步骤中便能生成合理的视频。然而,VCM生成的质量受到教师模型性能的自然瓶颈限制,并且减少的推理步骤进一步降低了其生成质量。另一方面,为了使生成的视频与人类偏好保持一致,InstructVideo借鉴了图像生成技术,并提出通过迭代视频采样过程反向传播可微分奖励模型(RM)的梯度。然而,计算完整的奖励梯度成本过高,导致了巨大的内存成本。因此,InstructVideo通过将梯度计算限制为仅在最终DDIM步骤中截断采样链,从而损害了优化精度。此外,InstructVideo受限于其依赖于图像文本RM,无法充分捕捉视频的过渡动态。从经验上看,InstructVideo仅对有限的一组用户提示进行实验,其中大多数与动物相关。因此,它对更广泛范围提示的泛化性仍然是未知的。

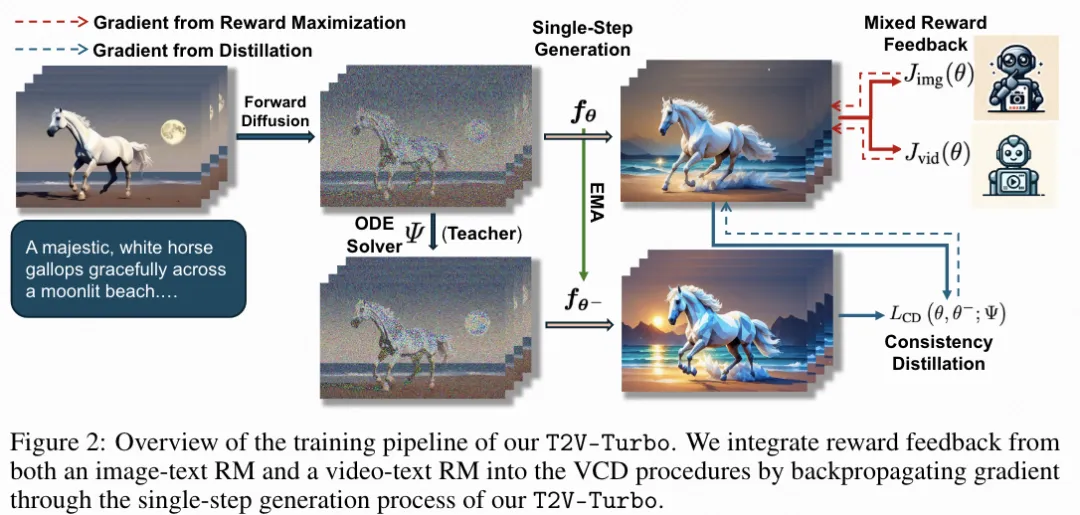

本文旨在通过打破VCM的质量瓶颈,实现快速且高质量的视频生成。本文介绍了T2V-Turbo,它将来自多种RM混合的奖励反馈集成到从教师T2V模型中蒸馏VCM的过程中。除了利用图像文本RM来使单个视频帧与人类偏好对齐之外,本文进一步结合了来自视频文本RM的奖励反馈,全面评估生成视频中的时间动态和过渡。本文强调,本文的奖励优化避免了通过迭代采样过程反向传播梯度所涉及的高度消耗内存的问题。相反,本文直接优化由计算CD损失而产生的单步生成的奖励,有效地规避了传统方法面临的优化DM时的内存限制。

根据经验,本文展示了T2V-Turbo在4-8个推理步骤内生成高质量视频的优越性。为了说明本文方法的适用性,分别从VideoCrafter2和ModelScopeT2V中提取T2V-Turbo(VC2)和T2V-Turbo(MS)。值得注意的是,T2V-Turbo的两个变体在4个步骤生成的结果都优于视频评估基准VBench上的SOTA模型,甚至超过了使用大量资源训练的专有系统,如Gen-2和Pika。本文进一步通过使用EvalCrafter基准中的700个提示进行人类评估来证实这些结果,验证了T2V-Turbo的4步生成优于其教师T2V模型的50步DDIM样本,这代表了十倍以上的推理加速和增强的视频生成质量。

本文的贡献有三点:

- 从多种RM的反馈中学习T2V模型,包括视频文本模型。据作者所知,本文是第一个这样做的。

- 在仅4个推理步骤中在VBench上建立了一个新的SOTA,优于使用大量资源训练的专有模型。

- 根据人类评估,本文T2V-Turbo的4步生成优于其教师T2V模型的50步生成,代表了超过10倍的推理加速和质量改进。

使用混合奖励反馈训练T2V-Turbo

特别是,本文利用图像文本 RM 的奖励反馈来提高每个单独视频帧的人类偏好,并进一步利用视频文本 RM 的反馈来改善生成视频中的时间动态和过渡。

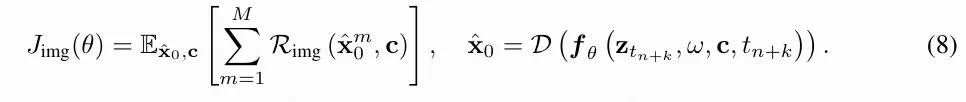

优化人类对个人视频片段的偏好

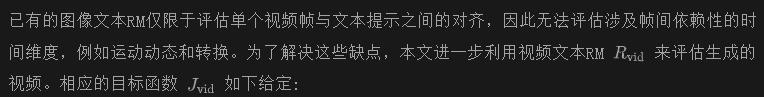

优化Video-Text反馈模型

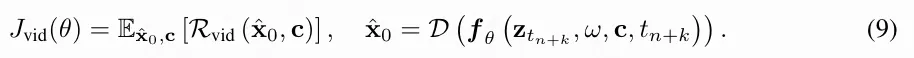

总结

为了减少内存和计算成本,将本文的T2V-Turbo初始化为教师模型,并且仅优化LoRA权重,而不是执行完整的模型训练。在完成训练后,本文合并LoRA权重,使得本文的T2V-Turbo每步推理成本保持与教师模型相同。

实验结果

本文的实验旨在展示T2V-Turbo在4-8个推理步骤内生成高质量视频的能力。本文首先在标准基准测试集VBench上进行自动评估,以综合评估本文的方法在各个维度上的性能,并与广泛的基线方法进行比较。然后,本文使用来自EvalCrafter的700个提示进行人类评估,比较T2V-Turbo的4步和8步生成与教师T2V模型的50步生成以及基线VCM的4步生成。最后,对关键设计选择进行消融研究。

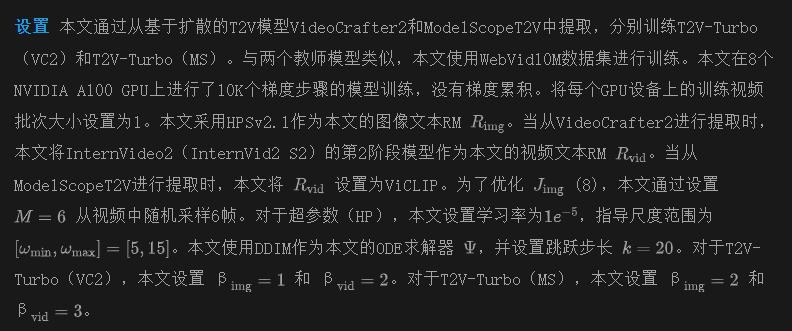

VBench 自动求值

本文评估了本文的T2V-Turbo(VC2)和T2V-Turbo(MS),并将它们与广泛的基线方法进行比较,使用了标准视频评估基准VBench。VBench旨在从16个解耦维度全面评估T2V模型。VBench中的每个维度都根据特定的提示和评估方法进行了定制。

下表1比较了本文方法的4步生成与VBench排行榜上各种基线方法的比较,包括Gen-2、Pika、VideoCrafter1、VideoCrafter2、Show-1、LaVie和 ModelScopeT2V。原文附录中的表4进一步将本文的方法与VideoCrafter0.9、LaVie-Interpolation、Open-Sora和 CogVideo 进行了比较。每个基线方法的性能直接来自于VBench排行榜。为了获得本文方法的结果,本文严格遵循VBench的评估协议,为每个提示生成5个视频以计算指标。本文进一步从VideoCrafter2和ModelScopeT2V中提取VCM(VC2)和VCM(MS),并将它们的结果进行比较,而不包括奖励反馈。

VBench已经制定了自己的规则来计算总得分、质量得分和语义得分。质量得分是使用顶部表格中的7个维度计算的。语义得分是使用底部表格中的9个维度计算的。而总得分是质量得分和语义得分的加权和。正如上表1所示,本文的T2V-Turbo(MS)和T2V-Turbo(VC2)的4步生成在总得分方面超过了VBench上的所有基线方法。这些结果尤其引人注目,因为本文甚至超过了使用大量资源训练的专有系统Gen-2和Pika。即使从一个较不先进的教师模型ModelScopeT2V进行提取,本文的T2V-Turbo(MS)也获得了第二高的总得分,仅次于本文的T2V-Turbo(VC2)。此外,本文的T2V-Turbo通过超越其教师T2V模型打破了VCM的质量瓶颈,明显优于基线VCM。

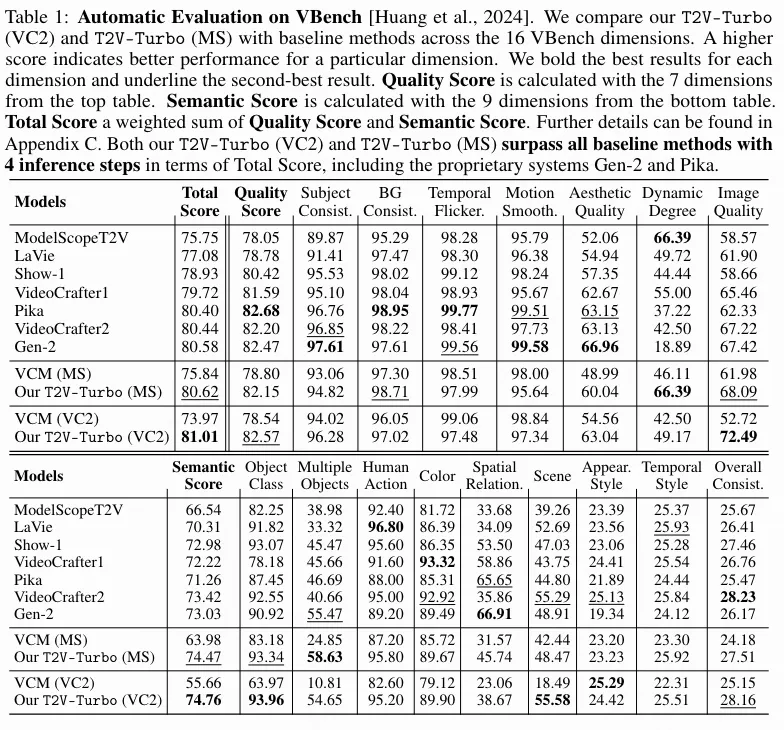

使用 700 个 EvalCrafter 提示进行人工评估

为了验证本文的T2V-Turbo的有效性,本文将T2V-Turbo的4步和8步生成与相应教师T2V模型的50步DDIM样本进行比较。本文进一步比较了从相同教师T2V模型提取时,本文的T2V-Turbo的4步生成与它们基线VCM的4步生成。

本文利用来自EvalCrafter视频评估基准的700个提示,这些提示是基于真实世界的用户数据构建的。本文从亚马逊的 Mechanical Turk 平台雇用人类标注员来比较使用相同提示生成的不同模型的视频。对于每次比较,标注员需要回答三个问题:

- Q1)哪个视频在视觉上更吸引人?

- Q2)哪个视频更符合文本描述?

- Q3)在给定的提示下,您更喜欢哪个视频?

下图3提供了完整的人类评估结果。本文还在图4中对不同的方法进行了定性比较。附录F进一步包括了额外的定性比较结果。值得注意的是,与其教师T2V模型的50步生成相比,本文的T2V-Turbo的4步生成受到人类的青睐,表示推理加速了25倍并提升了性能。通过将推理步骤增加到8步,本文可以进一步改善从本文的T2V-Turbo生成的视频的视觉质量和文本-视频对齐,事实上,本文的8步生成在所有3个评估指标中都更受人类喜爱,相比本文的4步生成。此外,本文的T2V-Turbo显著优于其基线VCM,证明了将混合奖励反馈纳入模型训练的方法的有效性。

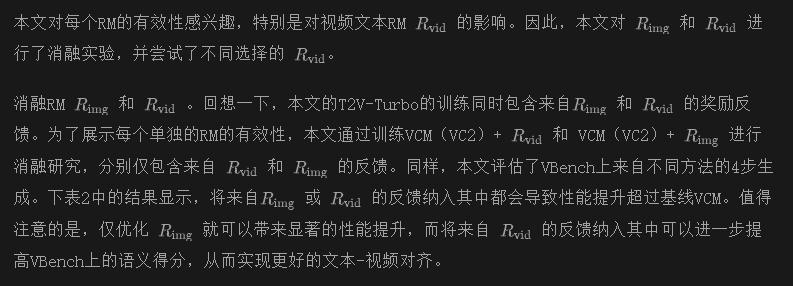

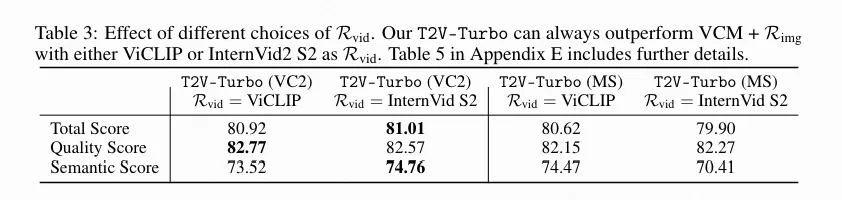

消融实验

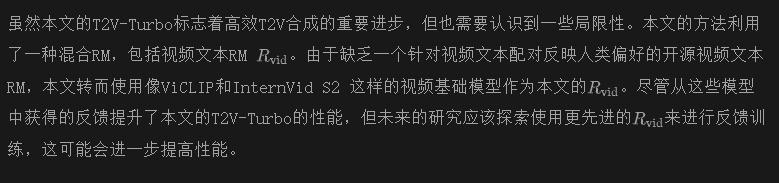

结论 & 限制

在本文中,提出了T2V-Turbo,通过打破VCM的质量瓶颈,实现了快速和高质量的T2V生成。具体来说,本文将混合奖励反馈集成到教师T2V模型的VCD过程中。从经验上讲,本文通过从VideoCrafter2和ModelScopeT2V中提取T2V-Turbo(VC2)和T2V-Turbo(MS)来说明本文方法的适用性。值得注意的是,本文的两个T2V-Turbo的4步生成都优于VBench上的SOTA方法,甚至超过了它们的教师T2V模型和专有系统,包括Gen-2和Pika。人类评估进一步证实了这些结果,显示出本文的T2V-Turbo的4步生成受到人类的青睐,而不是它们的教师的50步DDIM样本,这代表了超过十倍的推理加速和质量改进。

本文转自 AI生成未来 ,作者:Jiachen Li 等