超越Magic3D、ProlificDreamer,更灵活更可控的Text-to-3D扩散

论文链接:https://arxiv.org/pdf/2310.05375

代码链接:https://github.com/zengbohan0217/IPDreamer

最近文本到3D生成以及单张图片到3D生成惊艳的生成结果引来了越来越多研究者们的关注,然而这两个方向都存在有各自小小的局限性,首先文本到3D生成的结果难以准确地控制生成结果的外观,而单张图片到3D生成虽然可以确定生成3D结果的外观,但是目前主要的单张图片到3D生成方法还是只能处理主体比较明确的图片,难以处理复杂的图片,并且约束比较强,无法灵活地控制生成结果。

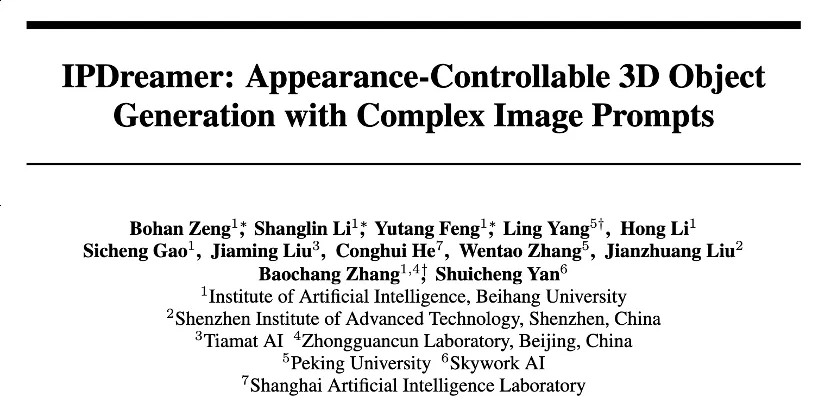

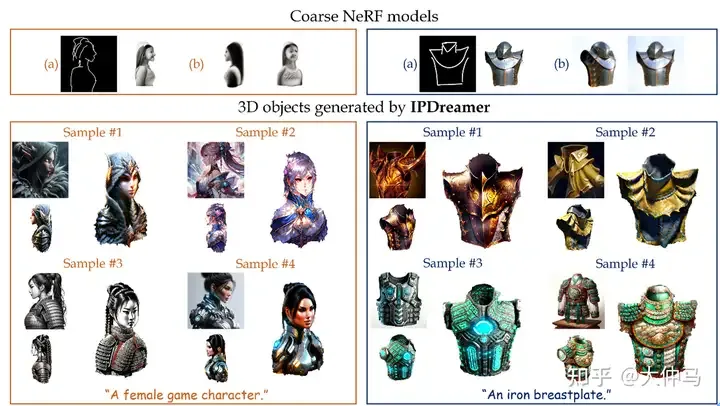

图1

基于以上问题,本文工作向3D生成过程中引入了image prompt adaption,能够利用图片提示词的特征来优化3D物体的几何细节以及材质颜色,从而实现灵活、可控且高质量的3D生成。如图1所示,我们可以将主体并不明确的复杂图片风格高质量地迁移到粗糙的3D物体上。并且在文本到3D生成的效果上,我们的方法比DreamFusion、Magic3D、Fantasia3D以及ProlificDreamer等SOTA方法表现更好。

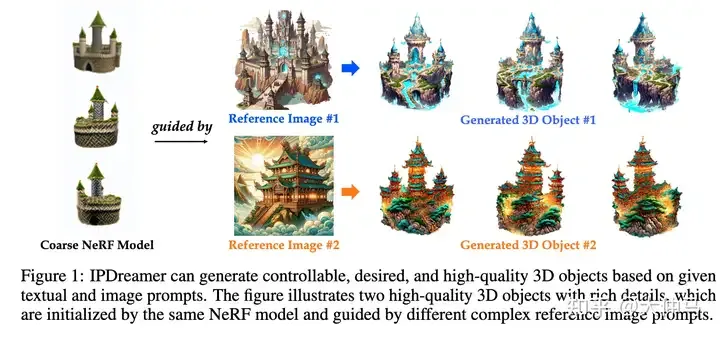

IPDreamer框架图

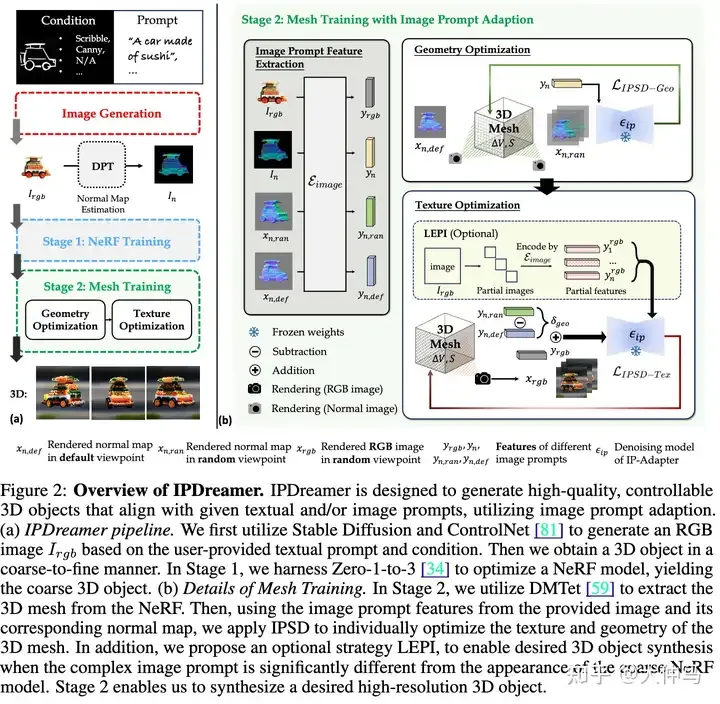

下面举一个例子展示优化过程:

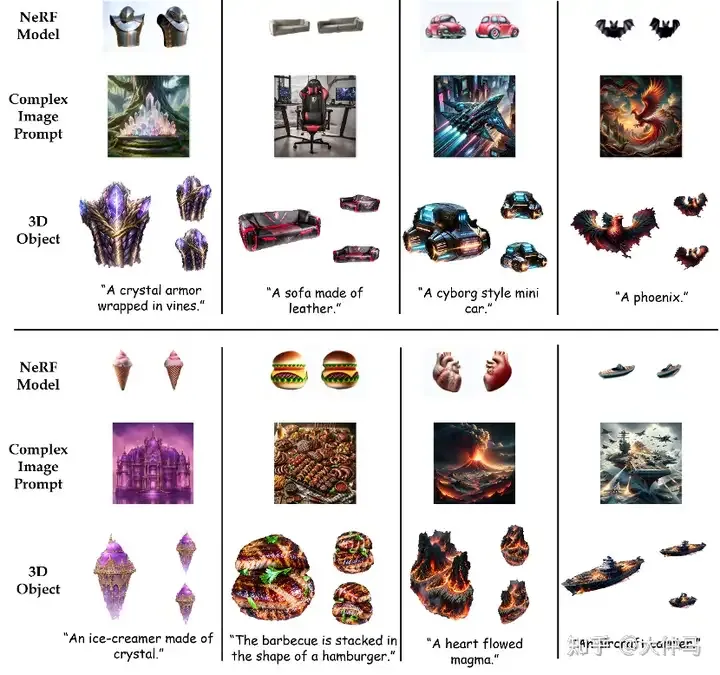

我们提出image prompt score distillation(IPSD),分别利用复杂图片的法向图以及图片本身对应的图片提示词特征来优化3D物体的几何细节以及颜色质地。

同时我们分析了为什么image prompt adaption可以很好地将复杂图片提示词的特征有效地定位到3D物体上。在优化过程中,图片提示词所对应的交叉注意力机制层计算得到的注意力图会一一将复杂图片提示词不同部分的特征定位到3D物体2D渲染图最合适的位置上。经过多轮的优化,复杂图片的特征可以非常好地定位到3D物体上。

同一个3D物体使用不同的图片提示词进行编辑可以展现出更丰富的效果,大大扩充了3D生成的丰富性。

甚至当被编辑的3D物体与提供的图片提示词形象上差异比较大的时候也可以很好地实现生成

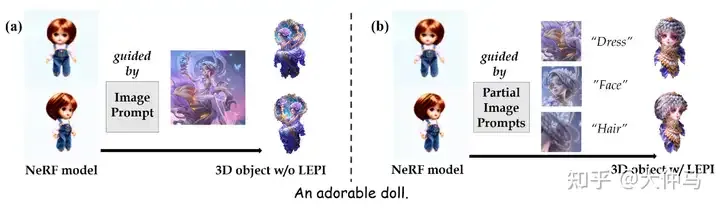

我们还发现,当被引导的粗糙的NeRF模型与复杂图片提示词有巨大差异时,仅仅使用交叉注意力机制曾进行特征定位难以生成理想的3D物体,为此我们提出了local editing with partial images(LEPI)策略来改进特征定位,从而更加灵活可控地生成理想的3D物体。我们借助多模态大模型以及SAM将复杂图片提示词分为若干个“部分图片”,如图5所示,同时每一个“部分图片”被提供了一个单词描述,我们借助这个描述在交叉注意力层中计算对应的mask,利用这个mask将对应的“部分图片”的特征定位到3D物体上。

图5

一些极端情况下,利用LEPI确实能产生更好的效果

更多的生成结果,证明了LEPI,即我们IPDreamer方法的稳定性与泛化性

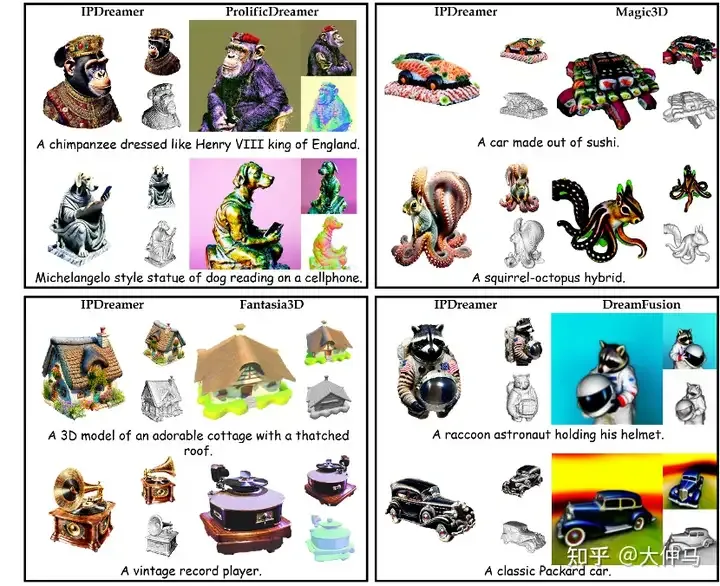

此外我们的方法还可以完成文本到3D生成,如图8所示,我们的方法相较于以往的文本到3D生成方法,可以生成更加高质量的复杂的3D物体。

图8

本文转自 AI生成未来 ,作者:大仲马