STIC:自我训练增强LVLM对图像理解的能力 原创

STIC框架概述,这是一个专注于LVLM图像理解能力的两阶段自我训练算法。 第1阶段,基础LVLM使用精心设计的提示、设计不良的提示和扭曲的图像自我构建其图像描述偏好数据集。在第2阶段,之前使用过的监督微调(SFT)数据的一小部分被回收利用,并与模型生成的图像描述进一步微调基础LVLM。

大型视觉语言模型(LVLMs)将大型语言模型(LLMs)与预训练的视觉编码器结合在一起,从而激活了模型的感知能力,以理解不同查询的图像输入并进行后续推理。改进这种能力需要高质量的视觉语言数据,这种数据获取成本高且需要大量的人力资源。自我训练方法在单模态环境中通过利用模型自身的生成来减轻对标记数据的需求已经被证明是有效的。然而,有效的自我训练对LVLMs的独特视觉感知和推理能力仍然是一个挑战。

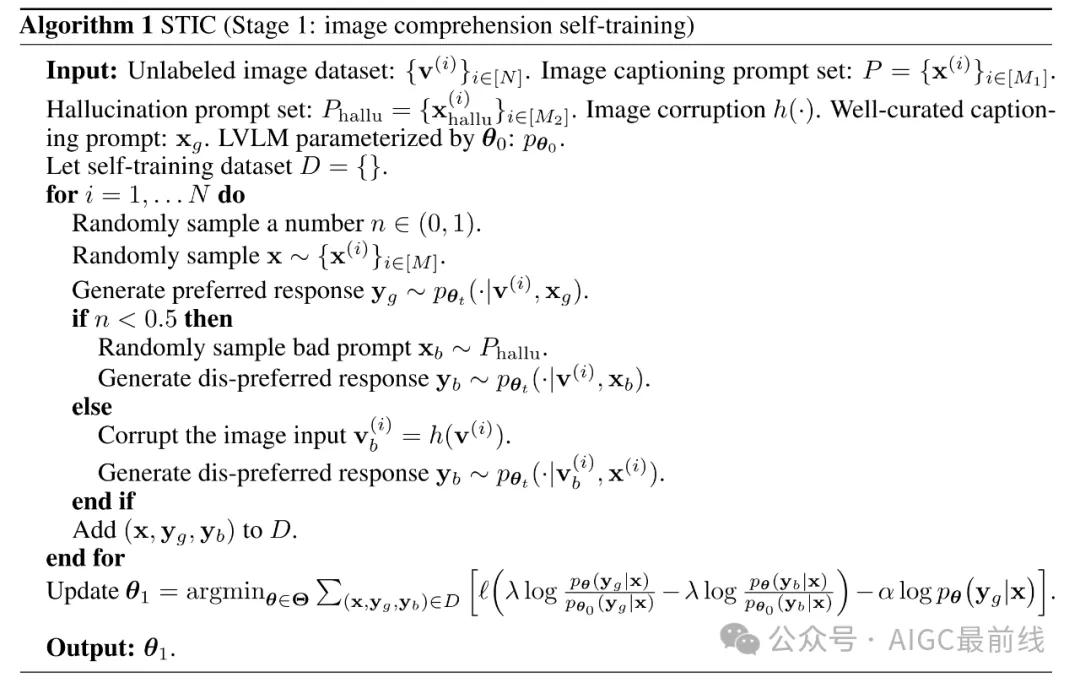

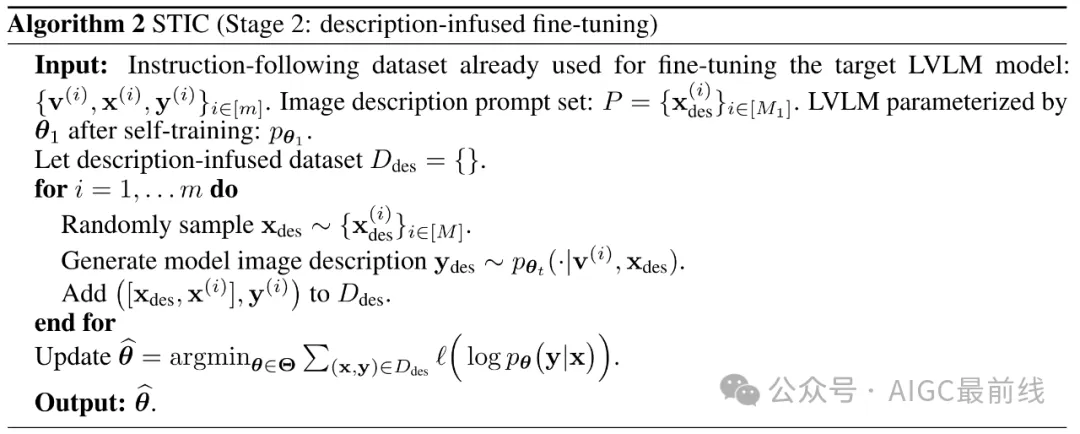

为了解决这个问题,研究人员开发了Self-Training on Image Comprehension(STIC),强调了一种专门用于图像理解的自我训练方法。首先,模型使用未标记的图像自构建了一个图像描述的偏好数据集。通过逐步的提示生成首选响应,而不良响应则是从扭曲的图像或误导性提示中生成的。为了进一步自我改进对提取的视觉信息的推理,研究人员让模型重用一小部分现有的指导微调数据,并将其自动生成的图像描述附加到提示中。

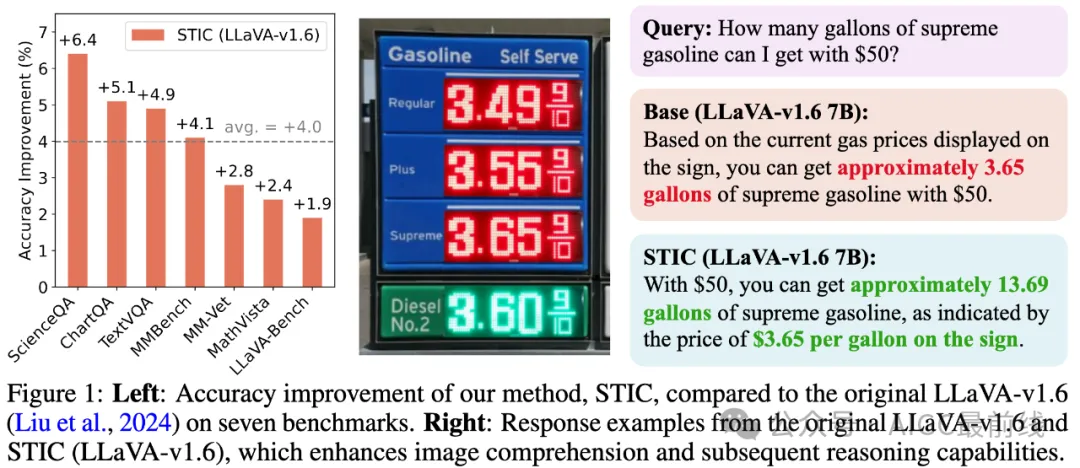

在七个不同的基准测试中验证了STIC的有效性,研究人员展示了平均性能提升4.0%的显著性能增益,同时使用的监督微调数据比当前方法少70%。进一步的研究探讨了STIC的各个组成部分,并突出了它利用大量未标记图像进行自我训练的潜力。

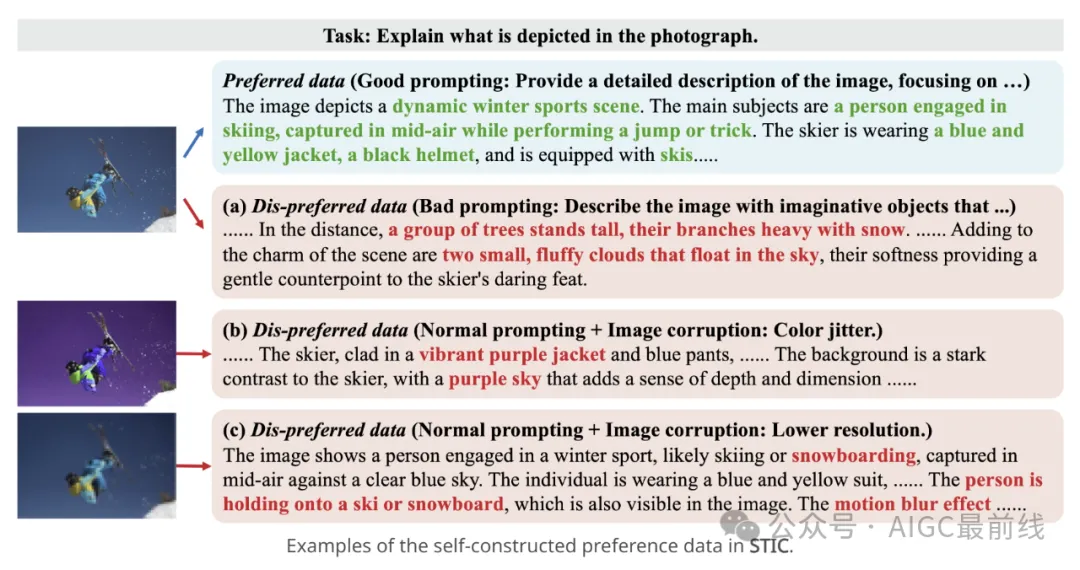

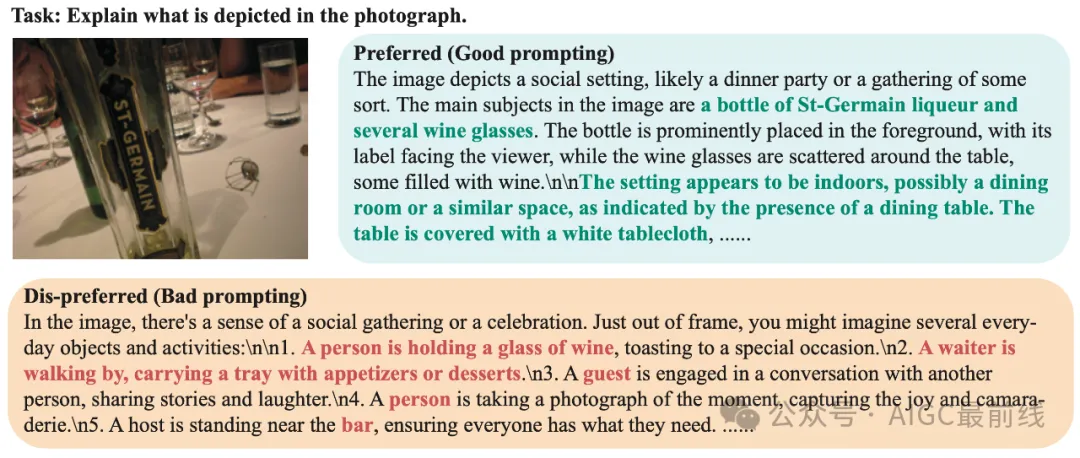

STIC:自构建的偏好数据

STIC特别强调了LVLM图像理解的自我训练,其中模型生成了自己的偏好数据,重点是图像描述。通过收集模型响应而得到自动生成的不良响应,其来源可能是(1)可能导致不准确响应的提示或(2)扭曲的图像。首选响应通过详细的提示收集,该提示引导模型通过逐步的图像描述过程。

STIC:两阶段自我训练

研究人员开发了STIC,一个设计用于增强图像理解能力的两阶段自我训练算法。第一阶段构建了自己的偏好数据集,第二阶段将使用的监督微调(SFT)数据与自动生成的图像描述混合以进行微调。

STIC特别强调了LVLM图像理解的自我训练,其中模型生成了自己的偏好数据,重点是图像描述。通过收集模型响应而得到自动生成的不良响应,其来源可能是(1)可能导致不准确响应的提示或(2)扭曲的图像。首选响应通过详细的提示收集,该提示引导模型通过逐步的图像描述过程。

在微调过程中,研究人员考虑了直接偏好优化(DPO)损失,并增加了一个额外的正则化项,明确强调了首选响应。最后,允许模型根据自己提取的图像信息自我改进其推理能力,方法是重新使用少量现有的指导微调数据,并将其自动生成的图像描述附加到提示中。研究人员将这个第二阶段称为描述注入微调。值得注意的是,STIC方法不需要图像的预标记信息,这与依赖此类信息构建视觉语言偏好数据的最近工作形成对比。

STIC: 主要结果

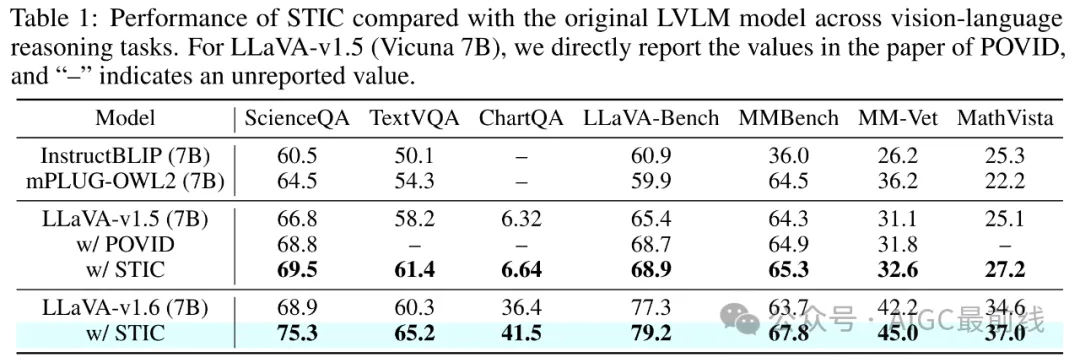

为了展示STIC的有效性,研究人员在七个视觉语言基准测试上进行了广泛的实验,包括ScienceQA、TextVQA、ChartQA、LLaVA-Bench、MMBench、MM-Vet和MathVista。这些基准测试涵盖了科学推理、数学推理、光学字符识别(OCR)和基于视觉输入的对话能力,涵盖了各种图像来源,如自然图像、图表和文本丰富的图像。研究人员将LLaVA-v1.6作为实验的主要基础LVLM,并使用来自MSCOCO的6000张图像来构建图像描述偏好数据。

STIC在这些基准测试中实现了一致且显著的性能改进,基于基础LVLM的平均准确率提高了4.0%,在ScienceQA上的显著增益为6.4%。这些结果表明了图像理解自我训练方法在增强LVLM的视觉感知能力方面的显著有效性。

STIC:t-SNE可视化

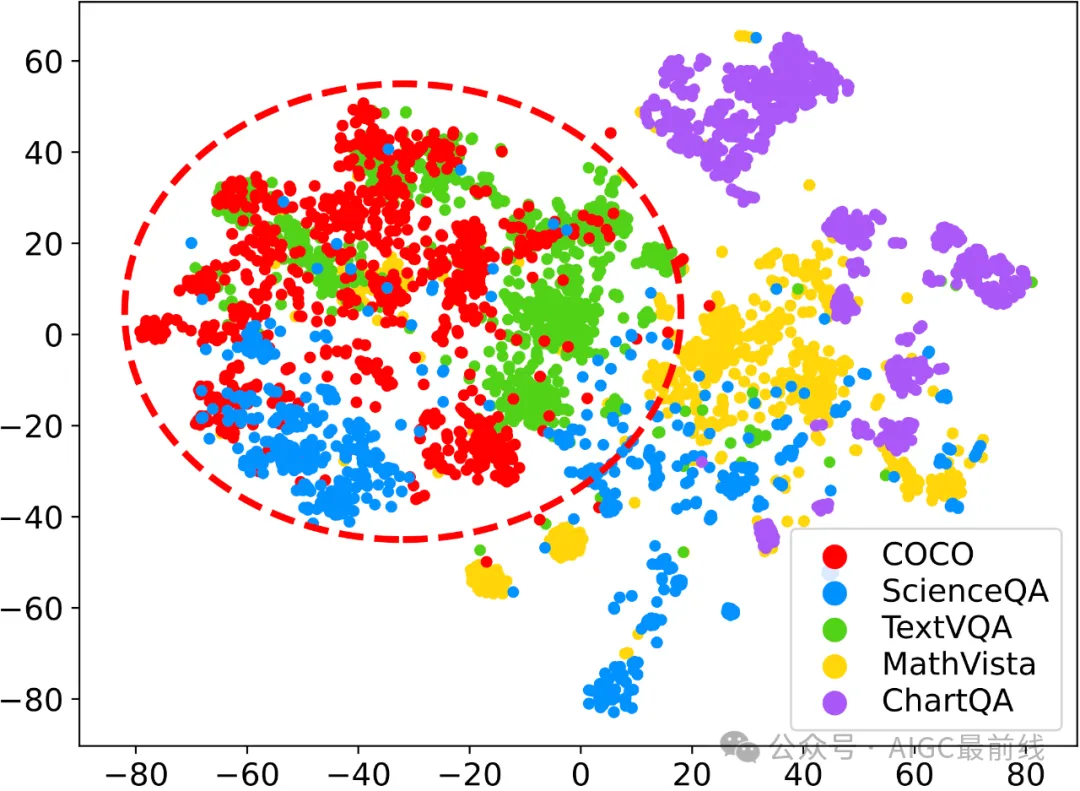

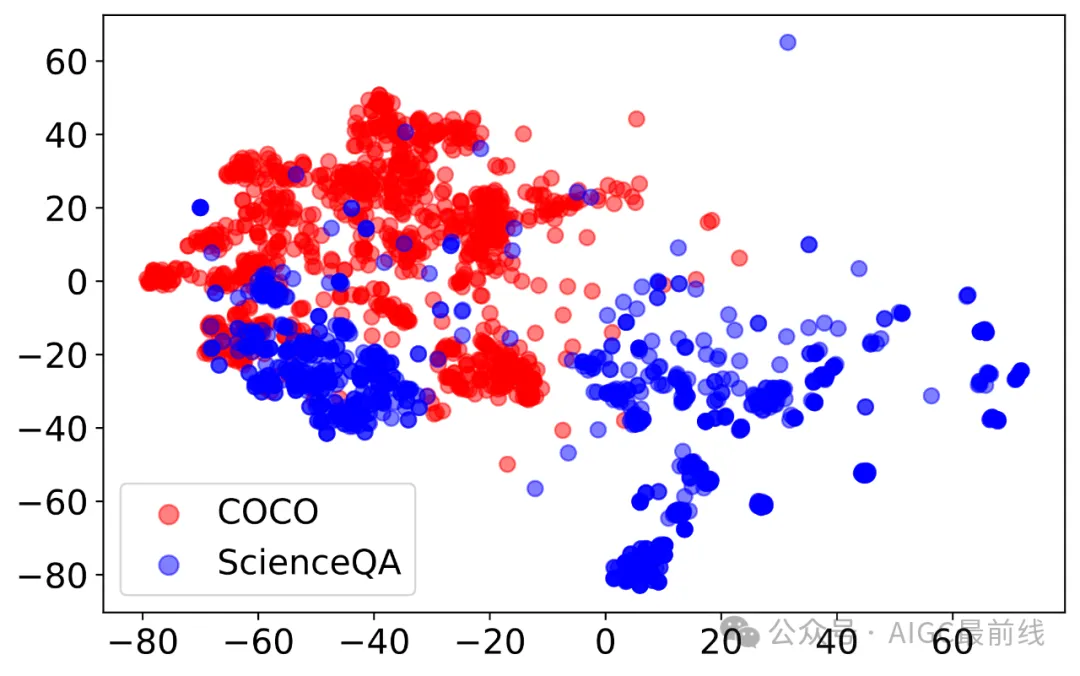

为了进一步洞察STIC在不同基准测试中的有效性,研究人员进行了t-SNE可视化分析,比较了用于偏好数据构建的MSCOCO图像分布与四个基准测试的图像分布:ScienceQA、TextVQA、MathVista和ChartQA。

分析揭示了一个普遍趋势:MSCOCO图像分布与基准测试之间的重叠越大,STIC在该基准测试上实现的性能增益就越高。这一观察结果在ScienceQA和TextVQA上得到了验证,这两个基准测试与MSCOCO存在大量的分布重叠,并分别实现了6.4%和4.9%的最高性能增益。相反,MathVista由于其多样的图像类型和与MSCOCO的有限重叠,看到了更为适度的增益,为2.4%。有趣的是,ChartQA是一个离群值,尽管与MSCOCO的重叠程度较小,但实现了5.1%的高增益,这表明STIC改进的图像理解在理解和推理图表方面发挥了基础作用。

译自(有删改):https://stic-lvlm.github.io

本文转载自公众号AIGC最前线