HippoRAG:协同LLM、KG与PPR的新型开源检索框架,R@5比RAPTOR提高28%

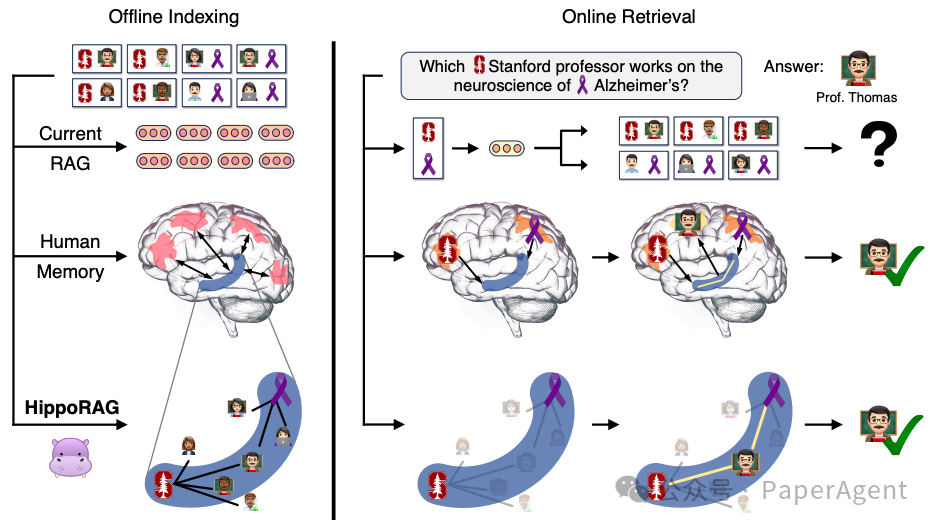

大型语言模型(LLMs)在预训练后仍难以有效整合大量新经验,当前使用的检索增强生成(RAG)方法无法帮助LLMs跨段落整合新知识。人类大脑通过海马体的索引结构来实现关联记忆能力,这是当前RAG系统所缺乏的。

知识整合与RAG。需要知识整合的任务对于当前的RAG系统来说特别具有挑战性。在上述例子中,从描述可能成千上万的斯坦福教授和阿尔茨海默症研究人员的段落中找到一位从事阿尔茨海默症研究的斯坦福教授。由于当前方法孤立地对段落进行编码,除非一个段落同时提到了这两个特征,否则它们很难识别出托马斯教授。相比之下,大多数熟悉这位教授的人会由于我们大脑的联想记忆能力而迅速记住他,这种能力被认为是由图中C形海马体(蓝色)所描绘的索引结构驱动的。受这种机制的启发,HippoRAG允许大型语言模型构建并利用类似的关联图来解决知识整合任务。

HippoRAG是一个受人类长期记忆的海马索引理论启发的新型检索框架。HippoRAG旨在通过模仿人类大脑中新皮层和海马体的不同角色,来实现更深层次、更高效的知识整合,整个框架包括离线索引阶段与在线检索阶段。

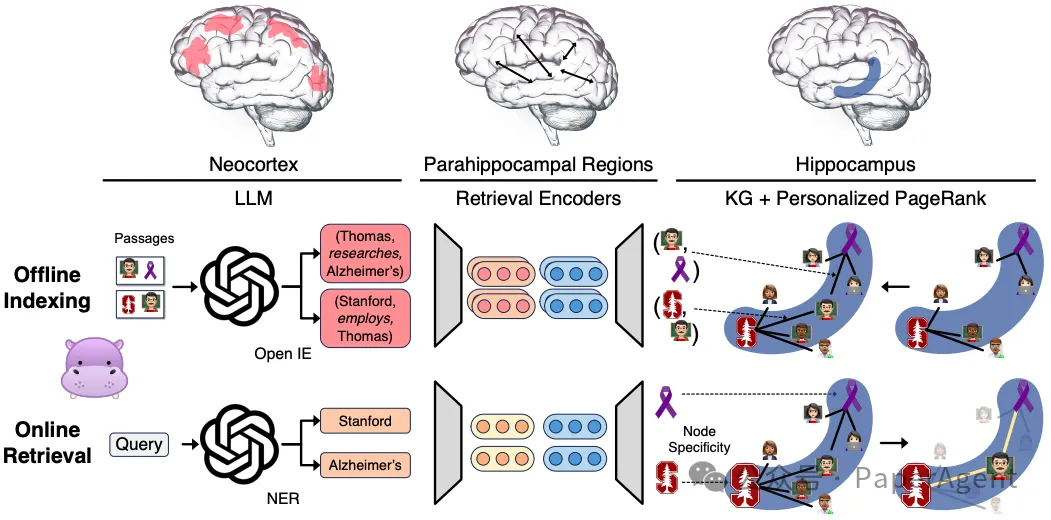

详细的HippoRAG方法论。模拟人类长期记忆的三个组成部分,以模仿其模式分离和完成功能。对于离线索引(中间),使用LLM处理段落,将其转化为开放知识图谱(KG)三元组,然后添加到我们的人工海马体索引中,而合成海马旁回区域(PHR)检测同义性。在上面的例子中,涉及Thomas教授的三元组被提取并整合到知识图谱中。对于在线检索(底部),的LLM新皮质从查询中提取命名实体,而海马旁回检索编码器将它们链接到我们的海马体索引。然后我们利用个性化PageRank算法来实现基于上下文的检索,并提取Thomas教授。

离线索引(Offline Indexing):

- 新皮层模拟:使用一个指令调整的大型语言模型(LLM),作为人工新皮层,通过开放信息提取(OpenIE)从文档集合中提取知识图谱(KG)三元组。这一过程被称为开放信息提取,它从文档中提取名词短语作为离散信号,而不是密集的向量表示,从而实现更细粒度的模式分离。

- 知识图谱构建:构建的KG是无模式的(schemaless),允许更灵活的模式分离和新信息整合。

- 海马索引构建:使用标准的检索编码器(retrieval encoders),这些编码器为KG中的相似但不完全相同的名词短语提供额外的边,帮助下游的模式完成。

在线检索(Online Retrieval):

- 查询处理:LLM基于新皮层从查询中提取一组显著的命名实体(query named entities),这些实体随后通过检索编码器与KG中的节点链接。

- 模式完成:选定的查询节点成为部分线索,人工海马体执行模式完成,通过个性化PageRank(PPR)算法在KG上运行,使用查询概念作为种子,整合跨文档的信息进行检索。

- 个性化PageRank(PPR):PPR算法是一种PageRank的变体,它只通过一组用户定义的源节点(即查询节点)在图中分布概率。这使得PPR输出只偏向于查询节点集,模仿海马体从特定部分线索中提取相关信号。

HippoRAG展示了处理当前方法难以触及的新类型场景的潜力:

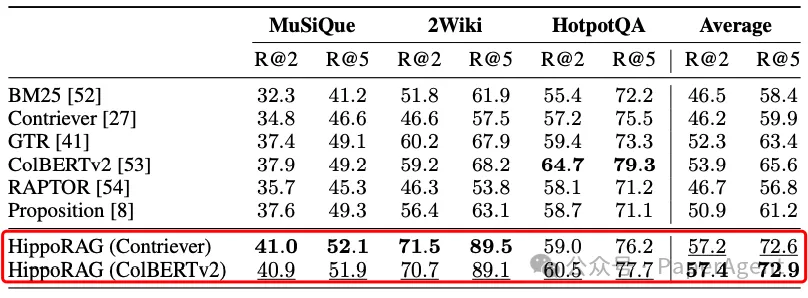

- HippoRAG在多跳问答(QA)基准测试中表现出色,相较于现有RAG方法显著提高了性能,最高可达20%。

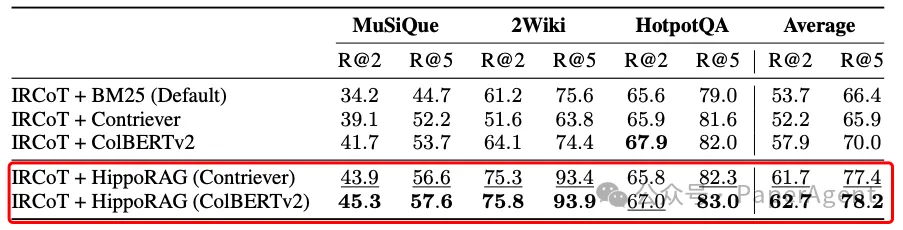

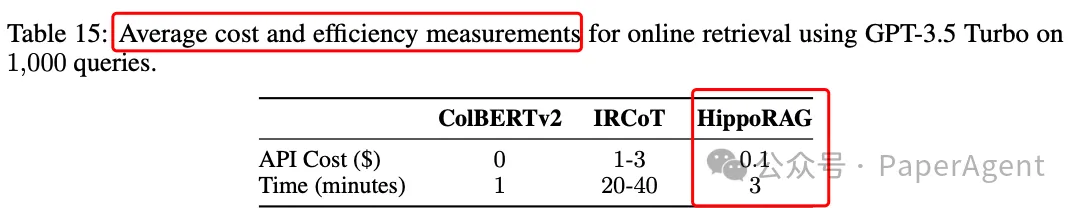

- 与迭代检索方法如IRCoT相比,HippoRAG的单步检索在成本上节省10-30倍,在速度上快6-13倍,并且与IRCoT结合使用可以带来进一步的显著增益。

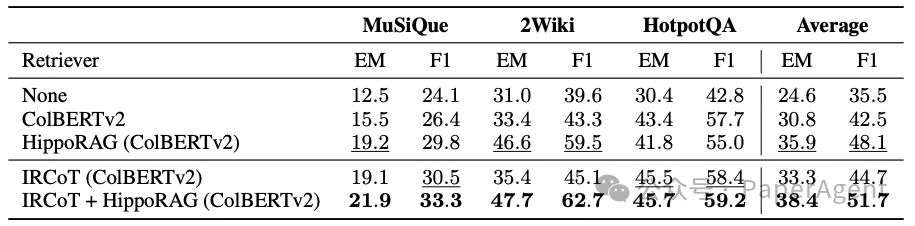

单步检索性能。HippoRAG在MuSiQue和2WikiMultiHopQA上的表现超过了所有基线,并且在挑战性较小的HotpotQA数据集上达到了可比的性能。

多步检索性能。将HippoRAG与IRCoT等标准多步检索方法相结合,在所有三个数据集上都取得了显著的改进。

问答性能。HippoRAG的问答改进与其在单步检索(行1-3)和多步检索(行4-5)的检索改进相关联。

成本与速度评测

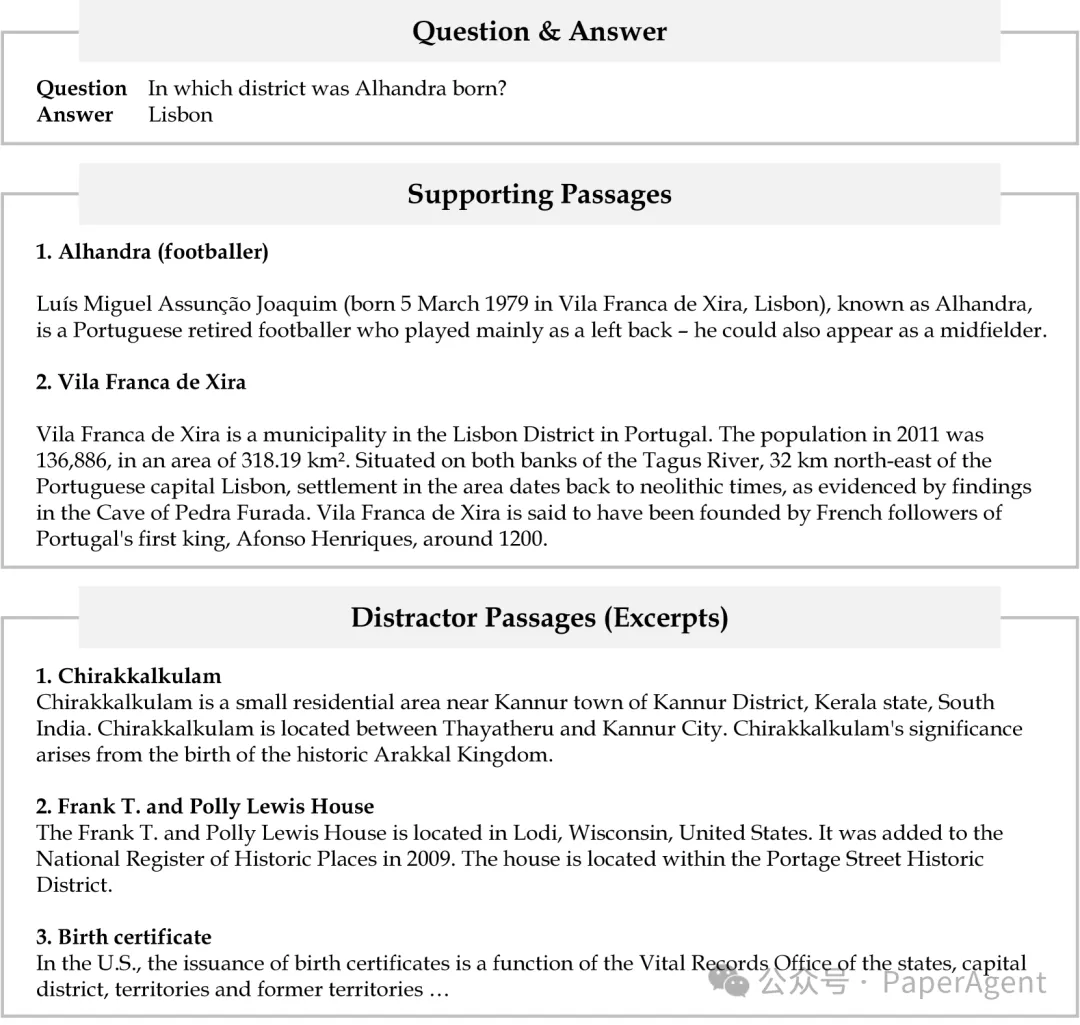

图3:HippoRAG流程示例(问题和注释),(顶部)一个示例问题及其答案。(中间和底部)这个问题的支持段落和干扰段落。解决这个问题需要两个支持段落。干扰段落的摘录与问题中提到的“区”有关。

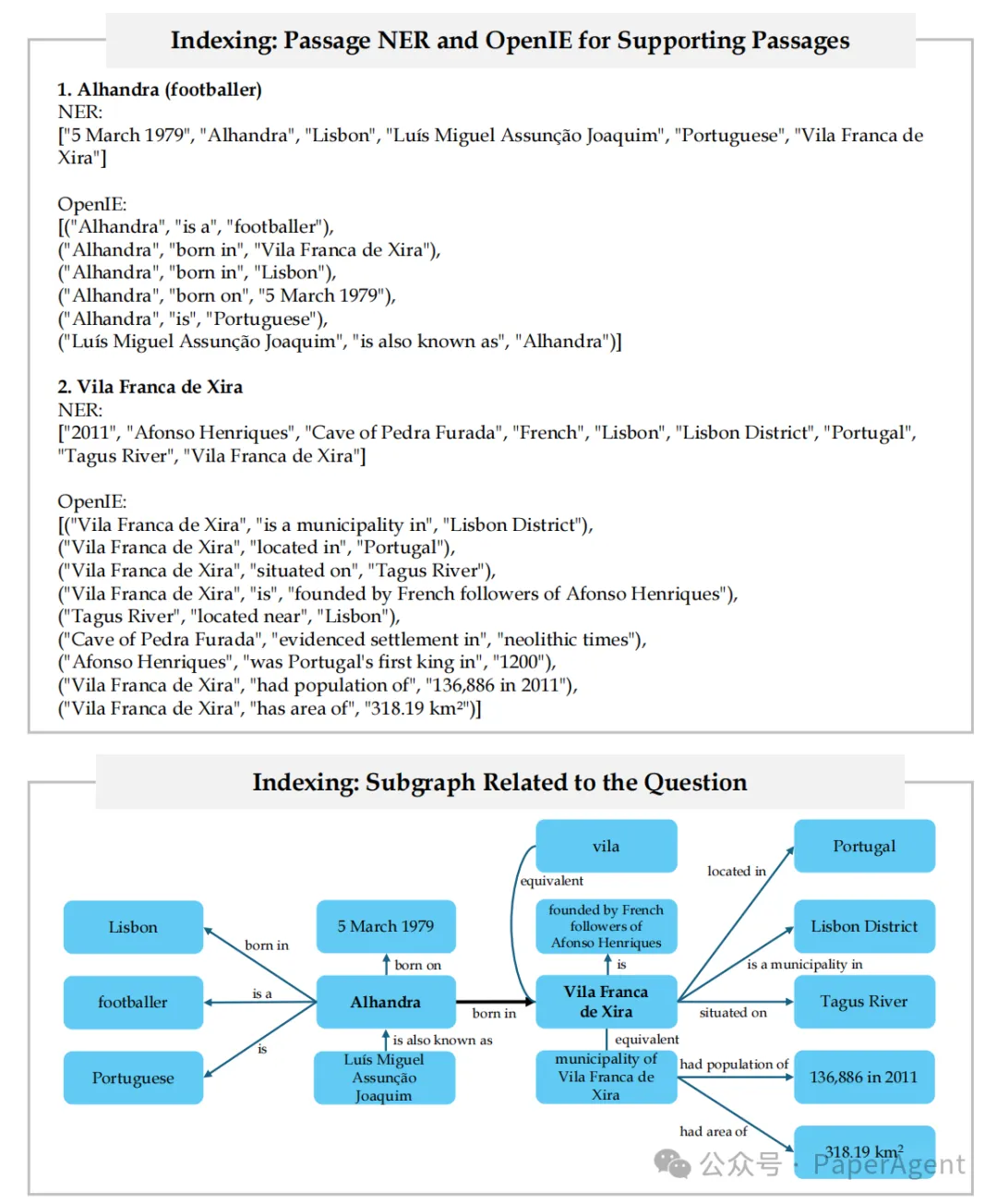

图4:HippoRAG流程示例(索引)。对语料库中的每个段落依次进行命名实体识别(NER)和开放信息抽取(OpenIE)。因此,为整个语料库形成了一个开放的知识图谱。只展示了知识图谱(KG)中与此相关的子图。

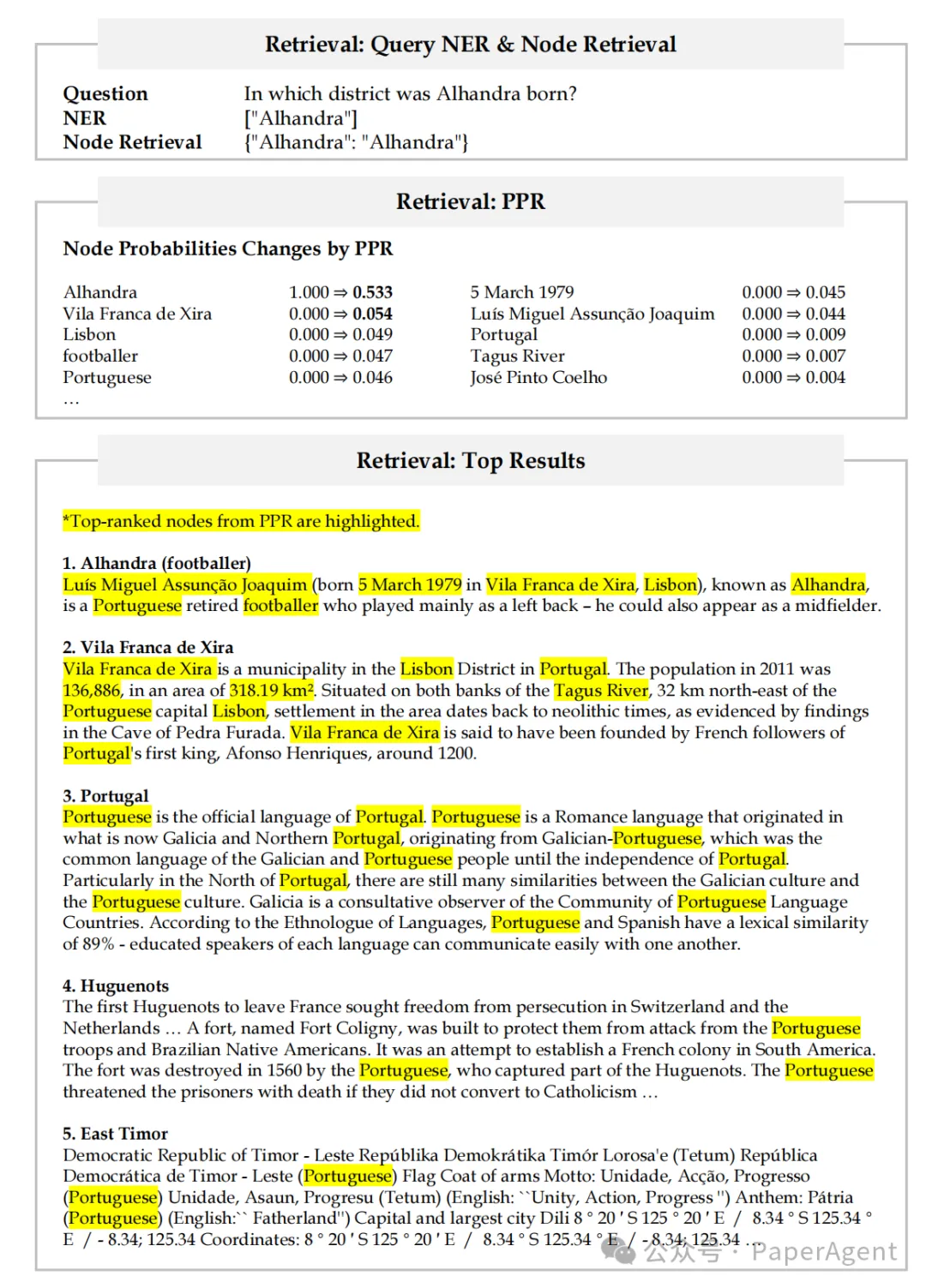

图5:HippoRAG流程示例(检索)。在检索过程中,首先从问题中提取查询的命名实体(顶部),然后使用检索编码器选择查询节点。在本例中,查询命名实体的名称“Alhandra”与其知识图谱(KG)中的节点相对应。(中间)然后我们根据检索到的查询节点设置PPR的个性化概率。PPR运行后,查询节点的概率根据图4中的子图进行分配,导致一些概率质量落在节点“Vila France de Xira”上。(底部)然后,这些节点概率被加总到它们出现的段落上,以获得段落级别的排名。PPR后排名最高的节点在排名最高的段落中被突出显示。

本文转载自PaperAgent,作者: PaperAgent