AI诗人来了!斯坦福和微软联手,用大型语言模型优化诗歌创作 精华

探索大型语言模型(LLMs)在文本空间优化问题中的潜力

在现代人工智能的研究与应用中,大型语言模型(Large Language Models,简称LLMs)已经显示出其在处理复杂语言任务中的强大能力。从生成文本、理解文档到执行代码,LLMs的应用范围日益扩大。然而,除了这些生成性任务外,LLMs在优化问题中的应用也开始受到关注。特别是在文本空间的优化问题上,LLMs展现出了独特的潜力。

本文旨在探讨LLMs在文本空间优化问题中的应用潜力,尤其是在接收方向性反馈(directional feedback)时的表现。通过实验研究,我们发现LLMs能够在提供方向性反馈的情况下,有效地优化各种问题,从数学函数的最大化到诗歌创作的优化。这一发现不仅拓宽了我们对LLMs能力的理解,也为未来在更广泛的优化问题中应用LLMs提供了可能性。

论文标题: The Importance of Directional Feedback for LLM-based Optimizers

机构: Stanford University, Microsoft Research

论文链接:https://arxiv.org/pdf/2405.16434.pdf

项目地址:https://github.com/microsoft/LLF-Bench

理解方向性反馈与非方向性反馈

1. 方向性反馈的定义及其在优化中的作用

方向性反馈是一种在优化过程中提供明确改进方向的信息。这种反馈可以被视为自然语言空间中一阶反馈的一种泛化。例如,当用户反馈说“这咖啡对我来说太热了”,这实际上是在指示优化器(在这个例子中是服务员)应该提供一个更凉快的咖啡。这种反馈直接指明了改进的方向,类似于数值优化中的梯度信息,使得优化过程更加高效和目标明确。

2. 非方向性反馈的角色和限制

非方向性反馈提供的信息虽然有用,但不具体指明如何调整输入以改善输出。例如,反馈“这咖啡的温度不太对劲”告诉我们温度是关键因素,但没有指明是应该更热还是更冷。这类反馈虽然能够帮助识别问题领域,但在没有额外信息的情况下,其在指导具体操作方面的作用有限。这种反馈更多地依赖于试错方法,如进化搜索或贝叶斯优化,这些方法通常效率较低,因为它们不能直接利用反馈信息来指导搜索方向。

LLM优化器的设计与实现

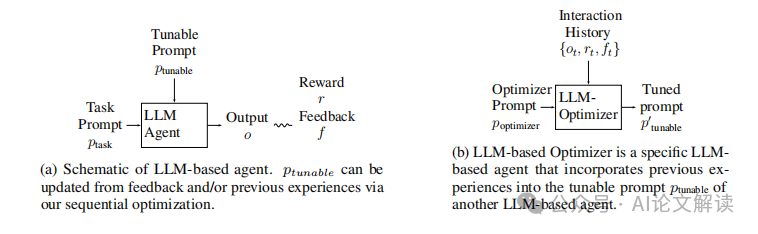

1. 优化器的基本构架与工作流程

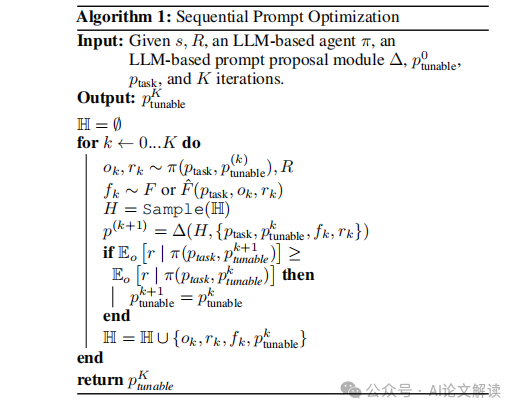

LLM优化器是一种基于大型语言模型的优化工具,它通过收集输出-奖励-反馈元组来改进生成的提示,从而提高期望奖励。这种优化器利用历史数据来调整可调参数(ptunable),以此来优化后续的输出。优化器的工作流程包括接收任务描述、生成输出、评估反馈和奖励,然后基于这些信息更新可调参数,循环进行直到达到优化目标。

2. 如何利用历史优化痕迹合成方向性反馈

在没有直接方向性反馈的情况下,LLM优化器可以通过分析历史优化痕迹来“合成”方向性反馈。这一过程涉及到从过去的输出和奖励中提取信息,以推断出改进的方向。例如,通过比较不同的输入和对应的输出结果,优化器可以学习到哪些变化能够导致性能提升,从而在未来的迭代中引导优化方向。这种方法虽然不如直接的方向性反馈那样直接有效,但在缺乏明确反馈的情况下,仍然可以显著提高优化效率。

实验设置与优化任务

1. 数学函数优化

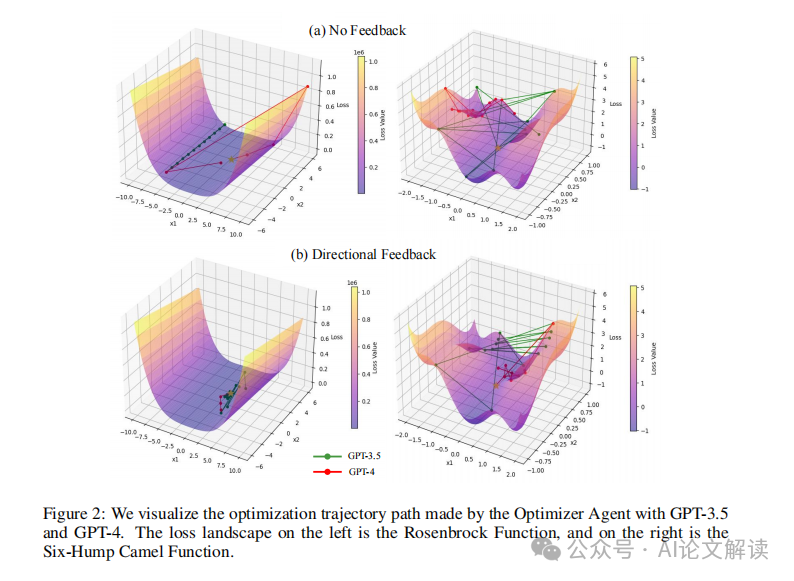

在数学函数优化的实验中,我们设置了一个具体的任务,即最小化一个数学函数。我们选择了几个经典的优化问题,如Booth函数、McCormick函数、Rosenbrock函数和Six-Hump Camel函数。这些函数的选择是因为它们的最小值不是在[0, 0]点,这为优化提供了挑战。实验中,我们使用了一个基于LLM的优化器,该优化器通过历史反馈来改进搜索方向。我们还设计了一个反馈合成模块,用于从模型输出和奖励中合成反馈,以改进下一次输出。

2. 诗歌生成优化

在诗歌生成的优化任务中,我们创建了一个合成的诗歌写作环境,其中LLM需要根据给定的约束生成诗歌。这些约束可能包括每行的音节数。我们的目标是优化一个提示(prompt),使得另一个基于LLM的代理能够生成满足约束的诗歌。我们设置了不同的任务,例如生成包含7、8、9或10个音节的诗行。我们的优化算法确保提示的选择能够单调地提高策略性能。

实验结果与分析

1. 数值优化实验的结果

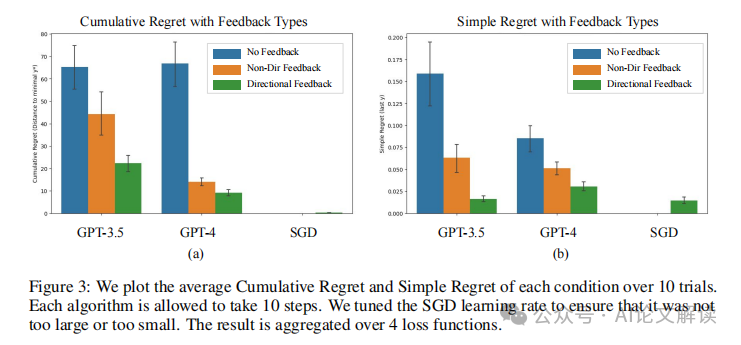

在数值优化实验中,我们观察到LLM作为优化器,在有反馈的情况下能够更好地理解历史信息,并提出改进的解决方案。尽管没有明确的梯度计算,LLM能够基于历史观察“改进”。我们比较了使用GPT-3.5和GPT-4的模型,并发现GPT-4在理解历史和制定新提议方面表现更好。此外,我们的反馈合成模块能够从历史输出和奖励中合成反馈,指导优化器找到更好的解决方案。在没有反馈的设置中,合成的反馈能够显著提高性能。

2. 诗歌生成任务的优化效果

在诗歌生成任务的优化实验中,我们的算法能够可靠地选择改进策略性能的提示。与Reflexion代理相比,我们的算法在每次交互后都能保证性能的提升。这一结果突出了方向性反馈在文本优化任务中的重要性。通过优化提示,我们能够有效地控制LLM产生的输出,从而满足特定的文本约束,如音节数限制。

这些实验结果表明,无论是在数学函数优化还是诗歌生成任务中,方向性反馈都是LLM基优化过程中的关键因素。通过利用环境提供的或合成的反馈,LLM能够在各种优化场景中表现出更好的稳定性和效率。

讨论:LLM基于反馈的优化潜力与挑战

1. 反馈类型对优化效果的影响

在LLM的优化过程中,反馈类型起着决定性的作用。研究表明,当LLM接收到方向性反馈时,其优化能力显著提高。方向性反馈,如其名,提供了明确的改进方向,类似于数值优化中的梯度信息。例如,在优化诗歌生成任务时,如果反馈是“增加第一行的音节数”,这将直接指导LLM调整其输出以满足特定的约束条件。

相比之下,非方向性反馈虽然包含有用信息,但不指明具体的改进方向。例如,反馈可能仅表明“诗的韵律需要改进”,而没有具体说明应如何调整。这种类型的反馈虽然有助于指出问题领域,但在指导具体优化行动方面不如方向性反馈有效。

2. LLM优化器在不同设置下的表现

LLM优化器在不同的应用场景下展现出不同的表现。在数值优化任务中,即使没有明确的方向性反馈,LLM也能通过历史数据推断出优化方向。例如,在优化特定数学函数时,通过分析历史输入和输出,LLM能够提出改进的建议,逐步接近最优解。

在文本生成任务,如诗歌创作中,方向性反馈的重要性更加凸显。通过程序化地生成反馈,如指定音节数或韵律结构,LLM能够更有效地调整其生成策略,以产生满足特定要求的文本。

结论与未来工作方向

1. 方向性反馈在LLM优化中的重要性

本研究强调了方向性反馈在LLM基于优化过程中的核心作用。无论是在数值优化还是文本生成任务中,方向性反馈都极大地提高了优化效率和效果。这种反馈提供了明确的改进方向,使LLM能够有效地调整其策略,以达到更好的优化结果。

2. 探索新的方向性反馈生成方法的可能性

鉴于方向性反馈的显著效果,未来的研究可以探索新的方法来生成更有效的方向性反馈。这可能包括开发新的算法来自动识别和提取任务相关的关键信息,或者改进现有的反馈合成模块,使其能够在更广泛的应用场景中生成实用的方向性反馈。此外,研究如何在没有明确外部反馈的情况下,利用LLM自身的输出历史来生成内部反馈,也是一个有价值的方向。这些努力将进一步拓宽LLM在各种优化任务中的应用潜力。

本文转载自 AI论文解读,作者:柏企