大模型是否是通往AGI?李飞飞、Yann LeCun vs Hinton、Ilya Sutskever

近一年多,依赖大模型技术,让人们燃起来对AI的新憧憬。

关于大模型是否有意识,依靠大模型是否能够构建“世界模型”,一直有很大的争论。

从信仰上来看,分为两大阵营。一种是大模型的反对派,他们认为大模型是鹦鹉学舌,根本不懂的自己在说什么,也没有人那样的创造力,想通过大模型通向AGI是误入歧途。这个阵营代表为Yann LeCun、李飞飞。

虽然LeCun作为MetaAI首席科学家,Meta也发布了Llama系列大模型,但他却在不同场合表达了对大语言模型的不屑,他认为LLM本质上只是自回归文本生成模型,它们只能非常粗浅地理解世界,并且捕获的只是文本的统计规律,无法真正理解文本在现实世界中所代表的含义,甚至曾公开表示5年内GPT就将被抛弃,利用大模型技术连一只猫的智能都达不到。

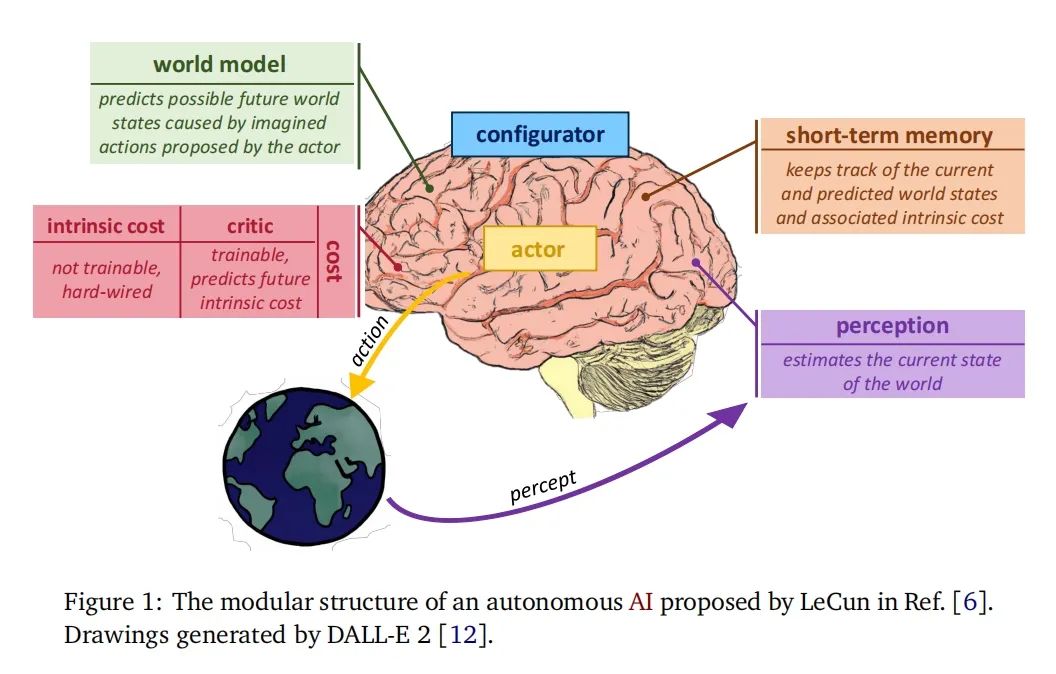

LeCun同时提出了自己解决方法,他认为要想让AI接近人类水平,其需要像婴儿一样学习世界如何运作。由此,他提出了“世界模型”的概念,解决方案即为JEPA(联合嵌入预测架构)。

JEPA通过一系列的编码器提取世界状态的抽象表示,并使用不同层次的世界模型预测器,来预测世界的不同状态,并在不同的时间尺度上做出预测。所有复杂的任务都可以通过“分层”的方式完成,他曾举了一个例子:我想从纽约前往北京,第一件事是去机场,第二件事是乘去往北京的飞机,最终的代价函数(cost function)可以表示从纽约到北京的距离。那么我该如何去机场?解决方案是把任务分解到毫秒级,通过毫秒级的控制来找到预测成本最小的行动序列。显然层次规划是最大的挑战,所谓“失之毫厘,差之千里”,其计算量和误差累积都将是JEPA的大麻烦。

而李飞飞也在一些场合表达了大模型并不是通往AGI的正路。她曾态度坚决的表示AI没有知觉,LeCun也转发了盟友的X。

她表示当前没有发现大模型具有意识,在未来的ChatGPT版本中也不可能出现。

而与之战在对立面的支持大模型是有可能通向AGI的支持派,他们表达的观点相对温和务实,某种意义上讲,他们是在不断实践自己的设想,并且已经取得了一定的成就。他们的代表人物是Hinton以及其爱徒ChatGPT之父Ilya。

Hinton在最近一个与Joel Hellermark的访谈里表示,在过去他们通过生理或者哲学层面理解人类智能并模拟制造AGI是不可行的,AGI表现的智能实现或许是另一种方式。

他相信他的学生ilya的判断。而ilya在他学生时代就凭着自己超人的直觉相信,大模型不简单只是学习文字符号概率,而是可以学习到自然规律,具备一定的推理能力,因为为了预测下一个符号,它必须进行一些推理。就从实际情况看,即使你不加入任何特殊的推理元素,仅仅是制造出大的模型,它们也已经可以进行一些推理了。随着大模型被做得更大时,它们就能进行更多的推理,甚至非常有创造力。Hinton利用一个例子来体现大模型甚至拥有超越人类的类比思维,而不是简单重复自己之前预训练学习过的内容。

比如讯问 GPT-4,为什么堆肥堆像原子弹?大多数人回答不出来。大多数人没有想过,他们会认为原子弹和堆肥堆是非常不同的东西。但 GPT-4 会告诉你,它们的能量规模非常不同,时间规模非常不同。但它们的共同点是,当堆肥堆变得更热时,它产生热量的速度更快;当原子弹产生更多的中子时,它产生中子的速度也更快。所以这就得到了连锁反应的概念。

大模型似乎理解这两种连锁反应,并使用这种理解将所有这些信息压缩到它的权重中。如果它确实在这样做,那么它将会对我们还没有看到的所有事物进行同样的操作。这就是创造力的来源 —— 看到这些表面上截然不同的事物之间的类比关系。

Hinton在采访时表示,大脑认知实际上采用了和大模型一样的处理逻辑。即大脑将这些符号转换为嵌入,并使用多层嵌入,因而大脑将得到非常丰富的嵌入。而嵌入仍然与符号相关联,从这个意义上讲,符号有其对应的大向量。这些向量相互作用产生下一个词的符号的向量。因此理解是指知道如何将符号转换为向量,以及向量的元素如何相互作用以预测下一个符号的向量。人们曾认为符号处理只是简单地匹配符号,一个符号只有一个属性:要么与另一个符号相同,要么不相同。实际并不是这样,而是利用上下文为符号提供嵌入向量,然后利用这些嵌入向量的组件之间的相互作用来进行思考。

Hinton甚至表示,大模型也可以拥有情感。但不一定是人类理解的样子,而意识应该是我们在没有外界限制的情况下可能会采取的行动,例如,1973 年在爱丁堡,他见过一个机器人表现出情感。这个机器人有两个抓手,可以在绿色毛毡上组装玩具汽车,只要将零件分开放置。但如果你把零件堆在一起,由于它的视觉系统不够好,无法分辨情况,它会显得困惑并将零件击散,然后再进行组装。如果这种行为发生在人类身上,可能会认为他因为不理解情况而感到恼怒,并因此摧毁了它。

Ilya自己也多次表示,大语言模型学习的不仅仅是文字概率,而是世界模型,并且曾经暗示大模型已经拥有意识。

未来谁可能是正确的?现下还难有明确结论。但笔者想说,想要打造最快的交通工具,不一定非要有四个轮子,想要打造AGI,也不见得要和人类完全一样,关键是我们能做的,它们是否能做,无需关注黑盒本身。

参考:https://mp.weixin.qq.com/s/OydltjpVwsQ7hNBH6hq_Og