OpenAI前CTO Ilya推荐的30篇文章,认真读完将理解当下90%的AI技术(12-27)

近日,网上流传一份ilya推荐给John Carmack的阅读清单,该清单包含了当今与AI相关27篇顶级文章,并称如果真的将它们读完,就能理解当下90%的AI技术。

下面剩余的文章速览。

12)Deep Residual Learning for Image Recognition(深度残差学习的图像识别)

何凯明的大作,2016年CVPR最佳论文,深入浅出地描述了深度残差学习框架,大幅降低了训练更深层次神经网络的难度,也使准确率得到显著提升。

训练更深层的神经网络通常会面临更多挑战。为了解决这一难题,作者提出了一种残差学习框架,目的在于简化比以往使用的网络深度更大的网络的训练过程。作者将每个层转化为学习相对于其输入的残差函数,而非学习没有参考基准的函数。作者提供了充分的实验证据证明,这些残差网络更易于优化,并能从显著增加的深度中获得准确度的提升。作者在ImageNet数据集上评估了最高达152层深的残差网络——比VGG网络深8倍,但复杂度却更低。一组这样的残差网络在ImageNet测试数据集上实现了3.57%的错误率,并凭借此成绩获得了ILSVRC 2015分类任务的冠军。作者也对CIFAR-10进行了100层和1000层的残差网络分析。在许多视觉识别任务中,深度的表示至关重要。正是由于作者极其深入的表示方法,作者在COCO物体检测数据集上实现了28%的相对性能提升。这些深层的残差网络构成了作者参加ILSVRC & COCO 2015比赛方案的基础,作者在ImageNet检测、ImageNet定位、COCO检测和COCO分割等项目上均获得了第一名。

地址:https://arxiv.org/pdf/1512.03385

13)MULTI-SCALE CONTEXT AGGREGATION BY DILATED CONVOLUTIONS(通过膨胀卷积进行多层次的上下文聚合)

最先进的语义分割模型是基于卷积网络的适应性,而卷积网络最初是为图像分类而设计的。但是,语义分割这类密集预测问题的结构与图像分类有显著差异。在本项研究中,我们开发了一种全新的卷积网络模块,这个模块是为密集预测任务量身打造的。这一模块采用扩张卷积,能够在不降低图像分辨率的情况下,有效地整合多尺度的上下文信息。这种架构利用扩张卷积在保持原有分辨率和覆盖范围的同时,实现感受野的快速扩展。论文的结果证明了引入的上下文模块提升了现有语义分割系统的准确度。此外,我们还探讨了图像分类网络向密集预测任务的转变,并发现简化这些调整后的网络能进一步提高其准确度。

地址:https://arxiv.org/pdf/1511.07122

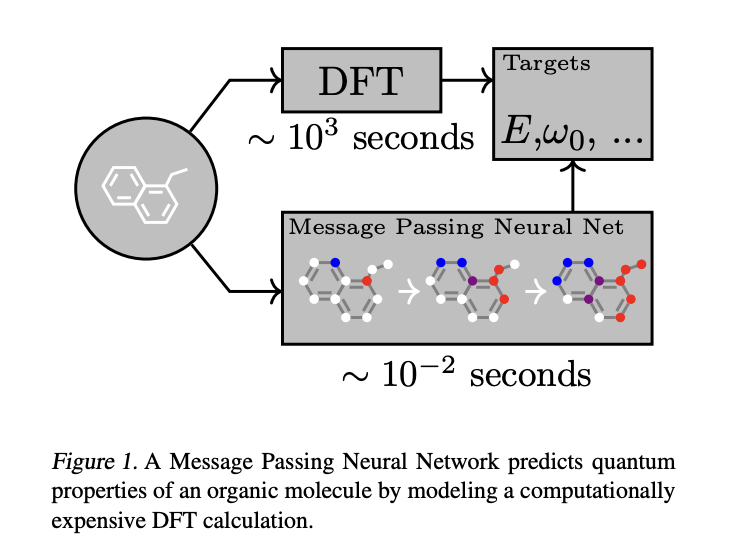

14)Neural Message Passing for Quantum Chemistry(量子化学中的神经消息传递)

论文总结整理了现有的几种作者认为最具前景的适用于图结构数据的神经网络模型。提出一种针对图数据结构的监督学习的通用框架,称为消息传递的神经网络(Message Passing Neural Networks ,MPNNs)。

地址:https://arxiv.org/pdf/1704.01212

15)NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE(神经机器翻译的对齐与翻译联合学习)

这篇论文由 Bahdanau et al. 在 2014 年发表在国际会议 ICLR 上,是神经机器翻译领域的开创性工作之一,提出了一种新颖的模型结构和训练方法,使得神经网络可以在翻译过程中自动搜索和选择源语言句子中与目标语言单词相关的部分,并生成对齐结果。这种方法不仅提高了翻译质量,而且产生了符合直觉的对齐结果。

地址:https://arxiv.org/pdf/1409.0473

16)Identity Mappings in Deep Residual Networks(深度残差网络中的恒等映射)

作者为残差网络的发明者何凯明博士,这一篇文章于同年投于2016 ECCV,深度残差网络已经崭露头角,成为一个深度架构家族,这个家族以其准确性和收敛性能吸引了人们的眼球。在这篇文章中,作者分析了构成残差块背后的传播机制,这些分析表明,当使用恒等映射作为跳连(skip connetions ),并且在加法后加入激活函数时,前向和反向的信息传递可以直接从一个块到达任何其他的块。一系列的对比实验证明了这些身份映射的重要性。这促使提出一个新的残差单元,这个单元使得训练过程更简单,并且改善了模型的泛化能力。使用 1001 层的残差网络 (ResNet) 在 CIFAR-10 数据集(错误率为 4.62%)和 CIFAR-100 数据集上取得了更好的效果,同时作者也在 ImageNet 数据集上使用 200 层的 ResNet 模型获得了改善的结果。

地址:https://arxiv.org/pdf/1603.05027

17)A simple neural network module for relational reasoning(一种用于关系推理的简单神经网络模块)

为了更深入地探索关系推理的思想,并测试这种能力能否轻松加入目前已有的系统,DeepMind 的研究者们开发了一种简单、即插即用的 RN 模块,它可以加载到目前已有的神经网络架构中。具备 RN 模块的神经网络具有处理非结构化输入的能力(如一张图片或一组语句),同时推理出事物其后隐藏的关系。

关系推理是通常智能行为的中心环节,但神经网络要掌握这一能力历来面临挑战。在本文中,作者展示了如何利用关系网络 (RNs) 作为一种简便的模块,针对根本上需要关系推理的难题实现解决方案。作者将增强了 RN 的网络应用于三大任务:第一个是使用一个挑战性的数据集 CLEVR 来进行视觉问题解答,在哪里作者达到了超过人类表现的最先进水平;第二个是利用 bAbI 任务组合来进行文本问题解答;第三个任务是对动态物理系统进行复杂的推理分析。接着,作者用一个叫 Sort-of-CLEVR 的专门数据集来展示,尽管传统的卷积网络在解决关系型问题上并不擅长,但通过与 RN 的结合就能够解锁这项能力。作者的研究说明,一个自带 RN 模块的深度学习框架能如何隐式地识别并学习对实体及其关系进行推理。

地址:https://arxiv.org/pdf/1706.01427

18)VARIATIONAL LOSSY AUTOENCODER(变分有损自编码器)

这篇论文成功地将自回归模型和VAE模型结合起来,实现了生成任务。自回归模型由于其强大的递归能力,能够学习到数据的全局特征,拟合复杂的潜在分布。但是,VAE的训练目标是高精度的密度估计(最大似然),这会导致VAE在训练时为了有效拟合而忽略了一些潜在的表示(解码时没有用到全部编码器给出的潜在表示)。论文从比特反转编码的角度分析了VAE网络在面对复杂数据分布和灵活先验分布时,容易出现潜在编码z没有被完全用于解码的情况(也就是条件分布大多数直接被正则化项搞成接近先验分布,只有少数被用于解码,输出数据和原始数据差异却不大),并在此基础上提出了VLAE网络。

地址:https://arxiv.org/pdf/1611.02731

19)Relational recurrent neural networks(关系性循环神经网络)

DeepMind和伦敦大学学院的这篇论文提出关系推理模块RMC,能够在序列信息中执行关系推理,在WikiText-103, Project Gutenberg 和 GigaWord 数据集上达到了当前最佳性能。

基于记忆的神经网络模型利用其长时间保存信息的功能来处理时间序列数据。但是,目前还不明确这些网络是否具备利用记忆执行复杂关系推理的能力。首先,验证了一个观点:标准的记忆结构在需要深刻理解实体间连接方式的任务上,也就是涉及关系推理的任务,可能会面临挑战。为了克服这些缺陷,引入了一种新型的记忆模块——关系记忆核心(Relational Memory Core, RMC),该模块使用多头点积注意力机制使得不同记忆间能够进行互动。最后,作者在一系列能够从更加精细的关系推理中获益的任务上测试了RMC,包括RL领域(如 Mini PacMan)、程序评估和语言模型等任务,并获得显著提升,在WikiText-103、Project Gutenberg 和 GigaWord 数据集上取得了前所未有的成果。

地址:https://arxiv.org/pdf/1806.01822

20)Quantifying the Rise and Fall of Complexity in Closed Systems: The Coffee Automaton(量化封闭系统中复杂性的升降:咖啡自动机)

与单调递增的熵不同,封闭系统的“复杂性”或“兴趣度”直观上呈现先增加后减少的趋势,特别是当系统接近平衡状态时。举个例子,在大爆炸期间我们的宇宙缺乏复杂结构,当黑洞蒸发和粒子分散之后也是如此。本篇论文首次尝试对这一模式进行度量。作者选用了一个简单的二维细胞自动机模型来模拟两种液体(“咖啡”与“奶油”)的混合过程。然后,作为一个合理的复杂性衡量方法,我们据此提出了自动机状态的粗糙度近似的“Kolmogorov复杂度”,命名为“结构复杂性”。我们研究了这种复杂性衡量方法,并通过分析展示,如果液体粒子不相互作用,其复杂性将不会显著增加。相反,如果粒子相互作用,我们通过数值证据展示,复杂性会达到一个最大值,与“咖啡杯”的横向尺寸大致相当。作者提出了一个挑战,即解析性证明这种行为的存在。

地址:https://arxiv.org/pdf/1405.6903

延伸阅读:美与结构的复杂性(https://zhuanlan.zhihu.com/p/87743946)

21)Neural Turing Machines(神经图灵机)

神经图灵机(Neural Turing Machines)是一种结合了神经网络和图灵机概念的深度学习算法。论文中作者增强了神经网络的能力,使其能与外部存储资源结合,通过注意力机制进行互动。这样的系统与图灵机或冯·诺伊曼架构有类似之处,但整个系统可进行端到端的微分,这意味着可以用梯度下降法有效训练。初步研究结果显示,神经图灵机能够根据给定的输入输出样例推导出一些简单的算法,比如复制、排序和关联记忆。

地址:https://arxiv.org/pdf/1410.5401

22)Deep Speech 2: End-to-End Speech Recognition in English and Mandarin( 英语与普通话的端到端语音识别)

该论文由百度研究院硅谷人工智能实验室发表,作者展示了一个端到端的深度学习方法能够识别英语和普通话——两种迥然不同的语言。通过用神经网络取代了之前需要人工搭建的复杂组件,端到端学习使作者得以处理各种各样的语音场景,包括噪声环境、不同的口音,以及多种语言。关键在于采用了高性能计算 (HPC) 技术,让系统速度比之前快了7倍 。得益于这种效率,原本需要几周才能完成的实验现在几天内就能搞定。这使得能够更迅速地试验,并找到更优秀的架构和算法。因此,系统在多种情况下可以在标准数据集基准上达到能与人类转录员媲美的水平。最后,通过在数据中心的 GPU 上使用一种叫做的 Batch Dispatch 的技术,这表明其系统可以并不昂贵地部署在网络上,并且能在为用户提供大规模服务时实现较低的延迟。

地址:https://arxiv.org/pdf/1512.02595.pdf

23)Scaling Laws for Neural Language Model(神经大语言模型的规模化定律)

OpenAI大模型经典论文,我们探究了影响语言模型在交叉熵损失方面性能的规律。根据我们的发现,模型的大小、所用数据集的范围以及训练所需的计算资源会影响损失情况,并且这种影响能在很大程度上(超过七个数量级)变动。而模型的网络宽度或深度等其他构造细节在较大的范围内的影响却微乎其微。作者还发现简单的公式可以描述模型或数据量大小如何影响过拟合程度,以及模型大小如何影响训练速度。借助这些关系,我们可以为有限的计算资源做出最优分配。更大的模型能够更有效地利用样本,因此,在有限的数据量上训练大型模型,并在模型完全拟合前提前停止,将是一种高效的计算方法。

其提出了两个核心结论:

1.LLM模型的性能主要与计算量C,模型参数量N和数据大小D三者相关,而与模型的具体结构 (层数/深度/宽度) 基本无关。三者满足: C ≈ 6ND

2.为了提升模型性能,模型参数量N和数据大小D需要同步放大,但模型和数据分别放大的比例还存在争议。

地址:https://arxiv.org/pdf/2001.08361

24)A Tutorial Introduction to the Minimum Description Length Principle(最小描述长度原则介绍)

该论文提供了最小描述长度(MDL)原则的教程介绍,MDL是一种用于模型选择和数据压缩的原则。

地址:https://arxiv.org/pdf/math/0406077

25)Machine Super Intelligence(机器超级智能)

DeepMind 联合创始人、首席科学家。他在 2008 年发表的博士论文,被认为是最早系统探讨机器超级智能(AGI)的学术文章之一,该论文为后续相关研究奠定了基础。他在对 80 种不同文化中的对“智能( Intelligence)”的研究基础上, 将“智能”总结为“能够在广泛的问题中表现优异的能力”,并给出了一套可工程化的量化标准。基于他的研究至少有了一个如何将人类智能总结、转化为算法结构的假设,智能成为了一个可被解决的问题。

地址:https://www.vetta.org/documents/Machine_Super_Intelligence.pdf

26)Kolmogorov Complexity and Algorithmic Randomness(Kolmogorov复杂性与算法随机性)

本书由American Mathematical Society出版,作者是A. Shen,V. A. Uspenskii,N. K. Vereshchagin。该书介绍了 Kolmogorov 复杂性理论及其在算法随机性中的应用,提供了对计算复杂性和随机性深入理解的理论基础。为了进行无监督学习,在OpenAI成立早期,他们认为通过压缩可以通向这一路径。随后,他们发现“预测下一个词元(token)”正是无监督学习可以追求的目标,并且意识到,预测就是压缩。这也正是后来ChatGPT成功的关键思想之一。

地址:https://www.lirmm.fr/~ashen/kolmbook-eng-scan.pdf

27)CS231n Convolutional Neural Networks for Visual Recognition(用于视觉识别的卷积神经网络)

地址:https://cs231n.github.io/

本文转载自 AI工程化,作者: ully