革新GUI自动化:V-Zen模型引领多模态语言模型新纪元 精华

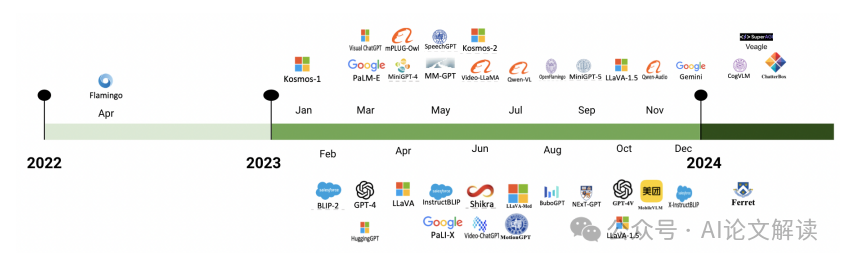

在人工智能领域不断发展的今天,多模态大型语言模型(MLLMs)已经成为一种变革性的力量,它们能够跨越不同数据表现形式的鸿沟,实现数据的理解和整合。这些模型擅长从多种模态(如文本和图像)中整合信息,显著扩展了研究和实际应用的范围。在这一领域内,一个关键的研究方向是图形用户界面(GUI)的任务自动化。GUI任务的自动化为提高各种应用的效率和生产力提供了巨大的潜力。然而,现有的模型和基准主要集中在基于文本的任务上,这种方法忽视了多模态代理有效处理和整合视觉信息以解决问题的巨大潜力。我们研究的主要推动力是这些模型的应用,特别强调在GUI图像上下文中的“着陆”概念。在MLLMs领域,着陆指的是将语言中的词语或短语与其他模态中的相应实体关联起来的过程。例如,在文本-图像配对中,“苹果”一词将与苹果的图像相对应。MLLMs在自动化GUI任务中有效且精确地进行着陆尤为关键。

论文标题、机构、论文链接

论文标题: IV-Zen: Efficient GUI Understanding and Precise Grounding With A Novel Multimodal LLM

机构: SuperAGI Research

论文链接: http://arxiv.org/pdf/2405.15341

本研究旨在通过开发一种能够有效导航、理解和与GUI元素高精度交互的多模态大型语言模型(MLLM),推动基于多模态代理的GUI任务自动化的边界。

V-Zen模型介绍

V-Zen是一种新型的多模态大型语言模型(MLLM),专为图形用户界面(GUI)的理解和精确定位而设计。它不仅仅是一个多模态语言模型,而是一个高级的GUI代理,能够准确处理图像和文本输入,解释自然语言指令,精确识别GUI元素,并在网站上执行操作以完成用户定义的目标。

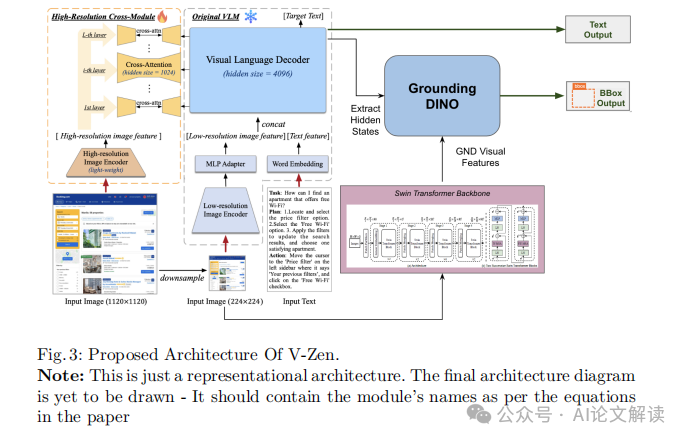

V-Zen的核心在于其视觉定位模块,该模块利用DINO检测器的功能,使其能够有效处理多模态定位任务。除了LLM的文本响应之外,定位模块还单独提供定位坐标,取代了典型的对象检测模块,从而确保坐标的精确性。此外,模型的性能通过高交叉分辨率模块(HRCM)得到进一步增强,该模块使模型能够处理高分辨率特征并理解图像中的文本。

为了推动基于代理的多模态GUI任务自动化的研究边界,我们还创建了一个名为GUIDE(Graphical User Interface Data for Execution)的数据集,这是一个前沿的基准数据集,包括跨各种GUI平台收集的边界框注释和带有思维链的文本描述。GUIDE数据集在推动代理研究方面起到了助推作用,最终导致了更灵活、响应更快、更类似于人的代理在多个领域的发展。

多模态融合与视觉理解

多模态融合是指在一个模型中整合来自不同数据源(如文本、图像、声音等)的信息的过程。在V-Zen模型中,这一过程尤为关键,因为它需要处理和理解来自GUI的图像和文本指令。V-Zen通过几个关键的技术模块来实现这一点:

1. 低分辨率视觉特征提取器(LRVFE):这一模块使用低分辨率编码器(如EVA-2-CLIP)处理输入图像,提取图像的关键特征,为后续的高级处理做准备。

2. 多模态投影适配器(MPA):此模块负责将从LRVFE提取的特征转换成适合LLM处理的格式,确保图像特征与文本模态能够在同一多模态嵌入空间中对齐。

3. 预训练的带视觉专家的语言模型(PLMVE):这一模块结合了视觉专家层和原始LLM层,用于生成基于处理后的图像特征和文本输入的文本输出。

4. 高分辨率交叉视觉模块(HRCVM):灵感来自于CogAgent,设计用于处理更高分辨率的输入,它使用更小的视觉编码器和交叉注意力机制,将高分辨率图像特征与PLMVE的每一层融合。

5. 高精度定位模块(HPGM):这一模块采用增强的DETR对象检测器(命名为DINO),从PLMVE中提取的隐藏状态用作视觉定位的查询,以精确地定位GUI元素。

通过这些模块的协同工作,V-Zen不仅能够理解GUI的视觉和文本信息,还能精确地执行定位任务,极大地提高了模型在真实世界应用中的实用性和效率。

精确定位与执行:高精度定位模块(HPGM)

在多模态大型语言模型(MLLM)的研究和应用中,精确地定位和执行任务是至关重要的一环。特别是在图形用户界面(GUI)自动化的背景下,高精度定位模块(HPGM)的作用尤为突出。HPGM不仅仅是一个普通的对象检测模块,它通过使用增强的DETR(名为DINO)对象检测器,能够以极高的精度输出边界框坐标。

这一模块的核心在于它如何处理和利用从预训练语言模型带有视觉专家(PLMVE)中提取的隐藏状态。这些隐藏状态被用作视觉定位的查询,与多尺度特征集进行交互,以精确地定位GUI元素。多尺度特征集是使用基于Swin Transformer的骨干网络获得的,这进一步增强了模型对图像中细微元素的识别能力。

通过这种方式,HPGM能够精确地识别和互动GUI元素,这对于提高自动化任务的效率和准确性至关重要。例如,在处理一个包含多个按钮和图标的复杂GUI界面时,HPGM能够准确地识别出用户指定的操作对象,从而有效地支持后续的自动化操作。

GUIDE数据集的构建与应用

GUIDE(Graphical User Interface Data for Execution)数据集是为了推动多模态大型语言模型(MLLM)在图形用户界面自动化领域的应用而特别设计的。这个数据集包含了124,000个数据点,涵盖了从Apollo.io到Gmail等多种GUI平台的用户交互。

每个数据条目都包含一个图像、一个任务描述、上一个动作和下一个要执行的动作,以及执行动作所需的定位信息。此外,数据集还包括了一个思维链(Chain of Thought),记录了之前的动作历史,这有助于模型在执行任务时进行上下文推理。

GUIDE数据集的构建使用了先进的注释工具NEXTAG(Next Action Grounding and Annotation Tool),并且适配了多种操作系统和浏览器。通过多个注释者的协作,数据集能够捕捉到不同设计风格和用户交互方式的多样性。

在实际应用中,GUIDE数据集支持跨界面的自动化任务研究,并鼓励开发能够在多平台上运行的MLLM。数据集的设计不仅仅是为了训练模型识别下一个任务,更重要的是能够准确执行与GUI元素(如按钮、图标等)的交互,这对于实现高效的GUI自动化至关重要。

实验设计与结果分析

1. 实验设计

在我们的研究中,实验的设计旨在验证多模态大型语言模型(MLLM)V-Zen在图形用户界面(GUI)任务自动化中的有效性。我们特别关注了两个核心任务:下一任务预测和元素定位(Grounding)。

为了进行这些实验,我们首先使用了GUIDE数据集,该数据集包括了124,000个数据点,涵盖了多种GUI环境中的用户交互。这些数据点不仅包括图像和任务描述,还包括了执行任务所需的具体动作和位置信息。

我们的模型V-Zen在两个阶段接受训练:预训练和特定任务的微调。预训练阶段,模型学习处理高分辨率图像并适应GUI应用,强调文本识别、视觉定位和理解GUI图像。微调阶段则使用GUIDE数据集,使模型能够学习复杂的工作流程和动作历史,从而在遇到新的GUI时,能够做出准确的推断和执行相关动作。

2. 结果分析

在下一任务预测方面,V-Zen的表现优于其他同类模型,如CogAgent、GPT-4V等。V-Zen在这一任务中的准确率达到了93.2%,这一结果表明V-Zen能够准确预测GUI环境中的后续任务,显示出其在实际应用中的潜力。

在元素定位任务中,V-Zen同样表现出色,其定位准确率达到了89.7%。这一成绩不仅展示了V-Zen在精确定位GUI元素方面的能力,也突显了其在GUI任务自动化中的实用性。

这些实验结果验证了V-Zen在GUI理解和任务执行方面的有效性,同时也展示了其在多模态大型语言模型领域中的先进性。

讨论与未来工作

1. 讨论

V-Zen模型的成功归功于其创新的架构,该架构有效地整合了低分辨率和高分辨率视觉模块、多模态投影适配器和高精度定位模块。这种设计使得V-Zen能够有效处理和整合视觉与文本信息,从而提升了其在GUI理解和定位任务中的表现。

此外,GUIDE数据集的使用为模型提供了丰富的训练资源,使V-Zen能够从复杂的工作流程和动作历史中学习,进一步增强了其处理实际GUI元素和任务序列的能力。

2. 未来工作

尽管V-Zen在多个方面表现出色,但仍有改进和扩展的空间。未来的工作将集中在以下几个方面:

- 性能提升:继续优化V-Zen的架构,提高其在各种GUI平台上的表现,尤其是在更复杂或未知的GUI环境中。

- 应用扩展:将V-Zen应用到更广泛的GUI平台和实际复杂性场景中,验证和提升其泛化能力。

- 数据集发展:扩展GUIDE数据集,包括更多种类的GUI环境和任务类型,以支持模型在更广泛应用中的训练和测试。

通过这些未来的研究工作,我们希望进一步推动多模态大型语言模型在GUI自动化领域的发展,为实现更智能、更自动的计算体验开辟新的可能。

总结:V-Zen在多模态大型语言模型中的创新应用及其对GUI自动化的贡献

在人工智能领域的快速发展中,多模态大型语言模型(MLLMs)已成为一种变革性的力量,它们能够跨越不同数据表示之间的鸿沟,实现信息的整合和理解。这些模型擅长从多种模态(如文本和图像)中整合信息,显著扩展了研究和实际应用的范围。在这一领域中,一个关键的研究方向是图形用户界面(GUI)任务的自动化。

1. V-Zen模型的创新设计

我们提出的模型V-Zen,不仅仅是一个MLLM,而是一个高级的GUI代理,能够准确处理图像-文本输入,解释自然语言指令,精确识别GUI元素,并在网站上执行动作以完成用户定义的目标。V-Zen集成了一个视觉接地模块,该模块利用DINO检测器的能力,有效地处理多模态接地任务。此外,该模型的性能通过高交叉分辨率模块(HRCM)进一步增强,该模块使模型能够处理高分辨率特征并理解图像中的文本。

2. GUIDE数据集的开发

为了推动基于代理的研究,我们还创建了一个名为GUIDE(Graphical User Interface Data for Execution)的数据集,这是一个前沿的基准数据集,包括跨各种GUI平台收集的边界框注释和带有思维链的文本描述。GUIDE数据集在提高模型性能方面发挥了关键作用,使V-Zen能够在执行多样化GUI平台上的任务时表现出色。

3. 实际应用和未来的研究方向

V-Zen在GUI自动化领域的应用展示了MLLMs在实际操作中的巨大潜力。通过精确地识别和与GUI元素交互,V-Zen不仅增强了这些代理的功能,还显著提高了它们在现实世界应用中的实用性。我们的研究目标是通过开发能够有效导航、理解和与GUI元素高精度交互的多模态大型语言模型,推动多模态代理基于GUI任务自动化的边界。

总之,V-Zen的引入标志着在多模态大型语言模型及其在GUI自动化中应用的一个重要进步。通过其创新的架构和强大的功能,V-Zen为未来的研究和开发奠定了坚实的基础,展望未来,我们预计将进一步提升V-Zen的性能,并扩展其适用于更广泛的GUI平台。

本文转载自 AI论文解读,作者:柏企