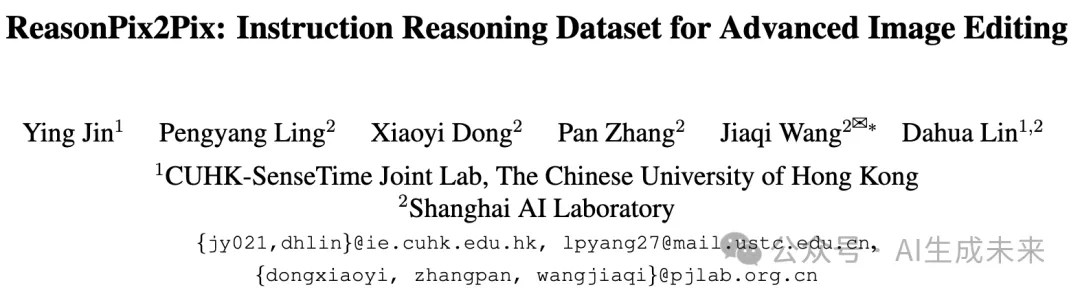

林达华团队最新发布ReasonPix2Pix:让基于指令的高级图像编辑效果飞升!

文章链接:https://arxiv.org/pdf/2405.11190

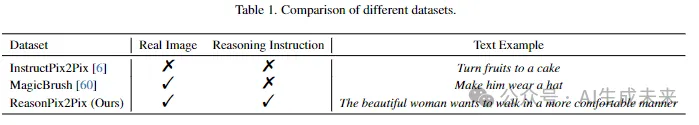

基于指令的图像编辑专注于使生成模型能够遵循人类书写的编辑图像指令。当前的方法通常能够理解明确且具体的指令。然而,它们往往在执行所需的主动推理能力上表现不足,无法很好地理解隐含或定义不足的指令。为了增强主动推理能力并赋予编辑模型智能性,本文引入了ReasonPix2Pix,一个综合性的推理注意指令编辑数据集。

该数据集的特点是:

- 包含推理指令

- 来自细粒度类别的更真实的图像

- 输入和编辑图像之间的更大差异

在监督条件下使用该数据集进行微调时,该模型在指令编辑任务中表现出优越的性能,无论这些任务是否需要推理。

介绍

基于指令的图像编辑旨在使生成模型具备遵循人类书写的编辑图像指令的能力,这对于促进AI生成内容(AIGC)系统理解人类意图至关重要。

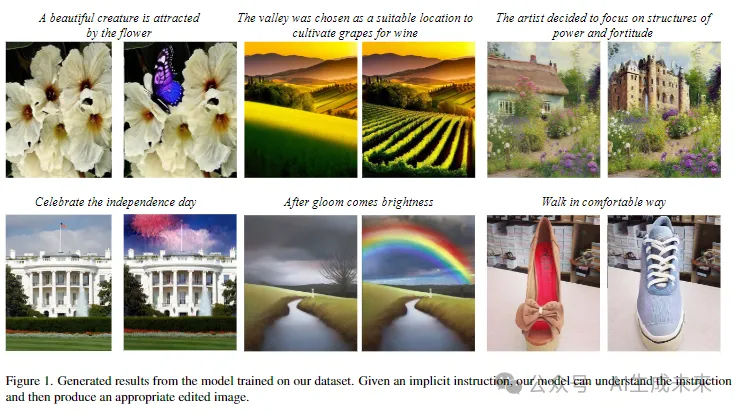

现有的基于指令的图像编辑框架通常能够理解明确且具体的指令,例如“将水果换成蛋糕”。不幸的是,这些模型在主动推理能力上表现不足,即理解指令的含义而不仅仅是从中提取词语。如下图2所示,一个典型的基于指令的图像编辑框架InstructPix2Pix未能实现“她更喜欢口罩而不是太阳镜”,却给女人添加了太阳镜,这是不合理的。

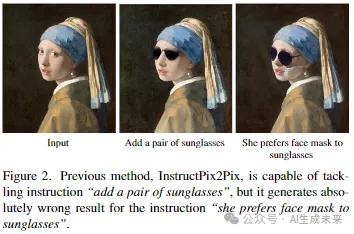

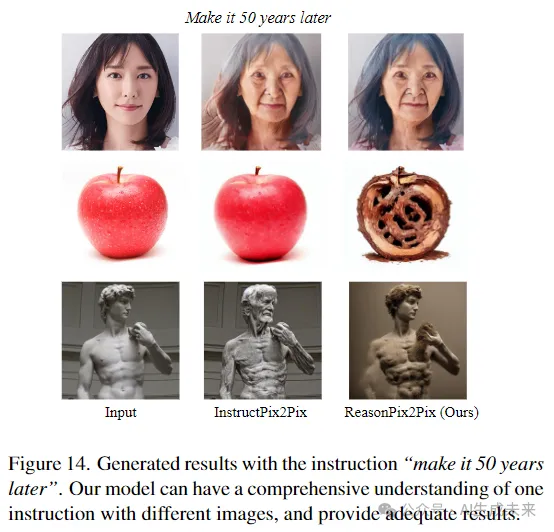

同时,该模型缺乏理解给定图像的能力。例如,对于一个简单明确的指令“让它变成50年后”,对于各种给定的图像,编辑结果应该是不同的。但是在下图3中,以前的方法只是简单地将人变老,甚至未能编辑图像,这是完全不正确的。

另一方面,这些方法也缺乏理解隐含或定义不足的指令的能力。这需要人工干预,将隐含指令变为明确指令,或将指令分解为多个明确、具体的指令,以符合这些模型的能力。

例如,指令“让房间整洁”需要手动分解为各种步骤,如“将散落的衣物整齐折叠”,“移除地上的垃圾”,以及“整理床单”等。同样,隐含指令“她是这场表演的明星”需要人为干预,将其明确为“在图像中添加一些闪光和聚光灯效果”。因此,增强自我推理能力不仅对用户更友好,而且是下一代智能AIGC系统发展的关键。

借助多模态大模型(MLLM)的生成模型在推理感知指令编辑方面的潜力是巨大的。然而,现有的用于指令编辑的数据集未能充分发挥和利用模型的内在推理能力。

因此,本文研究者们开发了一个综合性的推理注意指令编辑数据集ReasonPix2Pix,该数据集包含图像对及其相应的推理指令。ReasonPix2Pix的特点包括:

- 隐含指令以进一步增强模型的推理能力

- 来自细粒度类别的大量真实图像

- 输入图像和编辑后图像之间在几何层面上的显著差异。

在下表1中与之前的数据集进行了比较。

此外,将多模态大模型(MLLM)引入图像编辑模型,并在数据集上进行微调,从而增强图像编辑的推理能力,并显著提升指令编辑的质量。

贡献可以总结如下:

- 提出了基于指令推理的图像编辑任务,这是一项有趣的任务,旨在增强模型理解人类意图的智能。

- 开发了一个综合性的推理注意指令编辑数据集ReasonPix2Pix,该数据集包含图像对及其相应的推理指令。

- 在数据集上微调了一个简单的框架。即使在没有繁杂操作的情况下,该模型不仅在不需要推理的指令编辑任务中表现出色,而且在需要推理的任务中也表现良好。

相关工作

图像编辑 图像编辑是一个基础的计算机视觉任务,也可以看作是图像到图像的转换。在生成对抗网络(GAN)提出后,许多工作[13, 14, 19, 29, 35]被发明来解决这一任务。一类方法[1–3, 7, 10, 41, 50]将原始图像插入潜在空间,然后进行操作。这些方法被证明在转换图像风格、添加和移动图像中的对象方面是有效的。

最近,随着多模态学习的爆炸性发展,文本信息可以通过诸如CLIP之类的模型嵌入,然后作为图像编辑的指导。这些方法使模型能够根据给定的文本编辑图像。

扩散模型 扩散模型是最受欢迎的生成模型之一,在图像合成方面表现出色。通过扩散过程学习给定数据集的概率分布。最近,文本到图像的扩散模型,如Stable Diffusion,在将文本转换为高质量图像方面取得了巨大成功。

图像编辑的扩散模型一些扩散模型天生具备编辑图像的能力。然而,在实际应用中,这些模型显示出稳定性较差的问题(即在给定类似文本时生成类似的图像)。通过Prompt-to-Prompt在模型上施加约束,这个问题得到了缓解。与以往处理生成图像的方法不同,SDEdit通过加噪和去噪过程编辑真实图像。

图像修复可以看作是更精细的图像编辑。它通过从一小组训练样本中学习,将文本输入和用户绘制的masks转换为特定类别或风格的图像。InstructPix2Pix简化了生成过程,仅需要一个输入图像和一个指令来编辑图像,而不需要任何训练。它提出了一个大规模数据集,包含配对的图像和相应的指令。然而,它仅包含简单明了的指令,限制了其在复杂的现实场景中的应用。因此,本文构建了一个指令推理数据集,以改善图像编辑。

多模态大语言模型随着大语言模型(LLM)的快速发展,它们被扩展到更多的模态(如视觉),形成多模态大语言模型。BLIP-2和mPLUG-OWL引入了视觉编码器来嵌入图像,然后将它们与文本embeddings结合起来。Instruct-tuning被广泛采用,将LLM的能力转移到视觉领域。另一类工作使用提示工程,牺牲了端到端训练。多模态大语言模型在视觉任务中的应用被证明在基于视觉的任务和目标检测方面是有效的。

方法

本文的目标是根据人类指令进行图像编辑,特别强调推理指令。给定一个输入图像和一个人类指令,模型旨在理解人类的显性或隐性意图,并随后生成与提供的指令一致的输出图像。为了实现这一目标,本文引入了ReasonPix2Pix,一个专门针对基于指令的图像编辑并关注推理能力的数据集。以该数据集为基础训练数据,微调了一个包含多模态大语言模型与扩散模型的简单框架。

预备知识

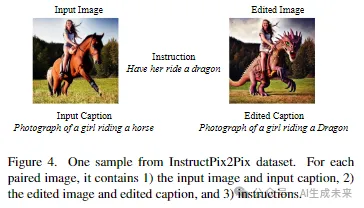

InstructPix2Pix数据集 InstructPix2Pix生成了一个重要的大规模配对数据集,以实现基于指令的图像编辑。具体地,如下图4所示

它包含:

- 输入图像t和输入标题

- 编辑后的图像和编辑后的标题

- 文本指令。

V3Det数据集 V3Det是一个庞大的检测数据集,包含13,204个类别,超过240,000张图像。图像看起来真实且复杂,开发了一个更通用的视觉感知系统。

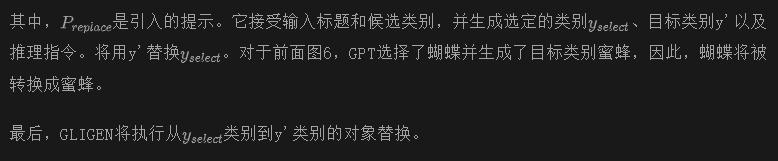

ReasonPix2Pix

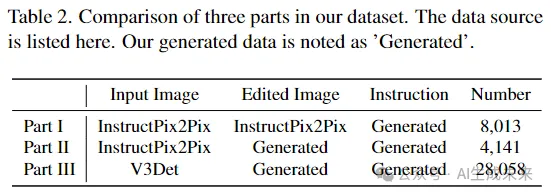

为了将推理能力注入图像编辑模型,研究者们构建了一个综合性的推理注意指令编辑数据集。根据生成过程,生成数据集可以分为三个部分。如表2所示:

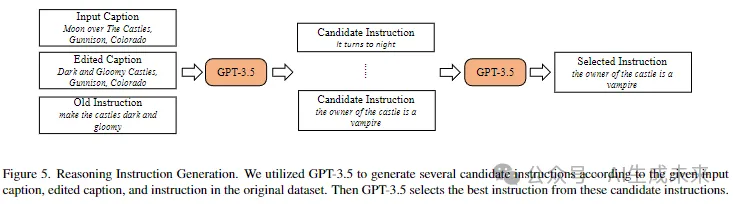

- Part I:使用InstructPix2Pix中的原始图像对,并生成指令以实现指令推理。

- Part II:从InstructPix2Pix的输入图像开始,生成自己的编辑图像和指令。

- Part III:从V3Det中获取更真实的图像,生成编辑后的图像和指令。

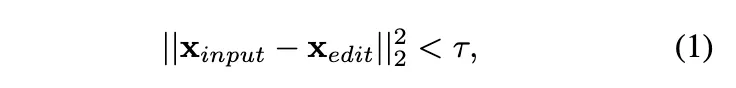

数据过滤尽管在基于指令的图像编辑中取得了巨大成功,InstructPix2Pix模型仍存在各种失败案例。一个典型的失败案例是模型倾向于输出原始图像,即不进行任何编辑。深入研究数据集,发现部分编辑后的图像与输入图像非常相似。因此,需要首先过滤这部分数据,通过以下方法区分它们:

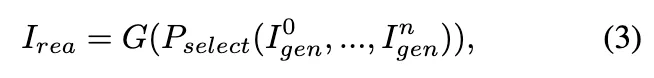

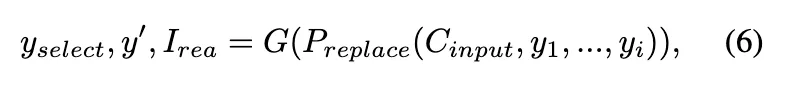

如下图5所示,将InstructPix2Pix数据集中的输入标题、编辑标题和原始指令输入GPT-3.5,并要求GPT-3.5生成候选指令。

然后,再次要求GPT-3.5从中区分出最佳指令。

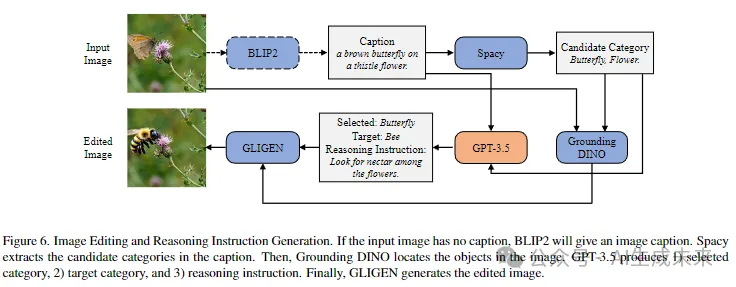

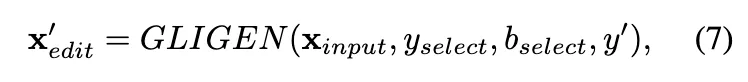

Part II & III:图像编辑和推理指令生成为了进一步提高模型的能力,研究者们扩展了数据集,加入了其他两部分数据。这些数据不仅增强了模型的推理能力,还旨在提升模型处理更真实的细粒度类别图像和输入与编辑图像之间更大差异的能力。

标题传递给Spacy模型S,这是一个先进的自然语言处理(NLP)模型,用于识别句子中的实体。在这里利用它来提取候选类别。

Spacy模型提取了i个候选类别。例如,在上面图6中,Spacy提取了i = 2个类别,即蝴蝶和花朵。

通过这些类别,可以使用Grounding DINO在图像中定位相应的物体。

然后将标题和候选类别注入到GPT-3.5中。在这里,设计了另一个提示,要求GPT-3.5输出

- 一个被选中的类别

- 需要用其替换的目标类别

- 推理指令。

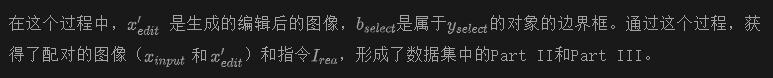

在这里展示了数据集的一些样本。从下图7可以看出,数据集具有复杂的推理指令(例如,“一家公司计划在清洁能源上开展新项目”),输入和编辑图像之间的变化更多,特别是在几何水平上,而且图像更加真实。

数据集利用

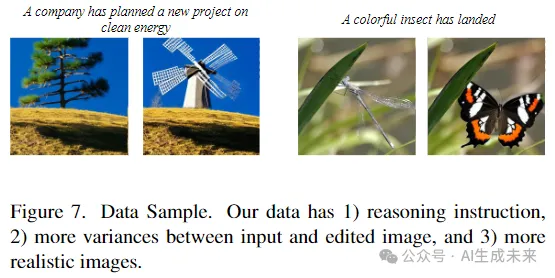

利用广泛模型来增强编辑模型的主动推理能力。具体来说,设计了一个简单的框架,将一个多模态大语言模型(MLLM)整合到扩散模型中,如下图8所示。

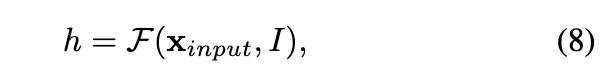

与以往仅通过文本理解人类意图的方法不同,MLLM通过结合指令和输入图像来增强理解能力。形式上,具有人类意图的指令特征h可以被公式化为

其中,F是MLLM。h是F的输出,包含了我们指令的多模态理解。

然后,可以无缝地将h注入到编辑模型中。图像生成模型可以在h的监督下编辑输入图像。

考虑到LLM中的大量参数,在对模型进行微调时将其固定。利用ReasonPix2Pix数据集,模型进行端到端的微调。

实验

实施细节

利用V3Det的测试数据构建了一个基准测试集,具体流程见前面图6,共有1000张图像。同时,记录了所选类别和目标新类别,因此可以通过多种模板制定简单的指令,例如“将A转换为B”。

因此,测试数据包括输入图像及其标题、真实编辑后的图像及其标题,以及直观指令和推理指令。分别在这些数据上评估了ReasonPix2Pix以及之前的方法。

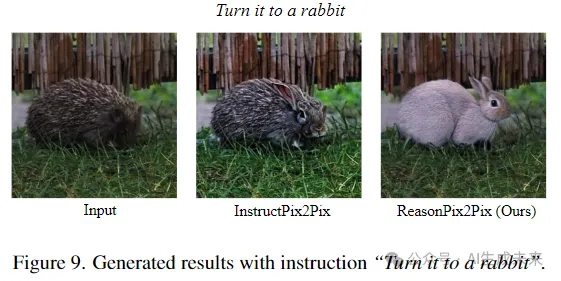

定性结果

图像质量 这里将本文的方法与之前的方法在简单指令下的表现进行了比较。如下图9所示,InstructPix2Pix未能将图像中的刺猬变成兔子。而ReasonPix2Pix能够转换这些复杂的类别,生成更生动的结果。

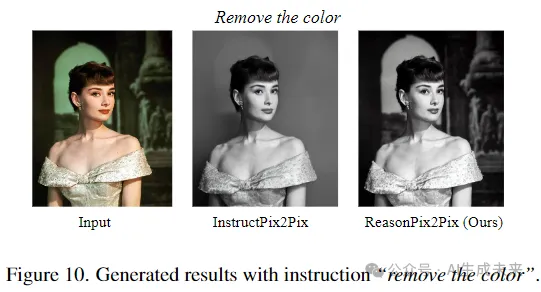

推理能力 为了比较推理能力,首先我们从相对简单的指令开始。如下图10所示,当指令是“去除颜色”时。之前的方法在一定程度上能够理解指令,但生成的结果不准确。

InstructPix2Pix遵循指令将图像转换为黑白,但也移除了背景。相反,ReasonPix2Pix理解了指令并给出了充分的结果。

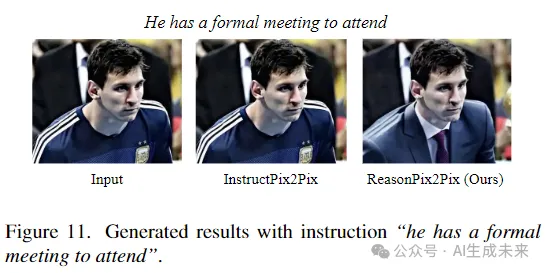

然后我们转移到更复杂的指令。如下图11所示,对于间接指令“他有一个正式会议要参加”,之前的InstructPix2Pix无法处理,输出了原始图像而没有进行任何编辑。ReasonPix2Pix能够理解指令,并让他穿着正式服装参加会议。

定量结果

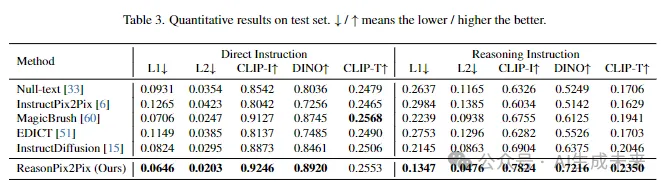

除了上述的定性结果之外,还将定量指标与之前的方法进行了比较,如下表3所示,分别使用直接指令和推理指令。我们报告了生成图像与真实图像之间的L1和L2距离,以及它们的CLIP和DINO嵌入之间的余弦距离。此外,还报告了CLIP-T,即目标标题的CLIP特征与生成图像之间的余弦相似度。

在传统的直接指令下,ReasonPix2Pix在之前的方法中取得了竞争性的表现,证明了生成的图像的质量。当涉及需要理解的推理指令时,之前的方法表现下降,但ReasonPix2Pix的结果远远高于其他方法。

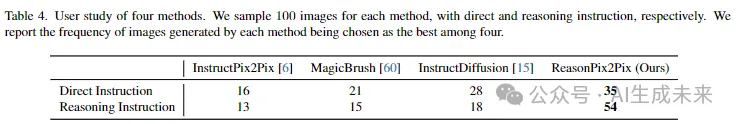

同时,研究者们还进行了用户研究,以比较ReasonPix2Pix与之前的方法。分别随机抽取了由不同模型生成的100个样本,并请5名工作者对它们进行评估(每人20个)。工作者被要求在4个候选项中选择最佳图像。从下表4中可以看出,在直接指令下,ReasonPix2Pix略优于之前的方法。当指令变为推理指令时,ReasonPix2Pix与之前的方法之间的差距变得更大。

分析

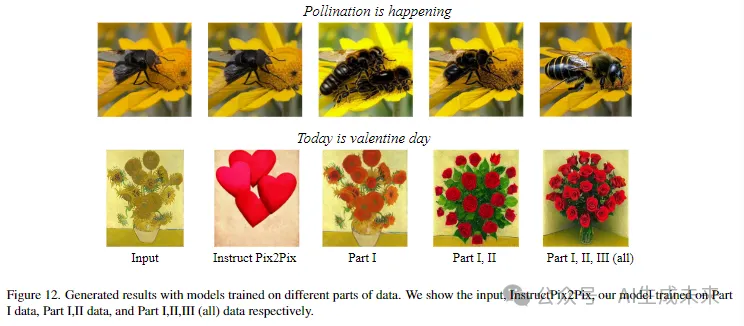

定性结果评估了数据集的三个部分的有效性。下图12展示了当仅使用Part I、Part I和Part II、以及整个数据集进行训练时的结果。可以观察到,当面对需要推理的指令时,之前的方法如InstructPix2Pix往往会编辑为空或产生不合理的编辑结果。使用Part I数据时,模型似乎理解了指令,但仍然很难提供编辑后的图像。这与本文提出的观点一致,即仅使用InstructPix2Pix数据集中的图像时,模型的编辑能力仍然有限。

另一方面,当逐步引入Part II和Part III数据时,编辑结果变得越来越好。有了数据集中的所有数据,模型能够理解指令并产生相应的结果。

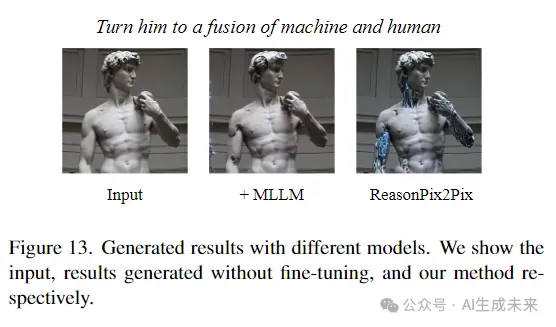

在我们的简单框架中,将多模态大语言模型集成到图像编辑模型中,它自然具有推理能力。在这里,比较了InstructPix2Pix的结果,添加了未经微调的MLLM,以及在ReasonPix2Pix上进行了微调的我们的模型。下图13显示,未经微调时,图像编辑模型很难接受MLLM的输出。当在我们的数据集上进行微调时,模型能够理解和编辑。

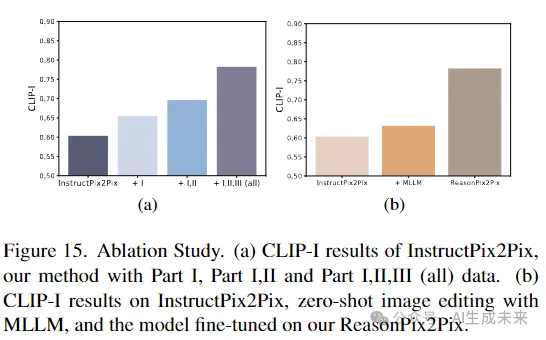

定量结果在下图15a中,比较了定量结果。当添加Part I、II和III数据时,CLIP-I上升。因此,数据集的三个部分都是必不可少的。同时,如下图15b所示,MLLM带来了轻微的改进,而数据集显然提升了模型的性能。定量结果与定性结果一致。

综合理解最后,让我们回到前面的案例,“使其晚50年”。以前的方法无法处理一些情况,例如水果。同时,理解指令不是一个单一模态的问题,一个男人的雕像在50年后不会变成老人。通过我们的框架和数据集,模型考虑了图像和指令。因此,它根据不同的输入提供了合理的结果。50年后,一个年轻美丽的女人变成了一个老女人,苹果变成了腐烂的,雕像变成了一个带着尘土的破碎的雕像。

限制

由于 API 成本的限制,数据集大小仍然有限。本文已经制定了一个清晰的数据生成流程。如果需要,研究人员可以将数据集扩展到超过 400,000 个样本。

结论

本文旨在增强编辑模型的推理能力,使其更加智能化。具体地,引入了 ReasonPix2Pix,一个专门用于注入推理能力到图像编辑中的推理指令编辑数据集。在提出的数据集上微调了一个简单的框架。广泛的实验结果证明,ReasonPix2Pix在不管指令是否需要推理的情况下都取得了竞争性的结果。

本文转自 AI生成未来 ,作者:Ying Jin等