除了RAG,还有这五种方法消除大模型幻觉 原创

出品 | 51CTO技术栈(微信号:blog51cto)

众所周知,LLM会产生幻觉——即生成不正确、误导性或无意义的信息。

有意思的是,一些人,如OpenAI的CEO Sam Altman,将AI的幻觉视为创造力,而另一些人则认为幻觉可能有助于做出新的科学发现。

然而,在大多数情况下,提供正确回答至关重要,幻觉并不是一项特性,而是一种缺陷。

那么,如何减少LLM的幻觉呢?长上下文?RAG?微调?

其实,长上下文LLMs并非万无一失,向量搜索RAG也不尽如人意,而微调则伴随着其自身的挑战和限制。

下面是一些可以用来减少LLM幻觉的高级技术。

1.高级提示词

关于使用更好或更高级的提示词(prompts)是否能解决大型语言模型(LLM)的幻觉问题,确实存在很多讨论。

图片

图片

虽然一些人认为编写更详细的提示词对解决(幻觉)问题没有帮助,但谷歌大脑(Google Brain)的联合创始人吴恩达(Andrew Ng)等人却看到了其中的潜力。

吴恩达认为,GPT-4和其他先进模型的推理能力使它们非常擅长解释带有详细说明的复杂提示词。

图片

图片

“通过多示例学习,开发者可以在提示词中给出数十个,甚至数百个示例,这比少示例学习更为有效,”他写道。

图片

图片

为了改进提示词,许多新的进展也在不断涌现,比如Anthropic公司于5月10日发布了一款新的“Prompt Generator”工具,该工具可以将简单的描述转化为针对大型语言模型(LLMs)优化的高级提示词。通过Anthropic控制台,就可以生成用于生产的提示词。

最近,马克·安德森(Marc Andreessen)也表示,通过正确的提示,我们可以解锁AI模型中的潜在超级天才。“在不同领域的提示技术可以解锁这种潜在超级天才”,他补充道。

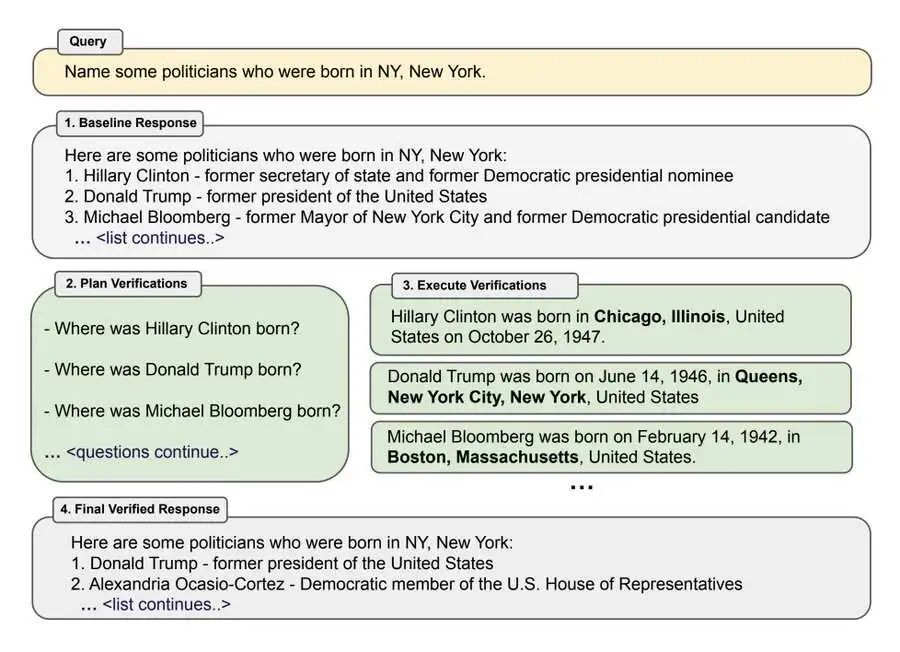

2.Meta AI的Chain-of-Verification(CoVe)

Meta AI的Chain-of-Verification(CoVe)是另一种技术。这种方法通过将事实核查分解为可管理的步骤,提高响应准确性,并与人类驱动的事实核查过程保持一致,来减少大型语言模型(LLMs)的幻觉现象。

图片

图片

CoVe涉及生成初始响应、规划验证问题、独立回答这些问题,并生成最终经过验证的响应。通过系统地验证和纠正其输出,这种方法显著提高了模型的准确性。

它通过减少幻觉并增加事实正确性,在各种任务中提高了性能,如基于列表的问题、闭卷问答和长篇文本生成等。

3.知识图谱

RAG(检索增强的生成)不再局限于向量数据库匹配,目前引入了许多先进的RAG技术,显著提高了检索效果。

图片

图片

例如,将知识图谱(KGs)集成到RAG中。通过利用知识图谱中结构化且相互关联的数据,可以大大增强当前RAG系统的推理能力。

4.Raptor

另一种技术是Raptor,该方法通过创建更高层次的抽象来处理跨越多个文档的问题。它在回答涉及多个文档概念的查询时特别有用。

图片

图片

像Raptor这样的方法与长上下文大型语言模型(LLMs)非常契合,因为你可以直接嵌入整个文档而无需分块。

该方法通过将外部检索机制与变换器模型集成来减少幻觉现象。当接收到查询时,Raptor首先从外部知识库中检索相关且经过验证的信息。

然后,将这些检索到的数据与原始查询一起嵌入到模型的上下文中。通过将模型的响应基于事实和相关信息,Raptor确保生成的内容既准确又符合上下文。

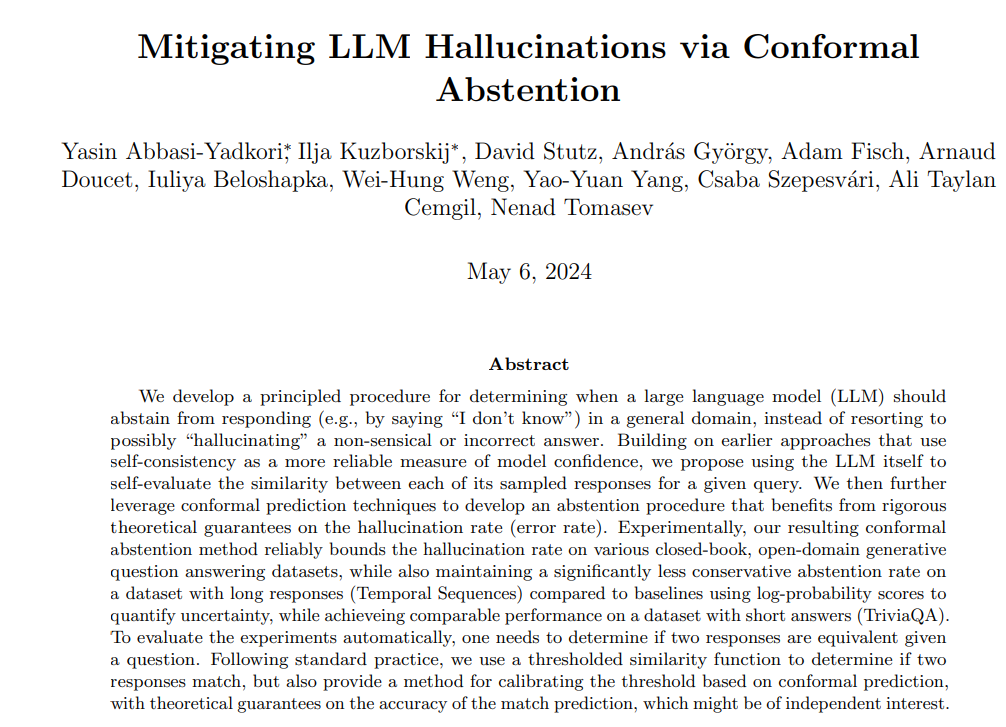

5.共形抽离(Conformal Abstention)

论文《通过共形抽离缓解大型语言模型的幻觉现象》介绍了一种通过应用共形预测技术来确定模型何时应该避免给出响应,从而减少大型语言模型(LLMs)中的幻觉现象的方法。

图片

图片

通过使用自我一致性来评估响应的相似性,并利用共形预测进行严格的保证,该方法确保模型只在对其准确性有信心时才做出响应。

这种方法在保持平衡的抽离率的同时,有效地限制了幻觉现象的发生率,特别有利于需要长篇回答的任务。它通过避免错误或不合逻辑的响应,显著提高了模型输出的可靠性。

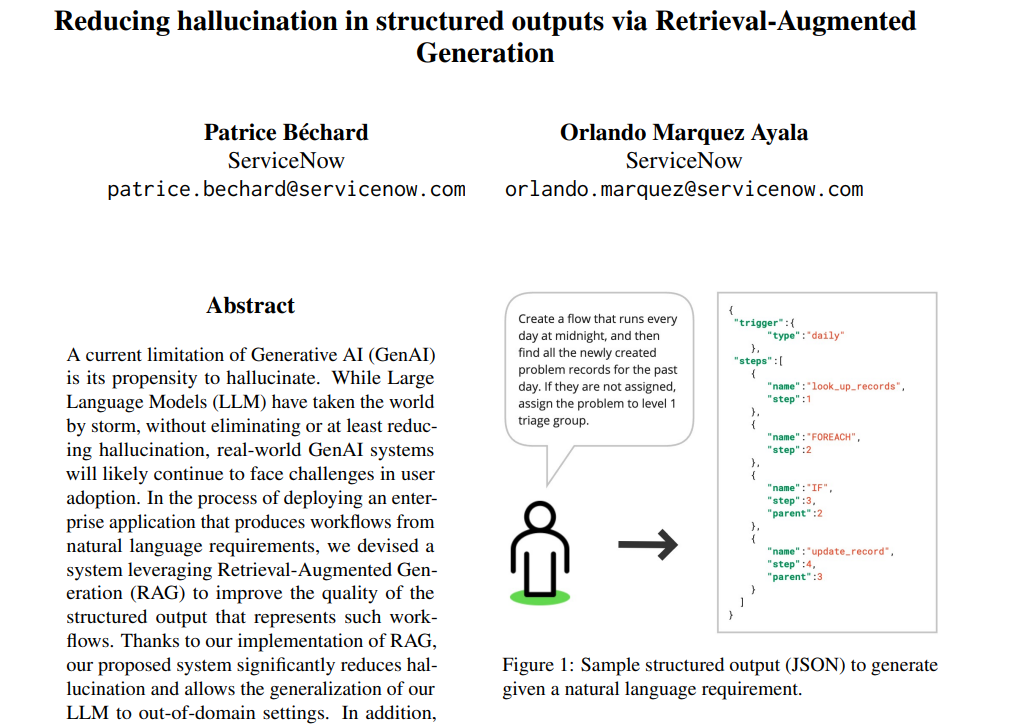

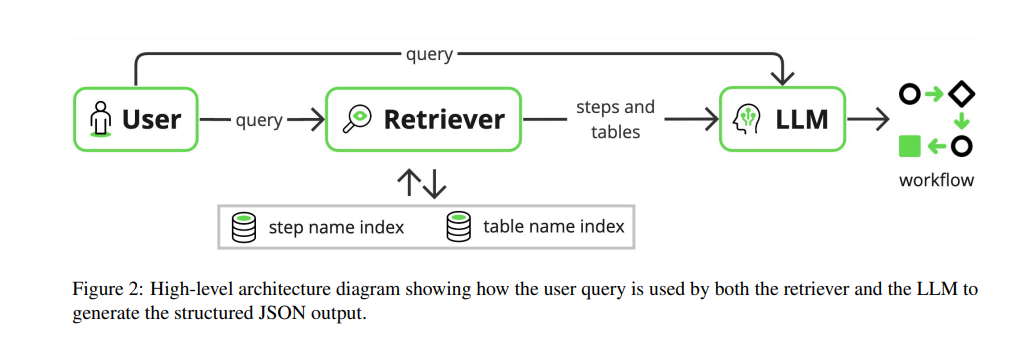

6.RAG减少结构化输出中的幻觉现象

最近,ServiceNow通过RAG减少了结构化输出中的幻觉现象,提高了大型语言模型(LLM)的性能,实现了域外泛化,同时最小化了资源使用。

图片

图片

该技术涉及一个RAG系统,该系统在生成文本之前从外部知识库中检索相关的JSON对象。这确保了生成过程基于准确且相关的数据。

图片

图片

通过融入这一预检索步骤,模型不太可能产生错误或捏造的信息,从而减少了幻觉现象。此外,这种方法允许使用较小的模型而不牺牲性能,使其既高效又有效。

本文转载自51CTO技术栈