无限创建新角色!大连理工卢湖川、贾旭团队开源CharacterFactory

Huggingface Demo: https://huggingface.co/spaces/DecoderWQH666/CharacterFactory

Github: https://github.com/qinghew/CharacterFactory(代码已经开源)

Project Page: https://qinghew.github.io/CharacterFactory/

Paper: https://arxiv.org/abs/2404.15677

最近,来自大连理工大学的IIAU团队提出CharacterFactory,不需要参考图片,仅需2.5GB显存训练10分钟,可以在3秒内无限制地端到端地采样出新的一致性角色,可以结合动作、背景、风格等文本提示实现一致性图像生成,并且无需微调即可插入视频/3D生成。

小编表示:这个工作竟有种女娲造人的感觉。

一、引言:

在不断发展的文本到图像生成领域,扩散模型已成为内容创建不可或缺的工具。但生成模型固有的随机特性导致无法直接地在如图1所示的不同的上下文中生成主体一致的内容。这样的一致性可以驱动许多应用:为书籍和故事绘制插图、创建品牌形象、开发演示文稿、艺术设计、身份一致的数据构建等。

近期,主体驱动生成将给定图像表示为新词或学习图像特征注入以实现一致的图像生成。他们的训练范式通常包括每个主体的单独优化和在大规模数据集上预训练编码器。前者通常需要对每个主体进行长时间的优化,并且往往会过拟合输入图像中的外观。后者消耗大量的计算成本,并且难以稳定地捕获身份及其细节。然而,这些方法试图生成与参考图像具有相同身份的图像,而不是创建新的角色。一种可行的方法是预先使用文本到图像模型来创建新的角色图像,然后采用主体驱动的方法来生成具有一致身份的图像。这样的两阶段工作流可能会将预训练的生成模型推离其训练分布,导致生成质量下降且与其他扩展模块的兼容性差。因此,迫切需要提出一种新的端到端框架来实现一致的角色生成。

二、方法

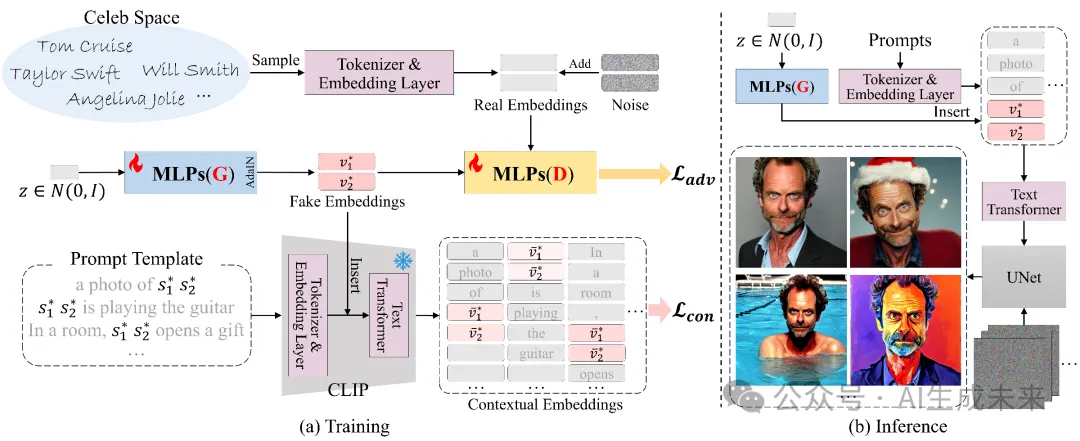

在这项工作中,研究者们提出了CharacterFactory,如上图所示,利用GAN采样出在上下文中具有一致性的身份词向量,在推理时将此身份词向量插入,可以产生身份一致的角色图片。

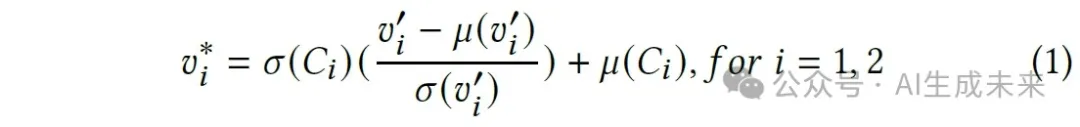

具体来说,本文将名人名字的词向量视为身份一致生成的理想样例,并收集了使用Stable Diffusion可以在不同上下文中生成一致身份的名人名字,作为理想的目标空间。为了使生成的身份词向量在扩散模型中表现得像名人名字一样,研究者们训练了一个向量级GAN模型来学习从隐空间到名人词向量空间的映射,并通过AdaIN辅助将生成的身份词向量更自然地与对齐名人空间的分布:

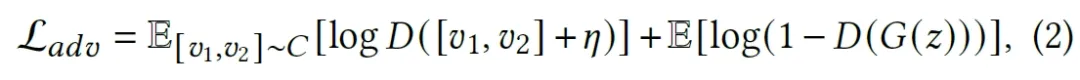

生成器G被训练最小化这一目标,而判别器被训练最大化这一目标。

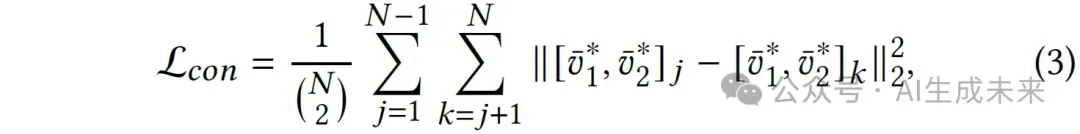

此外,CLIP可以将不同上下文中与某个主体对应的名词映射为相似的上下文表示,所以这一名词能够在生成结果中表现出一致性。为了让生成的伪身份词向量具有同样的效果(即在不同的上下文中表现出一致的身份),本文设计了一种上下文一致性损失,期望词向量v_1^*,v_2^*结合不同的文本提示时,在经过CLIP的text transformer之后差距尽可能地缩小。此外,这种损失是即插即用的,可以迁移至其他主体驱动的生成方法,有助于学习上下文一致的主体词嵌入。

整体的目标可以表示为:

判别器D的工作保持不变,生成器G的任务不仅是学习名人词向量的属性来骗过D,还要在text transformer的输出空间中体现上下文一致性。在此,有两点值得注意:

1.用于词向量的GAN:研究者们首次在 CLIP 词向量空间中引入 GAN,并利用后续网络来设计上下文一致损失,该损失可以感知不同上下文中生成的伪身份词向量。这种设计类似于之前基于GAN的图像生成模型的思想(例如Pix2pix,Perceptual loss),这些方法证明了将 GAN 目标与更传统的损失(例如 L2 loss)混合是有益的。

- 不需要基于扩散模型的训练:显然,研究者们的训练过程中不涉及通常用于训练的降噪UNet和扩散损失。值得注意的是,所提出的 IDE-GAN 在推理时可以与扩散模型无缝集成,以实现身份一致的生成。

三、实验结果

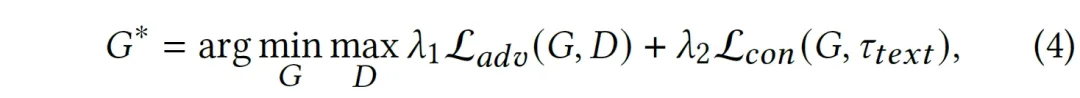

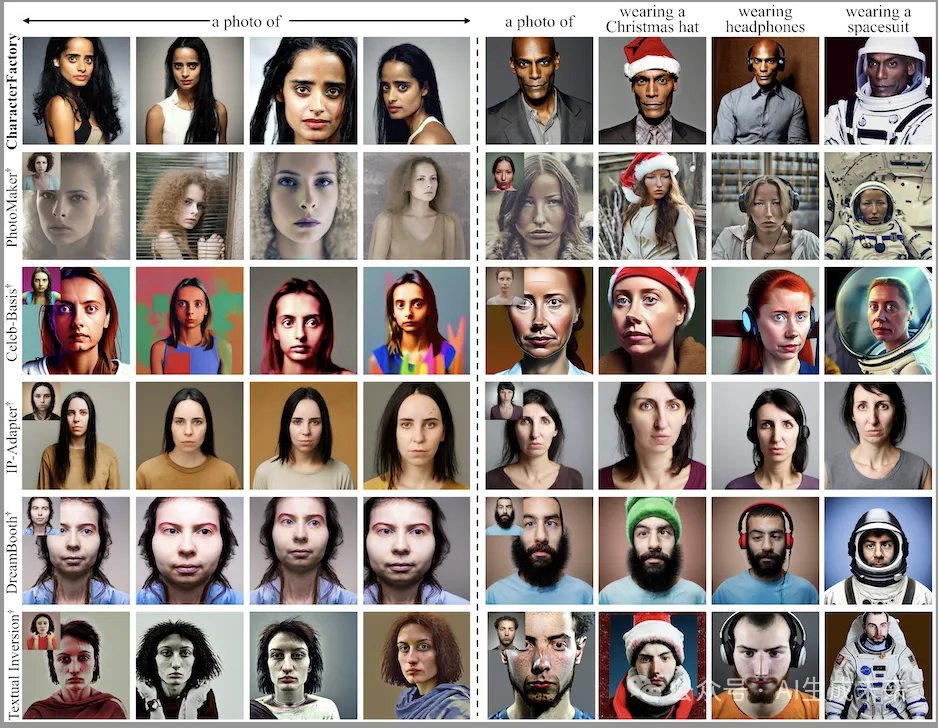

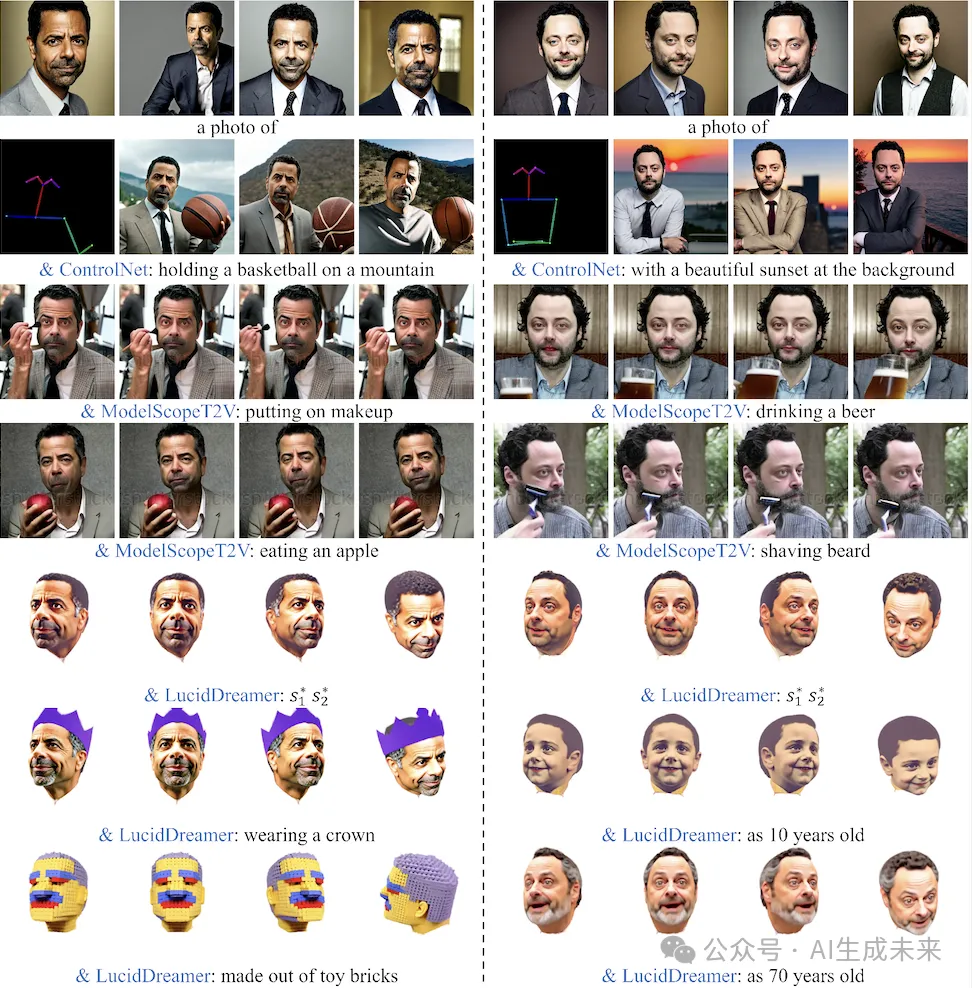

- 在实验环节,本文在多个指标上与实现的两阶段的工作流(主体驱动的方法)进行了定性和定量的对比。如图和表所示,本文的方法取得了最佳的人脸相似性、可编辑性、可信人脸多样性和图像质量。

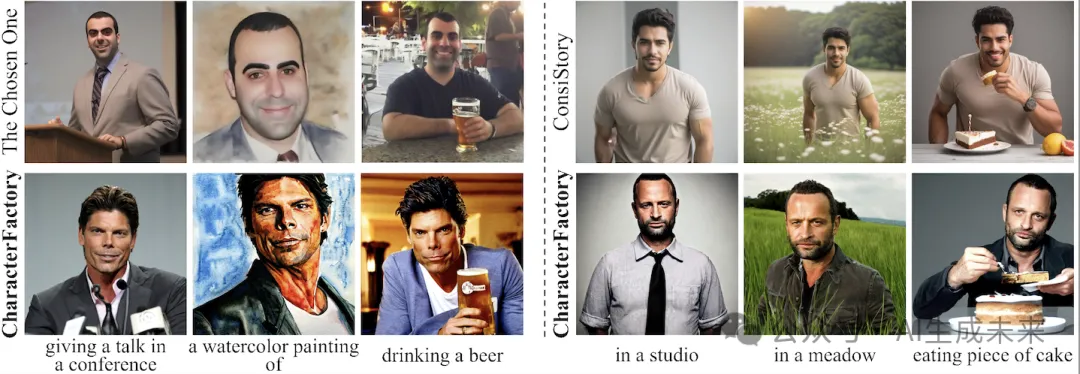

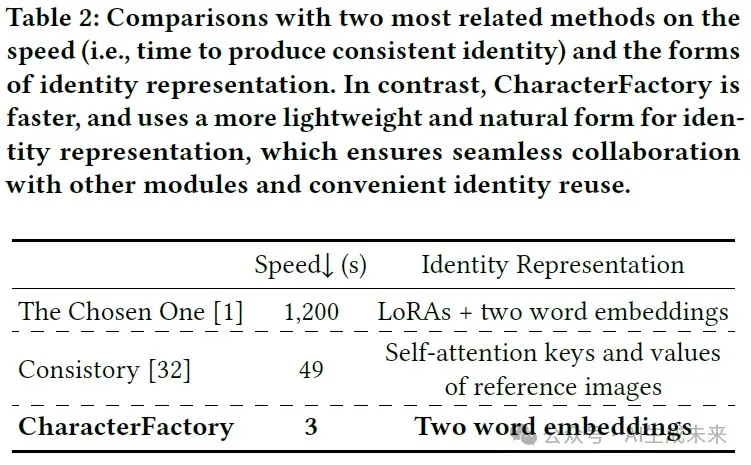

- 此外,与本文最相关的方法The Chosen One和Consistory没有开源,研究者们与他们论文里的内容进行了对比。视觉上本文方法与他们取得了相当的性能,但在本文的产生一致角色的速度更快,身份表示成本上更低。

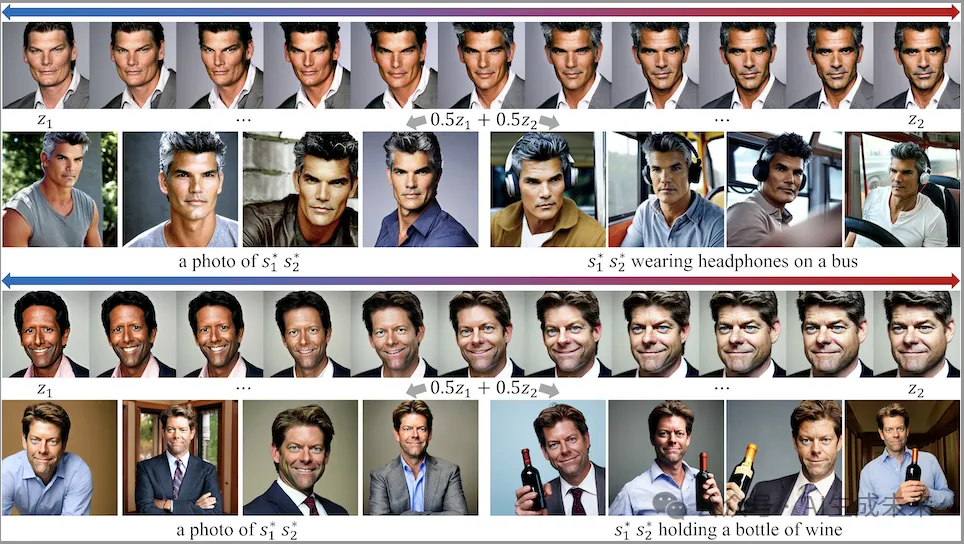

- 像传统的GAN方法一样,本文也尝试了在隐空间中进行插值,并在图像空间展示插值效果,可以看出,本文生成的身份能够产生平滑的变化,这不仅证明CharacterFactory具有不错的插值特性,也从另一方面证明了CharacterFactory可以与Stable Diffusion无缝集成。

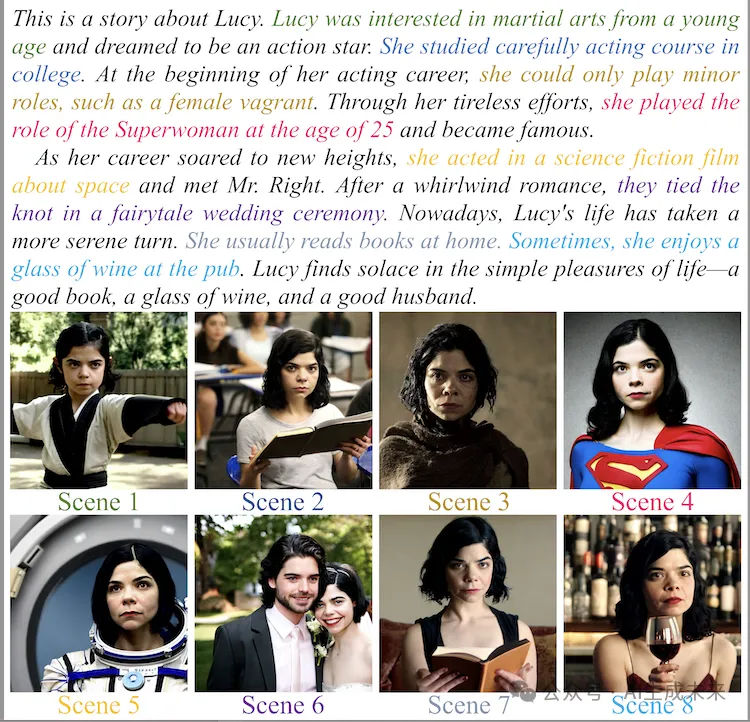

- 本文的一个应用是为故事插图方面,可以看出本文生成的身份可以结合不同的上下文产生相应结果,甚至能够完成抽象属性(如年龄)的编辑。

- 本文将得到的一致身份表示与图像/视频/3D模型进行结合,得到了更具创造力的结果。

四、结论

本文所提出的框架,可以以极低的训练开销和极快的推理速度,端到端地采样无限的新角色,在上下文中展现出良好的一致性和可编辑性,并可以与ControlNet、视频、3D等模型结合,做到即插即用,这项工作被认为是一致角色生成的重要一步。

本文转自 AI生成未来 ,作者:AI生成未来