大佬怎么看OpenAI 和Google 本周相继发布的模型及未来发展的?

作为 scale_ai 的 ceo, Alexandr Wang 今天在X上发布了他对于最近OpenAI和Google的公告引发了一些思考,以及这对未来人工智能发展的暗示。让我们一起来看看吧!

提示:后训练真的非常重要...

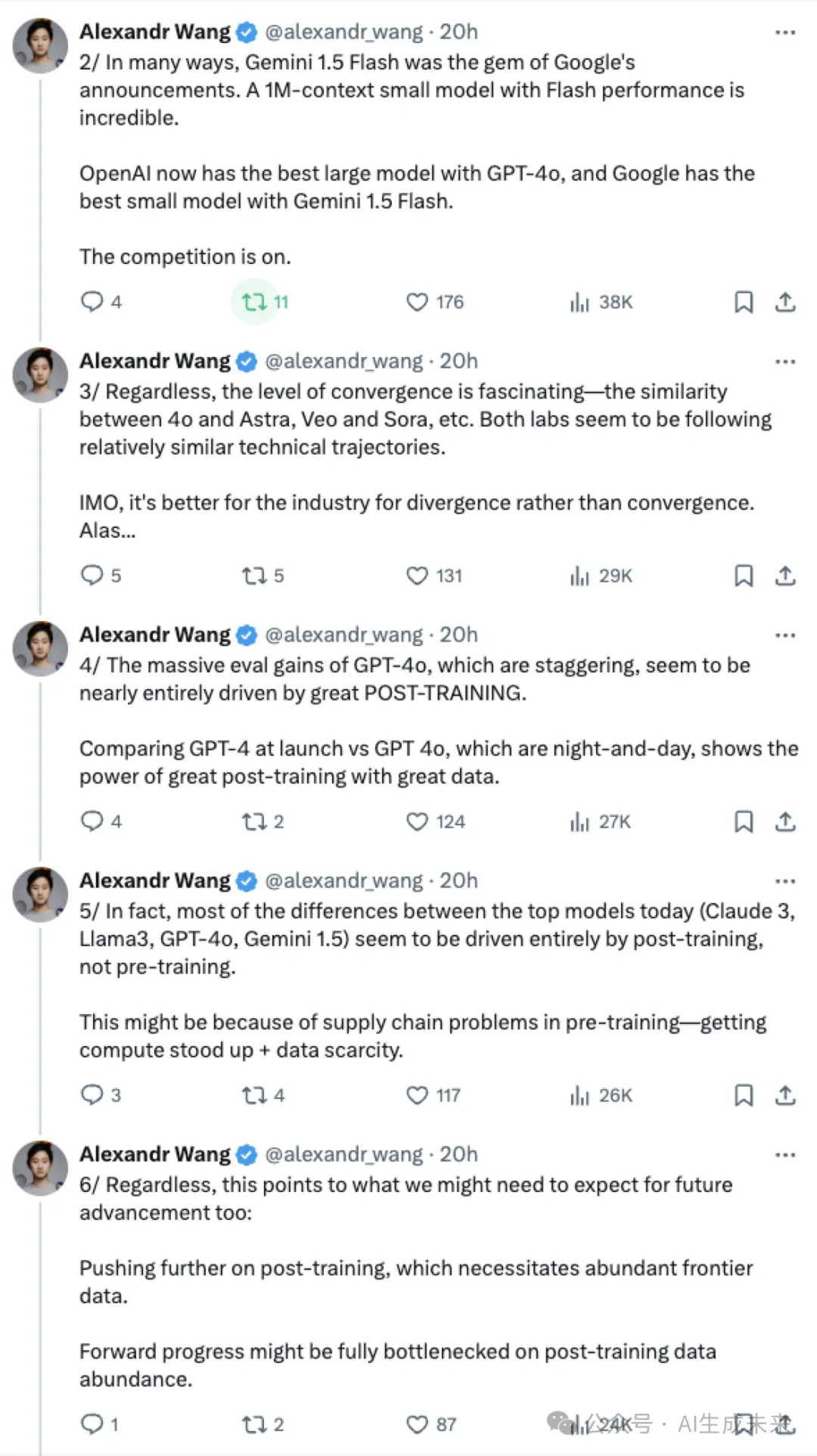

在许多方面,谷歌宣布的Gemini 1.5 Flash是一颗明珠。具备闪电般性能的100万上下文小型模型令人难以置信。

OpenAI现在拥有最优秀的大型模型GPT-4o,而谷歌则拥有Gemini 1.5 Flash这款最佳小型模型。

竞争激烈进行中。

无论如何,收敛水平都是令人着迷的——比如4o和Astra、Veo和Sora之间的相似性等等。两个实验室似乎都在遵循相对相似的技术发展轨迹。

在我看来,对于行业而言,分歧而非趋同更为有利。可惜啊……

GPT-4o的巨大评估增益令人瞠目,几乎完全归功于出色的后训练。

比较发布时的GPT-4和GPT-4o,二者之间的差异巨大,展示了出色数据与出色后训练的力量。

实际上,如今顶级模型(比如Claude 3、Llama3、GPT-4o、Gemini 1.5)之间的大部分差异似乎完全是由后训练而非预训练所驱动。

这可能是由于预训练中的供应链问题——计算资源的获取和数据稀缺。

不过,这也指向了我们对未来进展可能需要期待的方向:

进一步推动后训练,这需要充足的前沿数据支持。

未来进步可能完全取决于后训练数据的丰富程度。

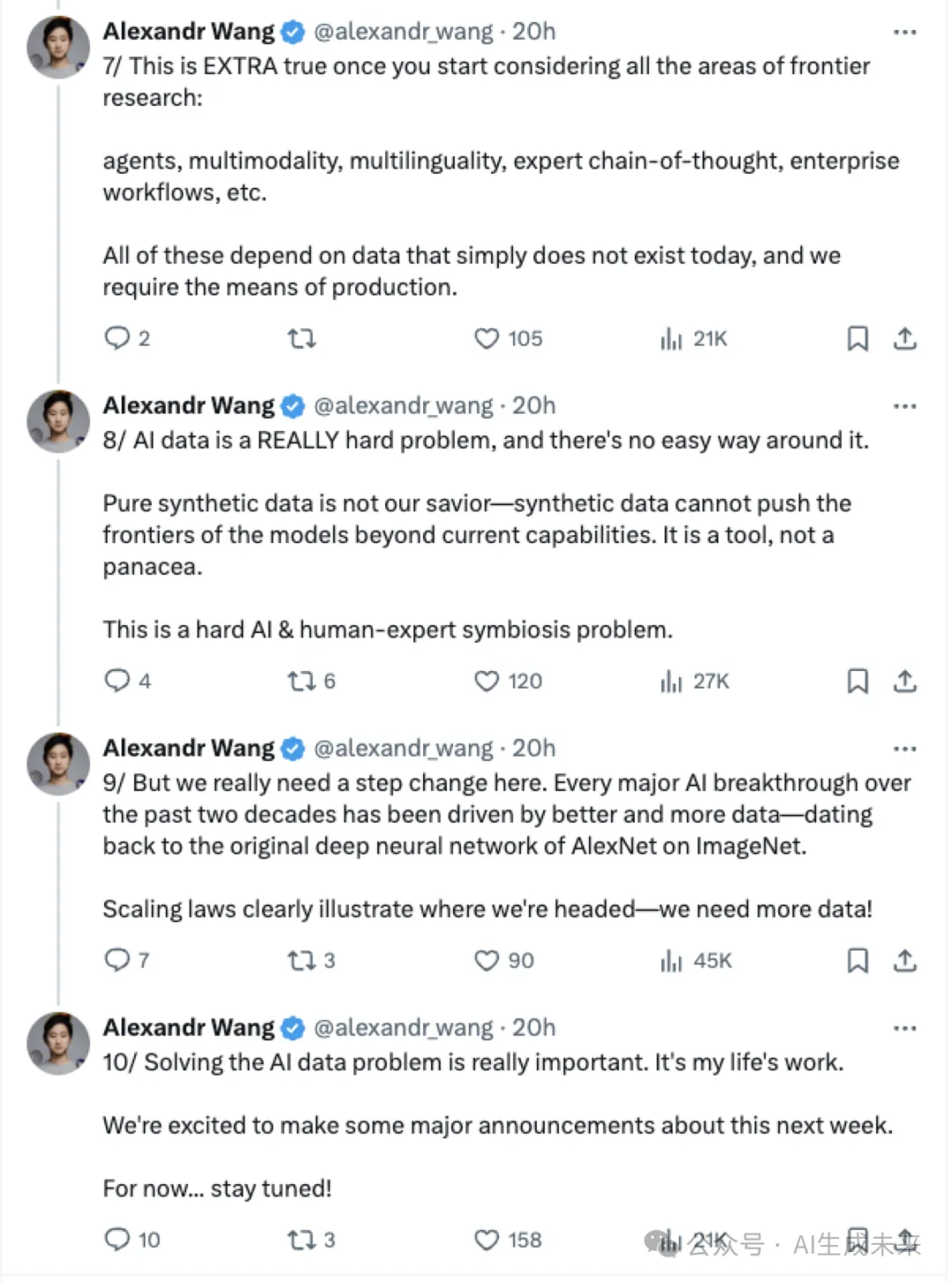

一旦开始考虑所有前沿研究领域,情况就会变得更为明显:

代理、多模态、多语言、专家思维链、企业工作流程等。

所有这些都依赖于当今根本不存在的数据,而我们需要生产这些数据的手段。

AI数据是一个非常棘手的问题,没有简单的解决办法。

纯合成数据并不能拯救我们——合成数据无法将模型的前沿推进到超越当前能力的水平。它只是一种工具,而不是灵丹妙药。

这是一个棘手的人工智能与人类专家共生的问题。

但我们真的需要在这方面迈出一大步。过去二十年里的每一次重大人工智能突破都是由更好、更多的数据推动的——从AlexNet在ImageNet上的原始深度神经网络开始。

Scaling laws 清楚地说明了我们的发展方向——我们需要更多的数据!

解决人工智能数据问题非常重要。这是我一生的事业。

我们很高兴地宣布,下周将有一些重大消息。

目前先... 敬请关注!

以下是原文:

本文转自 AI生成未来 ,作者:AI生成未来