300亿参数!苹果推出多模态大模型MM1,能解释图像和文本数据

在过去的一年里,LLM 因其先进的 AI 能力而备受关注。值得注意的是,苹果(Apple)公司却缺席了。

目前,苹果公司正在谈判将谷歌的 Gemini 人工智能引擎植入 iPhone。而苹果一直致力于开发下一代 LLM,一种可以解释图像和文本数据的 LLM。

近日,苹果的计算机科学家和工程师团队开发了一种 LLM 模型,声称该模型可以解释图像和数据。

苹果构建了一个多模态模型系列——MM1,包括高达 30B 的 dense 变体和高达 64B 的专家混合 (MoE) 变体,它们在预训练指标中是 SOTA,并在对一系列已建立的多模态基准进行监督微调后获得具有竞争力的性能。

该研究以《MM1:多模态 LLM 预训练的方法、分析和见解》(MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training)为题,发表在 arXiv 预印上,描述了他们新的 MM1 系列多模态模型和测试结果。

论文链接:https://arxiv.org/abs/2403.09611

论文链接:https://arxiv.org/abs/2403.09611

多模态 AI 的工作原理是集成和处理不同类型的数据输入,例如视觉、听觉和文本信息。这种集成使人工智能能够更全面地理解复杂数据,从而比单模态人工智能系统做出更准确和上下文感知的解释。

苹果的研究团队声称,他们在 MM1 模型中使用多模态 AI 方面取得了重大进展,该模型集成了文本和图像数据,以提高图像字幕、视觉问答和查询学习的能力。他们的 MM1 是他们所描述的多模态模型系列的一部分,每个模型都包含多达 300 亿个参数。

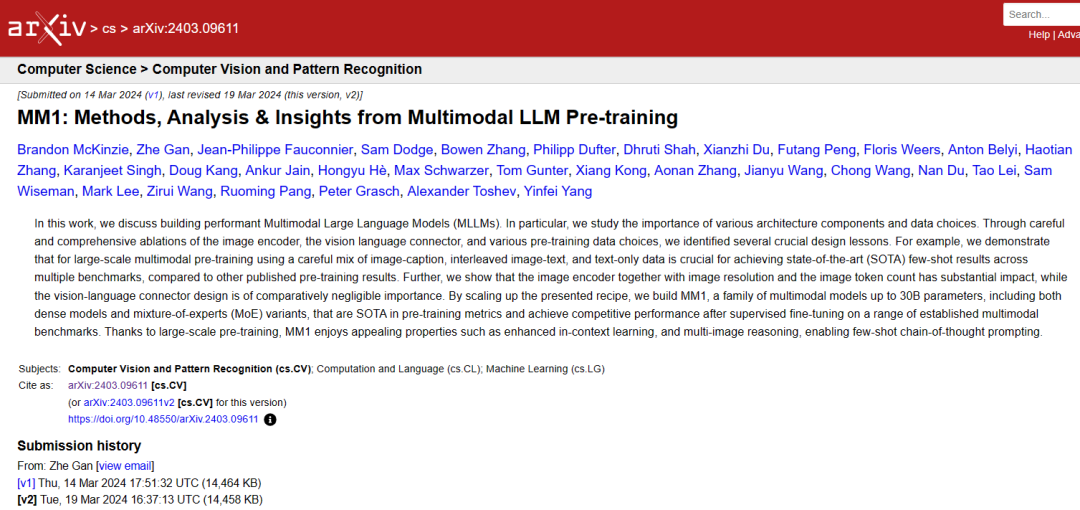

图 1:在 MLLM 基准测试中与 SOTA 模型的比较。

图 1:在 MLLM 基准测试中与 SOTA 模型的比较。

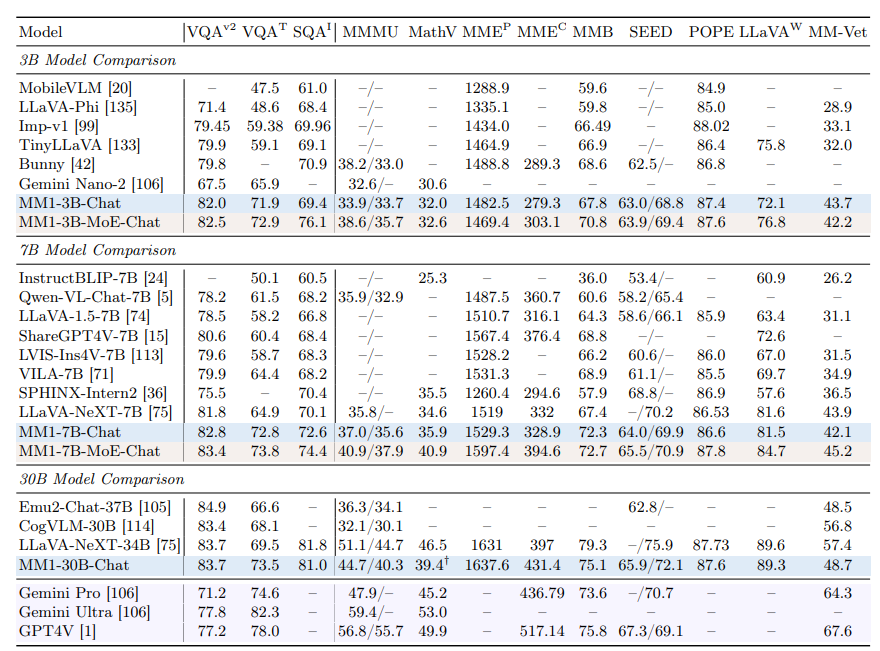

图 2:MM1 凭借其大规模多模态预训练可以执行上下文预测。

图 2:MM1 凭借其大规模多模态预训练可以执行上下文预测。

研究人员指出,此类模型利用由图像捕获对、包含图像和纯文本文档的文档组成的数据集。

研究人员进一步声称,他们的多模态 LLM (MLLM) 可以计算对象、识别图像中的对象,并利用日常对象的常识为用户提供有关图像所呈现内容的有用信息。

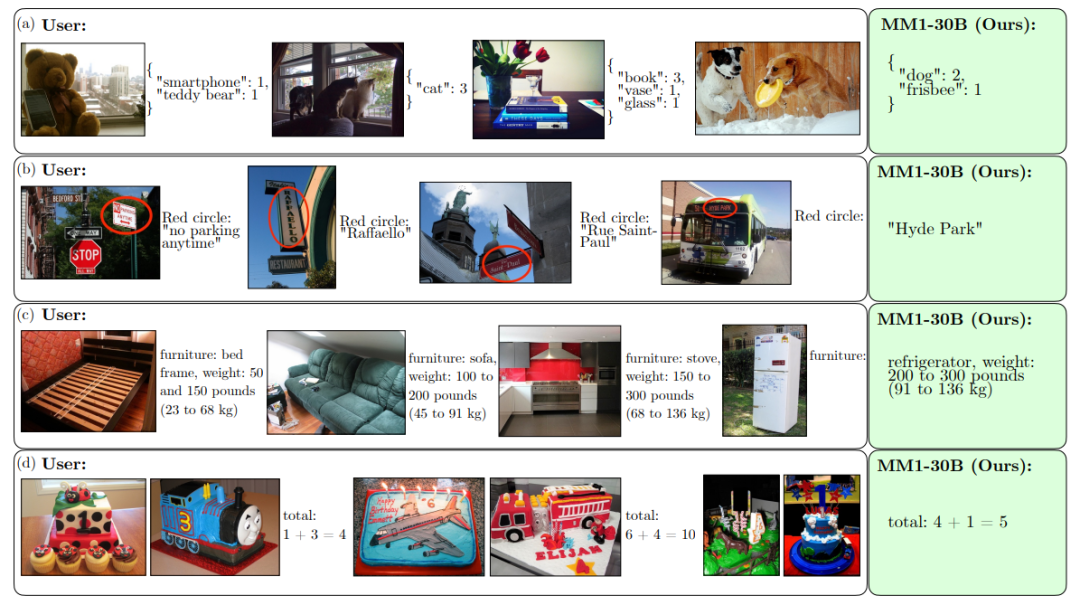

图 3:MM1 可以跨图像执行指令和推理。

图 3:MM1 可以跨图像执行指令和推理。

研究人员还声称,他们的 MLLM 能够进行情境学习,这意味着它不需要每次提出问题时都重新开始;它使用在当前对话中学到的知识。

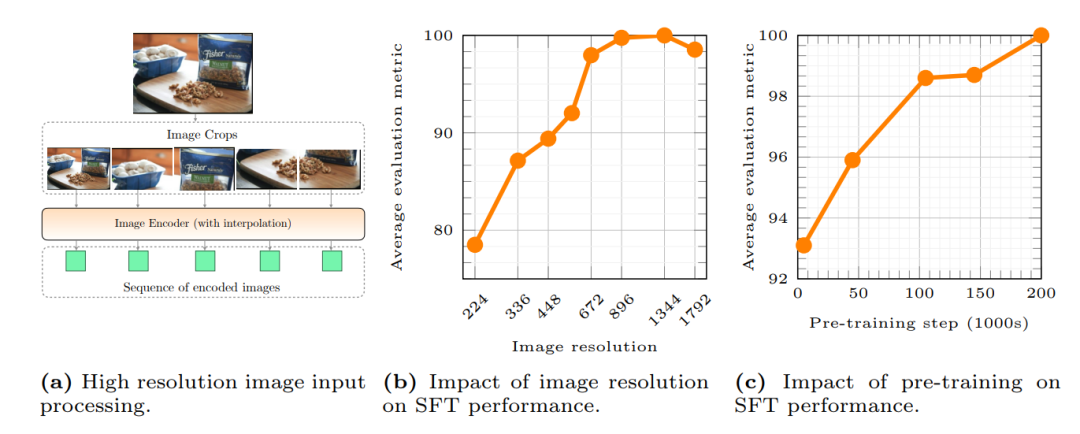

图 4:研究了图像分辨率和预训练对监督微调(SFT)性能的影响。

图 4:研究了图像分辨率和预训练对监督微调(SFT)性能的影响。

该团队提供了模型高级功能的示例,其中包括上传一群朋友在酒吧拿着菜单的图像,并询问模型根据菜单中列出的价格为每个人购买一杯啤酒需要多少钱。

研究人员表示,“我们希望所确定的经验教训将帮助社区构建超越任何单一特定模型架构或数据策略的强大模型。”