回复

SealTool:Agent微调与评测的开源项目(14k样本,4k工具),比ToolBench等更全面!

大型语言模型(LLMs)在多种任务中展现了强大的能力,研究者尝试将其作为代理,通过使用外部工具或插件帮助用户完成任务。为了提高LLMs的工具理解和使用能力,需要准备高质量的工具学习数据集。现有的工具学习数据集存在一些限制:例如工具数量有限、评估方法不精确或成本高昂。

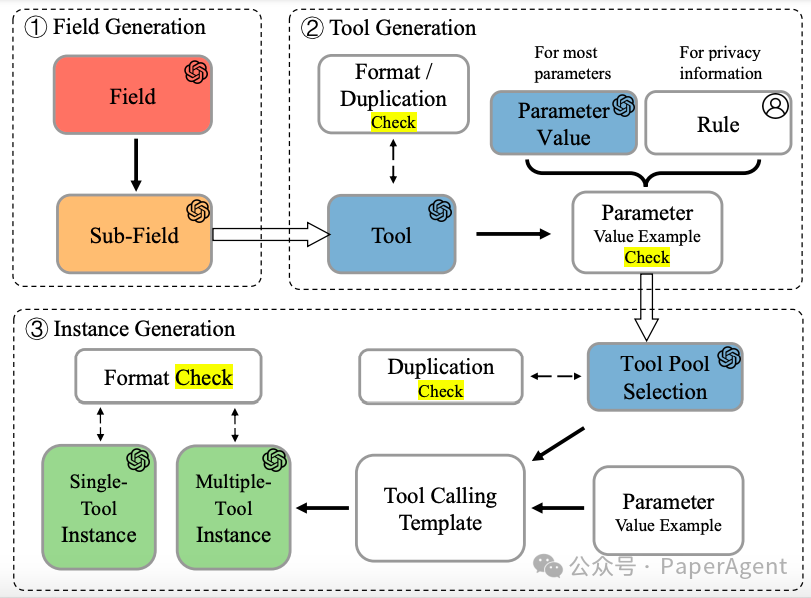

提出了一种自指导(self-instruct)方法,通过LLMs生成工具和实例。该方法首先生成不同领域的工具,然后生成调用这些工具的实例,包括单工具实例和多工具实例。

数据集构建方法的流程图

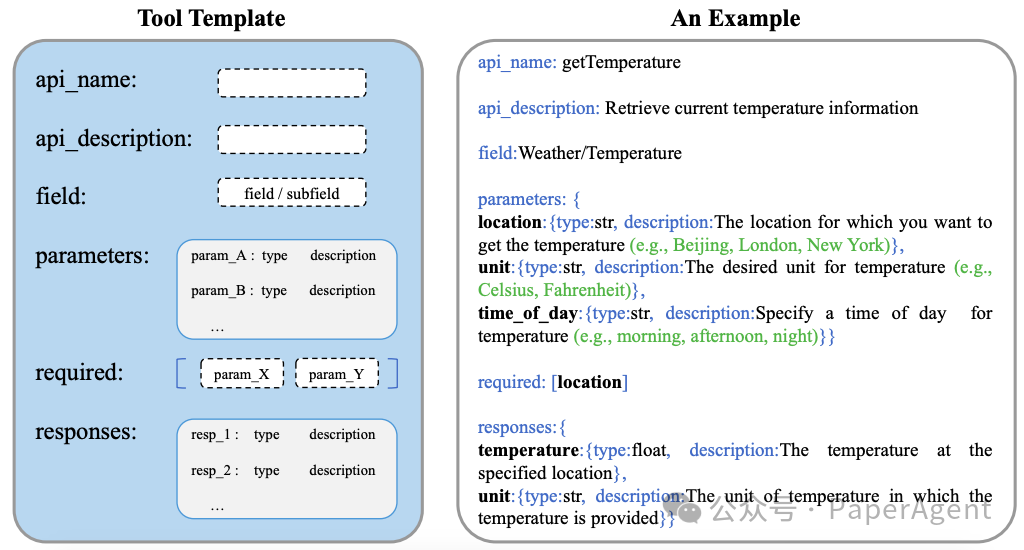

- 工具模板:设计了工具模板,用于生成具有输入参数和输出响应的API样式工具。

Seal-Tools工具模板以及以“getTemperature”工具为例:

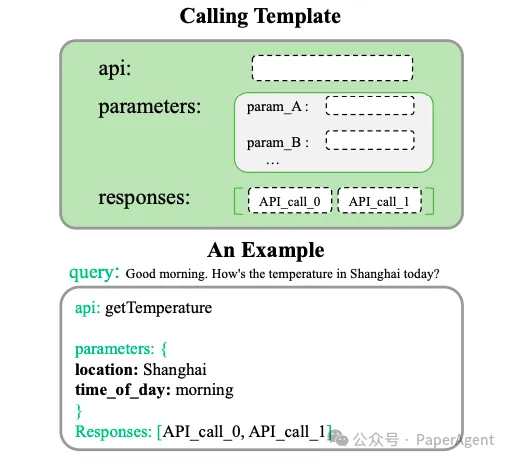

- 实例生成:生成实例包括用户查询和工具调用,通过多步骤生成并设置检查点以减少错误。

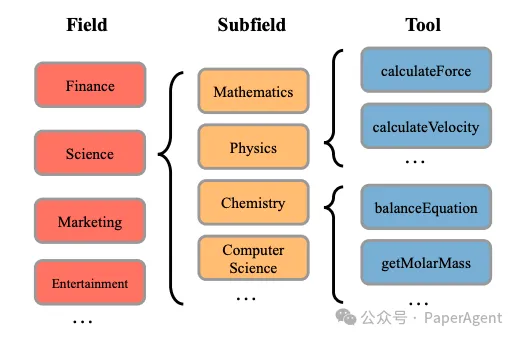

一些生成的字段/子字段和工具的示例:

单工具调用的实例模板

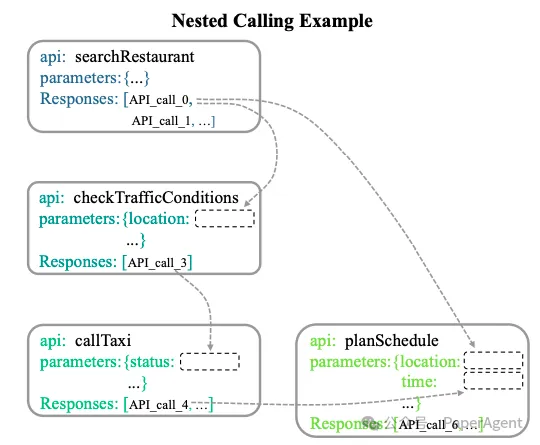

多工具嵌套调用的实例模板

设计了三个评估维度:输出格式、工具选择和工具参数填充,以进行详细评估。

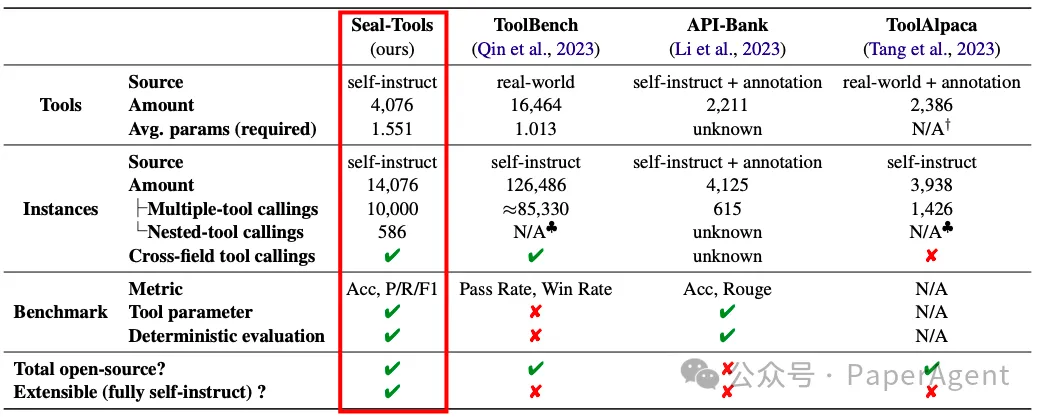

Seal-Tools与几个工具学习数据集的比较。† 格式混乱。♣ 多步骤。

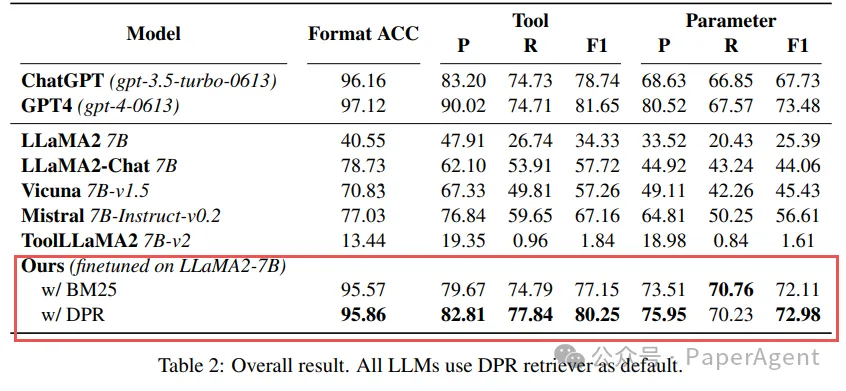

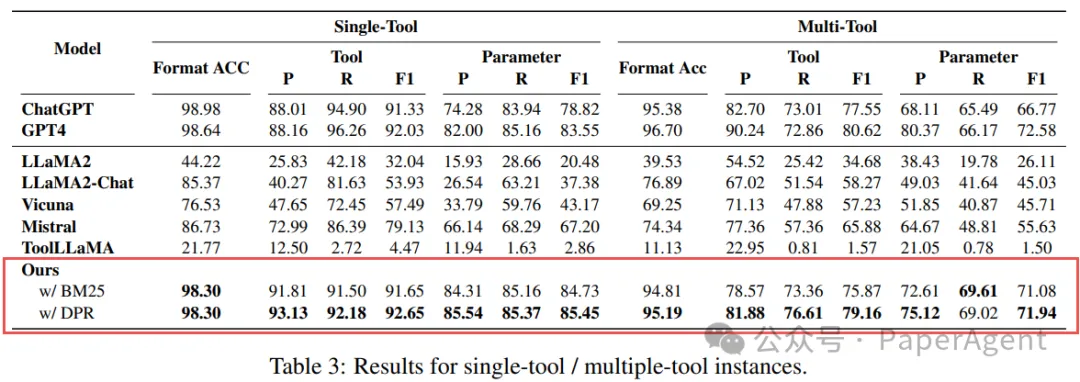

对几种流行的LLMs和微调模型在Seal-Tools上进行了评估,结果显示基于Seal-Tools微调的模型显示出很大的竞争力,但是当前的Agent系统在工具选择和参数填充方面仍有改进空间,Seal-Tools可以作为推动LLMs工具学习研究的新基准。。

https://arxiv.org/abs/2405.08355

Seal-Tools: Self-Instruct Tool Learning Dataset for Agent Tuning and Detailed Benchmark

https://github.com/fairyshine/Seal-Tools本文转载自 PaperAgent,作者: PaperAgent

赞

收藏

回复

相关推荐