ResearchAgent: 利用agent自动生成论文idea,再也不用担心做科研没有思路了

大家好,我是HxShine

今天分享微软的一篇文章:ResearchAgent: Iterative Research Idea Generation over Scientific Literature with Large Language Models。传统的科学研究过程包括新研究想法的提出和通过精心设计的实验来验证这些想法,这一过程缓慢且依赖专业专家,这限制了科研的生产力。这篇论文试图利用agent思想来自动生成新的论文idea,解决科学研究生产力低下的问题,论文提出了一个名为ResearchAgent的工具,这是一个由大型语言模型驱动的研究思路撰写助手,能够自动化地生成问题、方法和实验设计,并能利用ReviewAgent对它们进行迭代式的优化。

Title: ResearchAgent: Iterative Research Idea Generation over Scientific Literature with Large Language Models

URL: https://arxiv.org/abs/2404.07738

Authors: Jinheon Baek, Sujay Kumar Jauhar, Silviu Cucerzan, Sung Ju Hwang

Institutions: KAIST, Microsoft Research, DeepAuto.ai

1 Motivation

• 科研工作在推动创新和解决问题上发挥着关键作用,但目前的科研过程复杂、缓慢,且需要专业的专家参与,这些都限制了科研的生产力。

• 为提高效率,本研究提出了利用大型语言模型的研究生成助手:ResearchAgent,它可以在阅读科学文献的基础上,自动生成研究领域内的问题、方法及实验设计,并能迭代地进行改善。

2 Methods

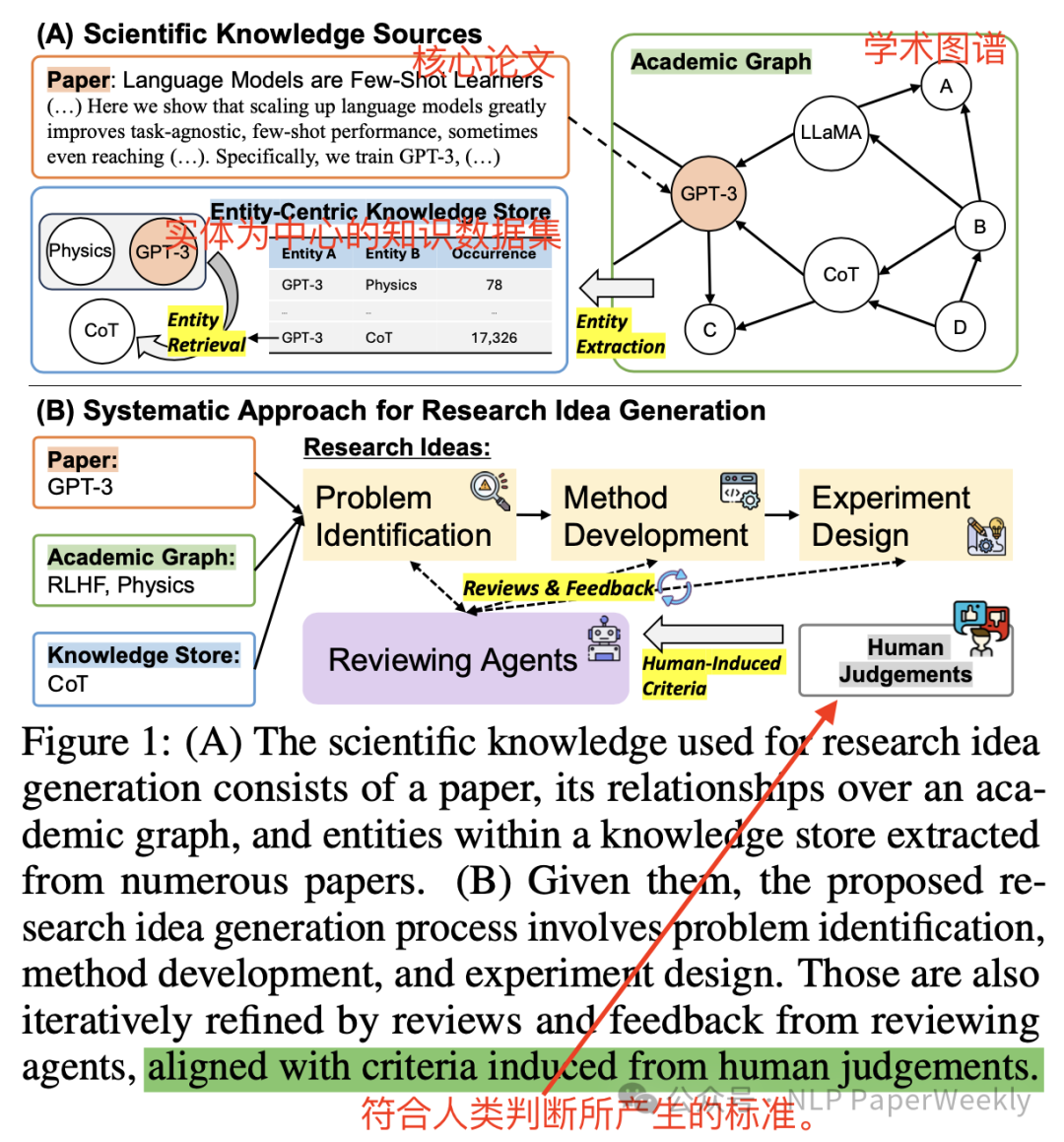

科研最重要的三个步骤是identifying problems(挖掘问题), developing methods(方法开发), and designing experiments(实验设计)。本文提出的“ResearchAgent”系统是一个基于大型语言模型(LLMs)的自动化科研想法生成框架,它通过三个主要步骤来模拟人类的科研过程:问题识别、方法开发和实验设计。系统利用科学文献中的引用关系和实体信息来增强LLMs的知识背景,并通过迭代评审和反馈机制,由多个与人类偏好对齐的LLM代理(ReviewingAgents)来提升想法的质量。实验设置包括从学术图谱API获取数据、构建实体中心的知识库,并使用GPT-4模型进行实验。通过人类和模型评估相结合的方法,验证了ResearchAgent在生成具有创新性、清晰度和相关性的科研想法方面的有效性。

本文提出的“ResearchAgent”系统是一个基于大型语言模型(LLMs)的科研想法生成代理,旨在通过自动化的方式提出新的科研想法。这个方法的核心在于模仿人类研究者在科研过程中的思考和迭代改进方式。以下是“ResearchAgent”方法的主要组成部分:

步骤一:LLM-Powered Research Idea Generation(利用core paper信息生成待研究的问题、以及方法和实验设计)

•问题识别(Problem Identification):利用LLM指出当前知识中的空白或矛盾,从而确定科研需要解决的问题。

•方法开发(Method Development):利用LLM设计用于解决问题的方法论和工具。

•实验设计(Experiment Design):利用LLM制定实验方案来验证提出的假设。

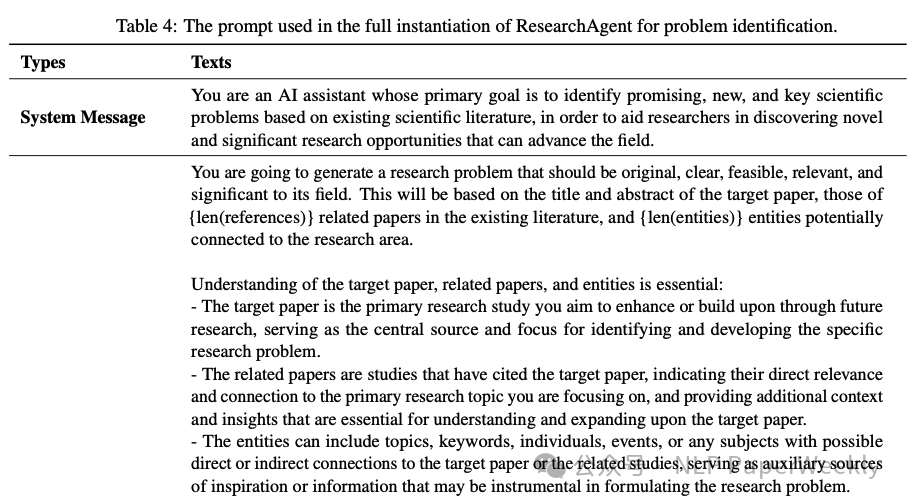

说明:我们的目标是基于现有学术文章(literature),挖掘新的idea,目标O由(problem,method,experiment)组成,可以表示为o = f(L),这里相当于分三个步骤来实现这个目标,首先基于提供的知识L生成问题,即p = f(L),然后根据问题p以及知识L生成method方法,即m = f(p, L),接着根据问题p,方法m和相关知识L完成实验设计,即d = f(p, m, L)。这里每一步都是通过LLM来实现,问题识别的prompt示例如下:

步骤二:Knowledge-Augmented LLMs for Research Idea Generation(通过外部知识增强的方法,提高LLMs在科研想法生成中的效果)

- •核心论文和相关引用(内部知识):选择一个核心论文作为起点,并基于引用关系选择相关的论文集,可以输入更相关、更连贯的一些知识。

- •实体中心的知识增强(外部知识):构建一个知识库,用于存储和检索科学文献中的实体,这些实体作为知识的原子单元,可以跨不同学科积累更多知识,提供更多见解(通过两个领域的重叠实体和外部知识建立联系),这里使用entity linker EL[1]这个工具来挖掘L中的实体。

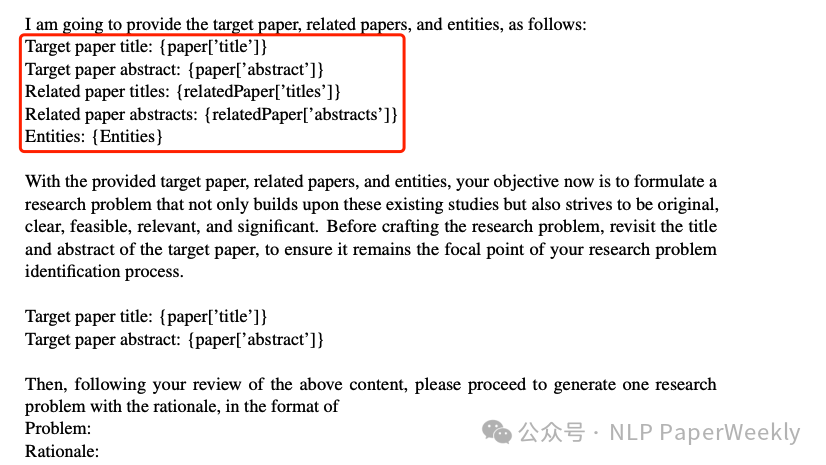

说明:知识增强的内容会放到prompt的context中作为输入,注意core paper选择3个月超过100个引用次数的文章,而relevant paper利用abstracts的相似度来过滤挑选更相关的文章,确保focus在相关的领域。其输入格式如下:

步骤三:Iterative Research Idea Refinements with Human Preference-Aligned LLM Agents(为了模拟人类研究过程中通过peer讨论来迭代优化,这里使用多个LLM代理(ReviewingAgents)根据特定标准提供评审和反馈来迭代优化。)

•评审和反馈:生成的科研想法(问题、方法和实验设计)根据特定标准进行评估。

•迭代改进:基于ReviewingAgents的评审和反馈,ResearchAgent进一步更新和改进已经生成的科研想法。

说明:Review Agent其实也是以LLM来实现,但是引入了人类的一些专家经验,要求如下:

此外,为了使机器生成的评估与人类判断保持一致,本文还提出了一种自动生成与人类偏好一致的评估标准的方法。这些标准是通过少量人类注释生成的,然后用于指导ReviewingAgents的评估。

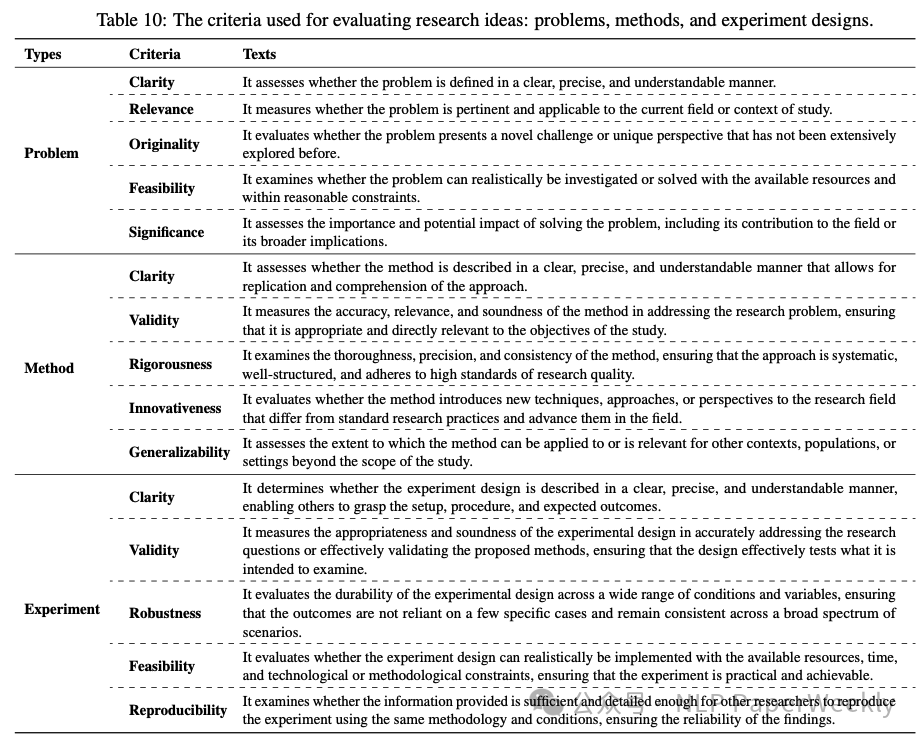

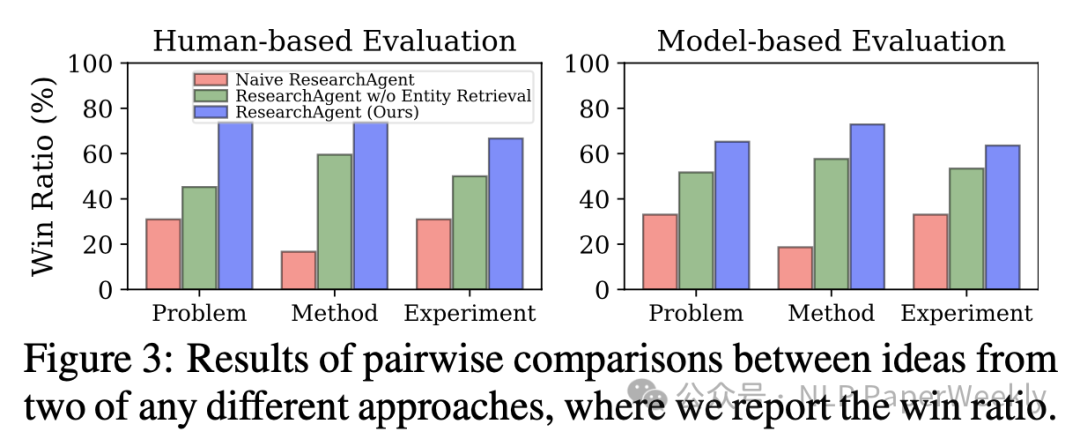

说明:问题识别,方法开发,实验设计都有相应的评分标准,其中问题识别的评分标准如下:

3 Conclusion

ResearchAgent使用一种名为“迭代研究想法精炼”的方法,该方法结合了利用大型语言模型评估和来自人类判断的反馈。实验结果表明,ResearchAgent在多个领域生成研究想法方面优于现有基线,显示了其在鼓励创造性、清晰性和有效性方面的潜力。

4 Limitation

研究提出的 ResearchAgent 虽然在提升科研效率方面显示了潜力,但仍存在若干限制,需要未来的工作进行改进:

• 目前使用的实体中心知识库构建基于文献的标题和摘要,可能无法充分捕获更广泛和细节的科学术语,未来工作可能需要扩展文献的范围,提高实体识别器的准确性。

• 研究的后续阶段——实验验证还需大量人力,研究的自动化程度有待提升。

二、详细内容

1 实验设置

数据选择:实验使用的数据来源于Semantic Scholar Academic Graph API[1],这是一个学术文献数据库,选择的数据集包括2024年5月1日之后发表的、具有高引用次数(超过20次)的论文,这些论文被视为核心论文。

核心论文抽样:从高引用次数的论文中随机抽取300篇作为实验的核心论文。这些核心论文将用于生成和评估300个研究想法。

模型和基线比较:由于研究想法生成是一个新任务,没有现有的基线模型可以直接比较,因此,作者比较了完整的ResearchAgent模型与以下变体:

• Naive ResearchAgent:仅使用核心论文生成想法。

• ResearchAgent w/o Entity Retrieval:使用核心论文及其相关引用,但不使用实体检索。

• ResearchAgent:完整模型,结合了相关引用和实体。

评估方法:由于没有标准答案,评估包括基于模型的自动评估和人类评估。

人类评估:选择至少发表过三篇论文的专家进行评估,评估包括为每个标准打分和对不同模型生成的想法进行成对比较。

实现细节:使用GPT-4作为所有模型的基础,使用BLINK实体链接器[2]提取实体并构建以实体为中心的知识库。

2 整体效果评估

模型和基线比较:由于研究想法生成是一个新任务,没有现有的基线模型可以直接比较,因此,作者比较了完整的ResearchAgent模型与以下变体的差异:

• Naive ResearchAgent:仅使用核心论文生成想法。

• ResearchAgent w/o Entity Retrieval:使用核心论文及其相关引用,但不使用实体检索。

• ResearchAgent:完整模型,结合了相关引用和实体。

说明:

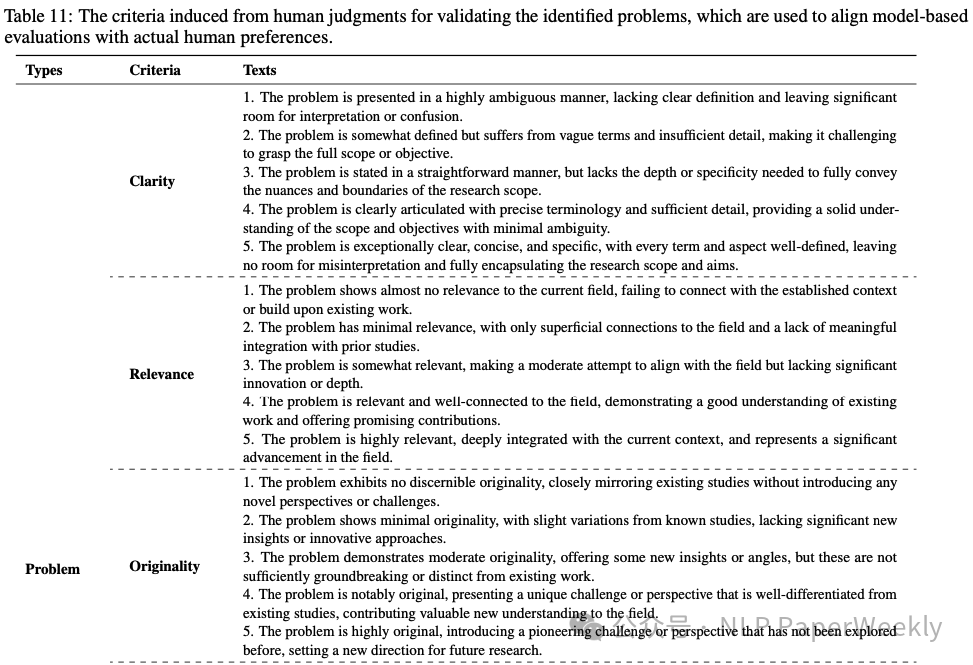

1.评估方法:研究想法的生成通过两种评估方式进行验证,人类评估(左侧)和基于模型(GPT4自动评估)的评估(右侧)。

2.多个标准:每个研究想法根据五个不同的标准进行评分,包括原创性、清晰度、相关性、可行性和重要性等。

3.综合评分:除了每个单独的标准评分外,还有一个平均分数,它提供了对每个想法整体质量的综合视图。

结论:ResearchAgent,完整模型,结合了相关引用和实体这种方法效果最好。说明了本文提到的每个方法都能给整体agent带来不错的收益。

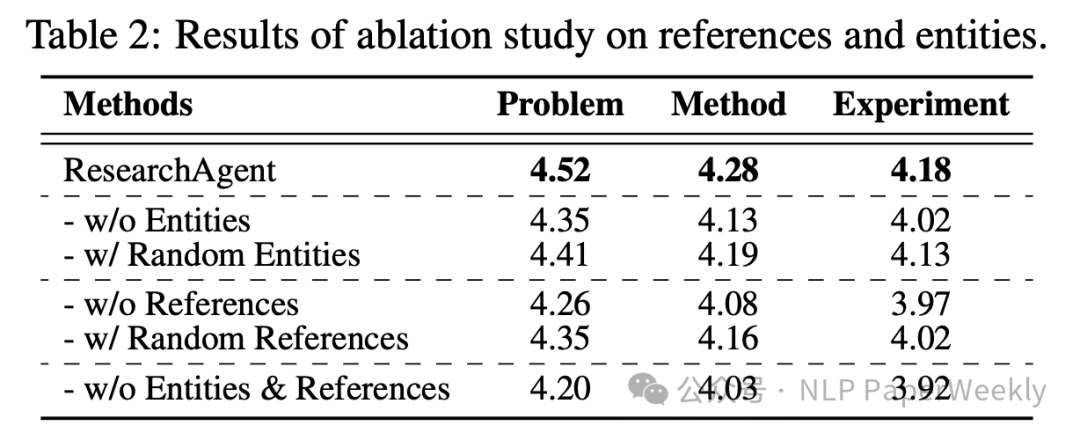

2 消融实验

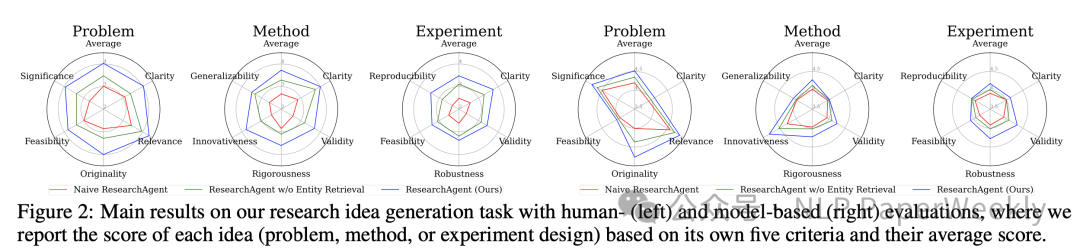

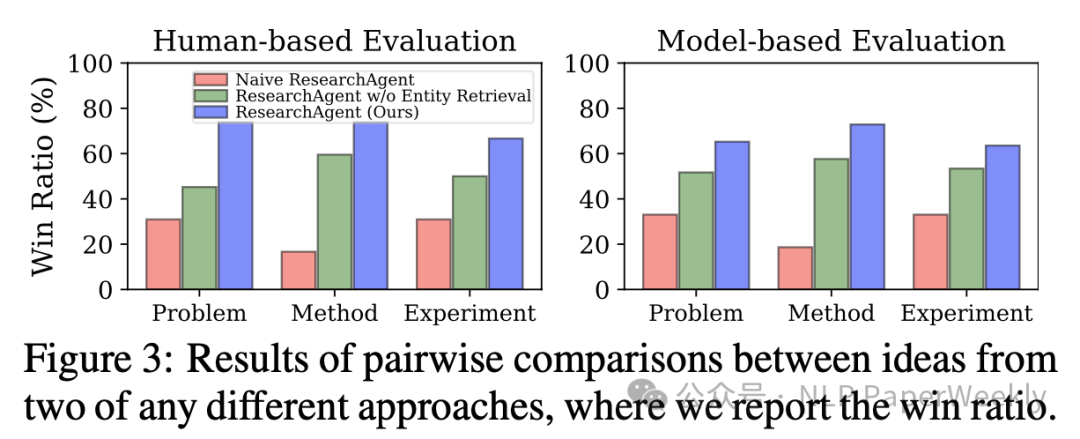

3.1 各模块胜率对比

结论:ResearchAgent,完整模型,结合了相关引用和实体这种方法胜率最高。同样说明了本文提到的每个方法都能给整体agent带来不错的收益。

3.2 引用和实体对各模块的影响

说明:每种消融变体在生成问题(Problem)、方法(Method)和实验设计(Experiment)方面的性能评分。

• 不使用实体检索(w/o Entities)的情况。

• 使用随机实体(Random Entities)替代实际实体的情况。

• 不使用参考文献(w/o References)的情况。

• 使用随机参考文献(Random References)替代实际参考文献的情况。

• 同时不使用实体和参考文献(w/o Entities & References)的情况。

结论:参考文献和实体的重要性。实体检索以及参考文献对于生成高质量的研究想法至关重要。

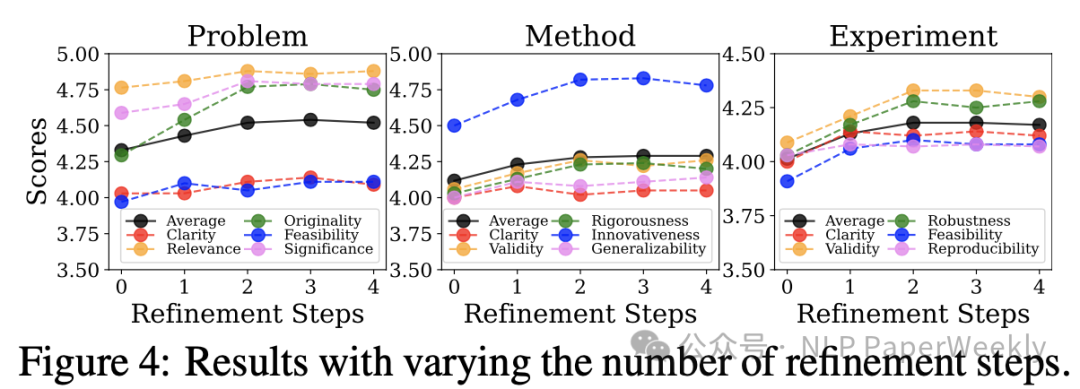

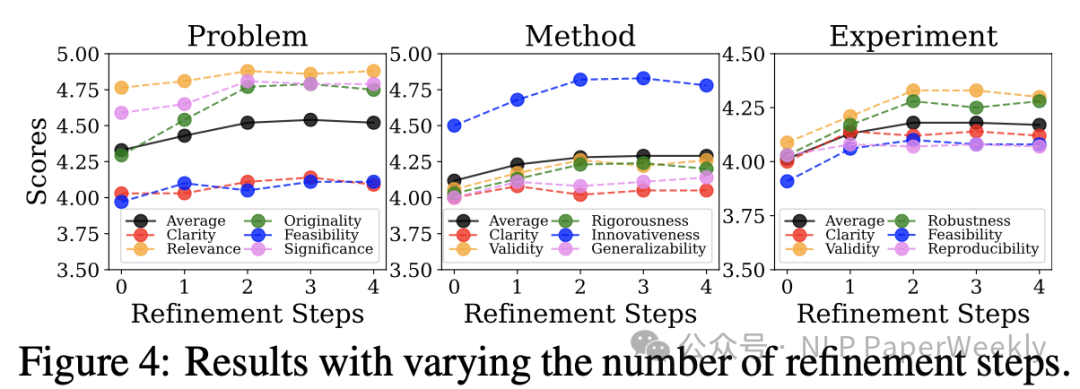

3 review次数越多效果越好

说明: 这里的“迭代改进步骤”指的是ResearchAgent系统使用ReviewingAgents进行的多轮评审和反馈过程,目的是提升研究想法的质量。

结论: 大部分评分点,随着review次数越多,效果越好,不过在3轮以后有一些下降,可能是饱和了。

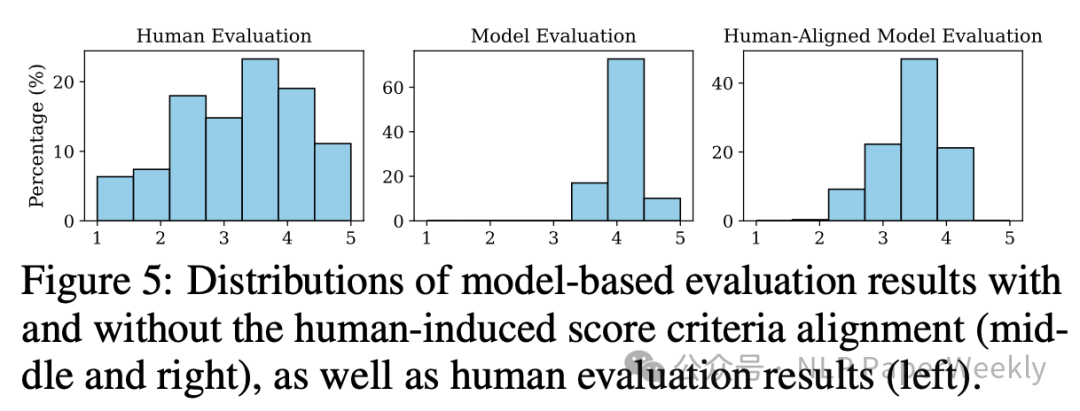

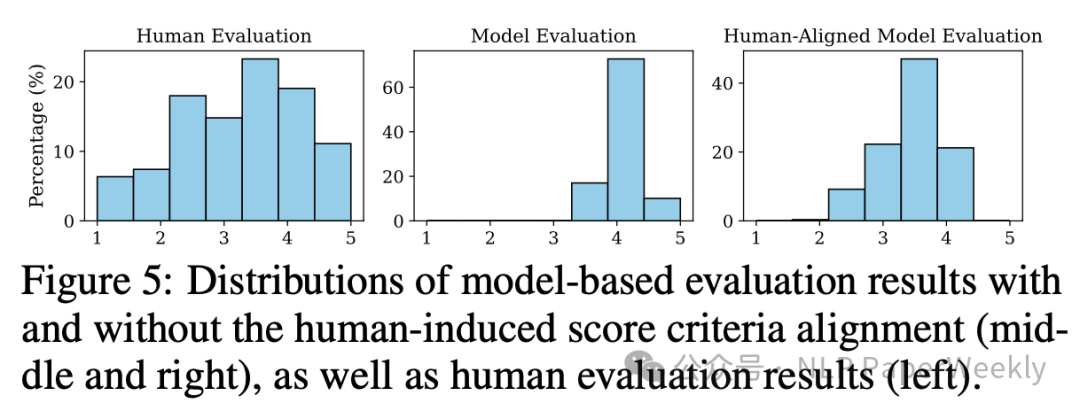

4 人类引导的评分标准对齐在自动评估任务中的重要性

说明:该结果说明了模型评估结果的分布,比较了三种不同评估方法的得分分布情况。

1.人类评估结果(左侧):这部分展示了人类评估者给出的评分分布。由于人类评估者对研究想法的质量有直观的理解,他们的评分分布可以作为评估标准的参考。

2.模型评估结果(中间):这部分展示了模型在没有进行人类评分标准校准的情况下给出的评分分布。由于模型可能没有完全理解人类评估的细微差别,因此其评分分布可能与人类评估结果有所不同。

3.人类对齐模型评估结果(右侧):在这部分,模型评估使用了基于人类评估结果导出的评分标准。这意味着模型评估试图与人类的评估偏好对齐,以提高评估的相关性和准确性。

结论:从图中可以看出,未经过人类评分标准校准的模型评估结果(中间)的分布可能与人类评估结果(左侧)有显著差异,这表明模型在没有人类指导的情况下可能无法准确捕捉到研究想法的质量。然而,当模型评估与人类评分标准对齐后(右侧),其评分分布与人类评估结果更加接近,显示了校准过程的有效性。这表明通过将模型评估与人类评估标准对齐,可以提高模型评估的质量和可信度。

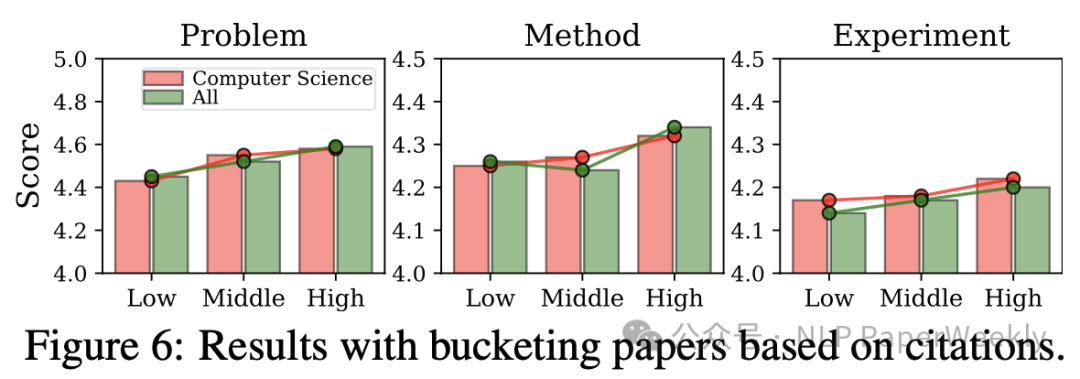

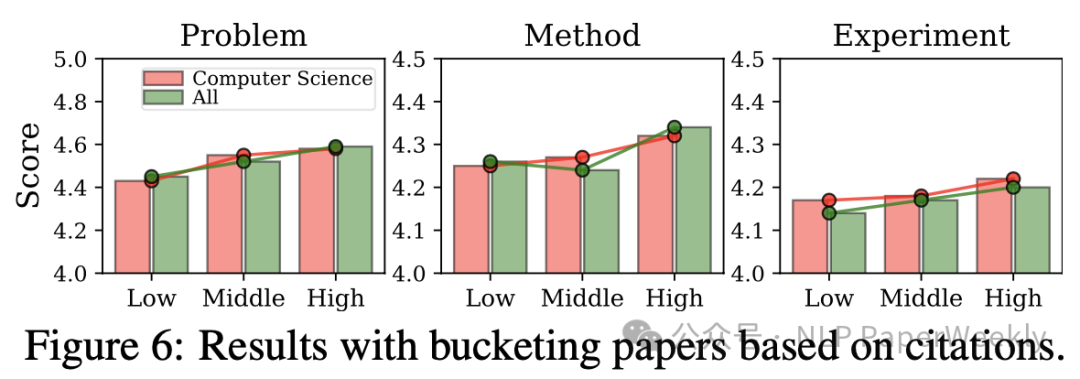

5 论文的引用次数与生成的研究想法质量之间存在正相关

说明:低、中、高引用次数的组别,以此来代表论文的影响力或“影响力”。然后,对于每个组别内的论文,使用模型评估(可能是GPT-4或其他类似的语言模型)来确定由这些论文生成的研究想法的平均质量得分。

- 1.分组依据:论文根据被引用次数被分为三个不同的组别,这可能意味着“低”引用组别的论文相对较少被引用,而“高”引用组别的论文则被广泛引用。

- 2.得分分布:每个组别的论文生成的研究想法会根据预设的评估标准(如清晰度、相关性、原创性、可行性和重要性等)被赋予一个得分。

- 3.平均得分:图表可能会显示每个组别的平均得分,这表明了不同影响力水平的论文在生成研究想法时的平均质量。

结论:可以观察到论文的引用次数与生成的研究想法质量之间是否存在相关性,高引用次数的论文可能倾向于生成质量更高的研究想法。

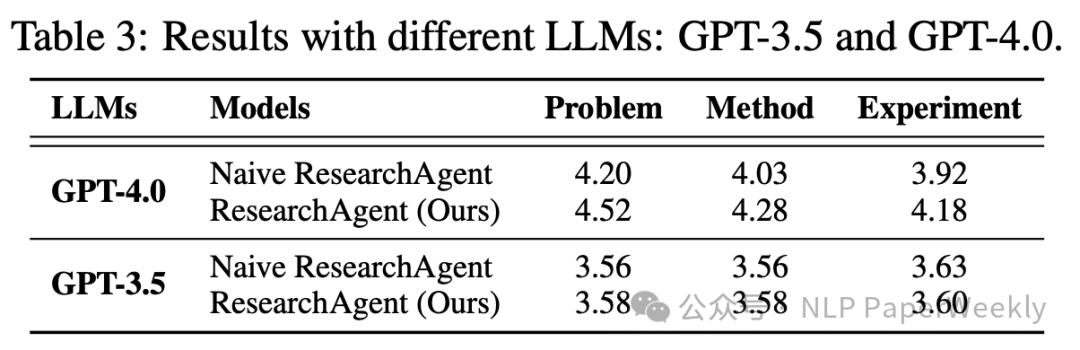

6 模型基座的影响

结论:GPT4.0比GPT3.5高了一大截,说明基座模型能力的重要性。同时本文的ResearchAgent也比Naive ResearchAgent高3个点左右,说明本文方法的有效性。

三、总结

结论1:模型在没有人类指导的情况下可能无法准确捕捉到研究想法的质量。引入人类反馈还是必要的,通过机器直接来review可能提供的反馈信息还不够。通过将模型评估与人类评估标准对齐,可以提高模型评估的质量和可信度。

结论2:内部引用知识以及外部图谱知识能提高idea的生成质量。 研究通过知识库和相关文献的结合使用,提升了大型语言模型在科学研究领域内创意生成的质量。

结论3:ReviewAgent迭代优化能显著提升研究创意。 研究设计的多个评审代理加强了生成的研究创意的迭代改进过程,使其更加新颖、有效和清晰。

结论4:原始core paper的质量也非常重要,高引的paper生成的idea质量更好。

引用链接

[1] Semantic Scholar Academic Graph API: https://www.semanticscholar.org/product/api[2] BLINK实体链接器: https://aclanthology.org/2020.emnlp-main.519.pdf

本文转载自NLP PaperWeekly,作者: NLP PaperWeekly