AI生成3D主题乐园,角色建筑批量生成,风格保持一致 | SIGGRAPH 2024

最少只需1个3D样例,即可生成3D主题乐园。

来自香港城市大学、上海人工智能实验室和南洋理工大学S-Lab的研究人员提出了一种名为ThemeStation的新颖框架。

它可以从少量3D样例中生成主题一致的高质量3D画廊。

还能基于文本控制,生成想要的3D资产。比如“穿正装的猫头鹰”。

要知道,虚拟世界和游戏等应用中,常常需要大规模主题一致的3D模型,如古城中的建筑群、虚拟生态系统中的怪物阵容。

尽管一位资深3D建模师可以创作出若干主题一致的作品,但要创建大规模内容丰富、风格一致的3D画廊却是一大挑战。

即便最近的3D内容生成(3D AIGC)在文本到3D、图像到3D等领域取得了长足进展,大大降低了3D内容创作的门槛。但由于输入模态中3D信息有限,它们仍然存在3D模糊和不一致的问题,且无法充分保证与输入样例主题的一致性。

因此研究人员提出了这项工作。目前该论文已被SIGGRAPH 2024接收,方法已开源。

由主题驱动的3D到3D生成

ThemeStation的主要贡献包括:

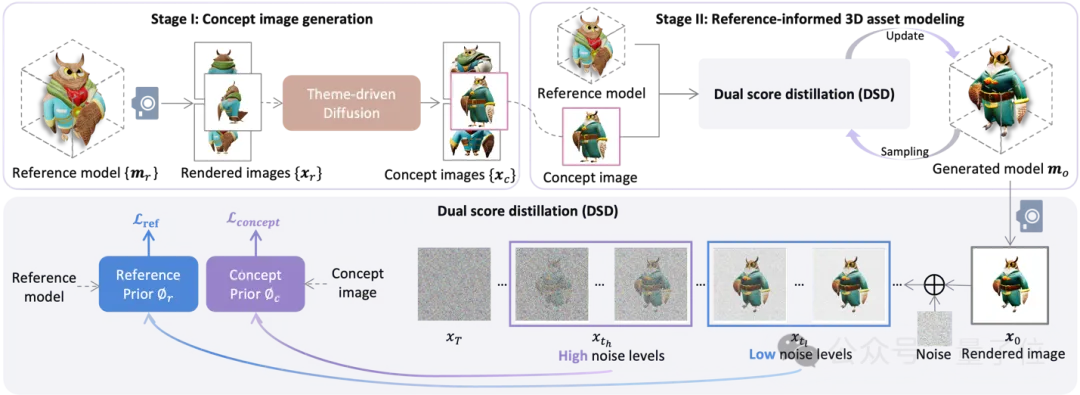

- 提出了一种用于主题驱动3D到3D生成的两阶段框架,其目标是仅从一个或几个3D样例生成在主题一致性和内容多样性方面均符合要求的新3D资产。

- 首次尝试将扩散先验扩展到3D到3D内容生成这一挑战性任务上。

- 引入了双重分数蒸馏(DSD),通过在不同噪声水平应用参考先验和概念先验,实现了在3D到3D生成中同时使用两种互相冲突的扩散先验。

与现有的文本到3D、图像到3D的技术不同,ThemeStation接受3D样例作为输入。与文本和图像相比,3D样例可以提供更多关于几何和纹理的3D信息,大大减少了3D生成中的多视角不一致问题,使得生成更高质量的3D模型成为了可能。

然而,直接在少量3D样例上训练的3D生成器缺乏先验信息,只能简单地重复、缩放和微调输入样例,无法生成多样化且主题一致的3D资产。为此,ThemeStation采用了一种两阶段的生成方案,模仿了实际3D建模工作流程:

第一阶段:主题驱动的概念图像生成

在第一阶段,ThemeStation利用给定3D样例的多视角渲染图像对预训练的文本到图像(T2I)扩散模型进行了微调,以生成一系列与输入3D示例保持一致主题的概念图像,类似于实践中的概念草图设计过程。与DreamBooth等主体驱动的微调技术不同,该阶段的目标并非完全拟合给定3D样例。

因此,在该阶段,研究人员使用低学习速率和少训练步骤来微调预训练的扩散模型以提取3D样例中的主题信息并避免过拟合,最终实现了主题一致且多样化的3D变体概念草图生成。

第二阶段:参考信息驱动的3D资产建模

在第二阶段,ThemeStation进行参考信息驱动的3D资产建模。给定一张第一阶段生成的概念草图和输入的3D样例,ThemeStation,首先使用现有的图像到3D技术生成粗糙的3D模型作为初始化。然后,它使用所提出的双重分数蒸馏(DSD)损失函数来逐步优化这个初始模型。

双重分数蒸馏(DSD)损失是ThemeStation的技术核心,它结合了两种扩散先验:概念先验和参考先验。概念先验来自第一阶段合成的概念草图,通过整体调整布局和颜色来确保概念图的重建。参考先验则来自输入的3D样例,通过利用多视角渲染图像和法线图中的3D一致信息来恢复更丰富的高频细节。

具体而言,研究者分别使用概念草图和输入3D样例的渲染图片微调了两个定制化的T2I扩散模型来提供不同的扩散先验。

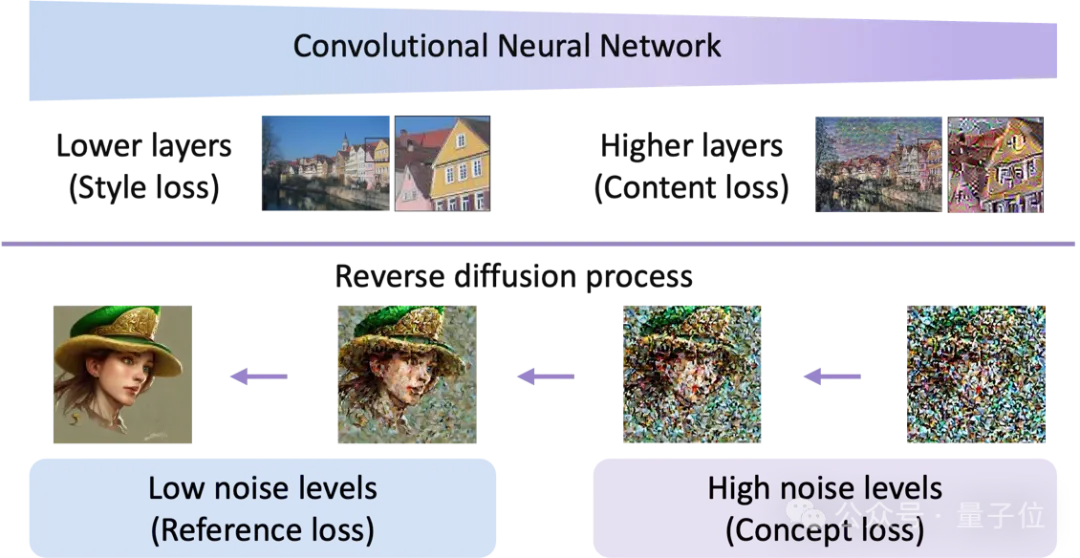

值得注意的是,由于概念图和输入的3D样例并非同一3D物体,同时使用这两种互相冲突的先验信息作为优化目标并非易事。与简单组合这两种先验(可导致严重的损失冲突)不同,ThemeStation的研究者创新性地根据扩散模型的去噪时间步分配不同的先验损失——在高噪声下控制全局布局(概念先验)并在低噪声下精雕细琢(参考先验)。

在这样的设计下,两个冲突的先验得以融合,避免了信息损失。这一设计灵感来自图像风格迁移算法和T2I扩散模型中反向扩散过程的基于时间步长的由粗糙到细致的动态变化,如下图所示:

由此基于ThemeStation,就能快速得到主题风格一致的大量3D资产。

项目主页:https://3dthemestation.github.io/

代码:https://github.com/3DTopia/ThemeStation

论文:https://arxiv.org/abs/2403.15383

本文转自 量子位 ,作者:量子位