ICLR2024杰出论文——Never Train from Scratch!

今天给大家介绍一篇ICLR2024的杰出论文,这篇文章深入探讨了自监督预训练对于使用Transformer进行长序列建模的重要性。

论文标题:Never Train from Scratch: FAIR COMPARISON OF LONGSEQUENCE MODELS REQUIRES DATA-DRIVEN PRIORS

下载地址:https://arxiv.org/pdf/2310.02980

1、背景介绍

在一些长序列建模数据集benchmark中,例如Long Range Arena,使用RNN或者SSM这种基础的序列模型效果要显著优于Transformer模型。

然而,文中提出这种评估方式并不科学。现有的基于LRA这类benchmark评估模型效果的方法,都是直接在这些长序列上从0开始拟合目标。这种情况下,Transformer的效果确实会比RNN、SSM等模型效果差很多。

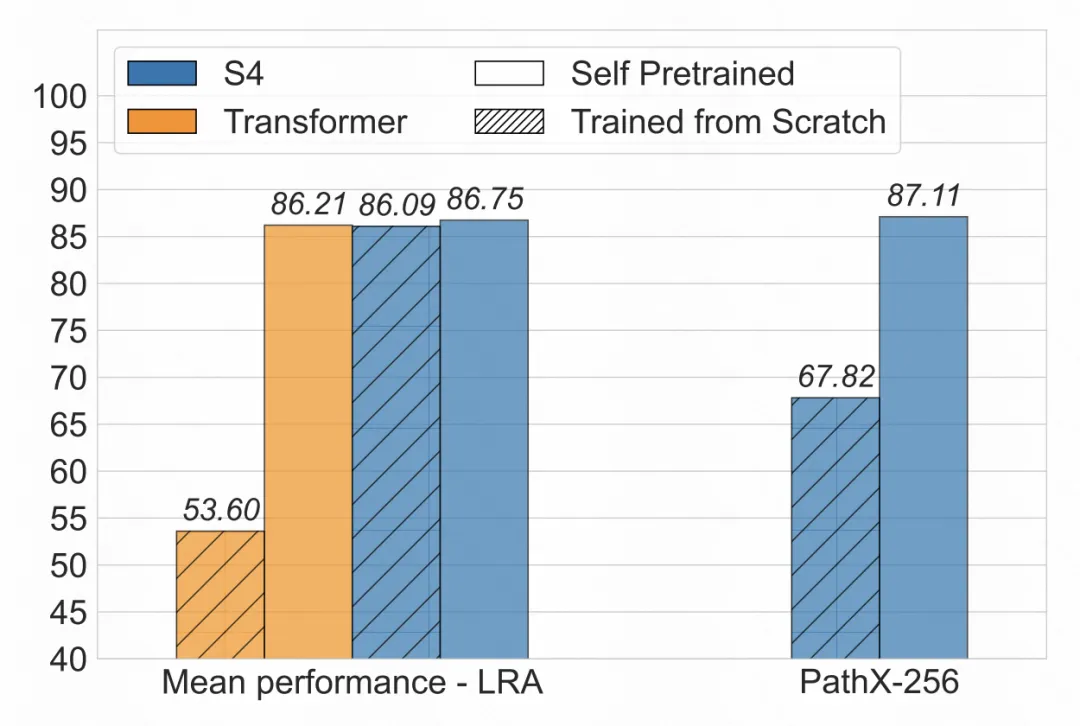

但是如果使用这些数据先对模型做一下预训练,就会发现Transformer的效果和SSM基本一致。如下图所示,从头训练,Transformer的效果和S4有很大差距;而如果使用mask language model等预训练任务进行自监督学习,就会发现Transformer的效果取得了大幅提升。同时,S4的效果也会有一定的提升。

2、实验方法

针对上述现象,文中提出在进行长序列benchmark等任务上的评估时,直接从0训练对比不同模型效果是不公平的,因为模型并没有被充分训练。文中提出应该先用SFT在目标数据上进行训练,使模型有一个良好的初始化点,再进行finetune,才能实现不同模型公平的对比。

文中主要在LRA数据集上进行Transformer和SSM的效果对比验证。LRA主要包括6个长序列分类任务,包括长文本的匹配任务、列表分类任务、一维化图像的分类任务等等。

在训练方法使用,增加预训练缓解,使用自回归预测下一个token,或者mask序列中部分token进行还原,作为自监督学习的目标。整个预训练都是在目标数据集中进行的,不会引入其他外部数据。

3、实验效果

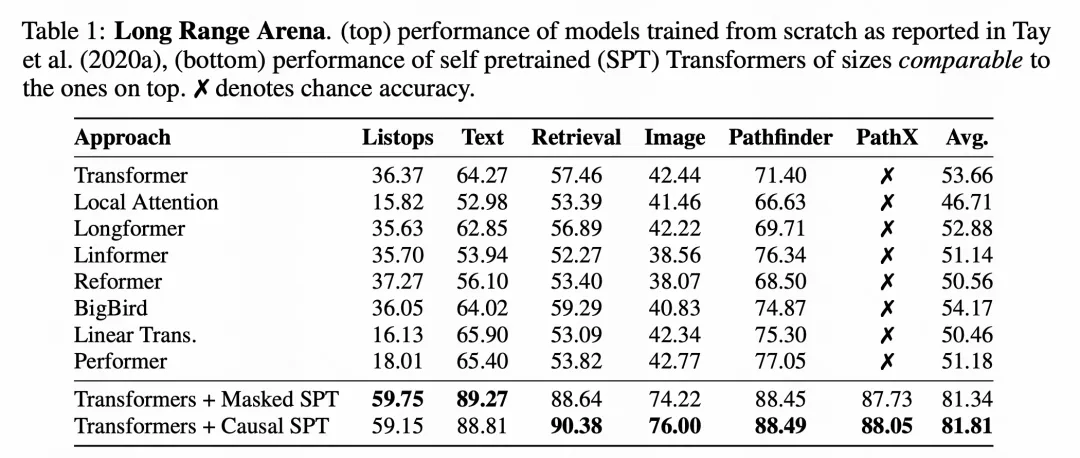

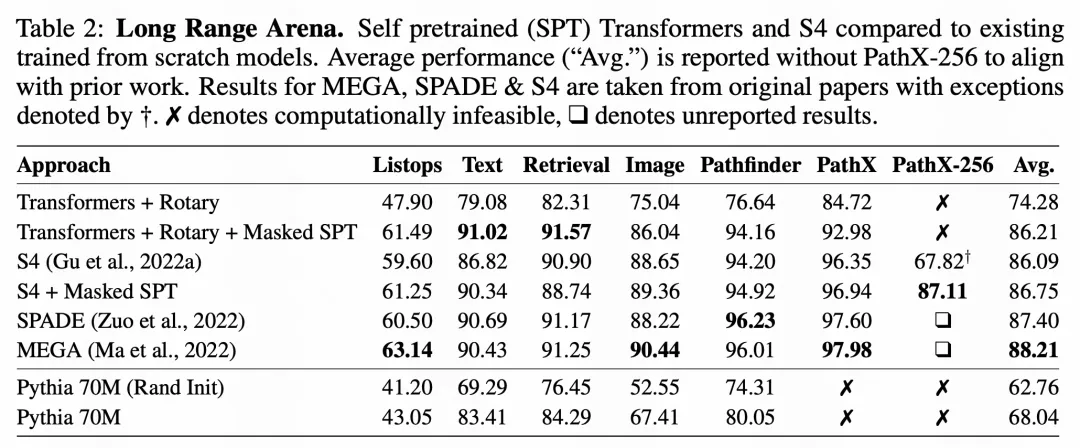

下表是一个主要的实验结果,其中上半部分是各个模型从头进行训练的效果,由A benchmark for efficient transformers. In 9th International Conference on Learning Representations(ICLR 2021)论文中发表,包括各类优化版Transformer效果。下面两行是本文提出的使用预训练进行Transformer充分训练后,再在目标数据上进行finetune。可以看到,经过SFT,Transformer的效果得到了非常大幅度的提升。

即使是在S4模型上,引入自监督预训练后,在某些困难数据集上也会取得提升。并且从下面实验来看,充分预训练的公平对比下,Transformer效果和S4接近,远没有从头训练时二者效果差异大。

由此可见,充分的自监督训练,找到一个比较好的初始点,对于公平对比不同模型性能是非常重要的。同时,这也启发我们在使用Transformer这类inductive bias较少的模型时,可以通过自监督学习来提升模型效果。

本文转载自 圆圆的算法笔记,作者: Fareise