《2024年人工智能准备度报告》发布!6成企业拟采用AI,投入生产的仅占其中三分之一;OpenAI稳坐王位; 原创

整理 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

最近,人工智能公司 Scale AI发布 《2024年人工智能准备度报告》。

该系列报告已经是连续第三年进行发布,本次报告调查采访了1800 多名在企业中构建或应用人工智能解决方案的人工智能从业人员,以获得相关的见解及结论。

旨在通过企业的AI应用现状,为大模型/人工智能的开发与构建、利用现有的基础模型的应用及测试和评估提供参考与建议。

划重点,该报告发现:

- 60%的受访者正在尝试使用生成性AI模型或计划在未来一年内这样做,但只有21%的公司已经将这些模型投入生产。

- 72%的公司计划在今年增加他们的人工智能投资。

- 89%采用人工智能的公司从开发新产品或服务的能力中受益。

- 一些受访者提到,缺乏合适的工具和框架是阻碍人工智能项目进展的一个挑战。

- 报告强调了组织需要在多个维度上优化和评估他们的人工智能准备度,包括开发模型、利用基础模型和测试模型。

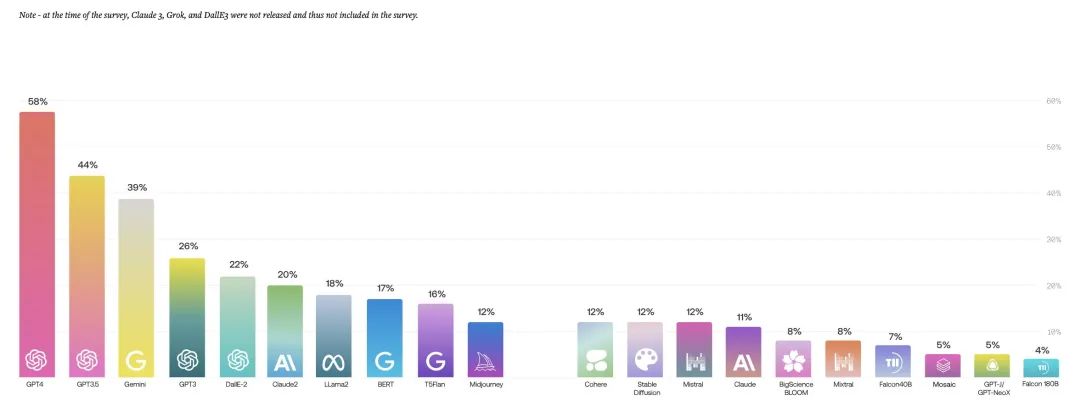

1.企业的选择:OpenAI占“半壁江山”,LLama领跑开源

调查结果显示,OpenAI是绝大多数企业的选择,在前五中除了来自谷歌的Gemini排在第三位以外,其余产品均来自这家AI明星公司。

LLama2以18%的采用率位列第7,开源模型中第1。而谷歌开源的BERT、T5模型,作为NLP领域的老将,也有比较高的采用率。

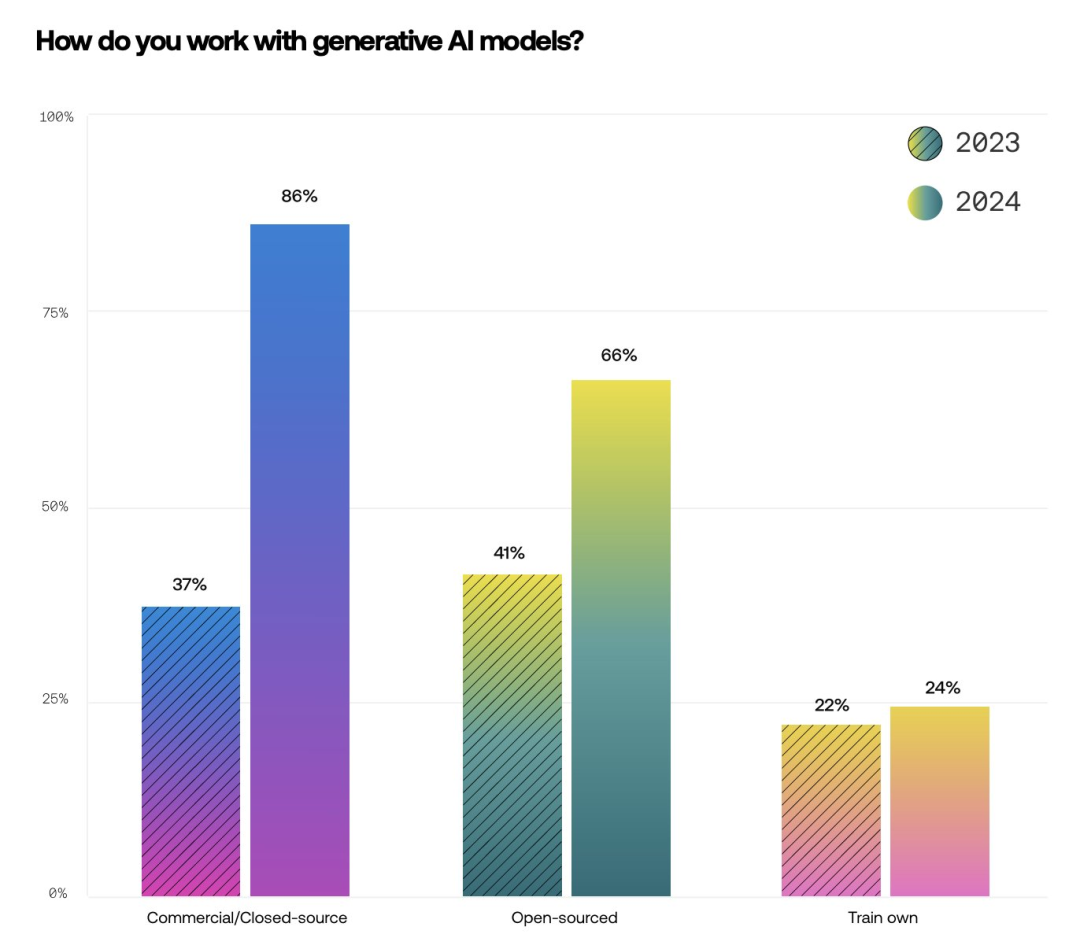

综合之前的调查数据来看,在模型的开源和闭源之间,企业的AI战略决策、模型选择的偏好是持续演变的。模型的开源生态会很大程度上影响企业的选择。

今年,闭源模型的使用增长最多,有86%的组织使用这些模型,而前一年的比例是37%。这很可能是由于多种因素的结合。许多组织已经与云服务提供商签订了现有合同,而这些提供商又与闭源模型开发者有合作关系,这使得使用闭源模型变得更加容易。此外,许多闭源模型在开箱即用的情况下也比开源模型表现更好。

尽管如此,开源模型的使用也有所增长,从41%增加到66%。这可能是由于开源模型为微调(fine-tuning)和托管(hosting)提供的灵活性。在2024年,自己训练模型的组织偏好变化最小,从22%升到24%。

图片

图片

值得注意的是,在调查进行时Claude 3, Grok, DallE 3,LLama3都没有发布,因此没有相关数据。尤其是性能强大到比肩 GPT-4 的 LLama3,能否给OpenAI绝对领先的地位一点震撼,我们无从得知。

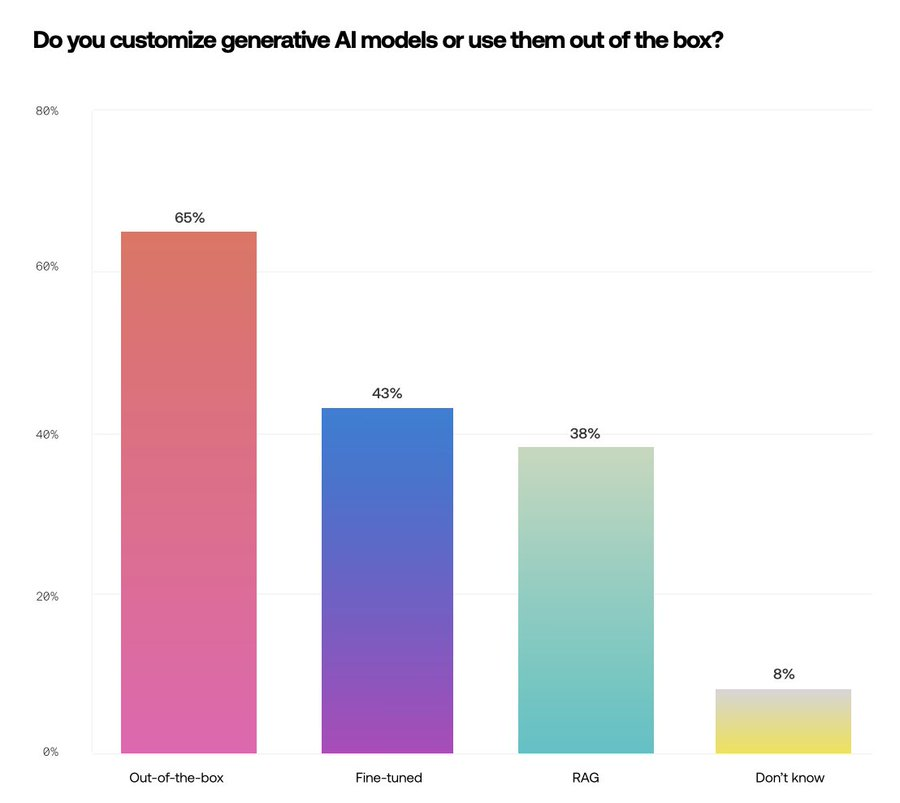

2.模型的采用:定制or开箱即用?

根据调查,受访者中65% 的选择了开箱即用,43%选择了微调模型,38%选择了RAG。受访者的多选情况,可能来自于企业多模型部署的策略。

应用人工智能的组织正在寻求通过提示工程、微调模型和检索增强生成(RAG)使得AI更具价值。

尽管有优化基础模型的愿望,但65%的组织使用开箱即用的模型。同时,微调可以为特定任务或数据集定制模型,显著提高其在目标应用中的性能和准确性。RAG通过在生成过程中动态整合外部信息进一步增强了这一点,使模型能够产生更相关且上下文丰富的输出。

图片

图片

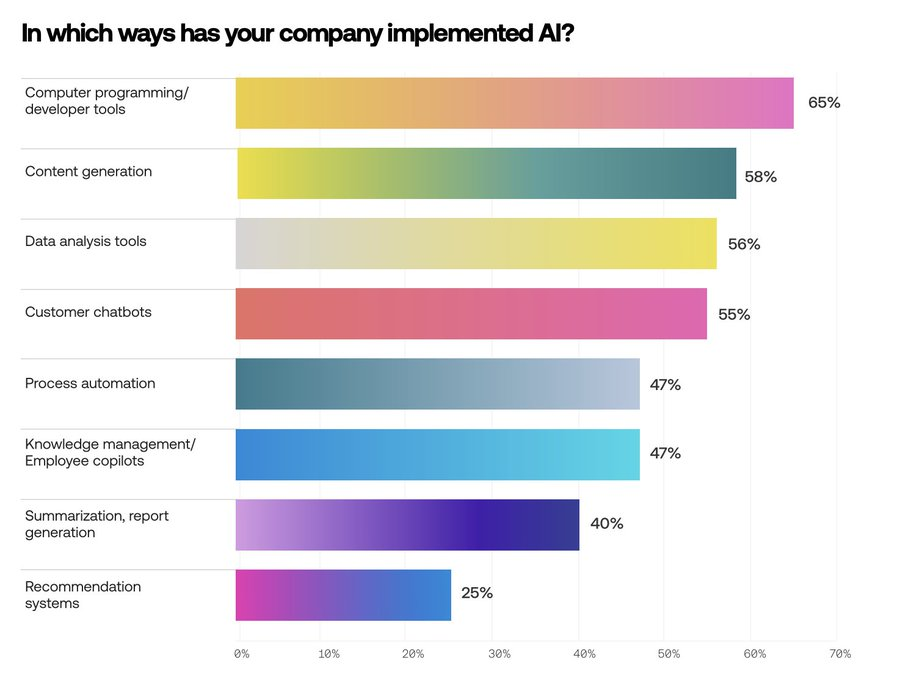

3.企业将在哪些工作中应用AI?

65%的受访者提到了使用AI进行编程相关的需求,但考虑到 Cognition、Augment 等公司正在筹集的大额融资也就不足为奇。

紧随其后的AI应用领域依次是,内容生成、数据分析工具、客服聊天机器人、流程自动化工具、知识库管理、总结和报告生成、智能推荐系统。

此外,只有 4% 的企业没有实施人工智能的计划 。

图片

图片

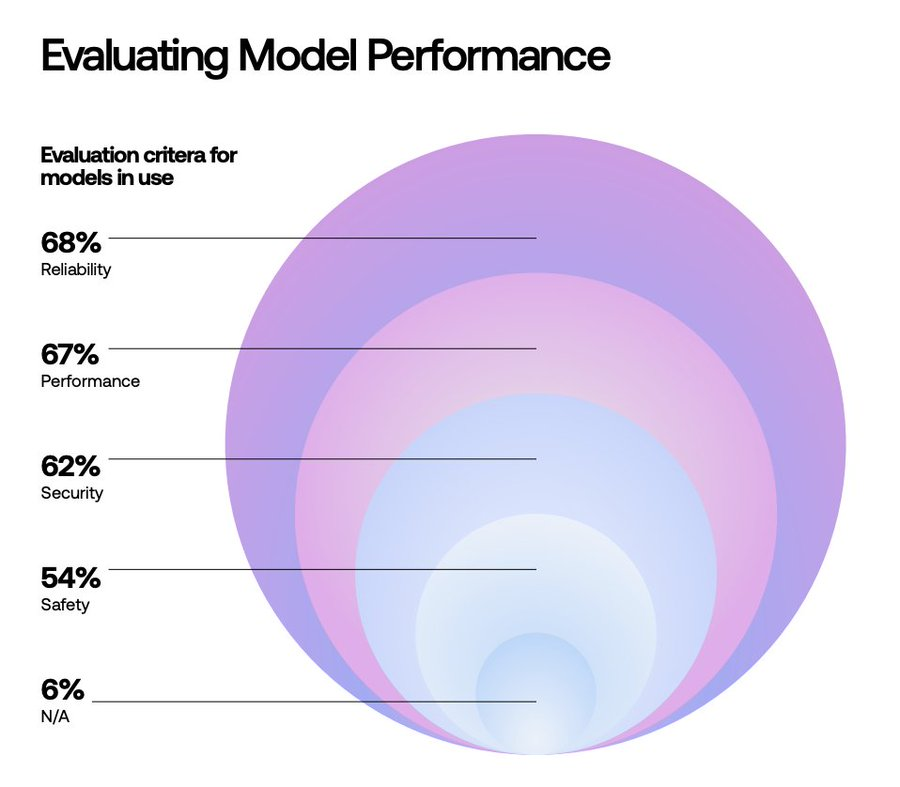

4.企业如何评估模型性能?

对于企业来说,模型的可靠性和性能的重要程度不相上下,这些直接与企业的使用甚至是业务的收入挂钩。比较来说,人们对于大模型的数据安全及安全性的评估优先级较低。

图片

图片

人工智能的焦点正从“卷”模型性能转向实际的应用落地,可以预见的是,AI技术将在企业中变得更加易用和普及。

72%的公司计划在本年度增加对AI的投资,验证着市场对AI潜力的认同。尽管有人担忧AI繁荣的犹如泡沫可能会一朝破灭,但实际情况可能恰恰相反——经过时间的洗礼,人工智能的神秘面纱将逐渐褪去,它将从前沿技术转变为像手机和电脑一样,成为我们日常生活中不可或缺的实用工具。

本文转载自51CTO技术栈,作者:伊风