深入探索个性化推荐新境界:AI通过语言理解你的喜好,效率提升131%

深入探索个性化推荐新境界 ——《Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation》论文解读

在个性化推荐系统的构建中,如何快速准确地识别用户偏好始终是一个挑战。特别是在冷启动情境下,缺乏用户历史数据使得这一任务更为艰巨。《Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation》这篇论文为我们提供了一种新颖的解决方案,通过结合贝叶斯优化和大型语言模型(LLM),在自然语言处理(NLP)的框架下进行有效的用户偏好激发(PE)。David Eric Austin与Anton Korikov等研究者们提出的PEBOL算法,利用自然语言推理(NLI)技术来维持对用户偏好的信念,并采用决策理论策略,如汤普森采样(TS)和置信上界(UCB),来指导语言模型查询的生成。这一方法在冷启动自然语言偏好激发对话中展现出显著的性能提升,相较于传统的单一大型语言模型,PEBOL在10轮对话后实现了高达131%的准确率提升。 通过这篇文章,您将获得:

- 前沿技术:了解如何利用最新的贝叶斯优化和LLM技术来提升推荐系统的个性化水平。

- 实际应用:探索PEBOL算法如何在没有用户历史数据的情况下,通过自然语言对话快速识别用户偏好。

- 性能对比:见证PEBOL与传统方法在偏好激发任务中的性能差异,以及它是如何在对话中动态平衡探索与利用的。加入我们,一起揭开个性化推荐系统新篇章的序幕,探索如何通过技术创新提升用户体验。

引言:探索自然语言偏好获取的新方法

在个性化推荐系统中,如何高效地从用户的自然语言(NL)描述中获取其偏好,是一个长期而复杂的问题。传统的偏好获取(PE)方法,如贝叶斯优化和多臂老虎机,通常依赖于用户对项目的直接评分或比较,这在用户对大多数项目不熟悉的情况下显得尤为困难。随着大型语言模型(LLM)的发展,我们有了通过自然语言对话进行偏好获取的技术基础,但这些模型在进行策略性的多轮对话查询时往往能力有限,难以有效平衡探索与利用,可能导致过度关注已揭示的偏好或低效探索低价值项目。

本文介绍了一种新的自然语言偏好获取方法——PEBOL(偏好获取与贝叶斯优化增强的LLM),它通过自然语言推理(NLI)来推断项目偏好,并利用基于决策理论的获取函数来指导查询生成,从而在自然语言对话中有效地学习用户的首选项目。这一方法不仅提高了偏好获取的效率,还通过贝叶斯优化形式化地处理了未知的用户偏好,为自然语言偏好获取领域提供了新的研究框架和方向。

论文标题:Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation

机构:University of Toronto, Ontario, Canada; University of Waterloo, Ontario, Canada

论文链接:https://arxiv.org/pdf/2405.00981.pdf

PEBOL算法介绍:结合贝叶斯优化与大语言模型

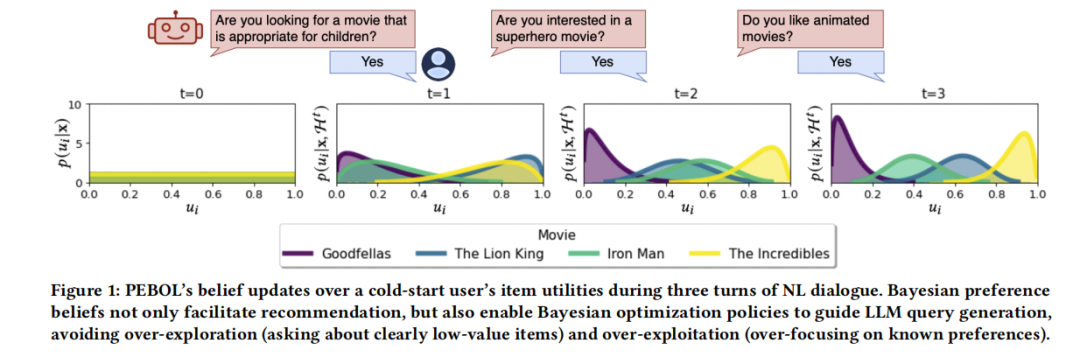

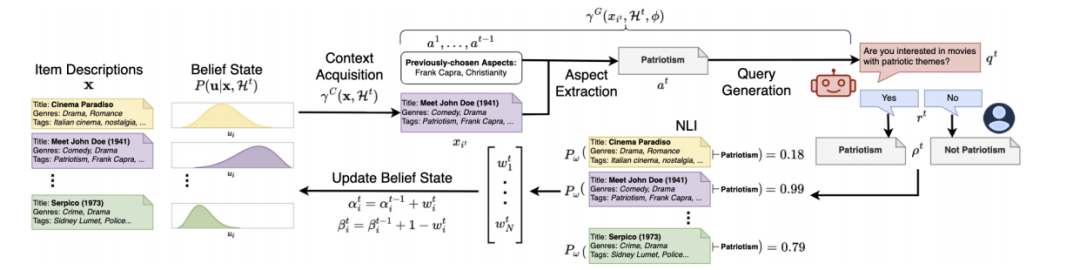

PEBOL(Preference Elicitation with Bayesian Optimization augmented LLMs)是一种新颖的自然语言偏好询问(NL-PE)算法,它通过结合贝叶斯优化和大型语言模型(LLM)来推断用户的物品偏好。这种方法首先利用自然语言推理(NLI)在对话话语和物品描述之间进行推断,以维护贝叶斯偏好信念;其次,引入基于LLM的获取函数,其中自然语言(NL)查询生成由决策理论策略如汤普森采样(Thompson Sampling, TS)和置信上界(Upper Confidence Bound, UCB)指导,以平衡探索和利用偏好信念。

1. 贝叶斯优化与决策理论的结合

PEBOL算法将贝叶斯优化的原理应用于NL-PE场景中,通过维护对用户偏好的概率信念来指导查询的生成。这种方法不仅考虑了用户的直接反馈,还通过NLI模型解析用户在自然语言交互中的隐含偏好。

2. LLM的应用与优化

在PEBOL中,LLM用于生成针对特定物品描述的查询,这些查询旨在通过询问用户对某些特征的偏好来揭示用户的兴趣。例如,系统可能会询问用户是否喜欢具有“爱国主义”主题的电影。此外,LLM在每一轮对话中都会根据当前的贝叶斯信念状态,选择性地引入新的物品描述,以优化查询的相关性和效率。

实验设计与方法

为了评估PEBOL算法的有效性,我们设计了一系列控制实验,通过模拟的NL-PE对话在多个自然语言物品数据集上测试算法的表现,并与单体GPT-3.5 NL-PE方法进行比较。

1. 实验设置

实验通过模拟用户与系统的交互来进行,其中用户的偏好被系统未知,系统需要通过连续的对话轮次来逐步学习和推断这些偏好。每个实验模拟100个用户,每个用户偏好一个特定物品,系统的目标是在对话中尽可能准确地识别出这些物品。

2. 数据集与模拟用户

我们使用三个真实世界的数据集:MovieLens 25M、Yelp和Recipe-MPR。这些数据集提供了丰富的物品描述,包括电影标题、餐厅描述和食谱信息,适合用于测试NL-PE系统的性能。

3. 性能评估

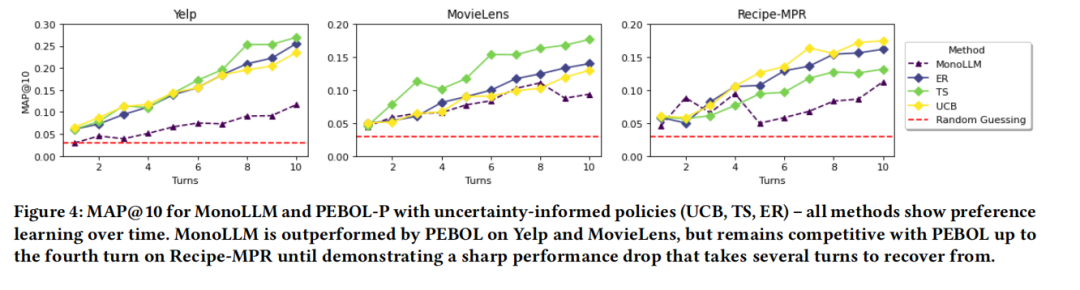

系统的性能通过多种指标评估,包括在10轮对话后的平均精确率(MAP@10)。此外,我们还考察了系统在不同用户噪声水平下的表现,以及不同获取策略(如TS、UCB和熵减)对性能的影响。

通过这些实验,我们能够详细了解PEBOL算法在实际NL-PE场景中的应用效果,以及与现有技术相比的优势和潜在的改进方向。

实验结果与分析

在对PEBOL(使用贝叶斯优化增强的LLM进行偏好询问)与传统的单体GPT-3.5 NL-PE方法的比较中,我们通过控制的NL-PE对话实验,对多个NL项目数据集和用户噪声水平进行了数值评估。实验结果显示,在10轮对话后,PEBOL在MAP@10(最大平均精度@10)指标上相比GPT-3.5实现了高达131%的提升,尽管PEBOL使用的是一个较小的400M NLI模型进行偏好推断。

通过实验,我们观察到PEBOL在不同数据集上的表现均优于MonoLLM。在Yelp数据集上,PEBOL的MAP@10提升了131%,在MovieLens上提升了88%,在RecipeMPR上提升了55%。这一结果表明,PEBOL的增量贝叶斯更新机制可能使其不太容易犯下灾难性的错误。

此外,我们还研究了二元响应与概率响应的PEBOL表现(PEBOL-B与PEBOL-P)。总体来看,PEBOL-P的表现更佳,这可能是因为PEBOL-B丢弃了来自蕴含概率的宝贵信息。特别是在MovieLens数据集上,从第二轮开始,概率蕴含的MAP提升至少为34%,尽管在Yelp上,使用二元更新的TS与最佳概率方法表现相当。

讨论PEBOL的优势与局限

优势:

- 效率提升:PEBOL在多轮对话中显著提高了推荐的准确性,特别是在处理大量数据集时,与传统的单体LLM方法相比,显示出更快的学习和适应用户偏好的能力。

- 探索与利用的平衡:通过贝叶斯优化策略,PEBOL能够有效地平衡探索和利用,减少了在已知偏好上的过度聚焦(过度利用)和在低价值项目上的资源浪费(过度探索)。

- 对话历史的有效利用:PEBOL通过跟踪对话历史来避免重复或无信息的查询,从而提高了系统的整体性能和用户体验。

局限:

- 模型复杂性:PEBOL的实现比单体LLM方法更为复杂,需要整合贝叶斯优化和自然语言推理(NLI)模型,这可能增加了系统的开发和维护难度。

- 对NLI模型的依赖:PEBOL的性能在很大程度上依赖于NLI模型的准确性。如果NLI模型的性能不佳,可能会直接影响PEBOL的推荐效果。

- 计算资源需求:尽管PEBOL减少了每轮所需的上下文量,但其仍然需要显著的计算资源来执行贝叶斯更新和查询生成,这可能限制了其在资源受限环境下的应用。

总体而言,PEBOL通过结合贝叶斯优化和LLM,为自然语言偏好询问提供了一个有效的解决方案,尤其适用于需要从冷启动场景快速学习用户偏好的应用。未来的研究可以探索如何进一步优化PEBOL的计算效率和准确性,以及如何将这种方法扩展到更广泛的对话推荐系统中。

未来研究方向与PEBOL的潜在改进

1. 多项和集合上下文选择的LLM基础获取功能:目前PEBOL系统在查询生成策略上主要采用单点选择策略,即每次只选择一个项目描述作为LLM查询生成的基础。未来的研究可以探索基于LLM的获取功能,使用成对比较或集合选择的上下文。这种多项上下文选择能够生成对比性查询,可能更有效地区分项目偏好。

2. 会话推荐系统中的NL-PE方法整合:将NL-PE方法如PEBOL整合到会话推荐系统架构中是另一个研究方向。这类系统需要在处理多种任务(如推荐、解释和个性化问题回答)的同时,获取用户在任意系统-用户话语对上的偏好。因此,算法需要能够在不仅仅是查询和响应的基础上,而是在更广泛的对话上下文中进行偏好获取。

3. 增强模型的解释性和控制性:尽管PEBOL通过贝叶斯优化增强了LLM的决策理论推理能力,但模型的解释性和控制性仍有待提高。未来的工作可以探索如何通过改进模型架构或调整训练过程来增强这些方面。

4. 响应噪声对性能的影响:用户响应的噪声是现实世界应用中常见的问题。研究PEBOL在不同噪声水平下的表现,并探索如何优化算法以适应高噪声环境,将是提高系统鲁棒性的关键。

总结:PEBOL在自然语言偏好获取中的创新应用及其意义

PEBOL(偏好获取与贝叶斯优化增强的大型语言模型)代表了在自然语言偏好获取领域的一项重要创新。它通过结合贝叶斯优化和大型语言模型(LLM)的优势,有效地解决了传统偏好获取方法在处理自然语言对话时的局限性。PEBOL不仅提高了偏好获取的效率和准确性,还通过其决策理论驱动的查询生成策略,优化了用户交互的质量。

PEBOL的核心创新在于其能够在完全冷启动的设置中,通过自然语言对话快速准确地识别用户的最高偏好项。这一点通过与传统的单体GPT-3.5方法的对比实验得到了验证,其中PEBOL在多个数据集和用户噪声水平上显示出显著的性能提升。

此外,PEBOL的设计充分考虑了探索与利用之间的平衡,通过动态调整查询策略来避免过度探索低价值项或过度利用已知偏好。这种策略的有效性不仅体现在提高推荐准确性上,也在于提升了用户的交互体验,避免了重复或无信息量的查询。

总之,PEBOL的开发和应用展示了利用先进的机器学习技术来改进自然语言处理任务的巨大潜力。未来的研究将进一步扩展这一框架的功能和应用范围,特别是在会话推荐系统中的整合使用,以及在更广泛的自然语言交互场景中的应用。

本文转载自 AI论文解读,作者: 柏企