首个ICLR时间检验奖出炉!3万被引论文奠定图像生成范式,DALL-E 3/SD背后都靠它

首届ICLR时间检验奖,颁向变分自编码器VAE。

这篇跨越十一年的论文,给后续包括扩散模型在内的生成模型带来重要思想启发,才有了今天的DALL-E3、Stable Diffusion。此外,在音频、文本等领域都有广泛应用,是深度学习中的重要技术之一。

论文一作、VAE主要架构师Diederik Kingma可是妥妥大佬一枚。现在他在DeepMind担任研究科学家,曾是OpenAI创始成员、算法负责人,还是Adam优化器发明者。

网友纷纷表示祝福:Well Deserved,并称VAE改变了游戏规则。

值得一提的是,荣获亚军的论文也同样具有代表性,其参与者包括OpenAI首席科学家的Ilya、GAN的发明者Ian Goodfellow。

与此同时,杰出论文奖也悉数颁出。

首届ICLR时间检验奖

首先来看荣获时间检验奖的论文讲了什么。

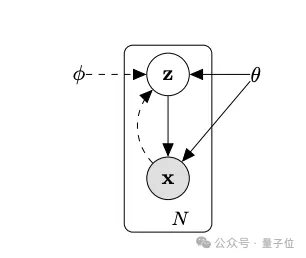

概率建模是我们推理世界的最基本方法之一。这篇论文率先将深度学习与可扩展的概率推理(通过所谓的重参数化技巧进行摊平均值场变分推理)整合在一起,从而产生了变分自编码器(VAE)。

委员会评价这项工作其持久价值在于它的优雅。用于开发 VAE 的原理加深了我们对深度学习和概率建模之间相互作用的理解,并引发了许多后续有趣的概率模型和编码方法的开发。

传统自编码器有个问题,它学到的隐向量是确定的、离散的,也没有很好的可解释性,而且不能随机采样隐向量来生成新样本。VAE就是为了解决这些问题而提出的。

VAE的核心思想是把隐向量看作是一个概率分布。具体而言,编码器(encoder)不直接输出一个隐向量,而是输出一个均值向量和一个方差向量,它们刻画了隐变量的高斯分布。这样一来,我们就可以从这个分布中随机采样隐向量,再用解码器(decoder)生成新图片了。

但是问题在于,这个隐变量的后验分布很复杂,难以直接求解。

所以VAE的第二个关键思想是用一个简单分布(例如高斯分布)去近似真实的后验分布,并通过优化一个下界(ELBO)来训练模型。

这个下界可以分解为两部分:一部分让生成的图片更接近原始图片,另一部分让近似后验分布更接近先验分布(例如标准高斯分布)。直观地说,这相当于在重构输入图片的同时,对隐变量分布进行了一个“规范化”。

为了让这个下界能通过梯度下降来优化,VAE论文提出了一个重参数技巧,它把从分布中采样的过程改写成从标准高斯分布采样并进行线性变换。这样梯度就可以直接反向传播了。

这样一来,VAE可以学习到数据的隐空间表示,并用它来生成新样本。和传统自编码器相比,VAE学到的隐变量具有更好的可解释性和泛化能力。

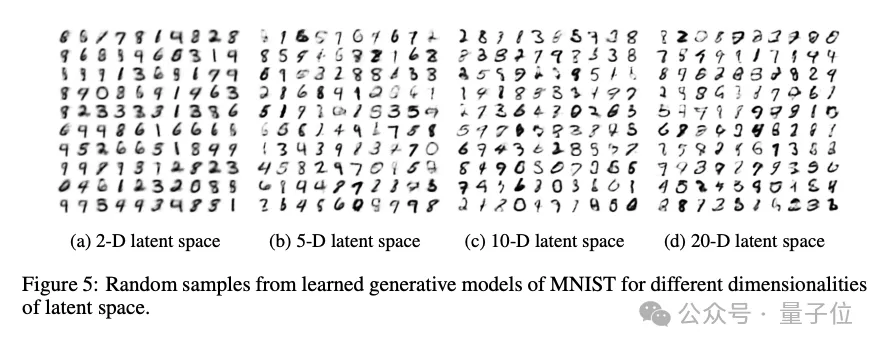

在实验部分,论文在MNIST数据集上展示了VAE生成数字图像的效果。

而这篇研究背后的作者同样来头不小。

Diederik P. Kingma博士毕业于阿姆斯特丹大学。曾是OpenAI创始成员之一、算法团队负责人,专注于基础研究,比如用于生成模型的算法。

离开OpenAI之后,他来到谷歌,参与到谷歌大脑、DeepMind团队研究中去,他主导了一系列生成模型的研究,包括文本、图像和视频。除了VAE之外,他也是Adam优化器、Glow等发明者。谷歌学术被引超20万次。

除此之外,他还有着天使投资人这一身份。

不过目前从Twitter介绍上看,他貌似已经离开DeepMind。

AI大牛Max Welling目前是阿姆斯特丹大学机器学习研究主席,也是MSR杰出科学家。

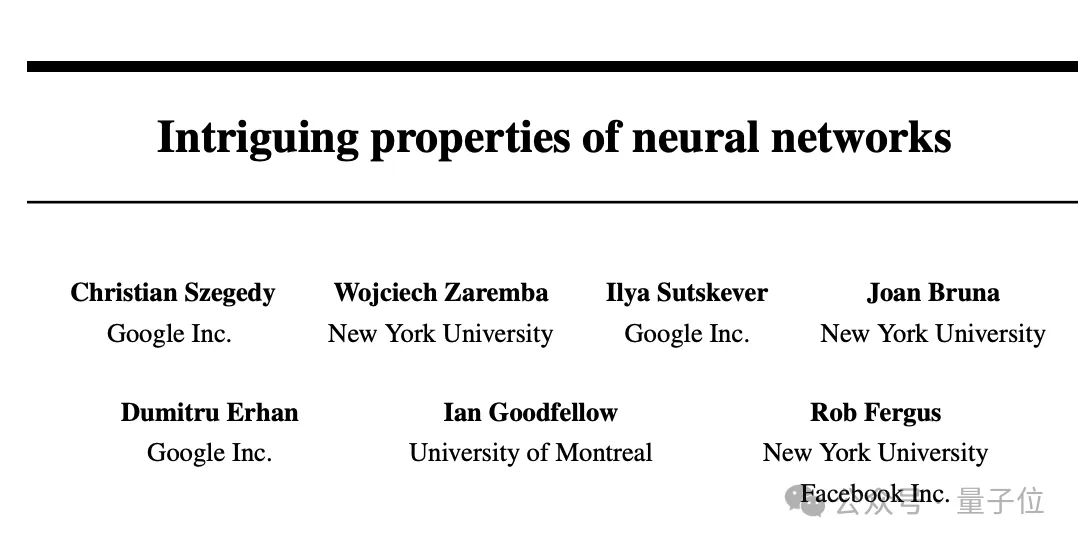

另外,同样来自2013年的研究,来自谷歌、纽约大学、蒙特利尔大学的论文Intriguing properties of neural networks获得了亚军。

里面还有不少熟悉面孔,比如那个消失的OpenAI联创兼首席科学家Ilya Sutskever 、GAN发明者Ian Goodfellow。

ICLR委员对这篇论文评价如下:

随着深度神经网络在实际应用中的日益普及,了解神经网络何时以及如何出现不良行为显得尤为重要。这篇论文强调了这样一个问题,即神经网络很容易受到输入中几乎难以察觉的微小变化的影响。这一想法有助于催生对抗性攻击(试图愚弄神经网络)和对抗性防御(训练神经网络使其不被愚弄)领域。

杰出论文奖

与此同时,本届ICLR杰出论文奖也悉数颁出,共有5篇优秀论文获奖、11篇论文获得荣誉提名。

那么主要来看看这5篇论文讲了什么。

Generalization in diffusion models arises from geometry-adaptive harmonic representations

这篇来自纽约大学、法兰西学院的研究,从实验和理论研究了扩散模型中的记忆和泛化特性。作者根据经验研究了图像生成模型何时从记忆输入转换到泛化机制,并通过 “几何自适应谐波表征 ”与谐波分析的思想建立联系,进一步从建筑归纳偏差的角度解释了这一现象。

这篇论文涵盖了我们对视觉生成模型理解中的一个关键缺失部分,很可能会对该领域未来的重要理论研究有所启发。

Learning Interactive Real-World Simulators

研究机构来自UC伯克利、Google DeepMind、MIT、阿尔伯塔大学。汇集多个来源的数据来训练机器人基础模型是一个长期的宏伟目标。由于不同的机器人具有不同的感知-运动界面,这阻碍了大规模数据集的训练,因此带来了巨大的挑战。这项名为 “UniSim ”的工作是朝着这个方向迈出的重要一步,也是一项工程壮举,它使用基于视觉感知和控制文字描述的统一界面来聚合数据,并利用视觉和语言领域的最新发展,从数据中训练机器人模拟器。

Never Train from Scratch: Fair Comparison of Long-Sequence Models Requires Data-Driven Priors

来自特拉维夫大学、IBM的研究深入探讨了最近提出的状态空间模型和Transformer架构对长期顺序依赖关系的建模能力。令人惊讶的是,作者发现从头开始训练Transformer模型会导致对其性能的低估,并证明通过预训练和微调设置可以获得巨大的收益。

这篇论文执行得非常出色,在注重简洁性和系统性见解方面堪称典范。

Protein Discovery with Discrete Walk-Jump Sampling

基因泰克、纽约大学的研究解决了基于序列的抗体设计问题,这是蛋白质序列生成模型的一个重要应用。作者引入了一种创新而有效的新建模方法,专门用于处理离散蛋白质序列数据的问题。除了在硅学中验证该方法外,作者还进行了大量湿实验室实验,在体外测量抗体结合亲和力,证明了其生成方法的有效性。

Vision Transformers Need Registers

来自Meta等机构的研究,识别了vision transformer网络特征图中的伪影,其特点是低信息量背景区域中的高规范Tokens。作者对出现这种情况的原因提出了关键假设,并提供了一个简单而优雅的解决方案,利用额外的register tokens来解决这些伪影问题,从而提高模型在各种任务中的性能。从这项工作中获得的启示也会对其他应用领域产生影响。

这篇论文写得非常好,提供了一个开展研究的绝佳范例—发现问题,了解问题发生的原因,然后提供解决方案。

除此之外,本届会议共收到了7262 篇提交论文,接收2260篇,整体接收率约为 31%。此外Spotlights论文比例为 5%,Oral论文比例为 1.2%。

本文转自 量子位,作者:量子位