ICLR 2024:确定性与随机环境中的effective horizon! 原创

现有的大多数强化学习理论无法解释实际强化学习算法何时或为何有效:理论家分析不同的算法并做出在真实环境中不一定成立的假设。这使得将理论洞察力应用于实践变得困难或不可能。

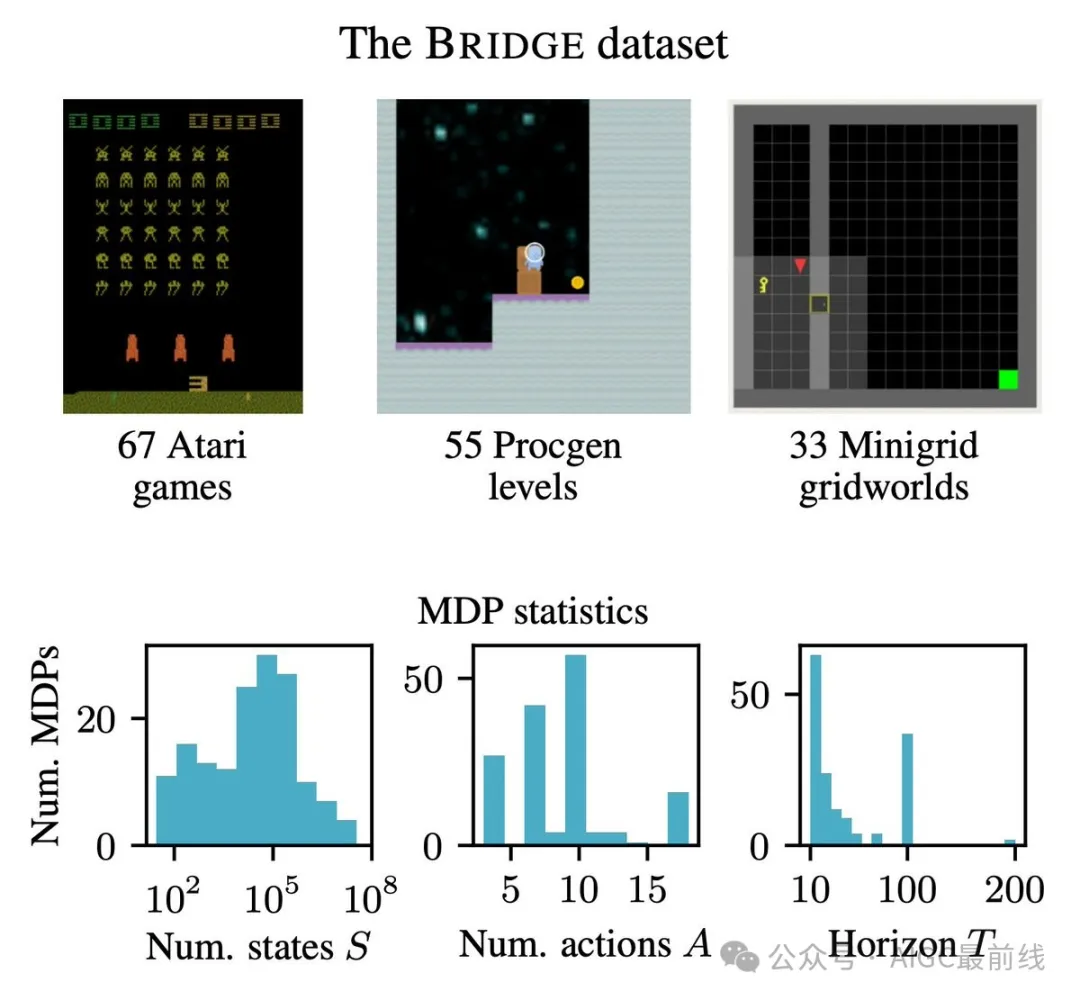

为了找到在常见环境中成立的假设,研究人员构建了一个名为BRIDGE的数据集,包含来自Atari和Procgen等基准测试中155个确定性MDP完整的表格表示,其中一些MDP具有1000万个以上的状态!

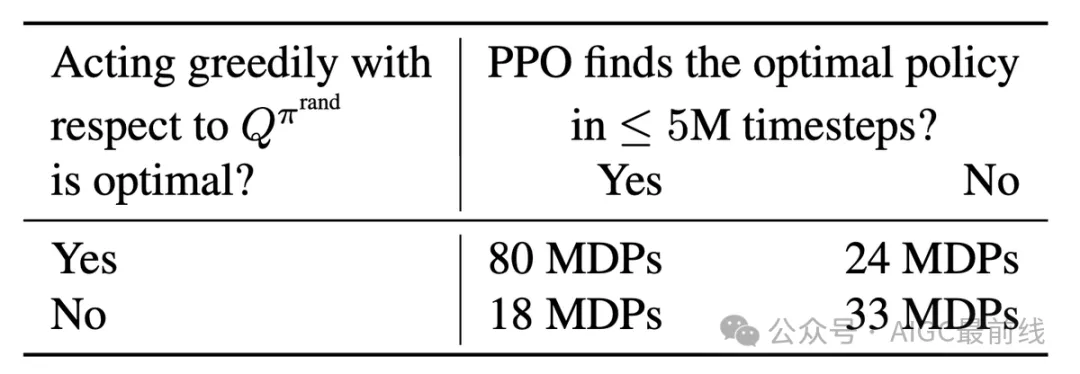

研究人员发现超过2/3的MDP具有一个令人惊讶的属性:在随机策略下具有最高Q值的动作,在最优策略下也具有最高的Q值。值得注意的是,当这种情况成立时,PPO更有可能找到最优策略。

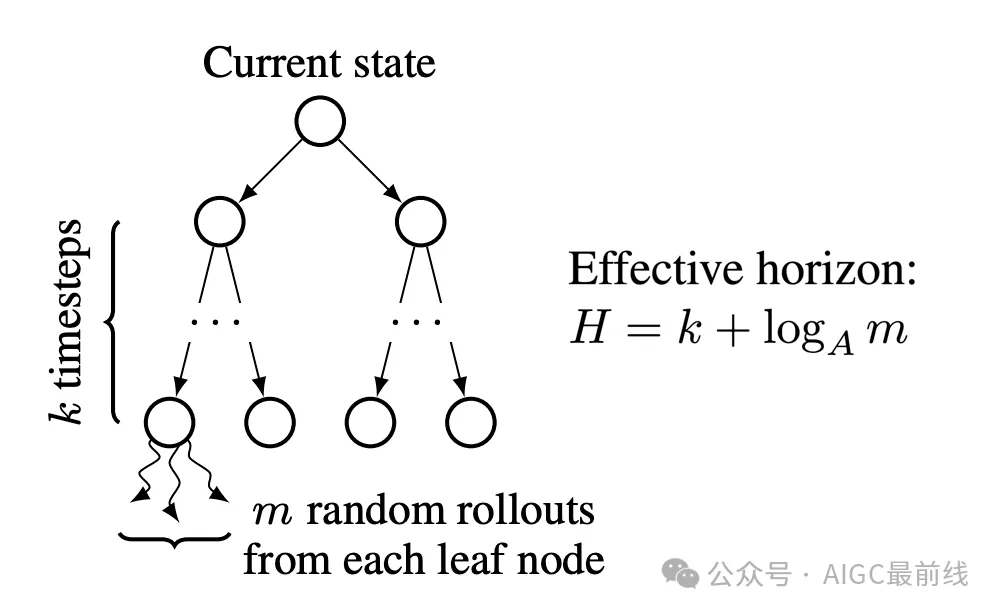

研究人员将这一特性推广为一种新的MDP复杂度度量,称之为effective horizon,它大致对应于当叶节点使用随机模拟进行评估时,需要多少步的前瞻搜索来确定下一个最优动作。

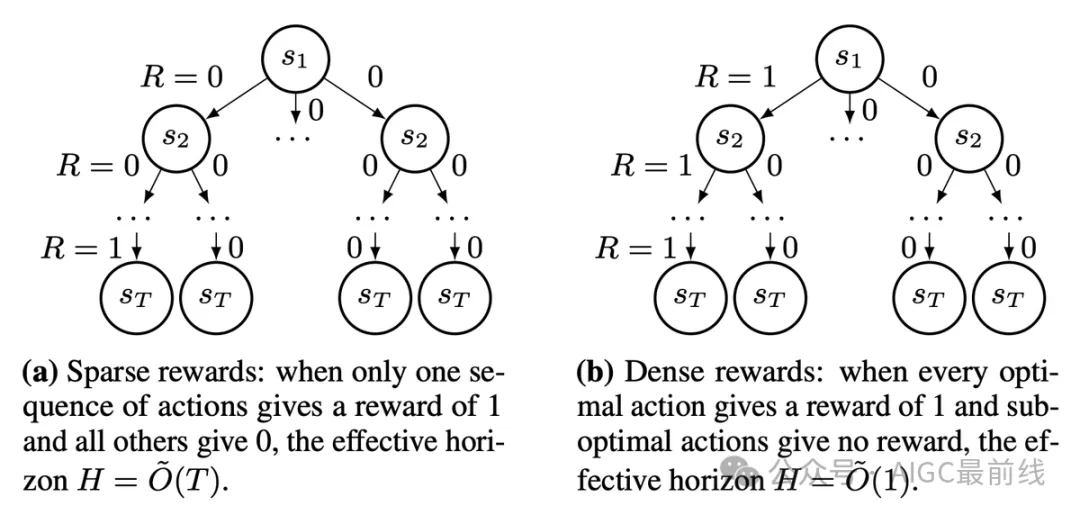

例如,下面的左侧MDP具有非常稀疏的奖励,因此effective horizon H不会比完整平线T短。然而,右侧的MDP具有非常密集的奖励,其effective horizon只有1。这反映了人们的直觉,即密集的奖励使得强化学习更容易。

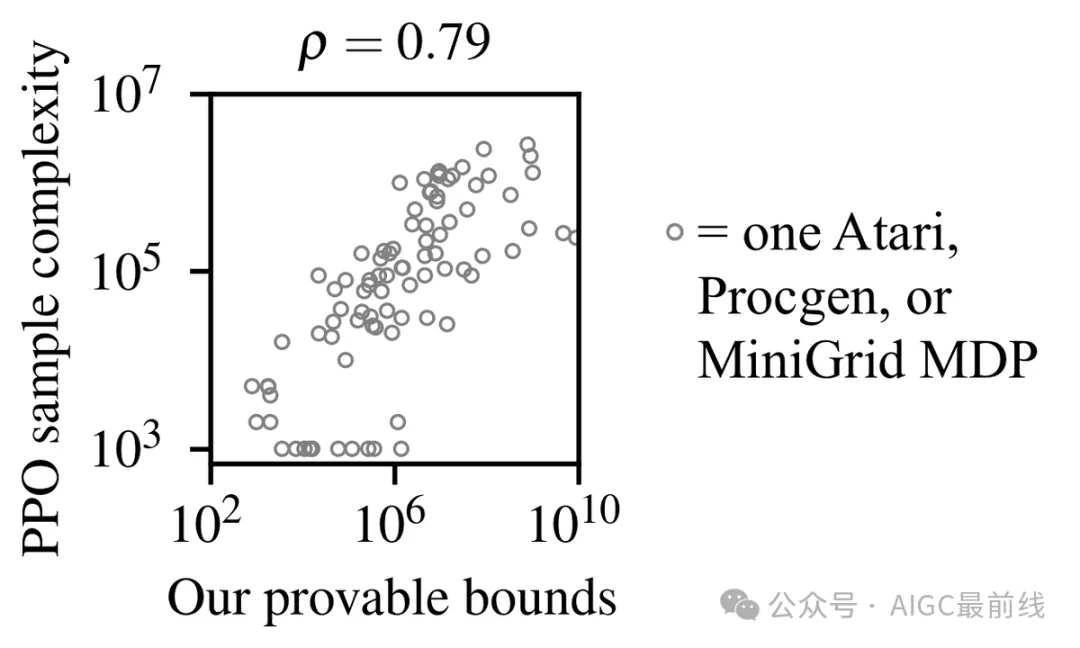

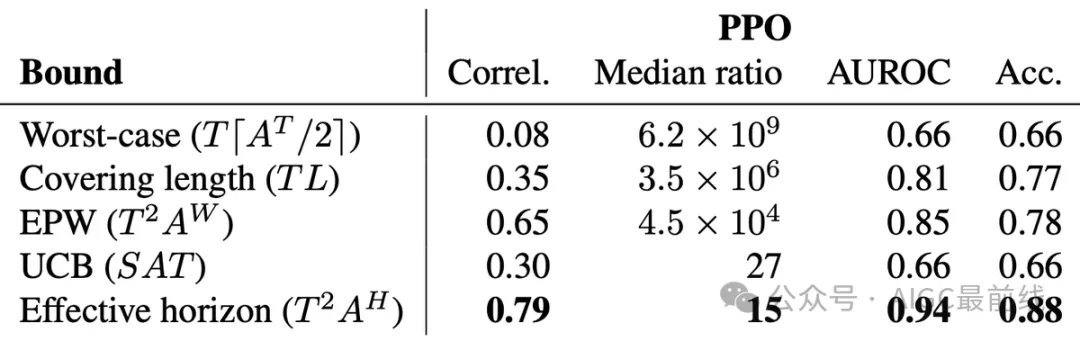

利用BRIDGE中的MDPs,研究人员评估了深度强化学习算法PPO和DQN,并将它们的样本复杂度与可证明的界限进行了比较。基于effective horizon的新界限极具预测性!

Effective horizon可以解释奖励塑造和使用预训练策略初始化这两种常用工具对提高强化学习性能的益处。

随机环境

随机环境更难分析,因为强化学习算法可能需要对从未见过的状态进行泛化。在实践中,这需要神经网络函数逼近器,并且以前的强化学习理论无法解释为什么使用神经网络进行高效的强化学习是可能的。

在对确定性环境的工作中,通过分析一种名为GORP的算法来回避了这个问题,该算法仅学习一系列动作,无需神经网络。GORP通过在随机策略的Q值的蒙特卡洛估计上贪婪地执行动作来逐步构建动作序列。

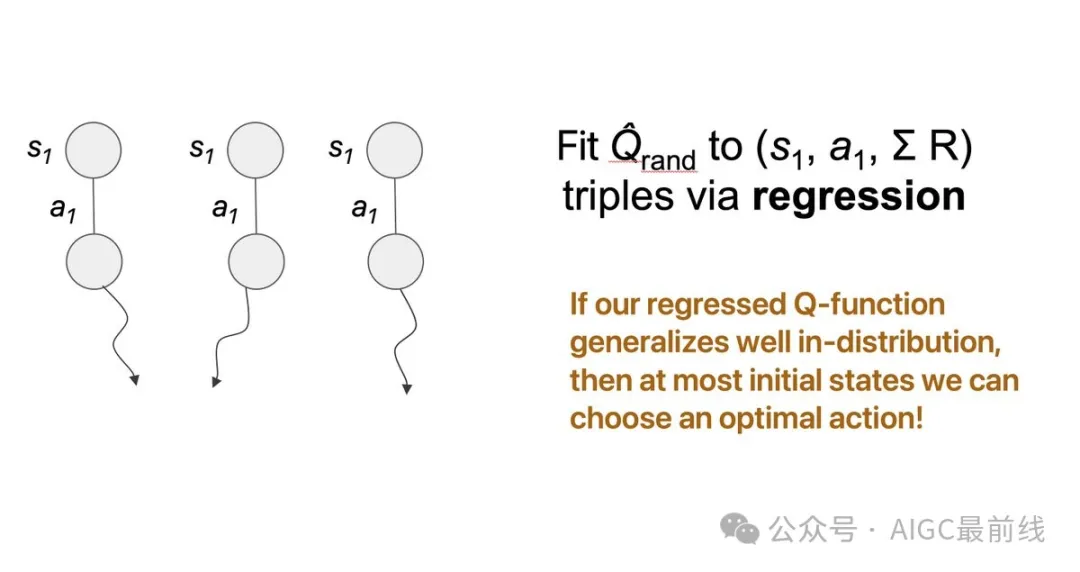

为了将这一方法扩展到随机环境中,研究人员用随机演算过程中收集的(状态、动作、未来奖励)三元组来进行随机策略Q函数的回归,以取代对随机策略Q值的简单均值估计。

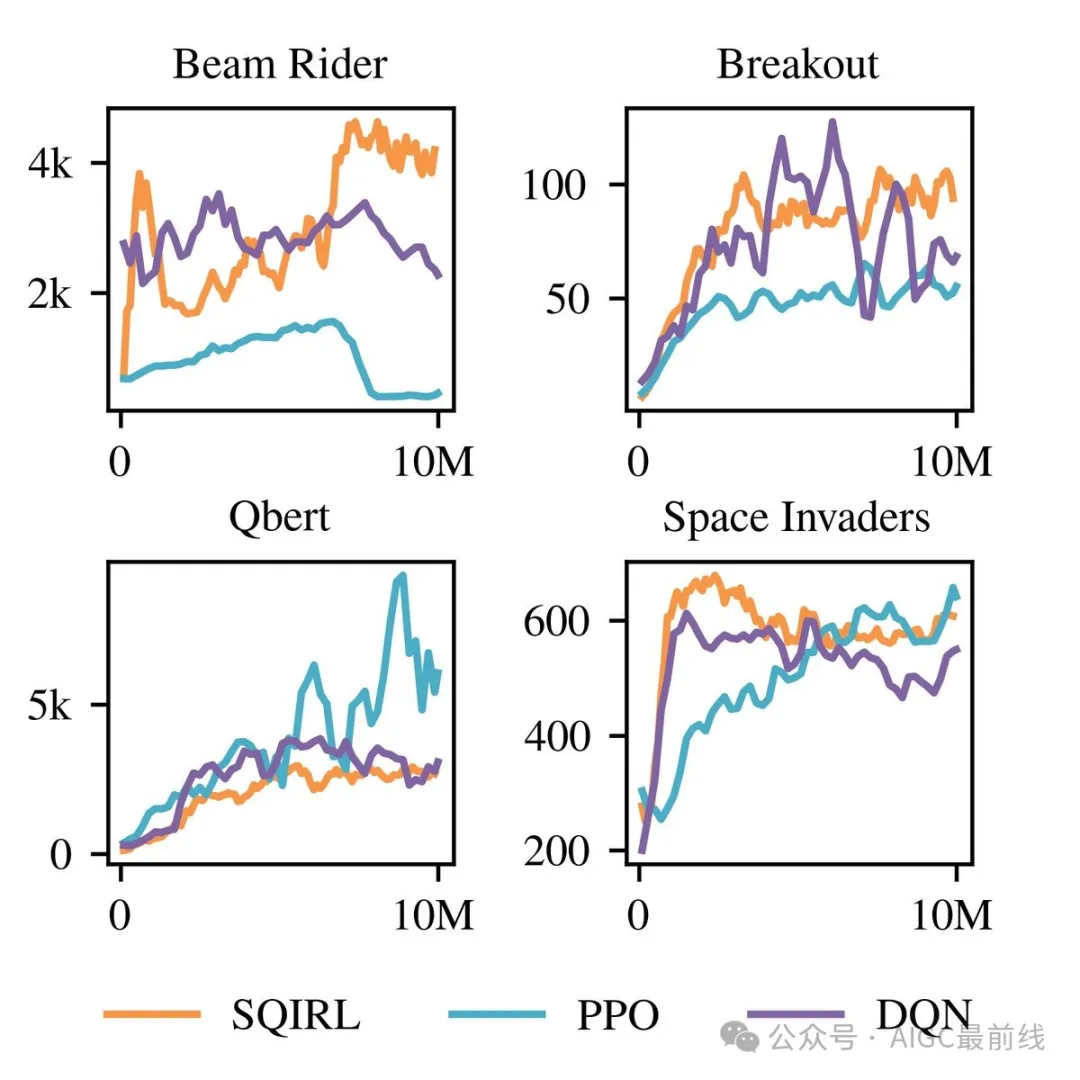

研究人员引入了一种名为SQIRL的算法,它使用神经网络对随机策略的Q函数进行回归,应用1或2步的拟合Q迭代,然后采用贪婪策略。尽管它很简单,但在像Atari的粘滞动作等基准测试中,SQIRL的表现与PPO和DQN几乎相当好!

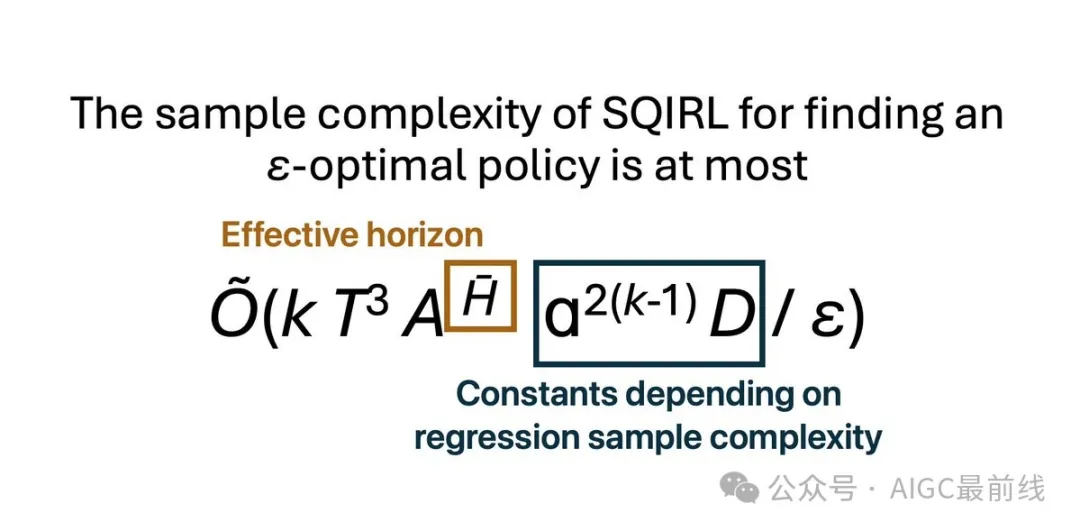

研究人员还对SQIRL进行了理论分析。结果表明,只要有效视野较低,任何具有低IID泛化误差的回归算法都可以在SQIRL中用于高效的强化学习。这解释了为什么能够进行IID泛化的神经网络在深度强化学习中也表现出色!

论文:https://arxiv.org/abs/2312.08369

代码:https://github.com/cassidylaidlaw/effective-horizon

本文转载自公众号AIGC最前线