回复

剖析Transformer模型时间复杂度:从矩阵乘法到自注意力机制和前馈神经网络的全解析

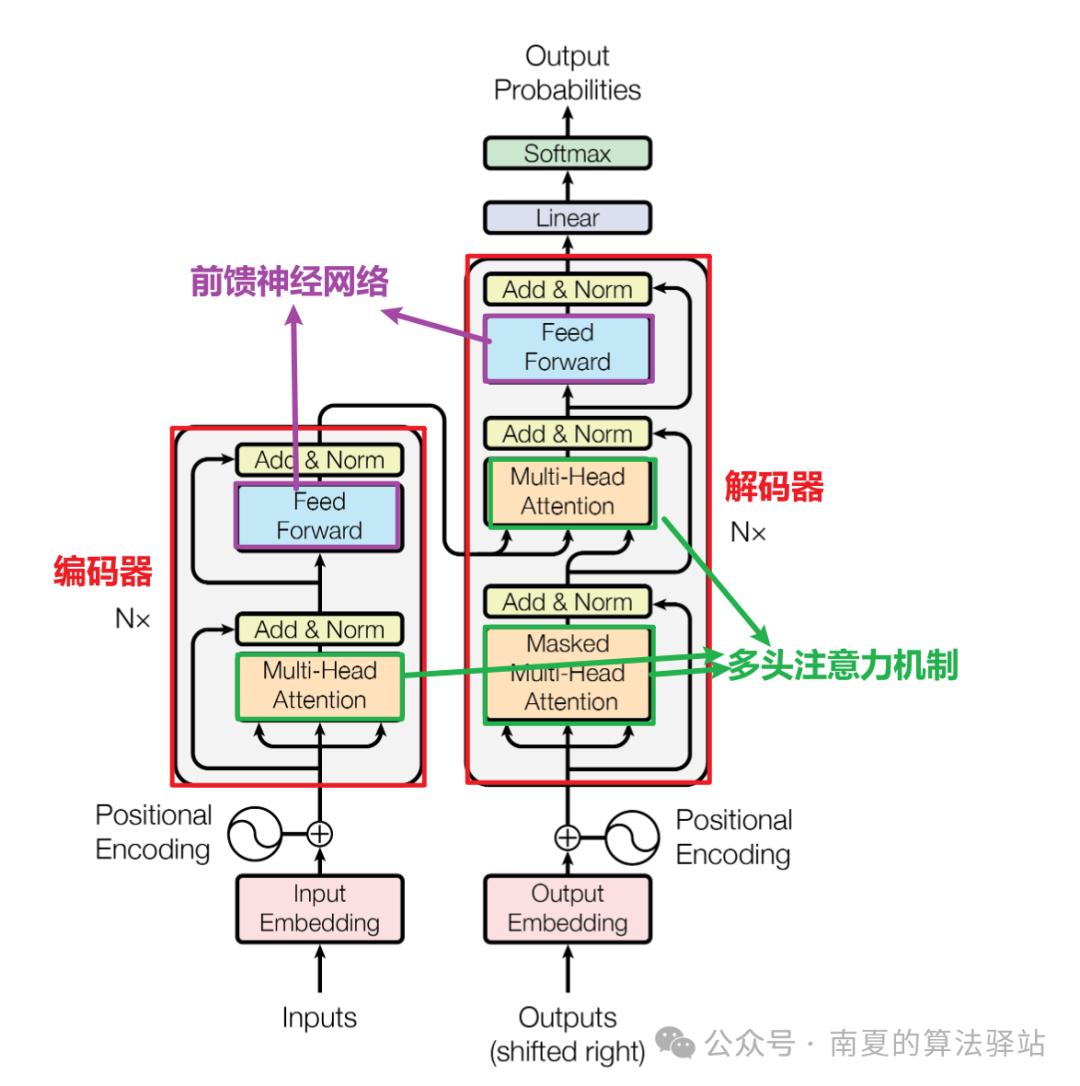

Transformer模型的时间复杂度主要由其核心模块自注意力机制和前馈神经网络决定,其中自注意力机制的计算复杂度占主导地位。

本文将从单个矩阵乘法的时间复杂度计算出发,分析自注意力机制、多头注意力机制、前馈神经网络的时间复杂度,从而得到整个Transformer模型的时间复杂度,并说明优化方法。

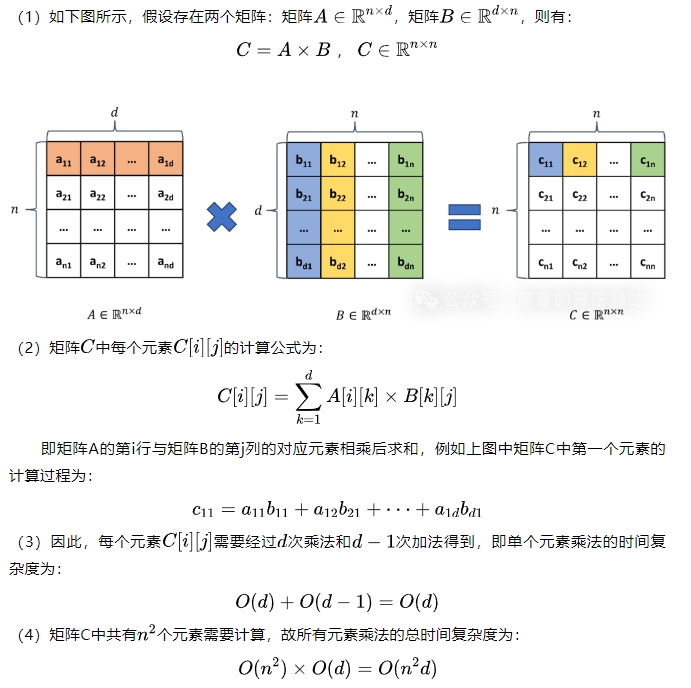

1.单个矩阵乘法的时间复杂度

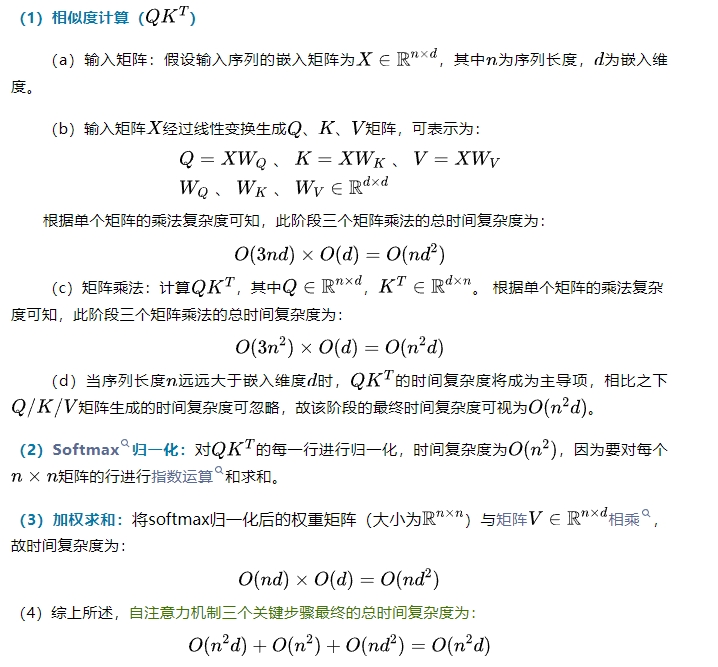

2.自注意力机制的时间复杂度

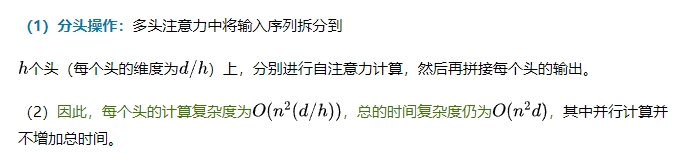

3.多头自注意力机制的时间复杂度

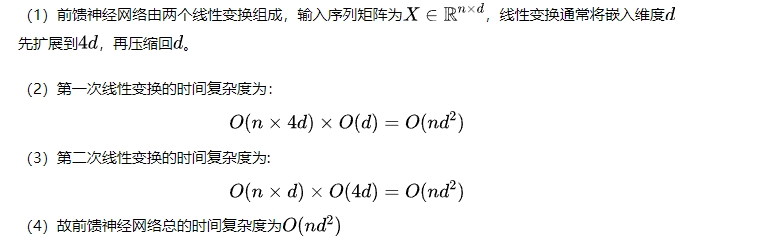

4.前馈神经网络的时间复杂度

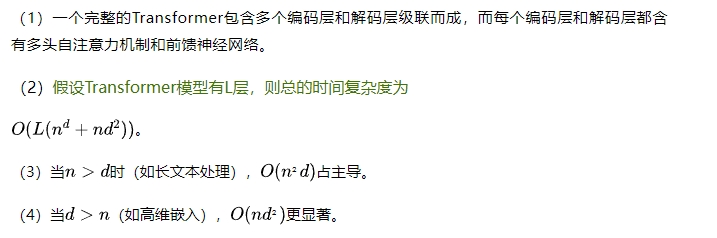

5.Transformer模型的时间复杂度

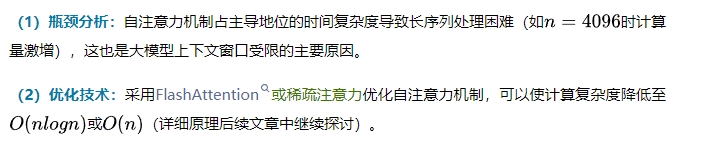

6.时间复杂度优化

本文转载自南夏的算法驿站,作者:赵南夏

赞

收藏

回复

相关推荐