复杂多文本图像生成;多角色对话视频生成,唇形同步,身体动作,情感表达

TextCrafter: Accurately Rendering Multiple Texts in Complex Visual Scenes

2025-03-30|NJU, China Mobile, HKUST|🔺61

http://arxiv.org/abs/2503.23461v2

https://huggingface.co/papers/2503.23461

https://github.com/NJU-PCALab/TextCrafter.git

研究背景与意义

复杂视觉文本生成(CVTG)任务近年来受到广泛关注,其核心挑战在于如何在图像的不同区域生成精确、清晰且上下文一致的文本内容。现有模型如FLUX和SD3.5虽然在简单场景中表现良好,但在多文本复杂场景下常出现文本混淆、遗漏或模糊等问题。TextCrafter正是为解决这些问题而提出的一种创新方法。

- 研究背景:随着扩散模型的发展,视觉图像生成技术取得了显著进步,但复杂视觉文本生成仍面临诸多挑战。例如,多文本之间的干扰、小尺寸文本的模糊以及位置错位等问题严重影响了生成效果。

- 研究意义:TextCrafter通过引入实例融合、区域隔离和文本聚焦三大机制,有效解决了上述问题。它不仅提升了复杂场景中文本生成的准确性,还为评估此类任务提供了新的基准数据集CVTG-2K。

研究方法与创新

TextCrafter的核心创新点在于其独特的三阶段策略,具体如下:

- 实例融合(Instance Fusion)实例融合通过加强文本与其载体之间的关联,确保文本不会漂浮在图像中,而是准确地定位到指定位置。该方法利用前引号的嵌入信息来捕捉文本的空间关系,并通过加权融合的方式将文本嵌入整合到载体嵌入中。这种方法避免了直接使用文本自身嵌入可能带来的偏差。

- 区域隔离(Region Insulation)区域隔离旨在减少多文本之间的相互干扰。通过为每个文本分配矩形边界框并初始化布局信息,模型能够有效地分离不同文本区域。这一过程利用了预训练DiT模型的位置先验知识,从而避免了手动指定布局或依赖大型语言模型的局限性。

- 文本聚焦(Text Focus)文本聚焦机制通过增强注意力机制,提升对小尺寸文本的关注度。具体而言,该方法通过调整注意力权重,使模型更加专注于文本及其前引号部分,从而提高渲染精度。此外,tanh函数被用于控制增强幅度,防止过度放大导致失真。

方法优势:

- 全局到局部的逐步细化:从整体任务分解到子任务,再到具体文本的精确渲染,实现了由粗到精的过程。

- 无需额外训练:TextCrafter基于预训练模型构建,无需额外训练或微调,降低了实现成本。

- 广泛的适用性:适用于多种复杂场景,包括长文本、小尺寸文本、数字和符号等。

实验设计与结果分析

为了验证TextCrafter的有效性,研究团队设计了一系列实验,并将其与其他基线方法进行了对比。

- 实验设计

- 数据集:提出了全新的CVTG-2K数据集,包含多样化的视觉文本提示,涵盖位置、数量、长度和属性等多个维度。

- 指标:采用OCR准确率(Word Accuracy)、归一化编辑距离(NED)和CLIPScore三种指标进行评估。

- 基线方法:包括Stable Diffusion 3.5 Large、FLUX.1 dev、AnyText、TextDiffuser-2、RAG-Diffusion和3DIS等。

- 结果分析

- 在CVTG-2K数据集上,TextCrafter显著优于其他方法。特别是在多区域文本生成任务中,其OCR准确率比FLUX高出45%以上。

- 对于小尺寸文本,TextCrafter的表现尤为突出,其清晰度和准确性远超其他模型。

- 定性结果表明,TextCrafter生成的图像不仅美观和谐,还能准确渲染多个视觉文本,同时保持稳定性。

- 对比基准

- SD3.5和FLUX在简单场景中表现良好,但随着文本区域数量增加,性能急剧下降。

- AnyText和TextDiffuser-2专注于单区域生成,在复杂场景中的泛化能力不足。

- RAG-Diffusion和3DIS虽能处理复杂场景,但在视觉文本生成的具体要求上表现欠佳。

结论与展望

- 总结贡献

- 提出了TextCrafter,一种无需训练的复杂视觉文本生成框架,包含实例融合、区域隔离和文本聚焦三大机制。

- 构建了CVTG-2K数据集,为评估复杂视觉文本生成任务提供了全面的基准。

- 实验结果证明,TextCrafter在OCR准确率、NED和CLIPScore等多个指标上均表现出色。

- 分析局限

- 当前方法主要针对静态图像中的文本生成,对于动态场景或视频中的文本生成尚未涉及。

- CVTG-2K数据集虽然多样化,但仍需进一步扩展以覆盖更多极端情况。

- 方法展望

- 将TextCrafter扩展至动态场景,探索其在视频生成中的应用潜力。

- 引入更多样化的属性(如字体风格、颜色渐变等),进一步丰富视觉文本的表现力。

- 开发更高效的优化算法,降低计算成本,提升实时性。

MoCha: Towards Movie-Grade Talking Character Synthesis

2025-03-30|U Waterloo, Meta GenAI, Meta |🔺49

http://arxiv.org/abs/2503.23307v1

https://huggingface.co/papers/2503.23307

https://congwei1230.github.io/MoCha/

研究背景与意义

MoCha的提出旨在解决现有视频生成模型在自动化电影制作中的局限性。当前模型尽管在视觉效果和动态环境方面取得了显著进展,但在生成具有完整身体动作、情感表达和多角色互动的对话场景时仍显不足。MoCha通过结合语音和文本输入生成高质量的电影级角色动画,不仅实现了精确的唇形同步,还能够自然地表达情感和全身动作,从而推动了自动化叙事技术的发展。

- 研究背景:自动化电影制作潜力巨大,可实现大众化的电影级叙事。然而,现有模型在生成具有丰富叙事内容的角色动画时存在明显限制。

- 研究意义:MoCha首次实现了从语音和文本直接生成包含多角色对话的动画视频,突破了传统单一角色或仅限面部区域的生成方法,为电影制作和虚拟助手等领域提供了新的可能性。

研究方法与创新

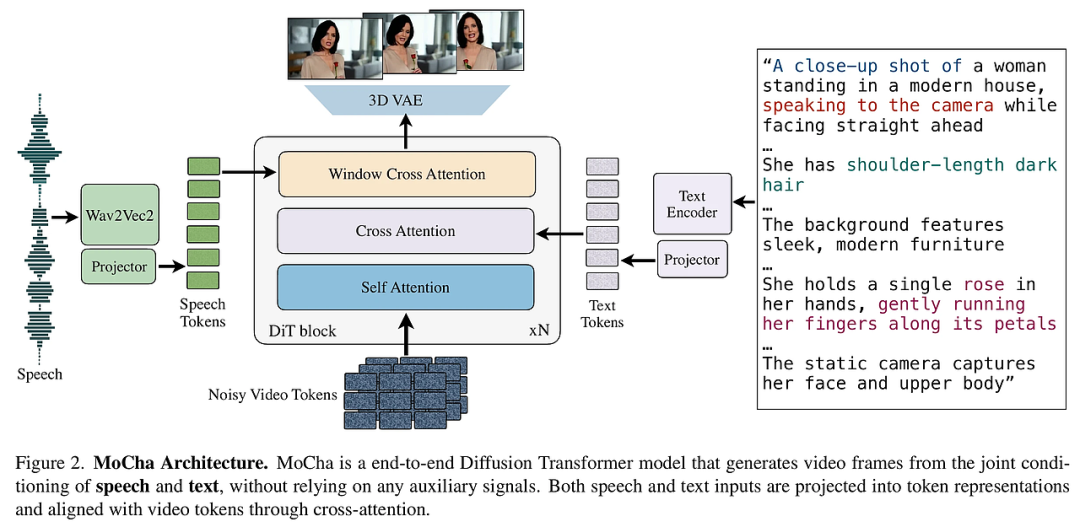

MoCha的核心创新在于其端到端训练架构和关键机制的设计,这些设计显著提升了模型的表现力和泛化能力。

- 端到端训练无辅助条件:MoCha无需依赖外部控制信号(如参考图像、骨架或关键点),直接基于文本和语音进行训练。这种简化不仅降低了模型复杂度,还增强了动作多样性和泛化能力。

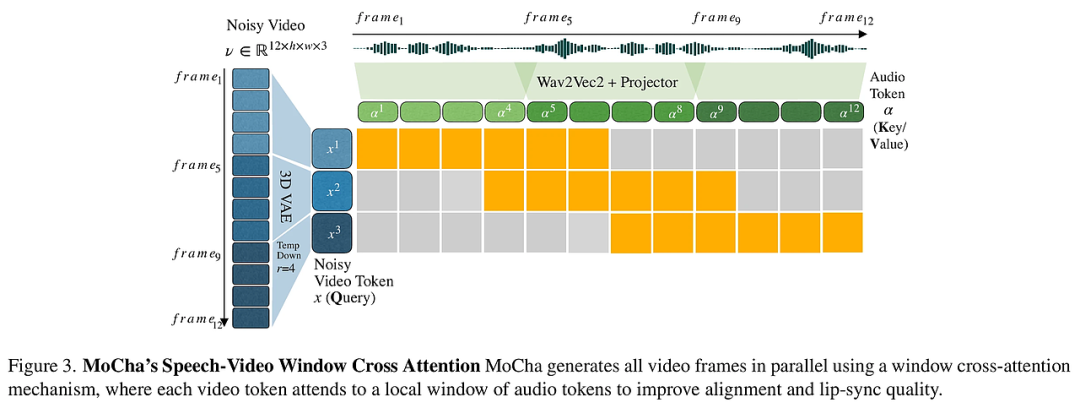

- 语音-视频窗口注意力机制:为了改善语音与视频之间的对齐,MoCha引入了一种新型注意力机制,该机制通过局部时间条件约束音频和视频令牌的关联。这一设计显著提高了唇形同步精度,并确保了语音与视频的一致性。

- 联合语音-文本训练策略:针对大规模语音标注视频数据稀缺的问题,MoCha采用了一种联合训练框架,同时利用语音标注和文本标注的视频数据。这种方法增强了模型在多样化角色动作上的泛化能力,并实现了通过自然语言提示对角色表情、动作和环境的精细控制。

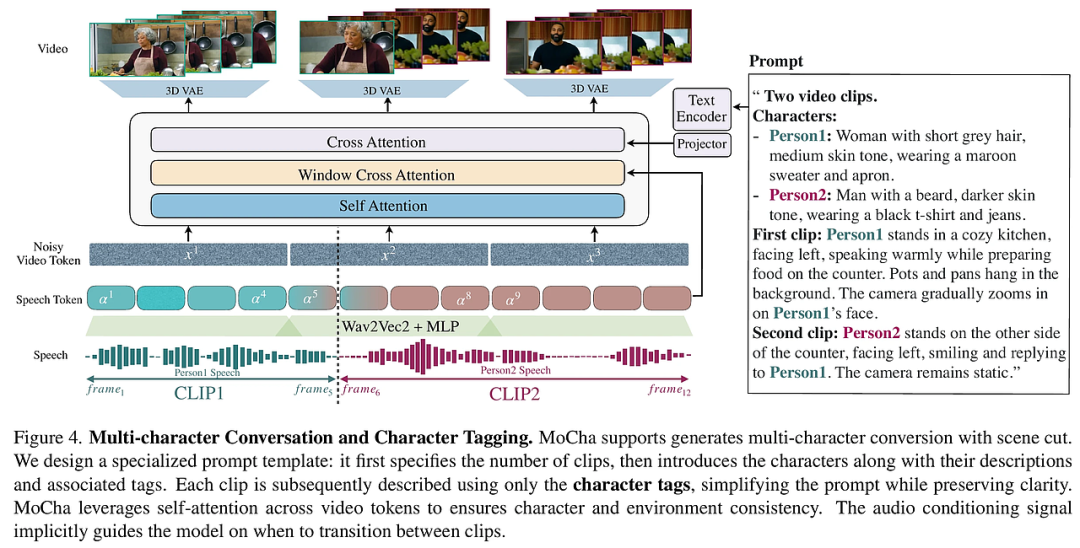

- 多角色对话生成:MoCha首次实现了连贯的多角色动态对话生成,支持基于场景切换的多片段生成。通过自注意力机制,模型能够在多个片段中保持角色和环境的一致性,而无需额外的架构修改。

实验设计与结果分析

实验部分验证了MoCha在多个维度上的优越性能,包括唇形同步质量、面部表情自然度、动作自然度、文本对齐和整体视觉质量。

- 实验设计:研究人员设计了一个专门用于评估Talking Characters任务的基准数据集MoCha-Bench,其中包括150个多样化的样本。实验涵盖了从近景到中景的不同镜头类型,强调面部表情、唇形同步和全身动作的表现。

- 结果分析:定量实验显示,MoCha在唇形同步指标Sync-C和Sync-D上均优于基线方法。人类评价结果进一步表明,MoCha在所有五个评估维度上均显著领先,尤其是在动作自然度和文本对齐方面表现出色。

结论与展望

MoCha的成功展示了其在生成高质量、可控性强的角色动画方面的潜力,为未来的研究奠定了坚实基础。

- 总结贡献:MoCha不仅实现了精确的唇形同步和自然的情感表达,还在多角色对话生成和全身动作表现上取得了突破。这些成果使其成为电影制作、虚拟助手等领域的有力工具。

- 分析局限:尽管MoCha表现优异,但其生成的视频在复杂动作场景下仍可能存在轻微瑕疵。此外,模型对长篇对话的处理能力仍有提升空间。

- 方法展望:未来工作可以进一步优化语音-视频窗口注意力机制,以更好地处理长时间序列数据。同时,探索更高效的联合训练策略和更大规模的数据集将有助于提升模型的泛化能力和生成质量。

本文转载自AI研究前瞻,作者:胡耀淇