ReSearch: 突破性强化学习框架实现大模型推理搜索能力无缝整合

引言:大模型推理与搜索的融合挑战

随着OpenAI-o1和DeepSeek-R1等模型的出现,大型语言模型(LLMs)在推理能力上取得了显著突破。然而,将复杂推理与外部搜索过程有效整合仍然面临重大挑战,尤其是在处理需要多步检索的复杂多跳问题时。传统方法往往依赖手动设计的提示或启发式规则,这在可扩展性和灵活性方面存在明显局限。更重要的是,为多步推理场景生成监督数据通常成本高昂且在实践中难以实现。

百川科技、同济大学、爱丁堡大学和浙江大学的研究团队近期提出了一种突破性解决方案——ReSearch框架。这一创新框架通过强化学习训练大语言模型将推理与搜索无缝整合,其独特之处在于完全不依赖推理步骤的监督数据。本文将深入探讨ReSearch的核心原理、技术实现以及其在多跳问答任务中的卓越表现。

ReSearch的核心方法论

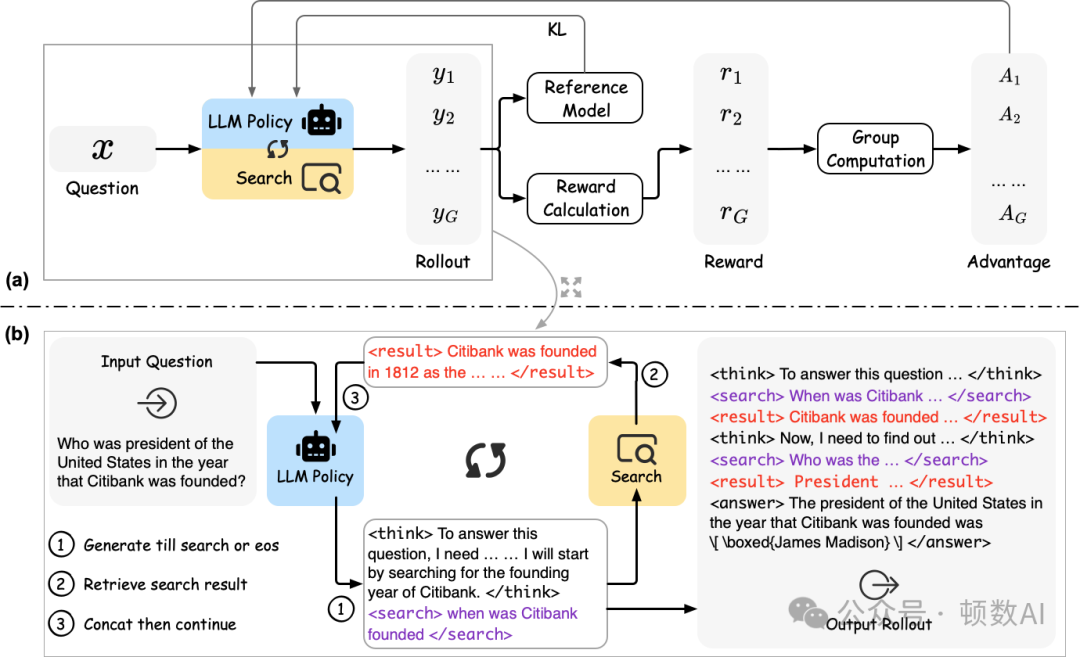

ReSearch的核心创新在于将搜索操作视为推理链的有机组成部分。在这一框架中,何时以及如何执行搜索由模型基于文本的思考过程自主决定,而搜索结果又会反过来影响后续的推理过程。这种双向互动机制使模型能够在处理复杂问题时灵活地利用外部知识。

从技术角度看,ReSearch采用了结构化的输出格式,通过在推理链中嵌入特定标签(如<think>、<search>、<result>和<answer>)来实现模型与外部检索环境之间的清晰通信。这些标签不仅系统地组织了生成的输出,还为模型提供了明确的行动框架。

群体相对策略优化(GRPO)

ReSearch采用了群体相对策略优化(Group Relative Policy Optimization, GRPO)作为其强化学习的核心技术。这一技术使模型能够自主识别执行搜索操作的最佳时机和策略,从而优化整体推理过程。值得注意的是,在训练过程中,ReSearch有意将检索结果排除在损失计算之外,以防止模型产生偏差。

指导强化学习过程的奖励信号基于两个简单而有效的标准:

- 通过F1分数评估的准确度

- 对预定义结构化输出格式的遵守程度

这种设计巧妙地鼓励模型自主发展复杂的推理模式,同时避免了对手动注释推理数据集的依赖。

技术实现细节

ReSearch的实现基于多个开源框架和工具,包括:

- verl作为强化学习的基础框架

- FlashRAG用于评估和检索

- FastAPI用于检索器服务

- SGLang用于模型服务

- Qwen2.5作为基础模型

检索器服务架构

在模型训练和评估过程中,搜索操作被设计为在部署和推理过程中执行。实际上,研究团队通过FlashRAG和FastAPI托管检索器服务,将搜索操作标准化为API调用。这种设计将搜索操作与强化学习过程解耦,使训练和评估更加清晰灵活。

数据准备与训练流程

ReSearch在MuSiQue的训练集上进行训练,并在HotpotQA、2WikiMultiHopQA、MuSiQue和Bamboogle的开发集上进行评估。训练流程包括以下关键步骤:

- 数据准备将MuSiQue数据集解析为parquet格式

- 检索器服务启动配置并启动基于FlashRAG的检索服务

- 模型训练使用定制版的verl框架进行强化学习训练

- 评估通过SGLang服务部署模型并使用FlashRAG进行标准评测

对于不同类型的基础模型,ReSearch提供了灵活的配置选项:

- 对于预训练模型:使用--apply_chat False和--prompt_template_name re_search_template

- 对于指令调整模型:使用--apply_chat True和--prompt_template_name re_search_template_sys

实验评估与性能表现

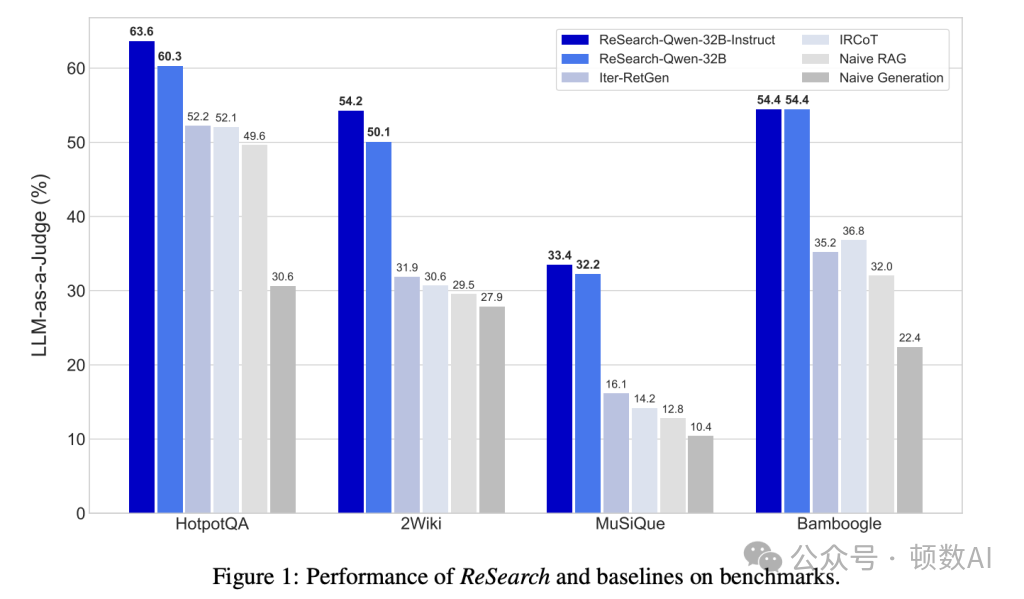

实验评估充分证明了ReSearch的稳健性和有效性。在多跳问答基准测试中,包括HotpotQA、2WikiMultiHopQA、MuSiQue和Bamboogle,ReSearch始终优于基线方法。具体而言,ReSearch-Qwen-32B-Instruct相比既定基线实现了8.9%至22.4%的性能提升。

值得注意的是,这些显著进步是在模型仅在单一数据集上训练的情况下实现的,这凸显了ReSearch框架强大的泛化能力。进一步分析表明,模型在整个训练过程中逐渐增加了对迭代搜索操作的依赖,这表明其推理能力得到了持续提升。

案例研究:自我反思与纠正能力

详细的案例研究展示了ReSearch模型令人印象深刻的能力:

- 识别次优搜索查询

- 反思其推理步骤

- 自主实施纠正措施

这种自我反思和纠正能力使ReSearch在复杂、现实的应用场景中表现出色,为解决实际问题提供了强大工具。

技术实现与代码示例

ReSearch的开源实现提供了完整的训练和评估流程。以下是启动检索服务的示例代码::

对于模型训练,可以使用以下命令:

评估模型性能的示例代码:

完整的代码实现和详细文档可在GitHub上找到:https://github.com/Agent-RL/ReSearch

ReSearch的理论意义与实践价值

ReSearch框架在理论和实践层面都具有重要意义。从理论角度看,它提供了一种新颖的方法,通过强化学习将推理与外部搜索机制无缝整合,而无需依赖监督推理数据。这一突破性方法有效解决了多跳推理场景中固有的可扩展性和适应性问题。

从实践角度看,ReSearch的自我反思和纠正能力大大增强了其在复杂、现实环境中的适用性。这使得它成为解决需要多步推理和外部知识检索的实际问题的强大工具。

与现有方法的比较

与依赖手动设计提示或启发式规则的传统方法相比,ReSearch提供了以下显著优势:

- 自主学习能力模型能够自主学习何时以及如何执行搜索操作,无需人工干预

- 灵活性能够适应各种复杂的多跳问题,不受预定义规则的限制

- 可扩展性无需为每个新任务或领域创建专门的监督数据

- 反思与纠正具备识别错误并自主纠正的能力

这些优势使ReSearch在处理复杂推理任务时表现出明显的优越性,特别是在需要多步检索和推理的场景中。

未来研究方向

尽管ReSearch已经取得了显著成果,但仍有多个值得探索的未来研究方向:

- 扩展应用领域将ReSearch框架应用于更广泛的任务,如科学研究、医疗诊断和法律分析等

- 整合多样化知识源探索将更多类型的外部知识资源整合到推理过程中

- 优化强化学习策略进一步改进奖励机制和训练策略,提高模型性能

- 多模态扩展将ReSearch的原理扩展到处理图像、视频等多模态数据

- 效率优化提高搜索和推理过程的计算效率,使其更适合实时应用

结论

ReSearch代表了大语言模型推理能力发展的重要里程碑。通过创新性地将强化学习应用于训练模型整合推理与搜索能力,而无需监督推理数据,ReSearch为解决复杂多跳问题提供了一种高效、灵活的方法。实验结果表明,这一方法在多个基准测试中均优于现有方法,展示了其强大的泛化能力和实用价值。

随着研究的深入和技术的进一步发展,ReSearch有望在更广泛的应用领域发挥重要作用,为人工智能系统处理复杂推理任务提供新的可能性。这一框架不仅推动了大语言模型技术的进步,也为未来的研究提供了宝贵的启示和方向。

论文:https://arxiv.org/abs/2503.19470

GitHub:https://github.com/Agent-RL/ReSearch

本文转载自顿数AI,作者:小顿