AI Hospital(人工智能医院):在多智能体医疗互动模拟器中评估大模型的表现 - 阿里、华中科技等

摘要

人工智能通过大型语言模型(LLMs)显著改变了医疗保健领域,尤其在静态医学问答基准测试中表现出色。然而,由于医患互动的复杂性,评估LLMs在现实世界临床应用的潜力仍然具有挑战性。为此,我们引入了“人工智能医院”这一多智能体框架,模拟医生(玩家)与包括患者和检查员在内的非玩家角色(NPCs)之间的动态医疗互动。这种设置允许在模拟的临床场景中更实际地评估LLMs的表现。我们开发了“多视图医疗评估”(MVME)基准测试,利用高质量的中文医疗记录和多种评估策略来量化由LLM驱动的医生智能体在症状收集、检查建议和诊断方面的表现。此外,提出了一种争议解决协作机制,通过迭代讨论提升医疗互动能力。尽管有所改进,当前的LLM(包括GPT-4)在多轮互动场景中的表现与非互动场景相比仍有显著差距。我们的研究结果强调了进一步研究的必要性,以缩小这些差距并提高大型语言模型在临床决策方面的能力。

数据、代码和实验结果均在https://github.com/LibertFan/AI_Hospital开源。

https://aclanthology.org/2025.coling-main.680/

核心速览

研究背景

- 研究问题:这篇文章要解决的问题是如何评估大型语言模型(LLMs)在真实世界临床诊断中的应用潜力。尽管LLMs在静态医学问答基准测试中表现出色,但在动态的医患互动中仍存在显著挑战。

- 研究难点:该问题的研究难点包括:动态诊断过程涉及多轮互动,而现有的LLMs在多轮互动场景中的表现远不如非互动场景;LLMs难以通过互动收集全面的患者信息并推荐正确的医学检查。

- 相关工作:在LLMs应用于医学领域之前,已有研究尝试创建医疗领域的代理,但这些代理通常缺乏灵活性,难以准确模拟复杂的医疗场景。近年来,随着LLMs的发展,其在复杂任务解决方面取得了显著进展,但在疾病诊断方面的应用仍面临挑战。

研究方法

这篇论文提出了AI Hospital框架,用于模拟真实的动态医疗互动,并开发了多视图医学评估(MVME)基准来评估LLMs在临床诊断中的表现。具体来说:

- AI Hospital框架:该框架包括两个非玩家角色(NPC):患者和检查员,以及一个玩家角色:医生。医生通过与患者和检查员的互动来完成患者的诊断,并生成完整的诊断报告。

- 多视图医学评估(MVME)基准:基于AI Hospital框架,利用高质量的中文病历记录,评估LLMs驱动的医生代理在症状收集、检查建议和诊断等方面的表现。评估方法包括基于链接的自动评估、基于模型的评估和人工评估。

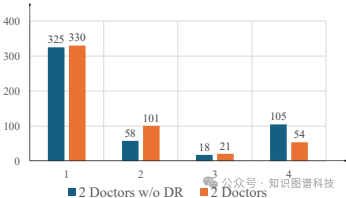

- 争议解决协作机制:提出了一种协作机制,通过多个医生独立诊断同一病例,生成不同的对话轨迹和诊断报告,然后通过中心代理促进有效讨论,达成共识。

实验设计

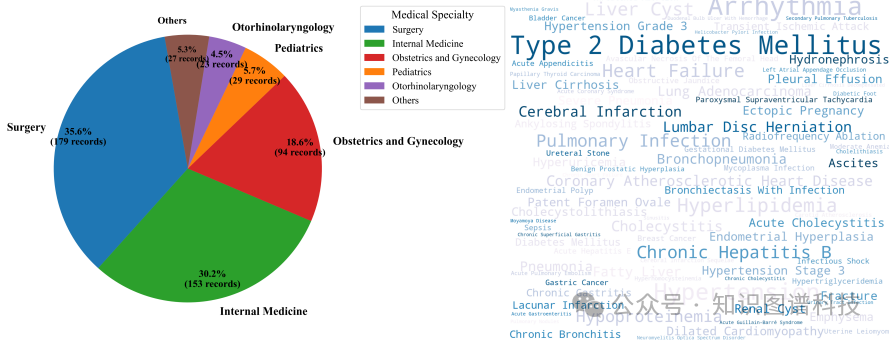

- 数据收集:从iyi.com网站收集了506份高质量的医疗记录,涵盖12个专科、48个亚专科和多种疾病。

- 实验设置:使用多个医生代理,包括GPT-3.5、GPT-4、Wenxin-4和Qwen-Max,随机选择50份病历样本,每个代理生成50轮多轮对话轨迹。手动标注所有指标并报告平均值。

- 评估指标:包括症状收集、检查建议和诊断等方面的评估。基于链接的评估使用ICD-10标准计算实体重叠度;基于模型的评估使用GPT-4作为评估器,采用离散评分系统;人工评估由专业医生进行,遵循与GPT-4评估器相同的评分标准。

结果与分析

- AI Hospital框架的有效性:实验结果表明,AI Hospital框架能够有效模拟真实的医疗互动,所有指标的平均值均超过95,表明代理行为可靠且一致。

- 各种医生代理的性能:在多轮互动场景中,现有LLMs的表现显著低于一步GPT-4方法。例如,GPT-4在诊断准确性、推理和治疗计划方面的表现不足其一步设置性能的50%。

- 协作机制的效果:协作机制在一定程度上提高了性能,但仍未能达到上限。主要原因是医生代理未能准确推荐必要的医学检查,以及在互动过程中未能询问关键的相关症状。

- 诊断性能与信息完整性的关系:分析表明,患者信息的完整性越高,诊断质量越高。当前LLMs难以通过互动动态收集全面的信息,推荐正确的医学检查也是一个挑战。

总体结论

这篇论文通过引入AI Hospital框架和多视图医学评估(MVME)基准,首次系统地评估了LLMs在模拟医疗互动中的能力。结果表明,尽管LLMs在静态医学问答中表现出色,但在动态诊断场景中仍存在显著局限性。未来的研究应致力于改进LLMs的训练,以缩小与人类专家在临床医学中的差距。

论文评价

优点与创新

- 引入AI Hospital框架论文首次提出了基于大型语言模型(LLM)的多代理框架,模拟真实的医疗互动,全面评估LLM在复杂临床场景中的能力。

- 建立MVME基准开发了多视图医学评估(MVME)基准,利用高质量的中文病历记录,评估LLM驱动的医生代理在收集症状、推荐检查和诊断方面的表现。

- 提出争议解决协作机制提出了一种协作机制,通过迭代讨论提高诊断准确性,展示了LLM在临床诊断中的应用潜力。

- 数据集可视化与统计对数据集进行了详细的可视化与统计分析,展示了数据集的多样性和复杂性,强调了医生代理在面对数百种检查选项时需要具备的强大信息收集能力。

- 多部门性能分析分析了不同医院部门的LLM性能,揭示了交互能力与诊断能力之间的正相关性,强调了考虑每个医疗专业的特定要求和复杂性在部署LLM时的重要性。

不足与反思

- 数据集局限性数据集主要来源于中文病历记录,可能限制了研究结果的通用性,难以推广到其他语言和医疗系统。

- 患者代理设置的影响未探讨不同患者背景、文化和偏见对模型性能的影响。

- 外部工具的利用未研究医生代理利用外部工具、外部知识或基于多模态医疗信息做出决策的能力。

- 资源消耗依赖大量LLM API进行新模型的测试会消耗大量资源,并可能增加碳排放。

- 框架的复杂性提出的AI Hospital和协作机制基于相对简单的框架,可能未能完全捕捉真实世界临床合作的复杂性,需要在更多样化和实际的设置中进一步细化和验证。

关键问题及回答

问题1:AI Hospital框架是如何设计的,它如何模拟真实的医疗互动?

AI Hospital框架包括两个非玩家角色(NPC):患者和检查员,以及一个玩家角色:医生。医生通过与患者和检查员的互动来完成患者的诊断,并生成完整的诊断报告。具体来说,患者代理会根据病历中的基本信息与医生进行对话,提供症状和既往病史等信息。医生则会根据这些信息询问更多的细节,并建议进行必要的医学检查。检查员代理会提供相应的检查结果,医生再根据这些结果进行诊断,并最终生成诊断报告。整个对话过程被限制在预定的最大回合数内,以确保对话的结构化和有限性。

问题2:多视图医学评估(MVME)基准是如何构建的,它包括哪些评估方法?

多视图医学评估(MVME)基准基于AI Hospital框架,利用高质量的中文病历记录来评估LLMs驱动的医生代理在症状收集、检查建议和诊断等方面的表现。具体评估方法包括:

- 基于链接的自动评估计算诊断结果部分的实体重叠度,使用ICD-10标准提取疾病实体并计算其重叠度,以衡量最终诊断的准确性。

- 基于模型的评估使用GPT-4作为评估器,对诊断报告的各个部分(如症状收集、检查建议、诊断结果等)进行离散评分,评分标准为1到4(从差到优)。

- 人工评估由专业医生进行,遵循与GPT-4评估器相同的评分标准,对诊断报告的各个方面进行详细评估。

问题3:实验结果表明LLMs在多轮互动场景中的表现如何,与一步GPT-4方法相比有哪些差距?

实验结果表明,现有LLMs在多轮互动场景中的表现显著低于一步GPT-4方法。具体来说,GPT-4在诊断准确性、推理和治疗计划方面的表现不足其一步设置性能的50%。这表明LLMs在动态诊断场景中仍存在显著局限性,难以通过互动收集全面的患者信息并推荐正确的医学检查。此外,协作机制虽然在一定程度上提高了性能,但仍未能达到上限,主要原因是医生代理未能准确推荐必要的医学检查,以及在互动过程中未能询问关键的相关症状。

本文转载自知识图谱科技,作者:Wolfgang