TinyR1-32B-Preview: 通过全新分支合并蒸馏技术让大模型瘦身不掉智商

图片

图片

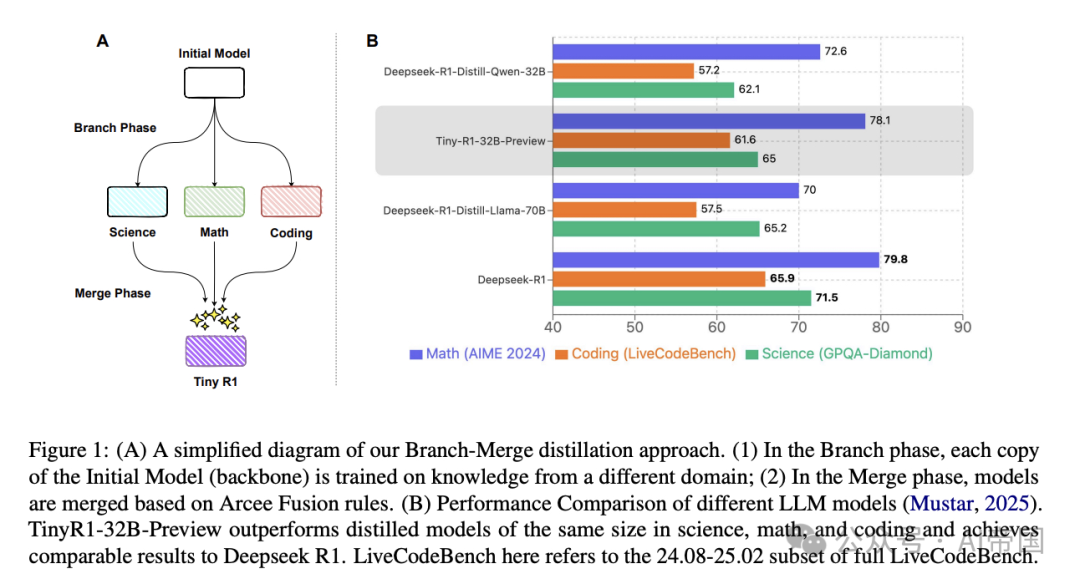

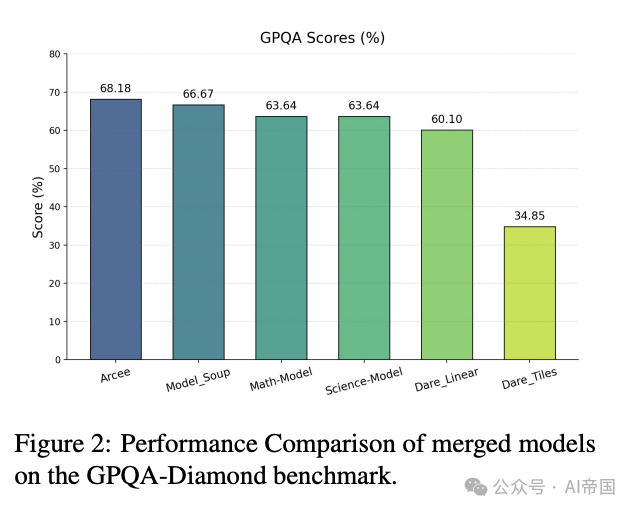

图1:(A) 我们的分支合并蒸馏方法的简化图解。(1) 在分支阶段,初始模型(骨干网络)的每个副本都在不同领域的知识上进行训练;(2) 在合并阶段,模型基于Arcee Fusion规则进行合并。(B) 不同LLM模型的性能比较(Mustar, 2025)。TinyR1-32B-Preview在科学、数学和编程领域的表现优于同等规模的蒸馏模型,并达到了与Deepseek R1相当的结果。这里的LiveCodeBench指的是完整LiveCodeBench的24.08-25.02子集。

你是否好奇:为什么大语言模型一定要那么"大"?能不能让它们变得更"小"却依然聪明?今天,我为大家带来一项突破性的研究成果——TinyR1-32B-Preview模型,它通过创新的"分支合并蒸馏"(Branch-Merge Distillation)技术,用仅有671B参数5%的规模,实现了接近DeepSeek-R1旗舰模型的推理能力。这可能意味着,未来我们每个人都能在自己的设备上运行强大的AI模型!

1、传统蒸馏方法的困境:小模型为何难以保持高精度?

传统的模型蒸馏技术虽然能让大模型"瘦身",但往往陷入一个两难困境:

(1)数据选择难题:需要精心挑选最相关的领域数据并调整它们的比例进行联合训练,这个过程耗时且容易出错

(2)梯度冲突问题:同时优化多个领域会导致任务之间相互干扰,阻碍整体学习进度

(3)性能天花板:传统方法蒸馏出的小模型难以达到专业任务所需的性能水平

这些问题严重制约了传统数据混合蒸馏的效果,导致小模型无法实现理想的性能水平。

2、分支合并蒸馏:创新性的两阶段知识传递

为解决上述问题,研究团队提出了全新的分支合并蒸馏方法,它包含两个关键阶段:

(1)分支阶段(Branch Phase): 将知识从统一的大型教师模型(如DeepSeek-R1 671B)选择性地蒸馏到几个专门的学生模型中。具体来说,团队构建了三个专业数据集:

1)数学领域:从NuminaMath1.5筛选出58K个样本,并配合OpenR1的解决方案

2)编程领域:从OpenThoughts数据集过滤形成20K个编码解决方案轨迹

3)科学领域:利用DeepSeek-R1生成8.6K个科学问题的思维链轨迹

然后,他们基于DeepSeek-R1-Distill-Qwen-32B模型,对这三个领域分别进行监督微调(SFT),得到了三个专业领域的专家模型。

(2)合并阶段(Merge Phase): 通过Arcee Fusion技术将不同领域的专家模型合并成一个统一模型。这种合并不是简单的参数平均,而是通过三个精细步骤进行:

1)重要性评分:计算每个参数的重要性

2)动态选择:确定参数更新的阈值

3)选择性整合:只集成超过阈值的重要参数

这种方法通过聚焦最显著的变化,避免了过度更新并维持了模型稳定性。

3、惊人的成果:小模型也能有大智慧

图片

图片

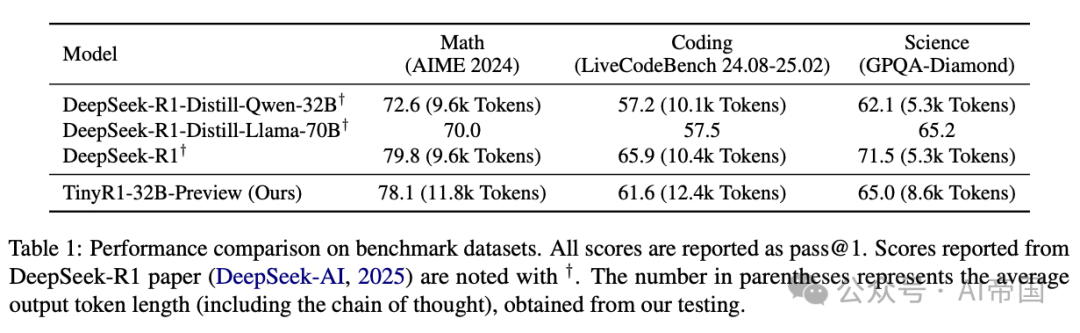

经过严格评测,TinyR1-32B-Preview模型取得了令人瞩目的成绩:

1)性能大幅提升:相比于backbone模型DeepSeek-R1-Distill-Qwen-32B,在数学领域提升了5.5个百分点,编程领域提升了4.4个百分点,科学领域提升了2.9个百分点

2)超越更大模型:总体上超过了DeepSeek-R1-Distill-Llama-70B(数学+8.1,编程+4.1,科学-0.2)

3)接近旗舰模型:性能接近DeepSeek-R1旗舰模型(数学-1.7,编程-4.3,科学-6.5)

4)推理成本可控:生成的输出token数量仅比R1略多(数学+23%,编程+19%,科学+62%)

5)参数量大幅减少:模型参数量更小,更适合用户和小团队在本地部署

图片

图片

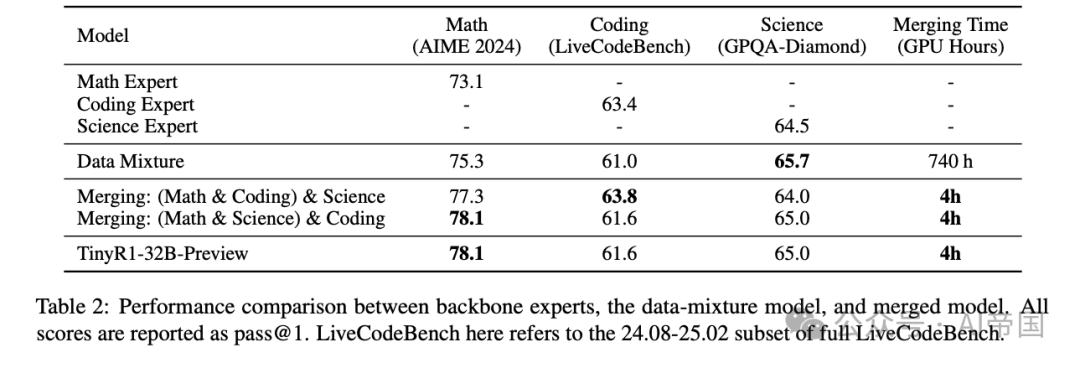

4、高效与简便:90%时间成本节省

图片

图片

分支合并蒸馏方法不仅提高了模型精度,还显著降低了时间和计算成本:

1)合并阶段成本大降:与传统方法相比,合并阶段节省了90%的时间(4个H800 GPU仅需0.5小时 vs. 32个H800 GPU需要23小时)

2)总复制成本可控:TinyR1-32B-Preview的理想复制成本为744个H800 GPU小时,约1500美元(不包括消融实验和参数搜索)

3)"免费午餐":模型合并既降低了计算开销,又通过避免混合数据重新SFT带来的延迟,显著加速了模型发布过程

更重要的是,研究团队承诺将开源他们的模型、所有数据、训练代码、评估代码和日志,使任何人都能重现他们的结果。

5、未来展望:更多可能性正在展开

这项研究成果打开了大模型瘦身的新思路,团队也提出了几个有前景的未来发展方向:

1)探索替代骨干模型:例如,使用Qwen-Instruct模型作为骨干进行SFT

2)发布各种规模的模型:扩展模型阵容以满足不同需求

3)深入研究实验细节影响:进一步分析各种实验设置如何影响最终性能

思考与启示:分支合并蒸馏技术的出现,让我们看到了大模型瘦身的新可能。它不仅解决了传统蒸馏方法的局限,更为AI的普及与个性化部署铺平了道路。未来,更小、更高效、更智能的AI模型将走进每个人的生活,改变我们与技术交互的方式。你是否已经准备好,迎接这个人人都能拥有强大AI的时代?

论文标题:TinyR1-32B-Preview: Boosting Accuracy with Branch-Merge Distillation

论文链接:https://arxiv.org/abs/2503.04872

本文转载自AI帝国,作者:无影寺