CVPR 2025 | 电商退货率或将腰斩!VTON 360突破3D虚拟试衣天花板:无死角虚拟换装 精华

文章链接: https://arxiv.org/pdf/2503.12165

项目链接:https://scnuhealthy.github.io/VTON360

亮点直击

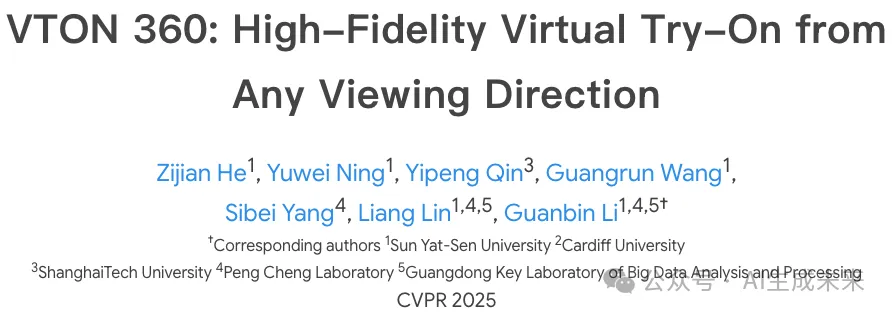

- 一种新颖的3D虚拟试衣(VTON)方法,即VTON 360,能够从任意视角实现高保真度的虚拟试衣。

- 利用3D模型与其渲染的多视角2D图像之间的等价性,将3D VTON重新定义为2D VTON的扩展,确保多视角下的一致性结果。具体而言,引入了多项新技术,包括:(i)伪3D姿态表示;(ii)多视角空间注意力机制;以及(iii)多视角CLIP嵌入。这些创新增强了传统2D VTON模型,使其能够生成多视角且3D一致的结果。

- 在两个大型真实数据集以及来自电子商务平台的真实服装图像上进行的大量实验结果证明了本文方法的有效性。

效果速览

总结速览

解决的问题

- 2D VTON的局限性:现有的2D虚拟试衣(VTON)技术在表示与视角相关的特征方面存在固有局限性,无法支持高保真度的多视角渲染。

- 3D VTON的挑战:现有的3D VTON方法在实现高保真度和支持任意视角渲染方面仍面临挑战,尤其是在服装的几何一致性和纹理保真度方面。

- 数据获取成本高:早期的3D VTON方法依赖昂贵的3D扫描设备和物理存在的人体/服装,限制了其在实际应用中的实用性。

- 多视角信息缺失:现有的基于图像的3D VTON方法由于输入图像(通常是正面)缺乏多视角信息,难以重建高质量的多视角服装模型。

提出的方案

- VTON 360方法:通过扩展2D VTON模型,引入多视角服装和与服装无关的人体图像作为输入,确保多视角下的3D一致性。

- 伪3D姿态表示:使用从SMPL-X 3D人体模型导出的法线图来表示伪3D姿态,捕捉细粒度的表面方向细节,提供跨视角的几何一致性。

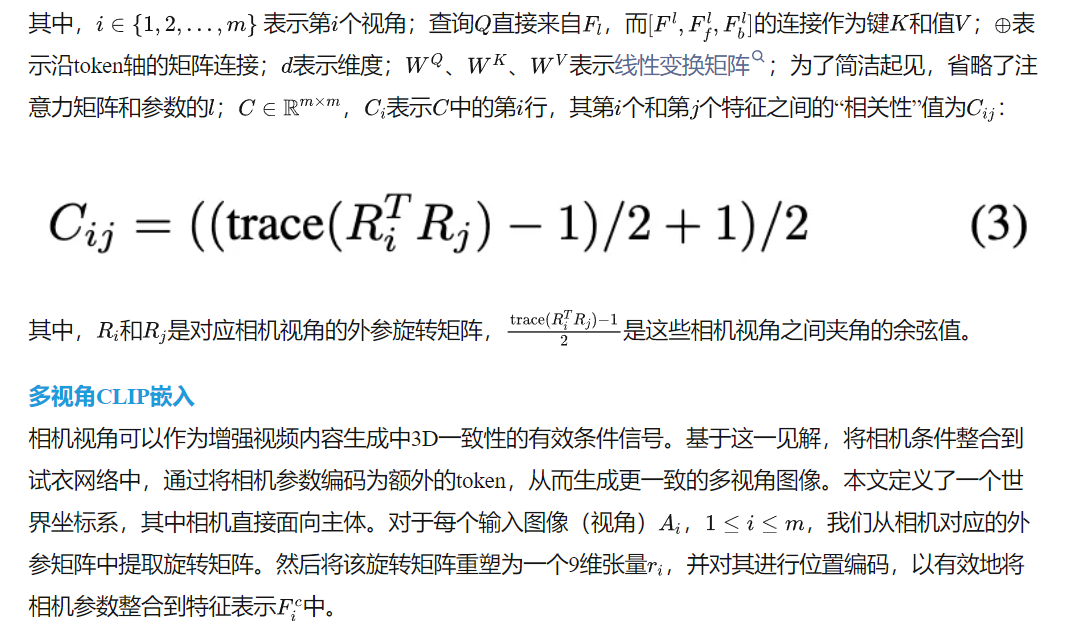

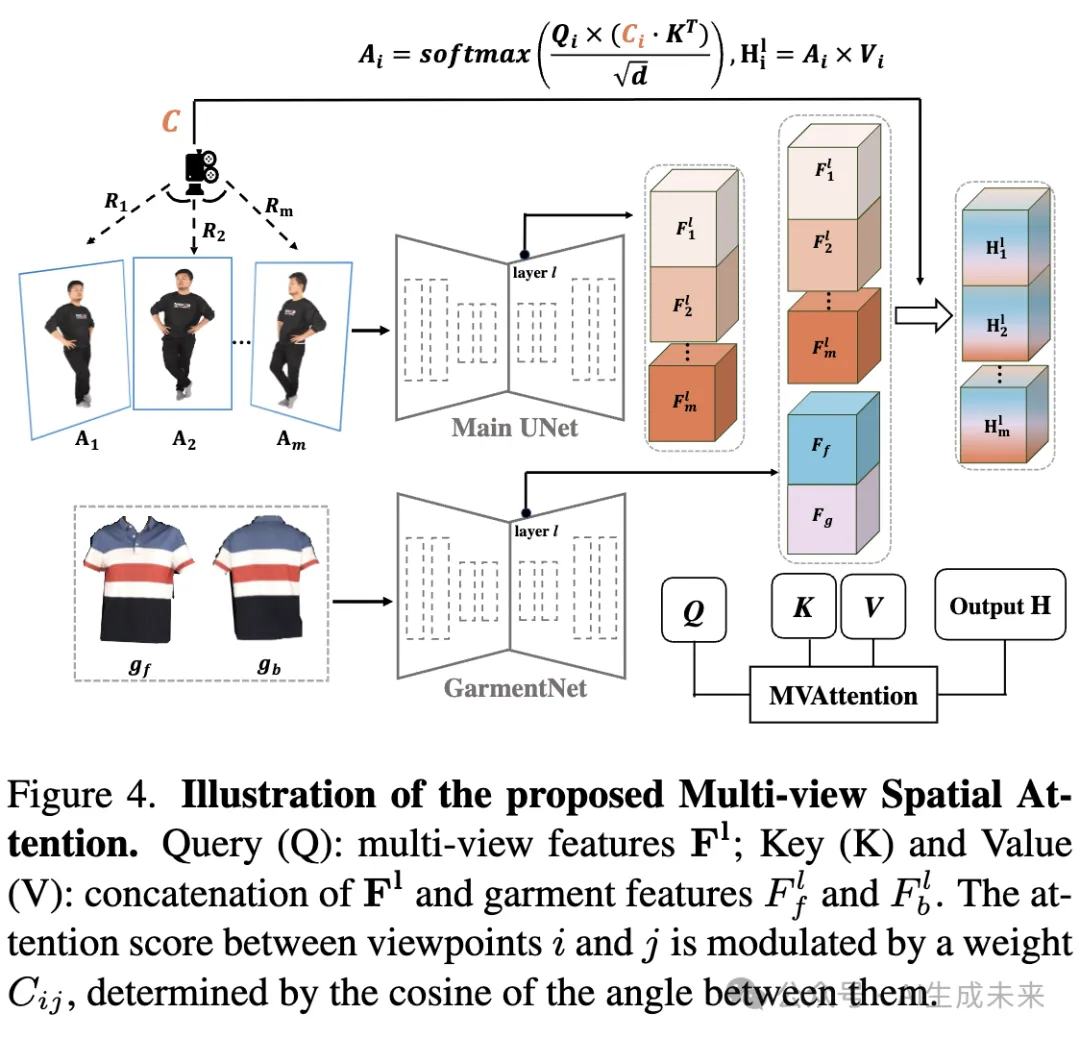

- 多视角空间注意力机制:设计了一种多视角空间注意力机制,建模不同视角特征之间的相关性,通过“相关性”矩阵来建模不同输入视角之间的关系。

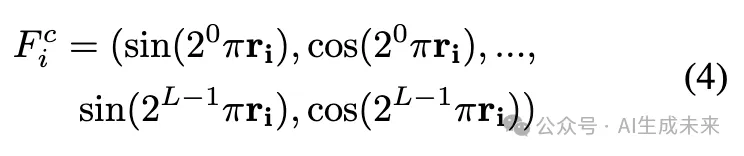

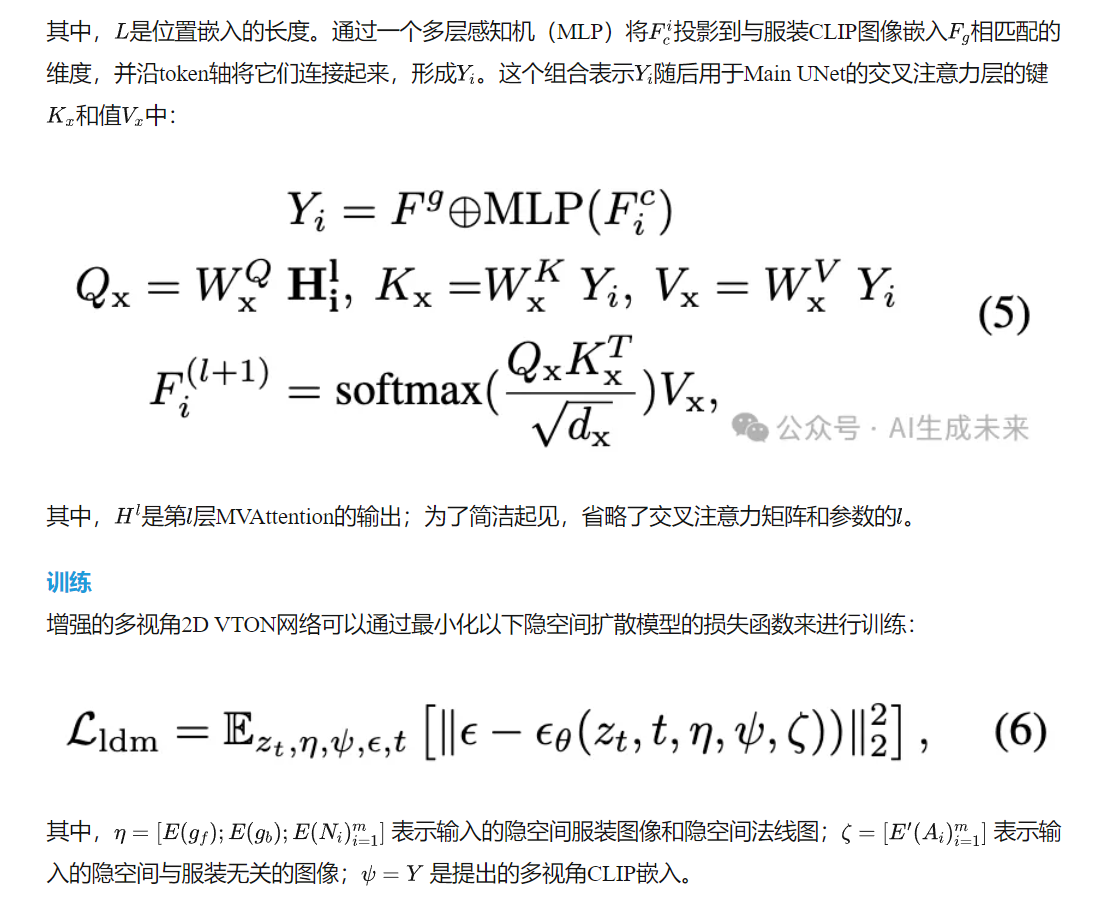

- 多视角CLIP嵌入:提出了多视角CLIP嵌入,增强了2D VTON方法中使用的服装CLIP嵌入,加入相机信息,促进网络学习与特定视角相关的特征。

应用的技术

- 2D VTON模型扩展:将2D VTON模型扩展为支持多视角输入,包括前后视角的服装图像和从随机方位角采样的多视角与服装无关的人体图像。

- SMPL-X 3D人体模型:利用SMPL-X 3D人体模型生成法线图,用于伪3D姿态表示。

- 多视角空间注意力机制:通过设计多视角空间注意力机制,建模不同视角特征之间的相关性。

- 多视角CLIP嵌入:将相机信息融入CLIP嵌入,增强网络对特定视角特征的学习能力。

达到的效果

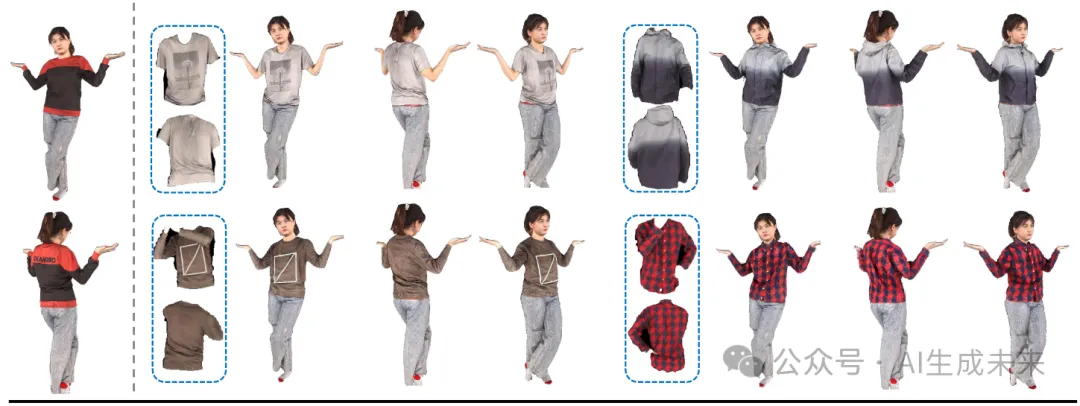

- 高保真度3D VTON:在Thuman2.0和MVHumanNet数据集上的大量实验表明,VTON 360方法能够实现高保真度的3D VTON,并支持任意视角渲染。

- 多视角一致性:通过引入多视角输入和伪3D姿态表示,确保了多视角下的3D一致性。

- 实际应用验证:通过在电子商务平台的服装上进行测试,验证了该方法的有效性和通用性。

方法

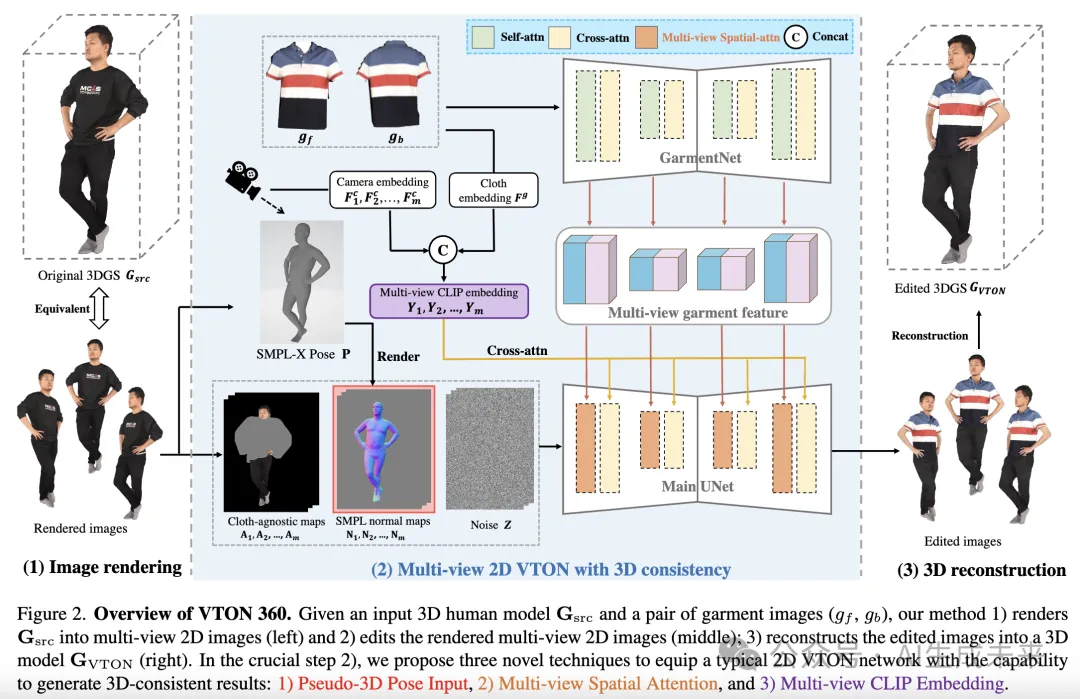

本文的方法利用3D模型与其渲染的多视角2D图像之间的等价性,实现高保真度、任意视角的3D虚拟试衣(VTON)。具体而言,如图2所示,给定输入的3D人体模型和服装图像,本文的方法:

- 将3D模型渲染为多视角2D图像;

- 将3D VTON定义为在这些渲染视角上一致且统一的2D VTON过程;

- 通过使用现有的3D重建方法将编辑后的图像重建为3D模型,确保从任意视角观看时的视觉一致性和精确的服装对齐。其中,第二步至关重要,因为现有的2D VTON方法缺乏3D知识,无法生成具有3D一致性的多视角图像。

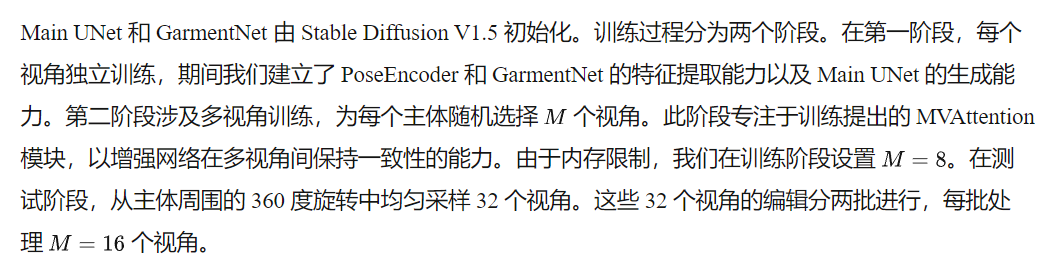

为了解决这一挑战,本文提出了多项新技术,为典型的2D VTON网络 赋予了生成3D一致性结果的能力。该网络基于隐空间扩散模型,并使用高斯泼溅(Gaussian Splatting)作为3D表示。

2D VTON框架回顾

具有3D一致性的多视角2D VTON

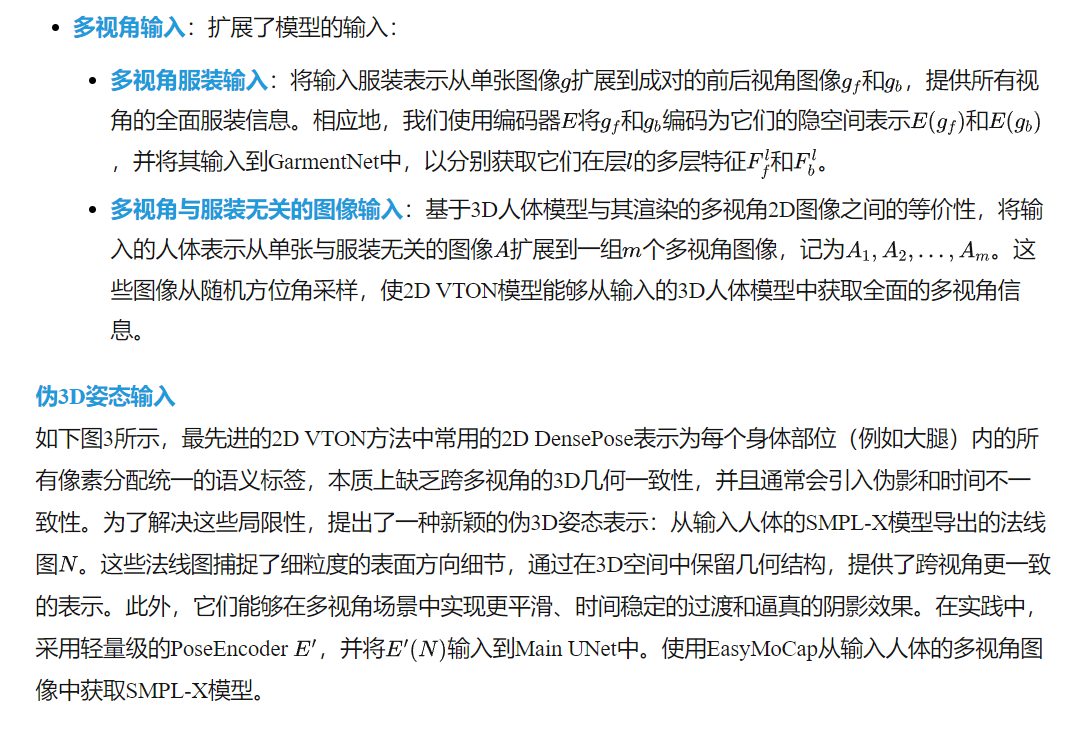

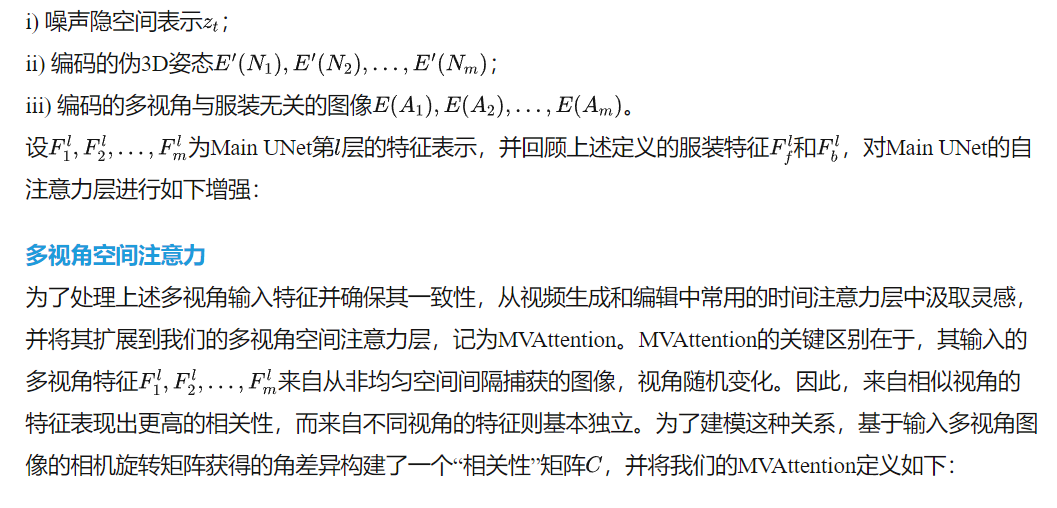

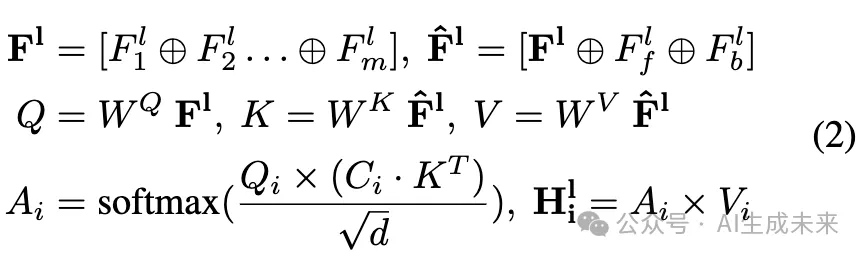

为了使上述2D VTON模型能够生成多视角且3D一致的结果,对其设计提出了以下新颖的改进:

相应地,将三个组件连接起来作为Main UNet的增强输入:

实验

实验设置

数据集:本文在两个公开数据集上进行了实验:Thuman2.0 和 MVHumanNet。Thuman2.0 包含 526 个重建的穿衣人体扫描,从中渲染多视角输入图像。其中 426 个样本用于训练,剩余的 100 个用于测试。为了进一步评估本文方法的有效性和鲁棒性,还在 MVHumanNet 上进行了实验。MVHumanNet 是一个大规模的多视角人体图像数据集,涵盖了多样化的主体、日常服装和运动序列。MVHumanNet 中的图像使用 48 或 24 个相机的多视角系统捕获。我们从该数据集中使用了 4,990 个主体,其中 4,790 个用于训练,200 个用于测试。对于每个主体,我们从其整个运动序列中随机选择两帧多视角图像。虽然 MVHumanNet 直接提供了多视角图像用于编辑和重建,但在 Thuman2.0 中为每个主体渲染均匀分布的视角以确保输入的一致性。

基线方法:主要将本文的方法与三种现有方法进行比较:DreamWaltz、GaussCtrl和 TIP-Editor。DreamWaltz 是一种基于文本描述直接生成 3D 人体的方法,而 GaussCtrl 和 TIP-Editor 是基于辐射场的编辑方法。GaussCtrl 基于 Stable Diffusion,使用类似描述的提示编辑场景。TIP-Editor 接受文本和图像提示。我们通过指定人体为编辑区域,并将目标服装作为图像提示来配置它。使用 ChatGPT 生成与服装图像对应的文本提示。

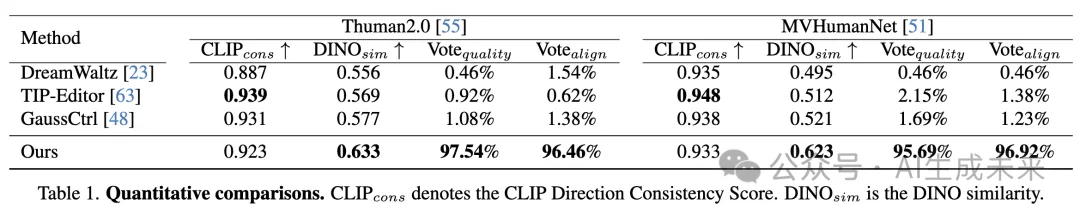

评估指标:为了定量评估,评估编辑后的人体与参考图像之间的服装对齐情况。根据 [63],计算参考图像与编辑后的 3D 场景渲染的多视角图像之间的平均 DINO 相似度。此外,为了评估多视角一致性,按照 [17] 计算 CLIP 方向一致性分数。由于实验规模较大(重复的 3DGS 重建),从数据集中选择了一部分样本进行指标评估。从 Thuman 和 MVHumanNet 的测试集中,随机抽取了 10 个人体扫描,每个人体扫描使用 6 个随机选择的服装进行虚拟试衣。

本文还进行了一项用户研究,邀请了 50 名参与者对本文的方法和三种基线方法的结果进行评分,评分标准包括整体“质量”和与参考图像的“对齐”程度。每次评估包含两个问题:(1) 哪种方法生成的编辑后 3D 人体质量最高?(2) 哪种方法与目标服装的对齐最一致?参与者通过观看随机旋转的视频序列来评估 VTON 结果。

实现细节:在预处理阶段,我们将多视角图像裁剪到人体周围的边界框,并将其调整为 768 × 576 的分辨率。服装图像的前视图和后视图从相应的穿衣人体图像中获取。编辑后,我们将图像填充回原始大小。Thuman2.0 和 MVHumanNet 数据集的数据处理流程相同。

与最先进方法的比较

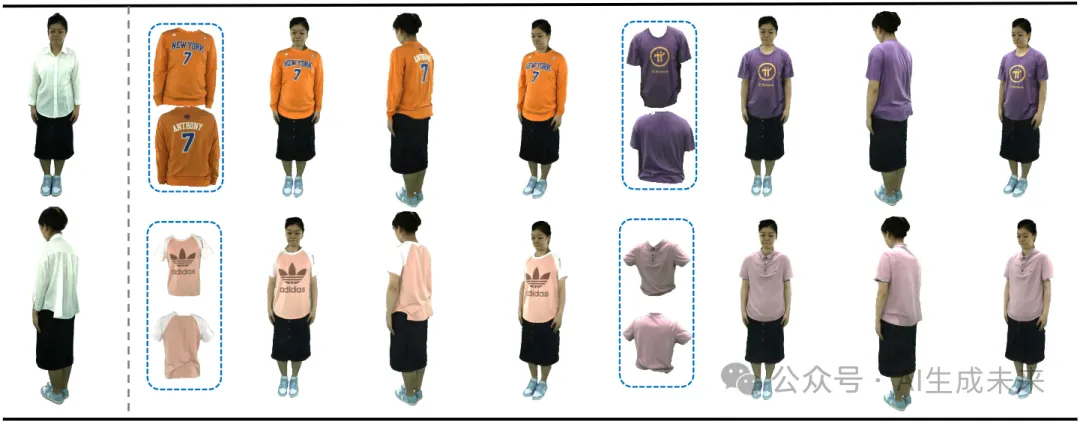

定性评估:下图5展示了本文的方法与基线方法的视觉对比。DreamWaltz 从文本提示重新生成3D穿衣人体,但难以准确保留身体和服装的特征。GaussCtrl 由于不支持图像提示,无法保持详细的服装纹理。虽然Tip-Editor 利用LoRA 进行个性化,但由于个性化概念在2D空间中是语义的,它在将两个视角的服装输入一致映射到3D人体时遇到困难。相比之下,本文的方法有效地保留了复杂的服装细节,如文字、条纹和标志。

定量评估:下表1展示了在Thuman2.0和MVHumanNet数据集上的CLIP方向一致性分数和DINO相似度的结果。本文的方法在DINO相似度上优于其他方法,清楚地展示了我们在服装纹理保留方面的优势。虽然我们的CLIP一致性结果与其他方法相当,但需要注意的是,这些方法结合了SDS损失,这在一定程度上平滑了3D空间中的人体表示。此外,其他方法的“更平坦”纹理也可能导致人为更高的一致性分数。此外,用户研究表明,本文的方法在编辑后的3D人体质量和服装细节对齐方面显著优于基线方法。

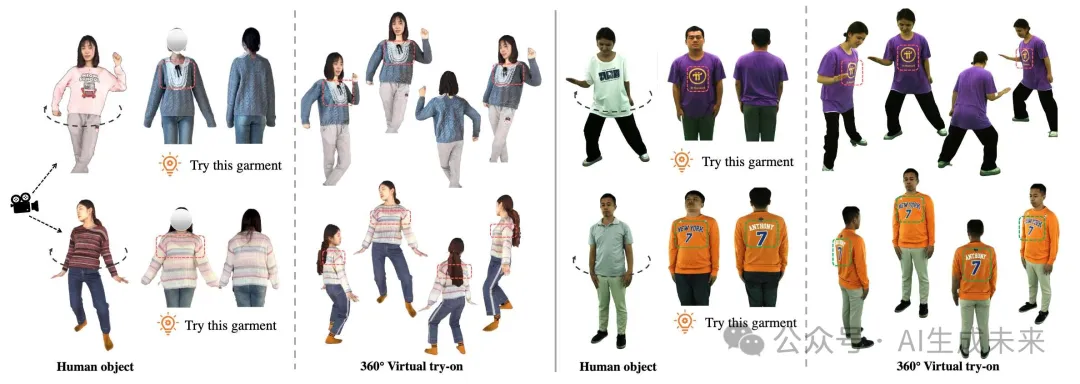

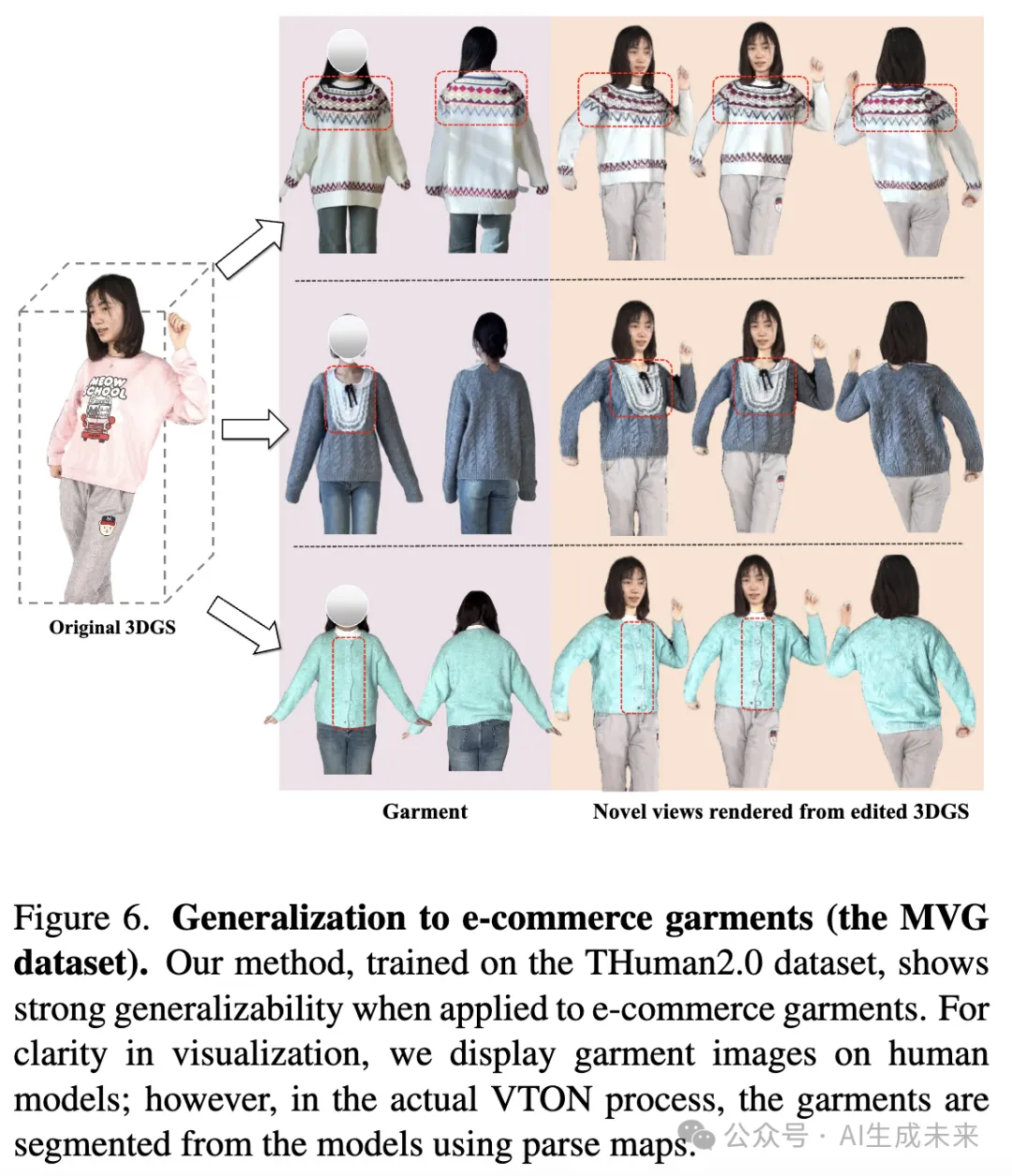

使用电子商务服装的视觉结果

下图6展示了使用MVG数据集中的服装进行的VTON结果,这些图像来自YOOX NET-A-PORTER、淘宝和抖音等电子商务平台,并在Thuman2.0数据集上训练的模型。结果表明,本文的方法有效地保留了复杂的服装细节和纹理。例如,它准确地保留了第一行中的条纹图案、第二行中的可爱领带以及第三行中的纽扣,突出了本文方法在处理多样化和现实服装项目时的鲁棒性。

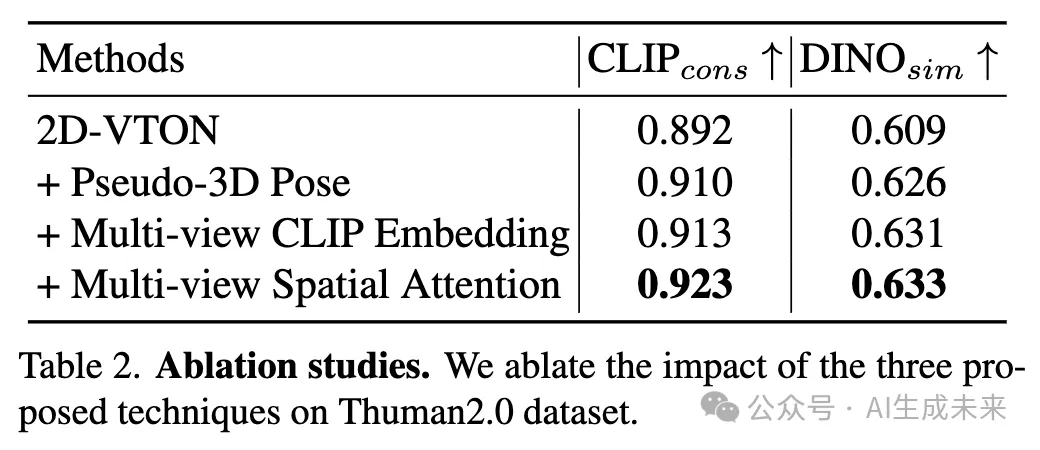

消融研究

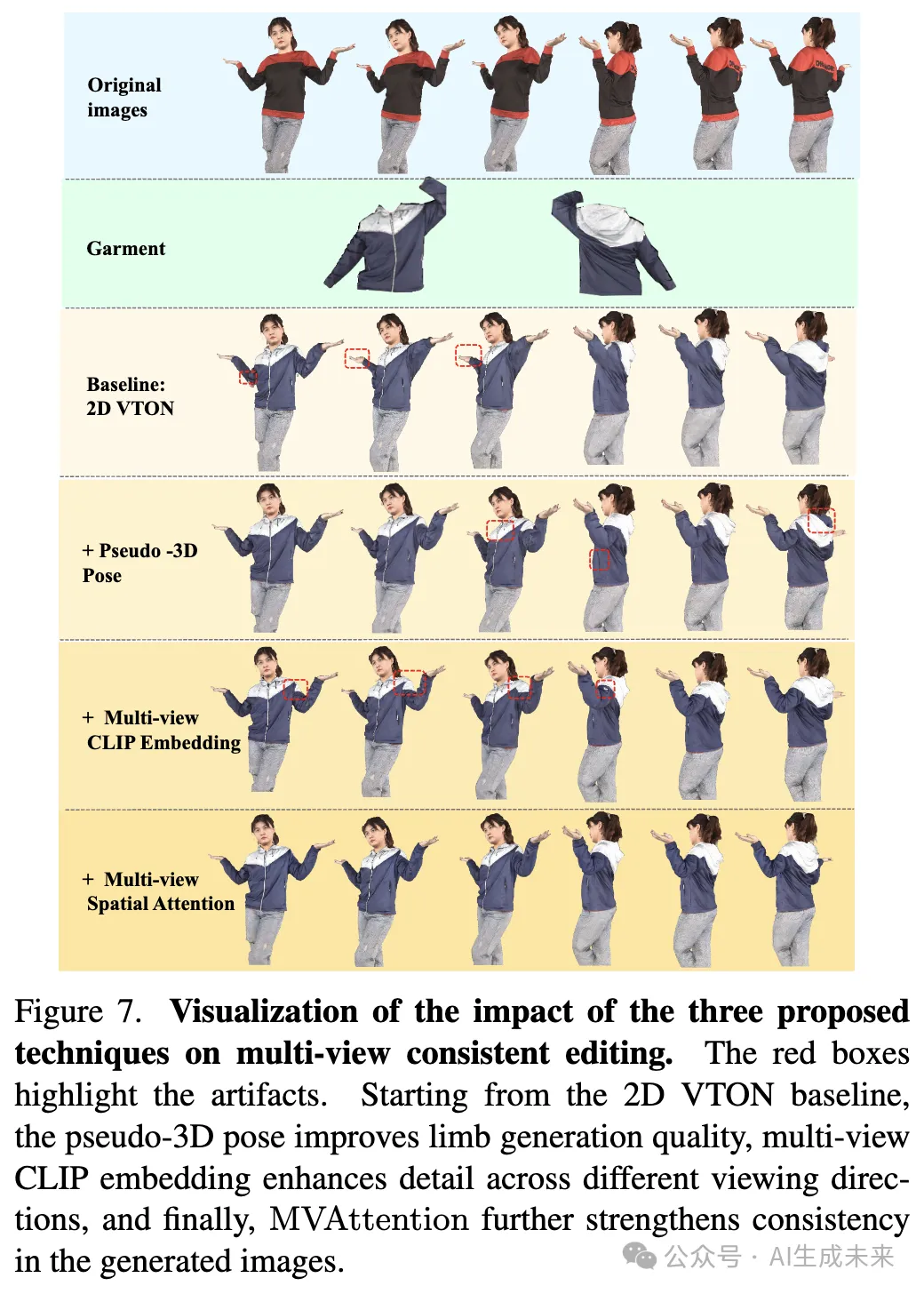

在Thuman2.0数据集上进行了消融研究,如下表2和图7所示,以评估本文提出的三个模块在增强典型2D VTON网络以具备3D一致性生成能力方面的影响。从使用DensePose的2D VTON基线 开始,我们逐步用伪3D姿态替换DensePose,加入多视角CLIP嵌入,并最终在最终配置中整合MVAttention。表2中的结果表明,每个模块都对指标改进有所贡献。图7展示了一个多视角图像编辑的示例。与2D VTON基线相比,伪3D姿态的引入显著改善了肢体生成。比较第4行和第5行,在整合多视角CLIP嵌入之前,模型捕捉到的空间信息有限,导致在特定角度(第3、4和6列)出现细节丢失。最后,提出的MVAttention实现了跨视角的更一致生成。

结论

VTON 360,一种新颖的3D虚拟试衣(VTON)方法,能够实现高保真度的虚拟试衣,并支持从任意视角渲染服装。本文的方法通过将3D VTON重新定义为2D VTON的扩展,确保多视角下的3D一致性结果。为了弥合2D VTON模型与3D一致性需求之间的差距,引入了多项关键创新,包括多视角输入、伪3D姿态表示、多视角空间注意力机制以及多视角CLIP嵌入。大量实验证明了本文方法的有效性,在保真度和任意视角渲染方面显著优于现有的3D VTON技术。

本文转自AI生成未来 ,作者:AI生成未来