面向疾病管理的对话式人工智能 - Google研究院&DeepMind

摘要

虽然大型语言模型(LLMs)在诊断对话中显示出潜力,但它们在有效管理推理方面的能力——包括疾病进展、治疗反应和安全药物处方——仍有待进一步探索。我们通过一种新的基于LLMs的代理系统推进了之前展示的Articulate Medical Intelligence Explorer(AMIE)的诊断能力,该系统针对临床管理和对话进行了优化,整合了对疾病演变、多次患者就诊经历、治疗反应以及药物处方专业能力的推理。AMIE在权威临床知识的基础上进行推理,利用Gemini的长上下文能力,结合上下文检索与结构化推理,使其输出与相关的最新临床实践指南和药物配方保持一致。在一项随机、盲法的虚拟客观结构化临床考试(OSCE)研究中,AMIE与21名初级保健医生进行了比较在100个多诊次病例场景中,对初级保健医生(PCPs)进行了测试,这些场景旨在反映英国国家卫生与临床优化研究所(NICE)指南和《英国医学杂志》(BMJ)最佳实践指南。由专家医生评估,在管理推理方面,人工智能助理(AMIE)不逊于PCPs,并且在治疗的精确性和调查、以及其与管理计划在临床指南中的对齐和依据方面表现更佳。

为了衡量药物推理能力,我们开发了RxQA,这是一个基于两个国家药品目录(美国和英国)的多项选择题基准,并由认证药剂师验证。虽然AMIE和PCPs都能从访问外部药物信息中受益,但在更高难度的问题上,AMIE的表现优于PCPs。尽管在实际应用前还需要进一步研究,但AMIE在各项评估中的强劲表现标志着在对话式人工智能作为疾病管理工具方面迈出了重要一步。

https://arxiv.org/abs/2503.06074

核心速览

研究背景

- 研究问题:这篇文章要解决的问题是如何通过大型语言模型(LLMs)在疾病管理中进行有效的对话式人工智能(AI)应用,特别是在诊断推理和管理推理方面的能力。

- 研究难点:该问题的研究难点包括:诊断推理虽然重要,但管理推理更为复杂,涉及疾病的纵向演变、多次患者就诊、治疗反应和药物处方的专业能力。此外,现有的研究大多集中在静态的非对话环境中,缺乏对动态对话环境中的管理推理能力的评估。

- 相关工作:该问题的研究相关工作包括:早期的工作主要集中在将决策理论应用于医学中,使用贝叶斯推断和规则系统来模拟管理决策;近年来,基于认知心理学的方法被引入到临床信息的处理和存储中;LLMs在特定管理任务中表现出类似人类的能力,但在更广泛的推理任务中表现较差。

研究方法

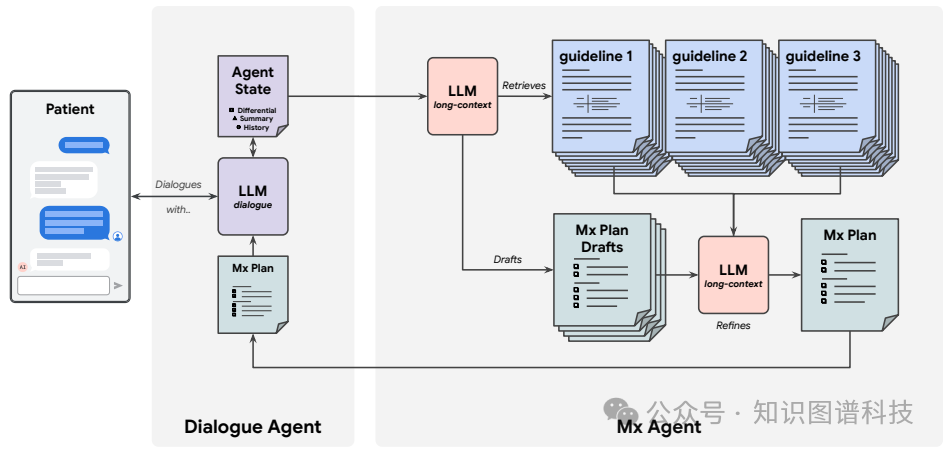

这篇论文提出了一种基于LLMs的代理系统,用于优化临床管理和对话,特别是针对疾病管理中的管理推理。具体来说,

- 对话代理:该代理与患者进行快速、直观且富有同情心的对话,并在多次就诊中保持持续的对话状态。对话代理通过一系列模型调用来生成最终响应,这些调用包括计划响应、生成响应和修订响应。

- Mx代理:该代理通过更广泛的推理时间计算来规划患者的护理。它连续分析患者的病例,从权威临床知识库中推理出临床指南,并生成详细且结构化的管理计划。Mx代理的设计优化包括粗检索、结构化生成和链式推理。

- 链式推理:在推理过程中,对话代理使用一系列模型调用来生成最终响应。每个调用都依赖于对话历史、内部管理的状态以及最新的管理计划。

- 长上下文推理:Mx代理利用Gemini的长上下文推理能力,通过在生成过程中每一步都与上下文数据进行交互来实现丰富的跨文档推理。

实验设计

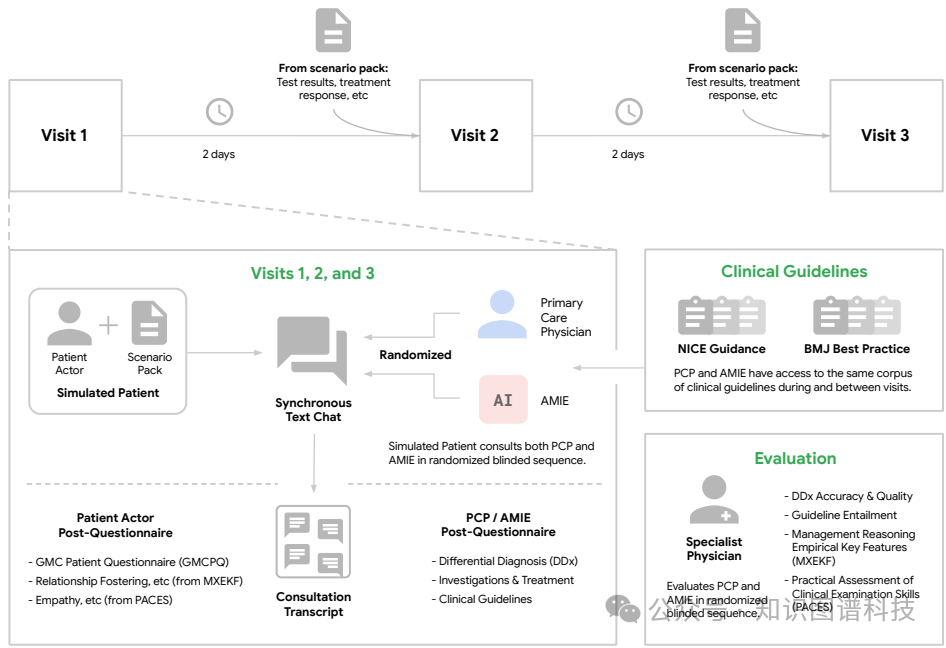

- 数据收集:实验使用了模拟的多就诊病例场景,这些场景由加拿大和印度的医疗提供者编写,描述了患者病情在三次不同就诊中的演变。总共使用了100个场景,涵盖了五个医学专业领域。

- 实验设计:实验采用随机、盲法设计的虚拟客观结构化临床考试(OSCE),比较了AMIE和21名初级保健医生(PCP)在100个多就诊病例场景中的表现。每个场景包括三次文本聊天对话,分别对应于就诊1、2和3,就诊间隔约为2天。

- 样本选择:实验涉及21名认证PCP和21名经过验证的患者演员,分别来自印度和加拿大。PCP具有9年的住院医师经验,患者演员完成了每个场景的两次就诊,一次与AMIE,一次与PCP。

- 参数配置:Mx代理在实时用户交互约束下优化,目标响应时间不超过一分钟。对话代理使用Gemini 1.5 Flash作为基础模型,并通过模拟的多就诊医患对话和其他临床相关数据集进行训练。

结果与分析

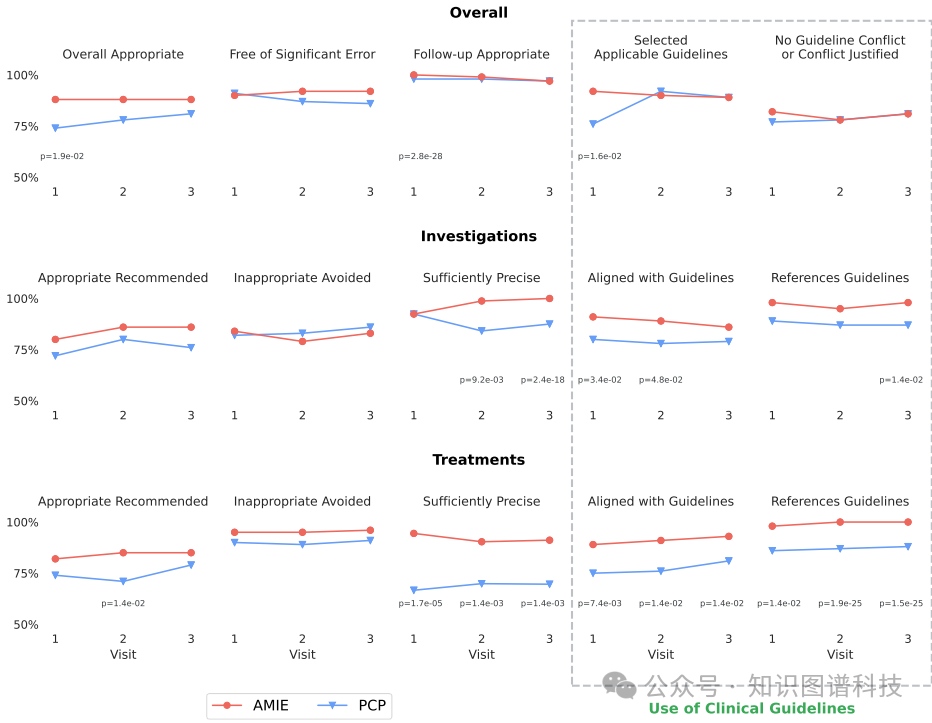

- 管理计划质量:AMIE的管理计划在所有15个评估轴和三次就诊中至少与PCP的表现相当。在初次就诊中,AMIE在计划的整体适当性和提供适当的后续建议方面得分显著高于PCP。

- 治疗和检查推荐的精确性:AMIE在每次就诊结束时推荐治疗和检查的精确性均高于PCP。例如,在第一次就诊中,AMIE的治疗精确性得分为94%,而PCP为67%。

- 临床指南的使用:AMIE在选择适用的指南和推荐与指南一致的治疗方面表现优于PCP。在初次就诊中,AMIE选择适用指南的得分为92%,而PCP为76%。

- 患者演员和专家医生的偏好:在51个独特的MXEKF评估轴组合中,AMIE被患者演员和专家医生优先选择的频率显著高于PCP,中位数胜率为42%。

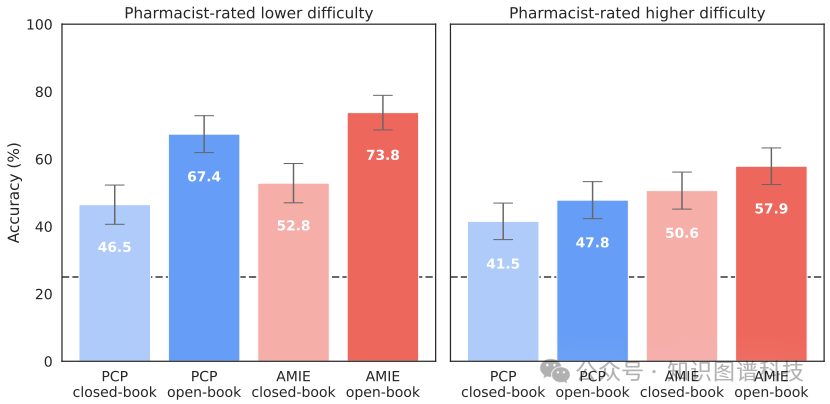

- RxQA药物推理准确性:在RxQA基准测试中,AMIE在高难度问题上的表现显著优于PCP。在闭书设置中,AMIE的高难度问题准确率为50.6%,而PCP为41.5%。

总体结论

这篇论文展示了AMIE在多种管理推理挑战中的一致性表现,能够在多次就诊中生成与认证PCP相当的管理计划。尽管AMIE尚未准备好用于临床护理,但这项研究标志着对话式AI作为疾病管理工具的重要一步。AMIE的精确治疗和检查推荐、指南选择和一致性表现显示出其在实际临床环境中的潜力。未来的研究需要进一步验证AMIE在实际医疗环境中的可行性和安全性。

论文评价

优点与创新

- 优化了AMIE的诊断能力:通过新的基于LLM的代理系统,AMIE在临床管理和对话方面进行了优化,结合了疾病演变、多次患者就诊、治疗反应和药物处方的专业能力。

- 利用Gemini的长上下文能力:AMIE利用Gemini的长上下文能力,结合上下文检索和结构化推理,使其输出与相关的最新临床实践指南和药物配方保持一致。

- 随机、盲法的虚拟OSCE研究:通过随机、盲法的虚拟OSCE研究,将AMIE与21名初级保健医生(PCP)在100个多就诊案例场景中进行了比较,这些场景涵盖了英国NICE指南和BMJ最佳实践指南中的决策。

- RxQA药物推理基准:开发了RxQA,一个基于两个国家药物配方(美国和英国)的多项选择题基准,并由认证药剂师验证。

- 非劣效性评估:AMIE在管理推理方面的整体表现不亚于PCP,在治疗的精确性和调查与治疗计划的一致性方面得分更高。

- 高难度问题的优势:在RxQA的高难度问题上,AMIE的表现优于PCP,尤其是在开放书籍设置中。

不足与反思

- 患者演员的代表性问题:尽管患者演员是医学教育中评估受训临床医生的黄金标准,但它们并不代表临床护理。

- 场景构建的局限性:临床场景是构建的,意味着它们有明确的答案,并且在评分上存在可靠性限制。

- 就诊间隔时间的静态性:尽管场景在叙述中描述了数周或数月的时间跨度,但实际就诊之间的间隔时间为1-2天,这可能增加了人类的表现。

- 文本界面的局限性:使用纯文本界面进行AMIE的用户界面与实际的患者护理存在显著差异,例如电子提供者订单输入系统和药房实践警报。

- RxQA基准的局限性:选择问题的过程可能会使问题偏向于较难的问题,并且不一定代表典型实践。

- 未来工作的方向:需要进一步的研究来展示MXEKF在现实世界中的可靠性和心理测量特性,并描述其特征。

关键问题及回答

问题1:AMIE的Mx代理在处理患者病例时如何进行长上下文推理?

Mx代理利用Gemini的长上下文推理能力,通过在生成过程中每一步都与上下文数据进行交互来实现丰富的跨文档推理。具体来说,Mx代理的设计包括以下几个步骤:

- 粗检索:首先,Mx代理使用Gecko 1B文本嵌入构建一个简单的检索器系统,索引所有临床指南文档。基于生成的查询和摘要,初步过滤掉不相关的文档。

- 结构化生成:其次,Mx代理生成四个初步的管理计划草案。每个草案通过链式推理在一个模型调用中完成,确保生成的内容具有结构性和一致性。

- 精细合并:最后,Mx代理使用最终生成步骤将这些草案合并成一个最终的管理计划。这一过程结合了长上下文推理和多文档推理,确保生成的管理计划全面且细致。

通过这种方式,Mx代理能够在处理复杂病例时,整合和分析大量的临床指南和患者信息,生成高质量的管理计划。

问题2:在多就诊OSCE研究中,AMIE和PCP在管理计划质量方面有哪些具体表现差异?

在多就诊OSCE研究中,AMIE和PCP在管理计划质量方面的具体表现差异如下:

- 初次就诊:在初次就诊中,AMIE在计划的整体适当性(88% vs. 74%,p=0.019)和提供适当的后续建议(100% vs. 98%,p<0.001)方面得分显著高于PCP。然而,在后续就诊中,这些差异不再显著。

- 治疗和检查推荐的精确性:AMIE在每次就诊结束时推荐治疗和检查的精确性均高于PCP。例如,在第一次就诊中,AMIE的治疗精确性得分为94%,而PCP为67%;在第二次和第三次就诊中,AMIE的检查精确性也显著高于PCP。

- 临床指南的使用:AMIE在选择适用的指南(92% vs. 76%,p=0.016)和推荐与指南一致的治疗(89% vs. 75%,p=0.007)方面表现优于PCP。在所有三次就诊中,AMIE推荐与指南一致的治疗的得分均高于PCP。

- 患者演员和专家医生的偏好:在51个独特的MXEKF评估轴组合中,AMIE被患者演员和专家医生优先选择的频率显著高于PCP,中位数胜率为42%。

总体而言,AMIE在初次就诊中的表现显著优于PCP,而在后续就诊中,两者表现相当。AMIE在治疗和检查推荐的精确性、临床指南的使用以及患者和专家的偏好方面均表现出优势。

问题3:RxQA药物推理基准测试的结果如何显示AMIE和PCP在高难度问题上的表现差异?

在RxQA药物推理基准测试中,AMIE和高难度问题上的表现显著优于PCP,具体结果如下:

- 高难度问题:在闭书设置中,AMIE的高难度问题准确率为50.6%,而PCP为41.5%(p=0.013);在开书设置中,AMIE的高难度问题准确率为57.9%,而PCP为47.8%(p<0.001)。这表明AMIE在高难度问题上的表现显著优于PCP。

- 低难度问题:在闭书设置中,AMIE的低难度问题准确率为52.8%,而PCP为46.5%(p=0.147);在开书设置中,AMIE的低难度问题准确率为73.8%,而PCP为67.4%(p=0.071)。虽然AMIE在低难度问题上的表现也优于PCP,但差异不如高难度问题显著。

- 外部知识资源的影响:无论是高难度还是低难度问题,AMIE和PCP在开书设置中的准确率均显著高于闭书设置。这表明访问外部知识资源对两者的药物推理能力都有显著提升作用。

总体而言,AMIE在高难度问题上的表现显著优于PCP,显示出其在复杂药物推理任务中的潜力。

参考文献:

- 百川智能最新医学大模型论文-利用先进的患者模拟器探索医疗"问诊-诊疗"关系

- 京东开源医学大模型“京医千询”Citrus: 利用专家认知路径以支持高级医疗决策

- AMG-RAG自适应知识图谱增强医学问答:弥合大模型与动态医学知识的差距 - 多伦多大学等

- PatientSeek: 海外首个基于Deepseek R1的"KG+LLM"结合的开源医学法律推理模型 - WhyHow.AI

- AIPatient:基于EHR和知识增强大模型智能体工作流的模拟患者-密歇根、斯坦福、哈佛医学院、山大、港大、医科院、北大六院等

- 利用大模型提升护理与老年照护:一个AI驱动的框架 - 复旦、上交等

- 护理临床智能决策的新颖方法:大语言模型与本地知识库的整合

- Nature - 基于护理大模型的医院门诊接待机器人和护士的人机协同新范式

- 使用大模型指导患者创建高效全面的临床护理信息

- 从“小白”到“专家”:大模型在肿瘤护理中的潜力探索

- [最新论文]探索大模型在乳腺癌肿瘤学护理领域中的应用潜力 - 谷歌DeepMind等

- 厦门·护理信息大会|首都医科大学与柯基数据合作的NursGPT项目顺利启动!

- DrHouse虚拟医生: 基于传感器数据和专家知识赋能的大模型医学诊疗推理系统 - 香港中文大学等

- AIPatient:基于EHR和知识增强大模型智能体工作流的模拟患者-密歇根、斯坦福、哈佛医学院、山大、港大、医科院、北大六院等

- AIR孵化|Agent Hospital首批AI医生上线内测

- 2024医学大模型应用及挑战综述 - Cornell、Duke、Berkeley、MIT等

- KG4Diagnosis - 知识图谱增强的多智能体大模型在医学诊断中的应用

- 上海经信局卫健委等发布2024年上海市医疗大模型应用示范场景需求列表

- CMAC中国行-走入“北京人工智能数据训练基地”|医学大模型产学研应用落地研讨会

- 再发布!哈佛医学院又一病理大模型TITAN

- Google DeepMind重磅推出AlphaFold3,预测了所有生命分子的结构和相互作用

- 大模型优化肝病临床指南解读:一种基于RAG的框架 - Nature NPJ

- 斯坦福&哈佛医学院 - MMedAgent,一个用于医疗领域的多模态医疗AI智能体

- 喜讯|柯基数据中标两个“大模型+医学”国自然面上项目

- 哈佛医学院&辉瑞推出基于知识图谱的复杂医学问答智能体MedAI

- 通过知识图谱自动生成和丰富加速医学知识发现 - 哈佛大学等

- 医疗保健和医学领域的大模型综述 - 斯坦福&加州大学

- 医学GraphRAG:通过知识图谱检索增强实现安全医疗大语言模型 - 牛津大学最新论文

- 消除幻觉的知识图谱增强医学大模型 - "Nature"NPJ数字医学杂志

- Almanac: 一种用于临床医学的检索增强RAG大语言模型(2023vs2024版)

- “大模型+知识图谱”双轮驱动的医药数智化转型新范式-OpenKG TOC专家谈

- 医学AI专家Anthropic CEO万字长文预测人工智能将消除癌症、人类寿命翻倍,世界变得更美好

- 医疗保健和医学领域的大模型综述 - 斯坦福&加州大学

- OpenAI o1模型的医学初步研究:我们离人工智能医生更近了吗?

- 哈佛医学院将生成式人工智能纳入课程和临床实践,以培训下一代医生

本文转载自知识图谱科技,作者:Wolfgang