AI大模型本地化方案:Xinference 本地运行大模型

一、Xinference简介

Xorbits Inference(Xinference)是一个开源的分布式推理框架,专为大规模模型推理任务设计。它支持大语言模型(LLM)、多模态模型、语音识别模型等多种模型的推理,极大简化了这些模型的部署过程。

二、Xinference Docker部署

在部署Xinference时,选择使用Docker容器可以带来许多便利。首先,需要拉取Xinference的Docker镜像文件,但请注意,该镜像文件较大,约为17.7GB,拉取过程可能需要较长时间。拉取命令如下:

拉取完成后,可以创建一个目录用于存放Xinference的缓存文件和日志文件,以便更好地管理数据。

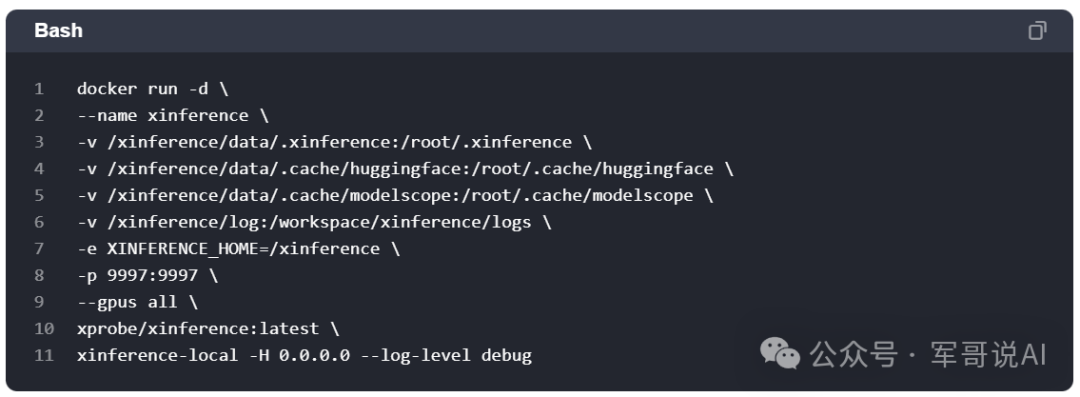

接下来,启动Xinference Docker容器。默认情况下,镜像中不包含任何模型文件,但会在容器内下载所需模型。如果已有下载好的模型,可以通过挂载宿主机目录到容器内来使用这些模型。同时,需要配置一些环境变量来指定模型下载源和存储目录。

三、Xinference本地运行大模型

容器启动后,可以通过访问公网地址加上9997端口来启动大模型。例如,启动qwen2-instruct模型,并使用Xinference自带的图形化聊天界面进行测试。

此外,还可以测试其他类型的大模型,如图片生成模型和多模态模型。启动这些模型时,需要注意GPU资源的需求,并根据实际情况选择合适的GPU配置。

四、Xinference启动嵌入和重排模型

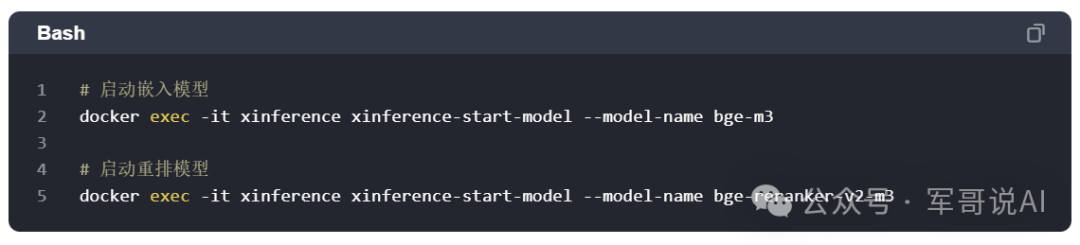

Xinference支持启动嵌入和重排模型,这些模型在后续的处理中可能会被其他系统或应用调用。例如,可以启动bge-m3嵌入模型和bge-reranker-v2-m3重排模型,并为后续调用做好准备。

请注意,Xinference目前无法同时运行多个大模型(如语言模型、图片模型、语音模型),但可以同时启动多个嵌入模型和重排模型。

本文转载自军哥说AI,作者:军哥说AI