回复

图RAG统一框架来了,12种RAG方法一网打尽!

基于图的 RAG 统一框架 in-depth 分析

作者:港中深与华为的研究人员

核心速览

研究背景

研究问题:这篇文章要解决的问题是如何在统一框架下对基于图的检索增强生成 (RAG) 方法进行系统的比较和分析。现有的基于图的 RAG 方法没有在同一实验设置下进行系统的比较。

研究难点:包括缺乏统一的框架来抽象和比较各种基于图的 RAG 方法;现有工作主要关注整体性能评估而非单个组件的性能;以及缺乏对各种方法在准确性和效率方面的全面比较。

相关工作:涉及 RAG 技术在医疗、金融、教育等领域的广泛应用,以及已有的基于图的 RAG 方法(如 RAPTOR、KGP、HippoRAG 等),但这些方法缺乏系统比较和分析。

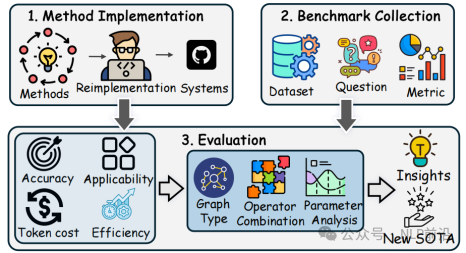

研究方法

- 图构建:将大规模语料库分割成多个块,并使用 LLM 或其他工具从中提取节点和边构建图(如 passage graph、tree、knowledge graph、textual knowledge graph 和 rich knowledge graph)。

- 索引构建:为高效在线查询,构建存储图中实体或关系的索引,并计算社区报告实现高效检索。索引类型包括节点索引、关系索引和社区索引。

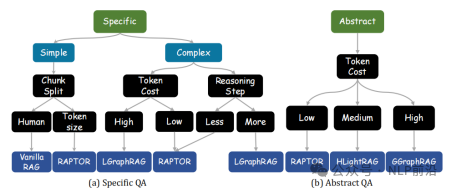

- 操作符配置:在统一框架下,任何现有的基于图的 RAG 方法均可通过选择特定操作符(节点、关系、块、子图、社区)并组合实现。

- 检索与生成:将用户输入的问题转换为检索原语,利用选定操作符检索信息,再与问题一起输入 LLM 生成答案。答案生成包括直接生成和 Map-Reduce 两种范式。

实验设计

- 数据集:使用了 11 个真实世界数据集,如 MultihopQA、Quality、PopQA、MusiqueQA、HotpotQA、ALCE、Mix、MultihopSum、Agriculture、CS 和 Legal。

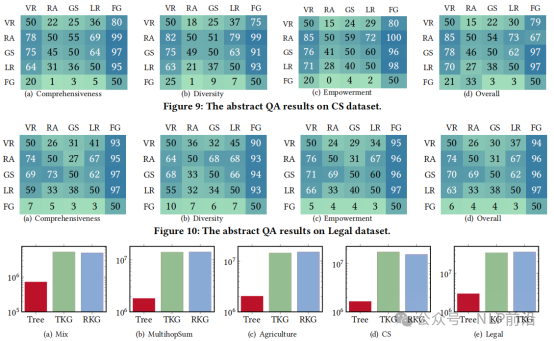

- 评估指标:对特定问题任务采用准确率和召回率;对抽象问题任务采用全面性、多样性、赋能和总体质量等指标。

- 实现:所有算法均在 Python 中实现,并使用提出的统一框架,实验覆盖 350 集数据集。

- 超参数设置:对于需要 top-k 选择的方法(如块或实体),设置 ( k=4 ) 以适应令牌长度限制,并采用 BGE-M3 模型生成节点和关系的嵌入向量。

结果与分析

- 特定问题任务的性能:RAG 技术显著提高了 LLM 的性能。比如,在 Quality 数据集上,RAPTOR 相较于 ZeroShot 提高了 53.80% 的准确性,但若检索到的元素不相关则可能降低性能。

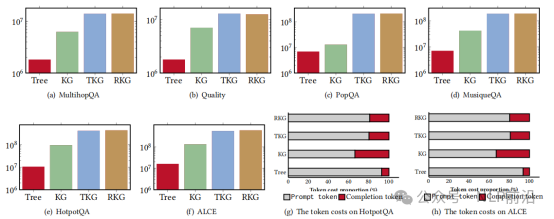

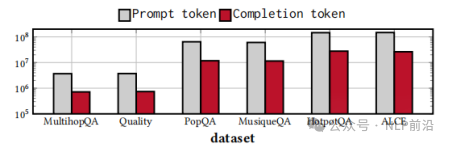

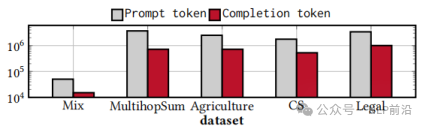

- 图构建和索引构建的成本:构建树的令牌成本最低,而 TKG 和 RKG 的成本最高。对于大型数据集,GraphRAG 的离线阶段成本较高。

- 生成成本:ZeroShot 和 Vanilla RAG 在时间和令牌消耗方面较为经济,而 KGP 和 ToG 由于依赖 LLM 检索信息成本较高。

- 复杂问题任务的新 SOTA 算法:提出了 VGraphRAG,通过结合实体、关系、社区和块四种元素有效指导 LLM 生成准确答案,在 ALCE 数据集上分别在 STRREC、STREM 和 STRHIT 上提高了 8.47%、13.18% 和 4.93%。

- 抽象问题任务的性能:基于图的 RAG 方法通常优于 Vanilla RAG,GGraphRAG 和 RAPTOR 因在提示中加入高层次总结文本表现更佳。

- 新 SOTA 算法的成本效益:设计了成本效益更高的 CheapRAG,通过选择最有用的社区和块显著减少令牌成本,在 MultihopSum 数据集上相比 GGraphRAG 降低了 100 倍令牌成本,同时提升了答案质量。

总体结论

本文对现有基于图的 RAG 方法进行了深入实验评估和比较,提出了一个新的统一框架覆盖所有现有方法,并识别出关键性能影响因素和未来研究机会。

论文评价

优点与创新

- 统一框架:提出了一个新颖的统一框架,涵盖所有现有基于图的检索增强生成 (RAG) 方法,并抽象出关键操作。

- 全面比较:在统一框架下系统比较了 12 种代表性方法,提供了深入分析。

- 新变体识别:结合现有技术识别出新的 RAG 方法变体,在部分任务上优于最先进方法。

- 实验设计:在多个常用 QA 数据集上进行了全面实验,评估不同查询类型下的方法性能。

- 模块化设计:模块化设计允许各阶段(图构建、检索、生成)独立优化和组合,提升灵活性。

- 操作符设计:通过调整检索阶段或交换组件,便于快速测试和实施新策略,加速模型开发。

- 标准化评估:提供了标准化评估方法,确保结果可重复,促进公平基准测试,为未来创新提供支持。

论文详情与开源代码

- 论文详情:https://arxiv.org/abs/2503.04338

- 代码开源地址:https://github.com/JayLZhou/GraphRAG

本文转载自NLP前沿,作者:NLP前沿

赞

收藏

回复

相关推荐