大模型调参技巧—如何实现超参的跨模型尺度迁移 原创

本篇介绍超参数(学习率)跨模型尺度的迁移规律。

众所周知,完整训练一次大型LLM的成本是昂贵的,这就决定了我们不可能像以前一样直接在大型LLM上反复测试超参数。

一个很自然的想法是希望可以在同结构的小模型上仔细搜索超参数,找到最优组合后直接迁移到大模型上。

尽管这个想法很朴素,但要实现它并不简单,它需要我们了解常见的超参数与模型尺度之间的缩放规律,本次介绍的文Maximal Update Parametrization,简称“muP”,正是这个想法的一个实践。具体出自论文《Tensor Programs V: Tuning Large Neural Networks via Zero-Shot Hyperparameter Transfer》。

先说结论,muP主要研究超参数跨模型尺度的迁移规律。这里有几个关键词:

1、超参数,目前主要指学习率;

2、模型尺度,目前主要是模型宽度;

3、这里的核心是“迁移”。

请注意,muP并不研究什么是最优的超参数,只研究最优超参数随着模型尺度的变化规律,所以我们需要在某个小模型上搜索最优的超参数组合,然后迁移到大模型上,这就是muP的使用场景和使用方法。

推导muP的原理是让模型的前向传播、反向传播和损失增量都不随模型尺度的变化而发生明显变化:

1、具体做法是分析初始化的数量级,然后认为结论可以代表后续优化的规律;

2、说白了就是假设做好初始化,后面就会自动沿着正确的轨迹走

具体方法

论文提出了一种名为µTransfer的方法来解决大型神经网络的超参数(HP)调整问题。这个方法的核心思想是利用最大更新参数化(Maximal Update Parametrization,简称µP)的特性,该特性表明在模型大小变化时,许多最优的HP保持稳定。

具体来说,µTransfer的解决方案包括以下几个步骤:

1. 目标模型的µP参数化:首先,将目标大型模型(即最终希望调整的模型)按照µP进行参数化。这确保了模型在训练过程中,各层的更新幅度保持一致,从而在模型宽度增加时,HPs保持稳定。

2. 在小型代理模型上调整HP:然后,研究者在一个小版本的代理模型上进行HP调整。这个小型模型在宽度和/或深度上小于目标模型,但采用相同的µP参数化。

3. 零成本转移(Zero-Shot Transfer):一旦在小型代理模型上找到了接近最优的HPs,这些HPs可以直接转移到全尺寸的目标模型上,而无需在目标模型上进行额外的调整。这种转移是基于µP理论,即在无限宽度极限下,模型的HPs趋于稳定。

4. 验证和测试:最后,研究者在目标模型上验证这些转移过来的HPs,并与直接在目标模型上进行调整的结果进行比较,以确保性能达到预期。

比较关键的改进点是Normalization和残差的影响,尤其是Normalization,它使得不依赖特殊的初始化就可以稳定前向传播,带来了更大的自由度和可能性。

具体示例

论文比较难理解,下面基于苏神的文举一个前向传播的例子,更详细的推理推荐直接去看苏神的文章。(可以点击后面原文链接直接跳转)

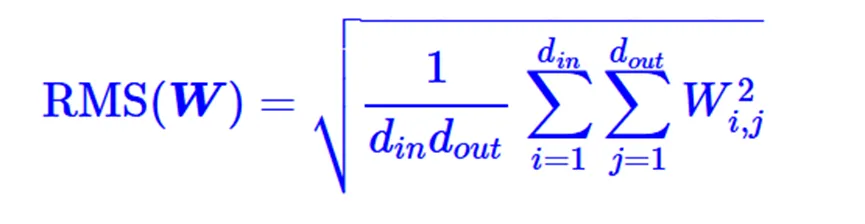

首先依然用RMS(Root Mean Square)来作为矩阵尺度的指标

那么muP就是想研究超参数关于d的变化规律。

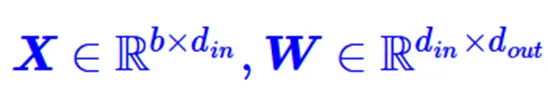

考虑线性层表示为

其中

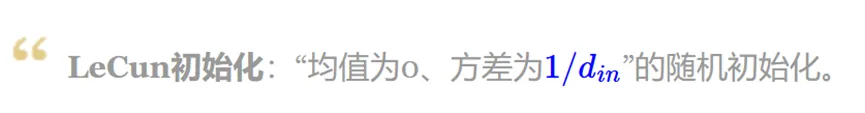

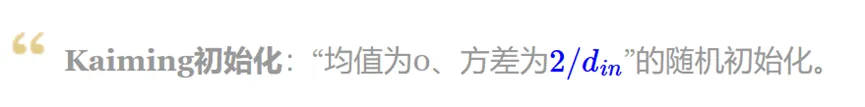

我们的目的是为了让迁移时稳定,即初始化阶段X的RMS跟Y的RMS大致相等,那么W的初始化

Kaiming初始化跟LeCun初始化相比,只是方差相差一个(跟模型尺度无关的)常数2,可以证明其他激活函数的结果也类似。因此可以得到结论

这也说明了“激活函数的影响是模型尺度无关的”。

这里直接给出最终所有优化器下的结论。

这里的W指的是除Win,Wout外的所有参数,还有要强调的是,这里的关系都是“正比于”而不是“等于”。

实验验证

论文在Transformer、ResNet、GPT等模型上均进行了实验,我们可以主要来看看GPT3上的实验。

这块作者在GPT-3的一个小型代理模型(约40M参数)上确定了超参数,然后将这些参数转移到完整的6.7B参数模型。实验结果显示,µTransfer模型的性能优于原始GPT-3模型,并且与两倍大的13B模型相当。

总结

基于muP可以在小模型上以相对较小的成本仔细搜索超参数(这里主要是学习率和初始化),然后迁移到大模型上,降低大模型的炼丹成本。当然µTransfer在实际应用中还有很多的潜在改进方向,比如如自动化代理模型选择、跨平台实现等。

文转载自公众号瓦力算法学研所,作者:喜欢瓦力的卷卷

原文链接:https://mp.weixin.qq.com/s/6OZBR1IKi8mW93jrXNjZlA