多模态奖励大一统!UNIFIEDREWARD突破任务边界,图像视频双域性能飙升的秘密

文章链接:https://arxiv.org/pdf/2503.05236

项目链接: https://codegoat24.github.io/UnifiedReward/

Github链接: https://github.com/CodeGoat24/UnifiedReward

Huggingface链接: https://huggingface.co/papers/2503.05236

Models链接: https://huggingface.co/collections/CodeGoat24/unifiedreward-models-67c3008148c3a380d15ac63a

Datasets链接: https://huggingface.co/collections/CodeGoat24/unifiedreward-training-data-67c300d4fd5eff00fa7f1ede

亮点直击

- 构建了一个大规模的人类偏好数据集,涵盖多种视觉任务,并开发了UNIFIEDREWARD,这是首个用于多模态理解和生成模型评估的统一奖励模型,能够执行成对排名和单点评分。

- 提出了一种通用流程,以用于图像和视频理解/生成模型的偏好对齐,该领域在当前研究中仍然较少被探索。大量实验表明,该方法在各个领域均能有效提升视觉模型的性能。

- 实验表明,同时学习评估图像和视频任务能够在不同视觉领域之间产生协同提升。通过本研究,旨在扩展奖励模型的适用范围,使其在各种视觉应用中更加适应性强、可推广且高效。

总结速览

解决的问题

- 任务特定性限制:现有的奖励模型通常针对特定任务设计,缺乏跨多种视觉任务的适应性。

- 数据收集成本高:大规模收集人类反馈数据用于模型优化既耗时又资源密集。

- 任务间的孤立性:视觉任务之间存在内在联系,但现有方法未能充分利用这种联系来提升模型性能。

提出的方案

- 统一奖励模型:提出了UNIFIEDREWARD,首个用于多模态理解和生成评估的统一奖励模型,支持成对排序和点对点评分。

- 大规模数据集构建:构建了一个涵盖图像和视频生成/理解任务的大规模人类偏好数据集。

- 自动数据生成:利用UNIFIEDREWARD自动生成高质量偏好对数据,通过多阶段过滤(如成对排序和点筛选)选择特定基线模型的输出。

- 直接偏好优化:使用生成的偏好对数据,通过直接偏好优化(DPO)方法对齐模型输出与人类偏好。

应用的技术

- 奖励模型学习:从有限的偏好数据中学习奖励模型,生成合成偏好数据。

- 多任务联合学习:联合学习多个视觉任务,利用任务间的协同效应提升模型性能。

- 多阶段过滤:采用成对排序和点筛选技术,自动构建高质量偏好对数据。

- 直接偏好优化(DPO):使用偏好对数据进行模型优化,减少对人类注释的依赖。

达到的效果

- 跨任务适应性:UNIFIEDREWARD模型能够适应多种视觉任务,提升了模型的通用性和灵活性。

- 性能提升:通过联合学习多个视觉任务,显著提升了图像和视频理解/生成任务的性能。

- 数据效率:自动生成的偏好对数据减少了对大规模人类注释的依赖,提高了数据利用效率。

- 协同效应:图像理解的提升改善了图像生成评估,图像评估的改进通过更好的帧分析提升了视频评估,形成了任务间的良性循环。

方法

概述

本研究旨在提出一个用于视觉模型偏好对齐的统一奖励模型。现有研究通常为特定任务开发专门的奖励模型,如下表 1 所示,这限制了它们在不同视觉应用中的适应性。

同时学习多个视觉任务可以产生相互增强的效果,但这一领域尚未被充分探索。为此,本研究提出 UNIFIEDREWARD,这是首个用于多模态理解和生成评估的统一奖励模型,能够执行 成对排名 和 单点评分。该模型被用于 视觉-语言模型(VLMs) 和 扩散模型(Diffusion Models) 的对齐,以实现更稳健且适应性更强的偏好学习,涵盖多种视觉任务。流程如下图 2 所示。

首先构建一个大规模的统一偏好数据集,并在此数据集上训练 UNIFIEDREWARD 模型。然后通过对 VLMs 和扩散模型的输出进行 成对排名 和 单点评分,来构建相应的偏好数据集。这些数据集随后被用于 直接偏好优化(DPO),从而有效增强模型对人类偏好的对齐能力。

统一奖励模型训练

统一偏好数据集构建

一个涵盖多种视觉相关任务的综合性人类偏好数据集,对于训练统一奖励模型至关重要。然而,现有的人类反馈数据集(如 [29, 40, 44])通常是为特定任务设计的,限制了其泛化能力。目前,还没有一个能全面涵盖 视觉理解 和 视觉生成 任务的人类偏好数据集,这凸显了构建更通用数据集的必要性。为弥补这一空白,我们整合并预处理现有数据集,构建了首个 大规模统一人类偏好数据集,其中包含约 236K 条数据,涵盖 图像和视频理解/生成 任务。数据集的详细统计信息和可视化分布分别展示在下表 2 和图 3 中。我们将在下文介绍各任务的数据构建过程。

图像生成

- EvalMuse:包含4K个文本提示,每个提示对应多个不同模型生成的图像。每张图像由至少三名标注员进行评估,提供总体评分(1-5)以及元素级标签,指示特定元素是否存在。

- 单点评分学习:最终得分取所有评分的平均值。若至少两名标注员认定某元素存在,则视为已生成,否则视为未生成。

- 成对排名:选取同一提示下得分最高和得分最低的图像,形成排名对。

- **Human Preference Dataset (HPD)**:包含70 万条人类偏好投票。对于每个文本提示,提供两张不同模型生成的图像及对应投票数。我们直接利用投票数构建成对排名数据,得票较多的图像被认为更受偏好。

- **Open-Image-Preferences (OIP)**:包含7.4K条文本到图像的偏好数据,直接用于本研究。

图像理解

- LLava-Critic-113K:包含40K条单点评分数据和73K条成对排名数据,主要用于图像理解评估。我们从中选取25K条数据用于成对排名,另25K条数据用于单点评分训练。

视频生成

- VideoDPO:包含10K条合成视频对比数据,适用于文本到视频的 DPO 任务。我们直接使用该数据集进行视频生成任务的成对排名学习。

- LiFT-HRA&VideoFeedback:提供大量人类反馈,用于合成视频的单点评分,我们直接将其纳入训练。

视频理解

- ShareGPTVideo-DPO:包含17K条视频理解 DPO 数据,其中每对响应均被赋予一个评价得分。我们使用配对数据进行成对排名学习,同时提取单个响应的得分进行单点评分学习。

数据标准化

- 成对排名数据集采用统一格式:

“图像/视频/响应 X 优于 图像/视频/响应 Y”其中 “X” 和 “Y” 代表相应索引。如果数据集中包含 评估理由,我们会保留,以便模型学习人类推理过程。

- 单点评分数据集不强制统一评分格式或分数范围,使模型能够学习不同数据集的评分风格和体系。为确保评估标准与回答内容对齐,我们相应调整提示词,具体模板见附录 C。

如上图 3 所示,相较于其他任务,视频生成任务的成对排名数据较少,但我们认为 多任务学习的协同效应 能够弥补这一不足。总体而言,我们的数据集 涵盖广泛,包含 成对排名 和 单点评分 数据,适用于 图像与视频的理解和生成任务,从而支持 高效的奖励模型训练,确保在多模态理解和生成任务中的 稳健性能。后续章节将介绍相关模型训练细节。

统一偏好学习

基于综合性数据集,对一个具有强大视觉理解能力的预训练 VLM进行微调,以开发 UNIFIEDREWARD,并在多个视觉任务上进行联合训练。与从零开始学习评估能力不同,我们将评估能力作为额外的判别技能进行整合,利用模型现有的视觉理解能力来增强其在不同任务上的评估性能。

前面图 2(顶部)展示了我们的训练流程。具体而言,在多模态生成评估任务中,我们的模型以视觉 token、指令输入和字幕作为输入。而在多模态理解任务中,字幕被替换为问题及其对应的回答,以使输入格式与任务需求对齐。模型基于指令提示中指定的标准,学习预测单点评分或成对排序。如果训练数据包含评估理由,模型还会学习生成详细解释,以支持其评估结果。在训练过程中,优化目标是标准的交叉熵损失,但仅计算模型预测答案的损失。

在训练好 UNIFIEDREWARD 之后,我们将其用于多模态理解和生成模型的偏好对齐。该过程包括两个顺序步骤:偏好数据构建 和 生成/理解模型对齐。接下来的章节将详细介绍每个步骤。

偏好数据构建

偏好对齐数据的质量直接决定了模型对齐的有效性。现有方法 [28, 40, 44] 通常仅采用单一的评估策略,要么为模型输出分配成对排序,要么给予单点评分,限制了数据的质量和多样性。相较之下,本文的方法同时利用 UNIFIEDREWARD 的成对排序和单点评分能力,从而构建出更高质量的偏好数据集,流程如前面图 2(左下)所示。

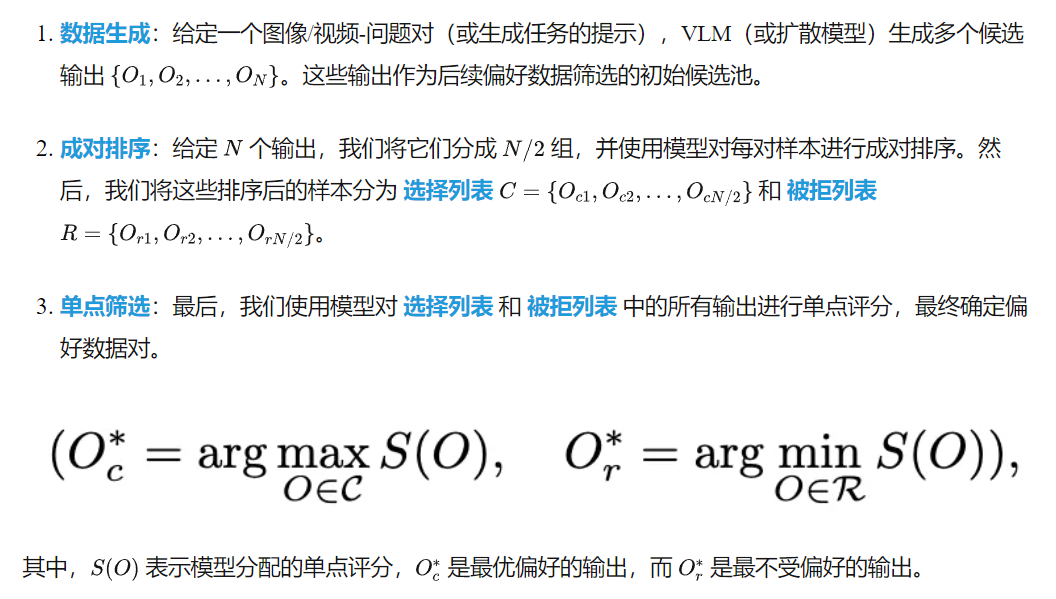

本文的数据构建流程包括以下三个顺序步骤:

通过结合成对排序和单点评分,最终的偏好数据能够提供高质量且可靠的偏好信号,有效捕捉相对比较和绝对质量评估。

生成/理解模型对齐

在构建偏好数据后,我们利用该数据进行多模态生成和理解模型的对齐。我们采用 DPO(Direct Preference Optimization) 方法,使模型能够在不显式建模奖励的情况下对齐其输出与人类偏好,直接基于排序的偏好对进行优化。

多模态生成的 DPO

在多模态生成任务中,扩散模型由于其在图像和视频合成方面生成高质量和多样化输出的能力,被广泛应用。因此,我们在扩散模型上应用 DPO,使其输出对齐人类偏好。

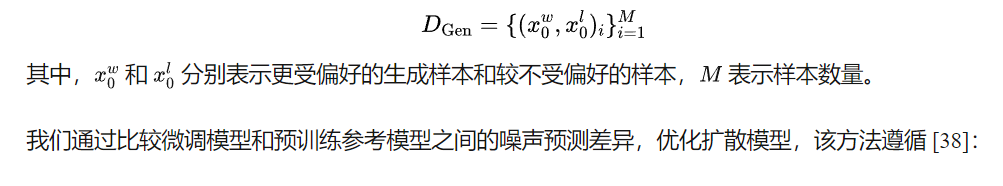

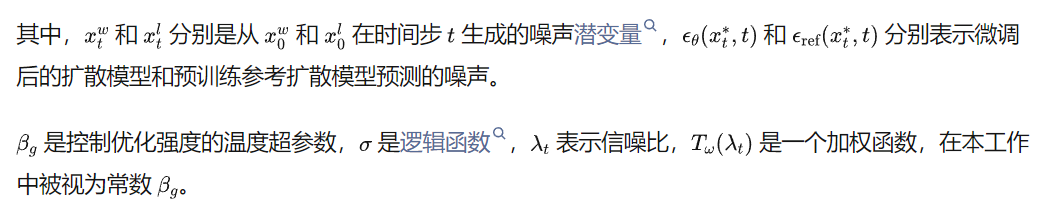

给定构造的偏好对数据集

该损失函数鼓励微调后的扩散模型减少对更受偏好样本的去噪误差,同时增加对较不受偏好样本的去噪误差,从而提升生成质量。

多模态理解的 DPO

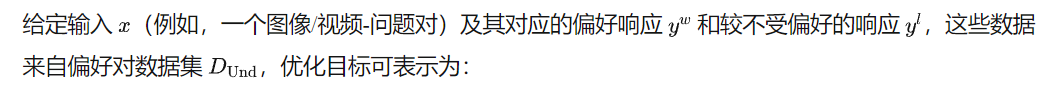

类似于生成模型的对齐,我们将 DPO 应用于多模态理解模型(即 VLMs),以调整模型的响应偏好。

该损失函数鼓励微调后的 VLMs 增加生成偏好响应的概率,同时降低生成较不受偏好响应的概率,从而提升模型对齐人类偏好的能力,并增强推理质量。

实验

实验设置

模型与超参数设置

- 奖励模型(Reward Model):我们采用LLaVA-OneVision 7B (OV-7B)作为UNIFIEDREWARD的基础架构,以利用其在图像和视频理解方面的强大性能。训练超参数如下:

- 多模态理解 DPO:

- 多模态生成 DPO:

- 数据集规模:

评测指标

- 多模态理解评测:

- 图像理解:VLRewardBench

- 视频理解:ShareGPTVideo(测试样本数:1K)

- 多模态生成评测:

- 图像/视频生成奖励评测: GenAI-Bench

- 视频生成评测: VideoGen-RewardBench

- DPO 评测:

- 文本-图像生成基准: Partiprompt(1632 captions)、HPSv2 (3200 captions)

- 奖励模型: PickScore、HPDv2、ImageReward

- 图像理解: LLaVABench、WildVision、LLaVABench-Wilder 、LiveBench、MMHal

- 视频理解: MSRVTT、MSVD、TGIF、LongVideoBench、MLVU、VideoMME

- 图像生成评测:

- 视频生成评测: VBench

奖励模型对比实验

图像理解

本文的方法与最新的开源模型 LLaVA-Critic 及两个闭源模型 Gemini-1.5-Pro 和 GPT-4o 进行对比。

实验结果(见下表 3)表明,本文的方法在大多数指标上优于最佳基线。例如,在 macro accuracy 方面,本文的方法达到了66.5%,显著高于 LLaVA-Critic 的 62.5%,验证了我们方法在图像理解评测中的优越性。

视频理解

由于目前尚无公开可用的基线模型,我们探索了 多任务学习 在视频理解评测中的有效性,并将在后续章节详细分析其影响。

图像生成评测

本文的方法与传统及最新的奖励模型进行对比,包括:

- PickScore

- HPSv2

- ImageReward

- VisionReward

实验结果(见下表 5)显示,最新的 VisionReward 方法同时支持图像和视频生成的奖励建模,但它为不同任务分别训练单独的模型,而本文的方法在 统一框架 下进行多任务联合学习,从而在多个指标上取得更优结果。

视频生成评测

本文的方法与以下最新方法进行对比:

- VideoScore(视频生成评测模型)

- LiFT(视频奖励模型)

- VisionReward

- VideoReward

尽管我们的视频生成评测数据相对较少(见前面图3),但实验结果(上表 5)表明,本文的方法在所有基线方法中表现最佳。这表明 多任务学习 不仅能缓解训练数据不足的问题,还能增强视频生成评测的学习效果。

多任务评估学习

在这项工作中,认为视觉任务本质上是相互关联的,联合学习多个视觉任务可能会产生相互增强的效果。因此,探索了多任务学习对奖励模型的有效性。具体来说,对于每个任务,我们使用不同的训练数据配置来训练模型,研究在不同模态(图像和视频)和任务(理解和生成)之间联合学习的影响。例如,对于图像理解任务,我们设计了三种训练配置来探讨多任务学习的影响:(1)仅在图像理解评估上训练,(2)联合学习图像理解和图像生成评估,(3)联合学习图像理解和视频理解评估。结果如表3所示,值得注意的是,研究表明,相较于单一任务训练,多任务学习显著增强了模型的整体性能。例如,在图像和视频理解任务上联合训练,相较于仅在图像理解上训练,整体准确率提高了5.3%,宏观准确率提高了8.3%。下表4和表5中的其他任务结果一致地证明了联合学习的有效性。这些结果突显了跨不同视觉任务共享知识的好处,从而提高了奖励模型的鲁棒性和泛化能力。

DPO比较结果

为了进一步展示本文方法在图像和视频理解与生成任务中的有效性,通过精细化输出筛选来构建偏好数据,然后通过DPO进行模型对齐。

- 图像理解:将本文的方法与最新的奖励模型LLaVA-Critic进行比较,使用相同的图像-问题对源(LLaVA-RLHF)来构建OV-7B的偏好数据,确保公平比较。下表7中的结果表明,本文的方法在所有基准测试中始终优于LLaVA-Critic,例如,在LLaVABench上提高了3.4%的效果,突显了其优越性。

- 视频理解:从ShareGPTVideo-DPO中提取提示,构建LLaVA-Video-7B的偏好数据。我们的结果表明,本文的方法在MSRVTT、MSVD和TGIF等数据集上显著优于基线,展示了其在视频理解中的有效性,具体见下表6。对于其他三种多选问题数据集,尽管我们的DPO数据不包含此类数据,但我们的性能仍与基线相当,表明了我们方法的鲁棒性和泛化能力。

- 图像生成:使用Pick-a-Pic人类偏好图像数据集的数据,构建偏好数据。下表9中的结果显示,相较于直接在原始数据集上训练,本文的方法表现更好,证明了其在精细化偏好数据以改善模型对齐方面的有效性。

- 视频生成:将本文的方法与VideoDPO进行比较,使用相同的提示源来构建偏好数据。下表8中的结果表明,本文的方法显著提高了生成质量和语义一致性,突显了其有效性。

图像生成定性结果

视频生成定性结果

结论

本文提出了UNIFIEDREWARD,第一个用于多模态理解和生成评估的统一奖励模型,能够处理配对排名和点评分两种任务。UNIFIEDREWARD通过在涵盖广泛视觉任务的大规模综合数据集上对预训练的视觉语言模型(VLM)进行微调来开发。然后,该模型用于通过详细的过滤过程自动构建高质量的偏好配对数据,这些数据随后用于通过直接偏好优化(DPO)进行模型对齐。实验结果表明,跨不同视觉任务的联合学习在图像和视频理解与生成任务中带来了显著的性能提升。这种方法增强了视觉模型与人类偏好之间的对齐,从而提高了推理质量和任务性能。

本文转自AI生成未来 ,作者:AI生成未来