英伟达股价暴跌!或与 Llama 3 发布有关? 原创

Llama 3在Groq平台运行速度超快

美国时间4月18日中午,Meta发布了Llama 3 大模型。该版本的模型经过预训练和指令微调,参数分别为 8B 和 70B,可支持广泛的用例。Llama 3在行业基准测试中展示了最先进的性能,包括改进的推理能力。Meta在发布的文章中声称Llama 3是目前同类产品中最好的开源模型。

4月19日凌晨,也就是Llama 3 发布12小时后,AI芯片公司Groq 发布在其 LPU™ 推理引擎上运行的 Llama 3 8B (8k) 和 70B (4k, 8k),并通过 groq.com 和 GroqCloud™ 控制台提供给开发者社区。

“我比较了 Llama 3和 GPT-4,让它们用 Python 编写一个蛇形游戏,看看速度有何不同!” 计算机教授Alvaro Cintas用Groq运行Llama 3,并直观地对比了Llama3和GPT-4的生成速度。

据OthersideAI创始人 Matt Shumer在X.com的发帖及其他几位知名用户的描述,Groq系统在运行LLaMA 3模型时的推理速度极快,超过800 token/秒(T/s)。

你也可以通过Groq官网免费亲自测试一下:

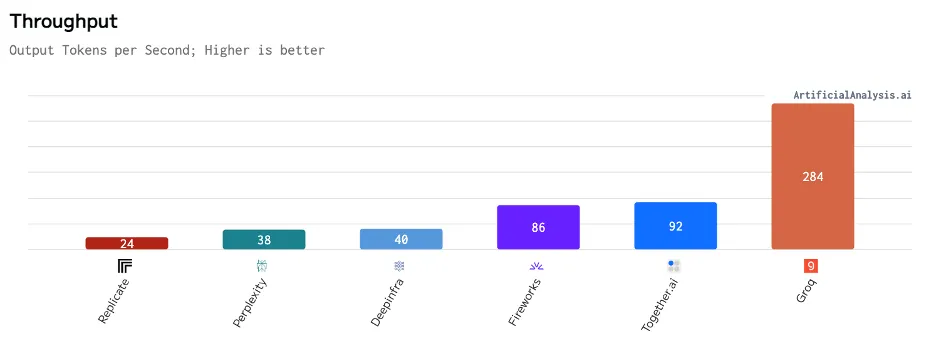

随后,根据Artificial Analysis的独立基准测试,Groq在Llama 3 8B和Llama 3 70B上的吞吐量分别达到877 token/秒和284 token/秒,是所有供应商中最高的2倍多。Groq 的产品还具有成本竞争力,两款机型的价格均低于其他供应商。结合 Llama 3 大模型的高质量,Groq 的产品非常有吸引力。

Groq的创新型AI芯片架构

Groq,这家位于硅谷、资金雄厚的初创企业,正在开发一种全新的处理器架构,专为深度学习中的矩阵乘法操作进行优化。公司推出的Tensor Streaming Processor放弃了传统CPU和GPU的缓存及复杂控制逻辑,转而采用一种针对AI工作负载定制的简化模式。

Groq的处理器架构与Nvidia及其他主流芯片生产商的设计截然不同。Groq没有选择通用处理器适配AI的常规路径,而是从零开始,专门开发了Tensor Streaming Processor以提升深度学习特有的计算模式。

这种从零构建的策略使Groq能够剔除不必要的电路,并针对AI推理中常见的高度可并行和重复性工作负载优化数据流。Groq声称,这样做不仅大幅降低了运行大型神经网络的延迟和能耗,也减少了成本,与市场上的主流产品相比有了显著改进。

AI推理的能效正受到越来越多的关注。由于数据中心已成为电力的大户,大规模AI的计算需求可能会显著增加电力消耗。在保持推理性能的同时最小化能源消耗的硬件开发,是实现大规模AI可持续发展的关键。Groq的Tensor Streaming Processor便是为此目的设计的。该处理器承诺能够显著降低运行大型神经网络的电力成本,相比传统通用处理器显示出显著的优势。

Nvidia的霸主地位遭遇挑战

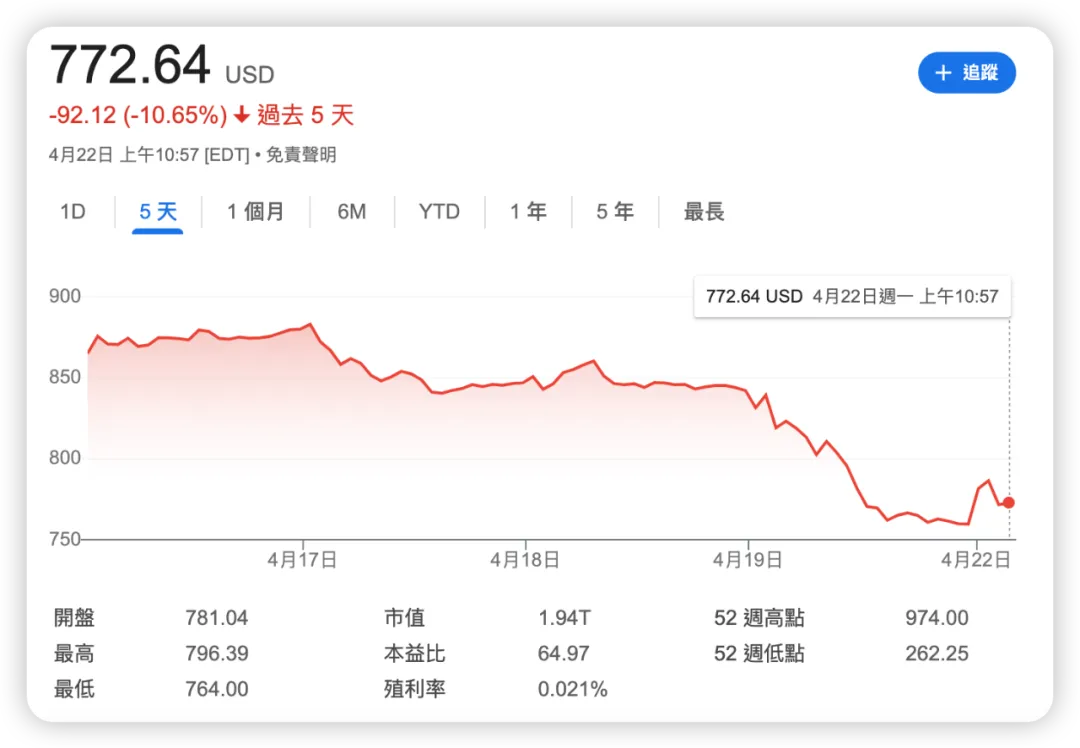

4月19日,英伟达(Nvidia)股价暴跌10%,市值蒸发2117亿美元,为美股史上第二大单日损失,几乎跌掉一个AMD。

Nvidia目前在AI处理器市场中占据领先地位,其A100和H100 GPU成为大多数云AI服务的核心动力。然而,Groq、Cerebras、SambaNova和Graphcore这些资金充裕的初创企业正通过专为AI设计的新型架构挑战Nvidia的主导地位。

在这些竞争者中,Groq表现尤为活跃,不仅关注于训练领域,更在推理技术方面积极推广。Meta最近发布的Llama 3,作为目前最先进的开源语言模型之一,为Groq提供了展示其硬件推断性能的良机。Meta宣称这一模型能够与市场上最优的闭源模型匹敌,预计将广泛应用于基准测试和多种AI场景。

如果Groq的硬件在运行LLaMA 3时能显著超越现有主流产品的速度和效率,不仅能验证其技术优势,还可能加速其技术的广泛应用。结合Llama等强大的开源模型和Groq这类高效推理硬件,可能会让AI技术更具成本效益,从而更易于被更多企业和开发者采用。尽管如此,Nvidia并不会轻易放弃市场领先地位,其他竞争者也在紧追不舍。

当前竞争的焦点在于构建能与AI模型的快速发展相匹配的基础设施,并拓展技术以满足日益增长的应用需求。近乎实时的AI推理和低成本实现,可能在电商、教育、金融、医疗等领域开启革命性的新局面。

如X.com一位用户所评价的基于Groq的Llama 3性能基准:“速度+低成本+高质量=当前没有理由选择其他产品。”在新一代架构挑战传统的浪潮中,AI的硬件基础仍在不断演进。

本文转载自公众号AIGC开发者,作者:阿橙AIGC